介绍了一种简易的,不需要GPU的AIcover方法,亲测有效!_aicover...

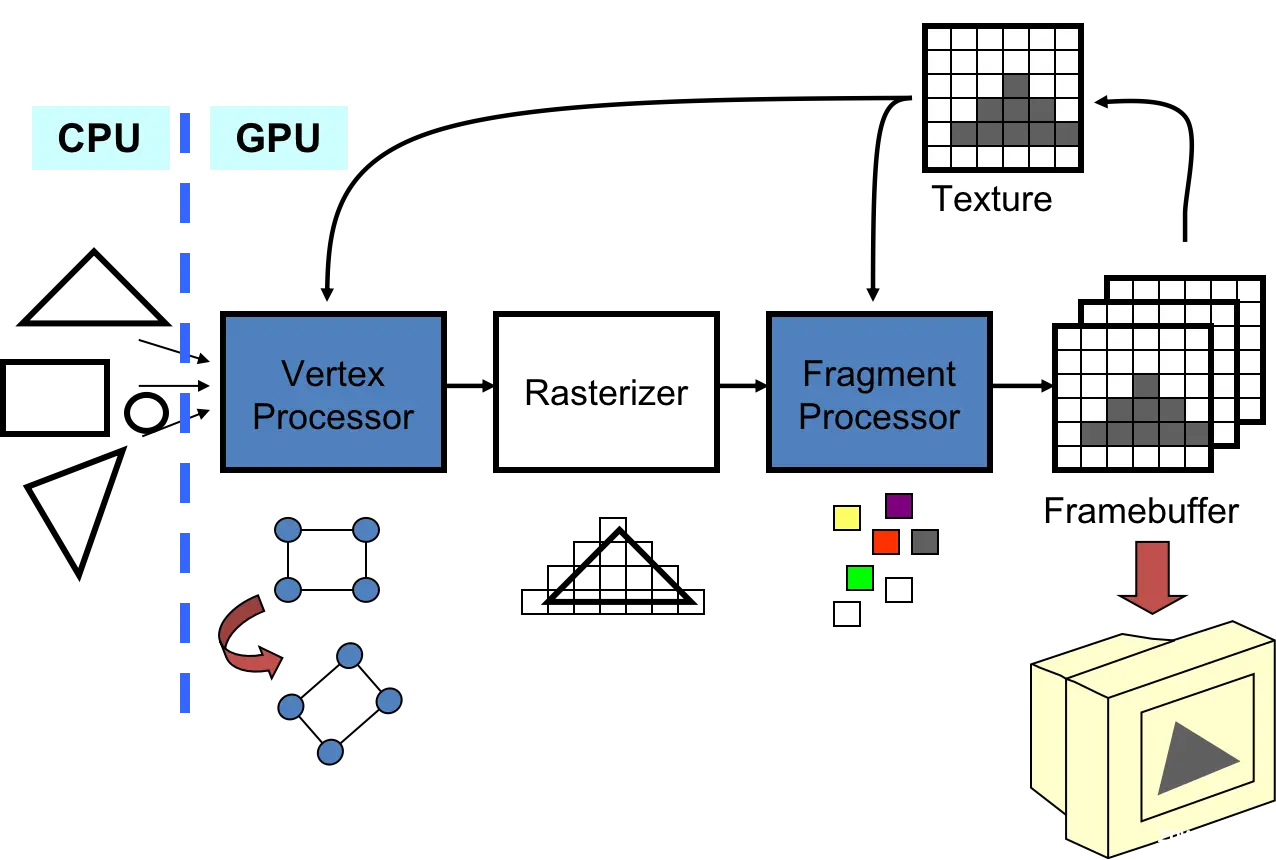

GPGPU(GeneralPurposeGraphicsProcessingUnit,通用图形处理器)脱胎于GPU(GraphicsProcessingUnit,图形处理器)。GPGPU由于其强大的运算能力和高度...

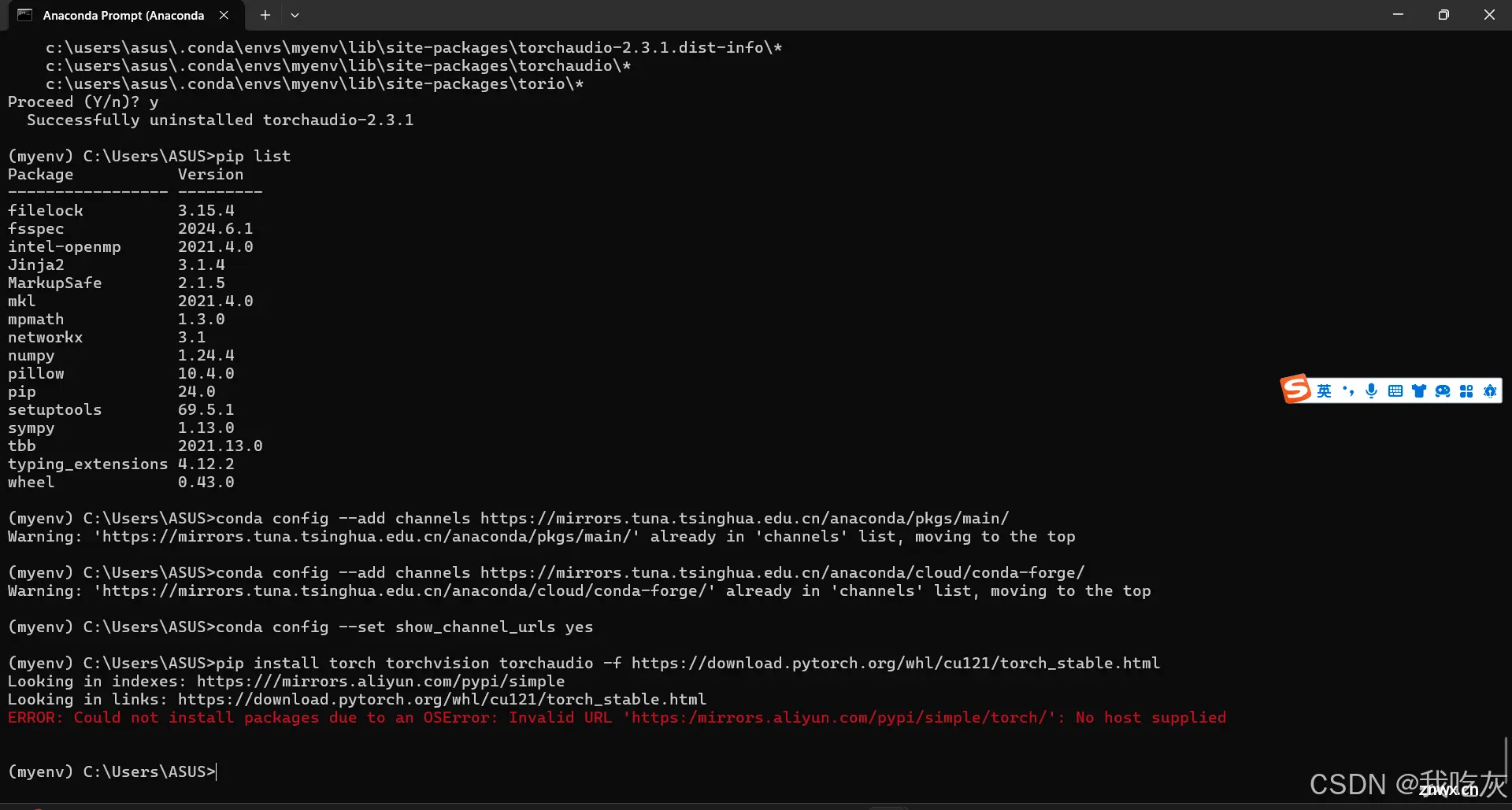

本文用于总结前几天在配置python环境的过程中碰到的种种问题,以及对自己看到的数不清的博客做一个总结归纳,将自己坎坷的安装史留次记录,希望可以给到其他人一点帮助。同时,这两天在用树莓派的时候也避不开配置pyth...

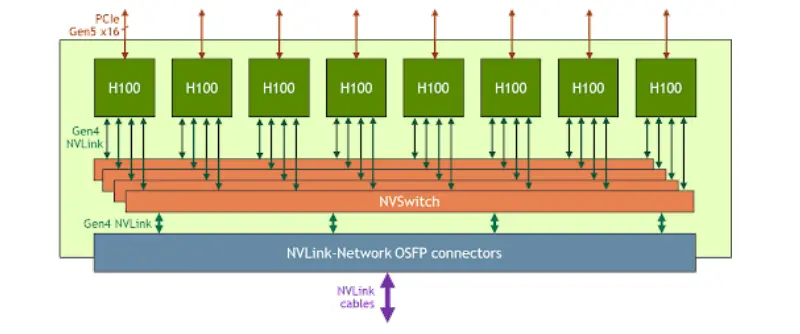

随着大模型时代的到来,模型参数量、训练数据量、计算量等各方面急剧增长。大模型训练面临新的挑战:显存挑战:例如,175B的GPT-3模型需要175B*4bytes即700GB模型参数空间,而常见的GPU显存如A100...

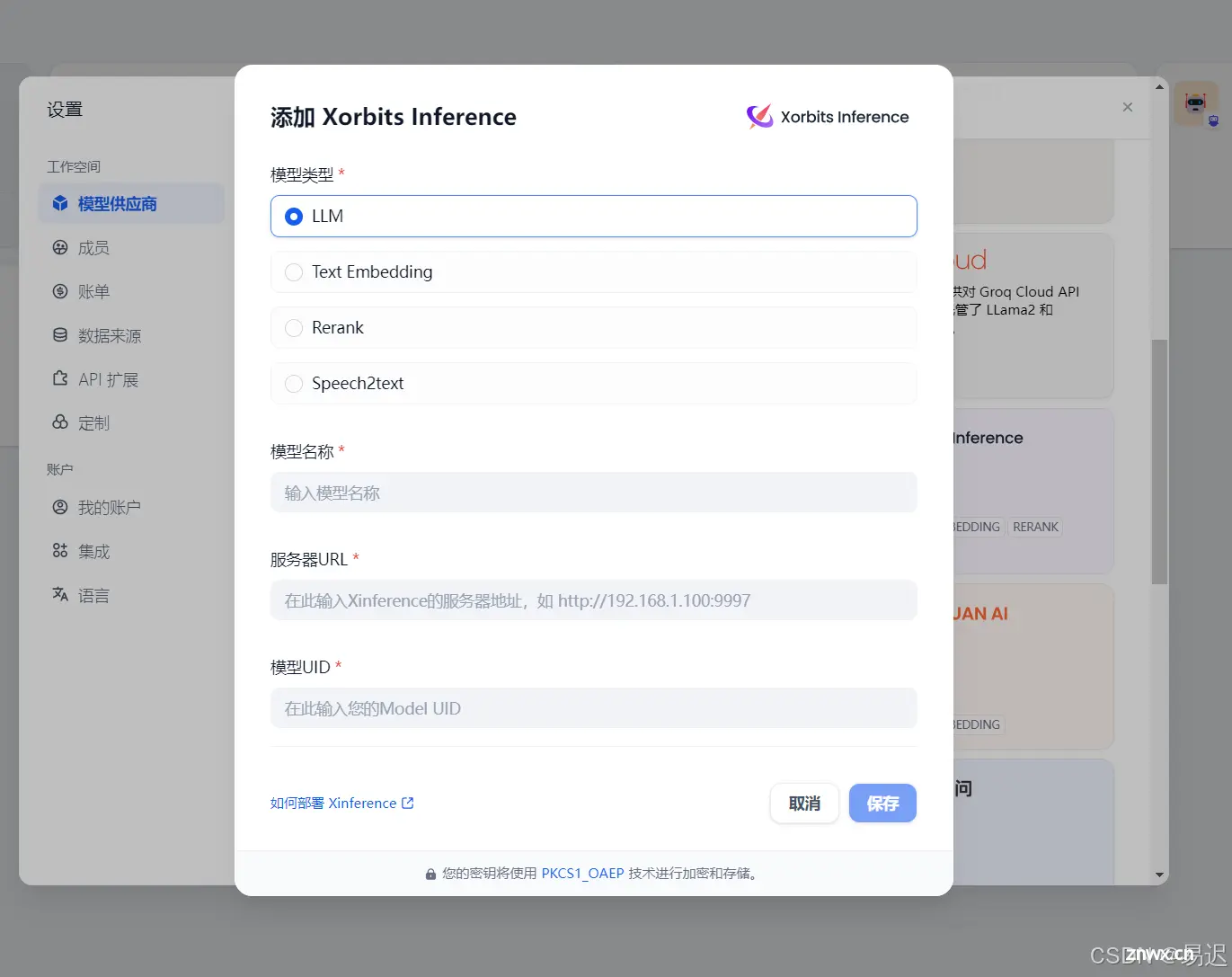

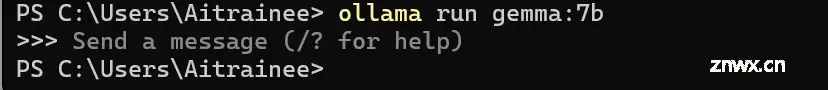

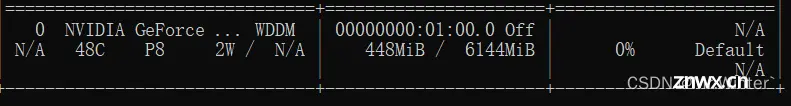

在前一篇文章RAG项目对比之后,确定Dify目前最合适的RAG框架。本次就尝试在本地GPU设备上部署Dify服务。Dify是将模型的加载独立出去的,因此需要选择合适的模型加载框架。调研一番之后...

等,进一步支撑你的行动,以提升本文的帮助力。_获取openwebui的请求头...

本文探究CUDA的内存管理机制,总结RuntimeError:CUDAoutofmemory的背后原因,并给出解决方案_cudaoutofmemory...

GPU算力租用平台推荐,推荐AutoDL、OpenBayes、智星云_gpu租用...

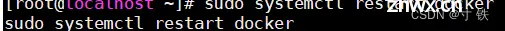

【深度学习】构建无与伦比的深度学习环境:在CentOS上实现GPU资源管理容器的终极指南这篇博文将深入探讨在CentOS操作系统上创建高度优化的深度学习环境的完整过程。我们将从零开始,逐步指导读者完成配置...

vLLM默认并不支持纯CPU模式部署和推理模式,老牛同学应网友要求,根据vLLM官网整理vLLM在CPU模式下如何部署和推理大语音模型,并以Qwen2为了进行验证和演示……...