使用docker集成vllm实现模型推理加速,并使用Tools(工具)增强模型的能力和准确性...

通过vLLM的Docker镜像,快速体验Qwen2-VL-7B-Instruct推理效果_qwen2-vldocker部署...

通过docker方式实现Qwen2.5-7B-Instruct集成vllm,流式输出...

最近在玩LLM,听闻PAI-DSW有三个月免费试用,试了一下感觉还不错,就是有一些学习成本。刚通过vllm+open-webui成功部署了Qwen2.5-7B-Instruct,也是摸索了一段时间,记录一下以便需...

vLLM是一个用于大语言模型服务的高性能框架。高吞吐量:通过优化的推理引擎,vLLM能够处理大量并发请求。低延迟:采用创新的调度算法,最小化请求的等待时间。兼容性:支持多种流行的语言模型,如GPT、LLaMA、OP...

我没找到好的解决办法,issue里说的情况都是在用源码安装后遇到的,我直接在干净环境ubuntu20.24cuda12.2下面pip安装,仍然遇到了问题。而且问题指向是torch里的class缺少属性,因此我猜测是to...

检查ninjaecho$?_vllm部署qwen2...

SGLang是一种大语言模型和视觉语言模型的服务框架。它基于并改进了多个开源LLM服务引擎的优秀设计,包括LightLLM[4]、vLLM[5]和Guidance[6]。它利用了FlashInfer[7]的高性能注意...

vLLM默认并不支持纯CPU模式部署和推理模式,老牛同学应网友要求,根据vLLM官网整理vLLM在CPU模式下如何部署和推理大语音模型,并以Qwen2为了进行验证和演示……...

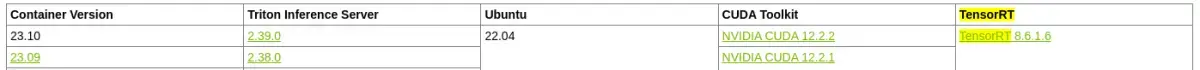

而在Triton+vLLM的组合中,Triton不会做任何的调度处理,而是将请求全部打给vLLM,让vLLM根据PagedAttention和异步API自行处理请求,vLLM的调度策略更适配大语言模型decode...