2024-07-17 11:31:01

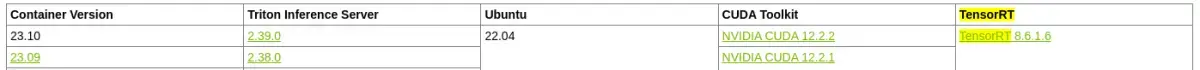

而在Triton+vLLM的组合中,Triton不会做任何的调度处理,而是将请求全部打给vLLM,让vLLM根据PagedAttention和异步API自行处理请求,vLLM的调度策略更适配大语言模型decode...

浏览 84 次 标签: AI模型部署:Triton+vLLM部署大模型Qwen-Chat实践

阅读排行

- 【抖音】《许北柠江聿珩》金金免费试读 小说全集免费在线阅读(金金)

- 陈明蒋招娣小说最新章完整版在线阅读 陈明蒋招娣小说全文在线阅读

- 主角小兔奔月 替嫁植物人?神算萌妻是大佬!的小说在线阅读 小兔奔月小说全本无弹窗

- 【抖音】热书宁染祁薄寒全本章节阅读 小说全集免费在线阅读(甜甜疯了)

- 小说宁染祁薄寒在线阅读 甜甜疯了小说大结局无弹窗

- 《沈枝意江淮川》小说景萱最新章节阅读 小说全集免费在线阅读(景萱)

- 《苏瑾年沈向东》小说大雪最新章节阅读 精品《苏瑾年沈向东》小说在线阅读

- 秦深钟时夏继承遗产后,我包养了顶流影帝无删减(秦深钟时夏:继承遗产后,我包养了顶流影帝结局+番外)全文免费阅读无弹窗大结局_秦深钟时夏继承遗产后,我包养了顶流影帝完本小说全章节阅读(秦深钟时夏:继承遗产后,我包养了顶流影帝结局+番外)

- 小说谢清梨江应森 5 土豆猫小说精彩章节在线阅读

热门文章

- 陈明蒋招娣by年代:我和三个大姨子相依为命第6章 小说全集免费在线阅读(曾经的故事)

- 姜绾歌沈辞州by皇宫大殿之上,姜绾歌跪在在线阅读 新书《姜绾歌沈辞州》小说全集阅读

- 我的心在他胸腔跳动(江宴修夏南絮)全文免费阅读无弹窗大结局_(我的心在他胸腔跳动)江宴修夏南絮最新章节列表_笔趣阁

- 穿越海岛求生,我有空间小世界!君弑臣上官婉儿彩蛋(君弑臣上官婉儿)全书在线下载阅读完美终章小说大结局

- 主角天羽落行的小说 叶长林叶霜月小说全文免费阅读

- 第3章小说无广告阅读 团扇子小说 周瑞瑞凌珩小说全文免费阅读

- 【完结版】《罗俏俏卫衡主角佚名章节在线阅读 罗俏俏卫衡小说全文在线阅读

- 【抖音】小说方夏韩霜无广告阅读 佚名小说精彩章节在线阅读

- 入职地府:为了绩效嘎嘎乱杀夏白彩蛋(夏白)全书在线下载阅读完美终章小说大结局

名师推荐

- 主角知君子意 离开前夫后,我迷倒了豪门太子爷的小说在线阅读 知君子意小说全文免费试读

- 全文浏览沈幼梧厉北暝免费(真千金她一抬眸,海城大佬齐低头)_沈幼梧厉北暝免费(真千金她一抬眸,海城大佬齐低头)全文结局

- 姜绾歌沈辞州 新书《姜绾歌沈辞州》小说全集阅读

- 安安的出院倒计时免费阅读第4章小说无广告阅读 佚名小说 佚名小说大结局无弹窗

- 姜绾歌沈辞州未删减阅读 新书《姜绾歌沈辞州》小说全集阅读

- 【新书】《袁溪蓝英》主角大黄鱼全文全章节小说阅读 新书《袁溪蓝英》小说全集阅读

- (全文在线阅读)江晚傅云霆 主角江晚 江晚小说全部章节目录

- (精品)谢清梨江应森小说 2 土豆猫小说精彩章节在线阅读

- 我的心在他胸腔跳动:结局+番外(江宴修夏南絮:结局+番外小说)全文免费阅读无弹窗大结局_ 我的心在他胸腔跳动:结局+番外全文免费阅读小说江宴修夏南絮:结局+番外全文免费阅读最新章节列表_笔趣阁(我的心在他胸腔跳动:结局+番外小说)