Centos的docker部署安装超详细教程(零基础可用)以及docker常用命令详解(图文结合纯干货,适用于初学者)_centosdocker...

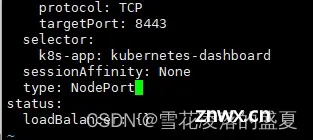

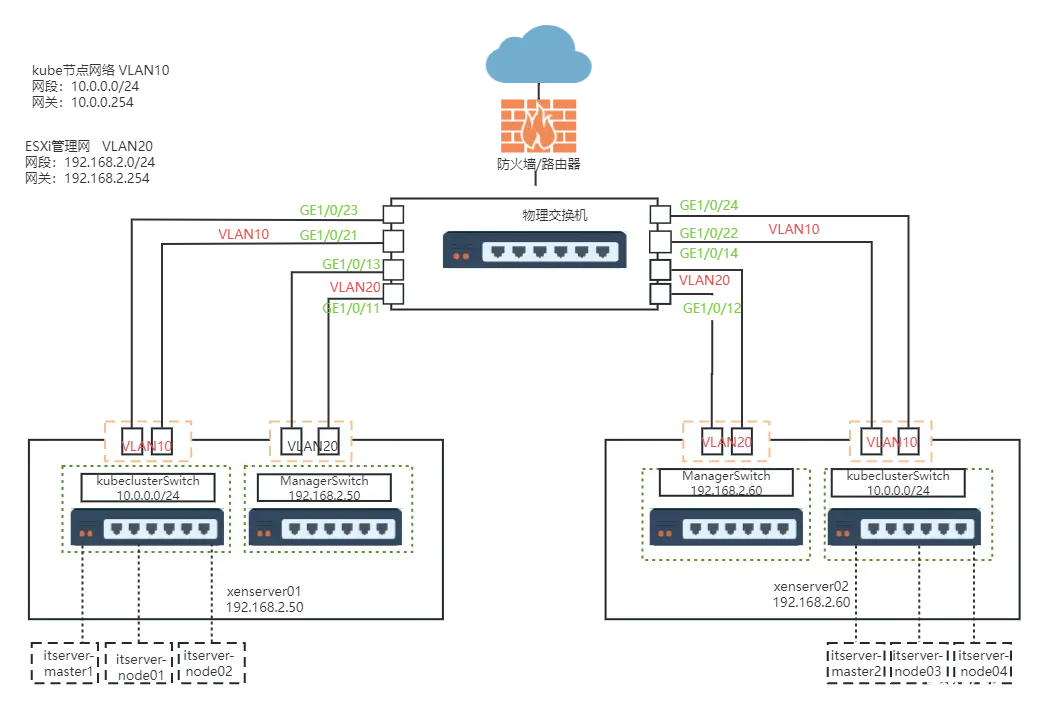

或者你也可以使用默认端口,把API服务器放到一个监听443端口的负载均衡器后面,并且路由所有请求到API服务器的默认端口。当你在一个有严格网络边界的环境里运行Kubernetes,例如拥有物理网络...

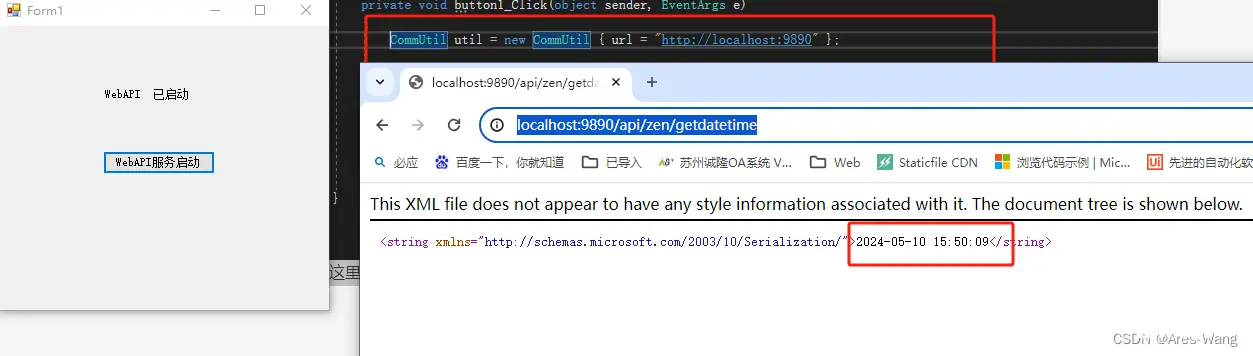

一、webservice部署只能部署IIS上,比较简单,就不做说明了二、WCF部署1部署到IIS跟部署webservice部署方法一样的wcf部署2部署到控制台要以管理员运行vs,或者...

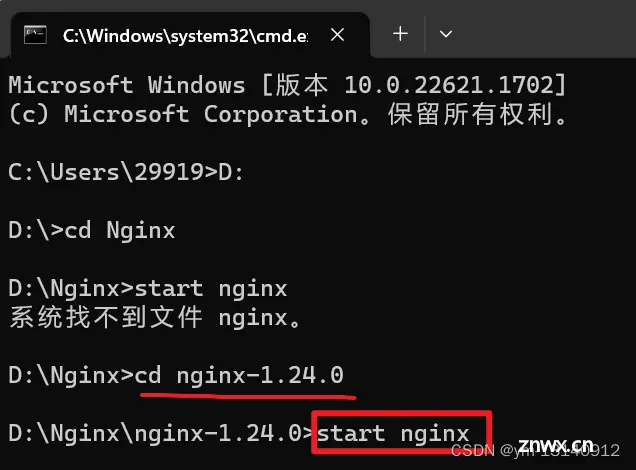

Nginx的基本使用、nginx.conf配置文件、负载均衡、部署前端项目。_nginx启动前端项目...

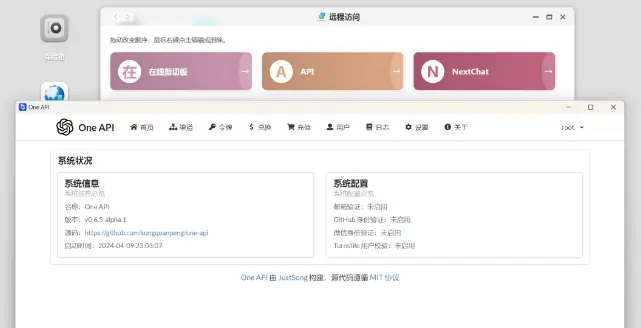

本文首先在引言中强调了一下OpenAI兼容API的重要性,希望引起读者重视,其次介绍了Qwen-VL的原理与模型结构,最后简要讲了下FastAPI以及搭配组件,并基于FastAPI封装了OpenAI兼容API...

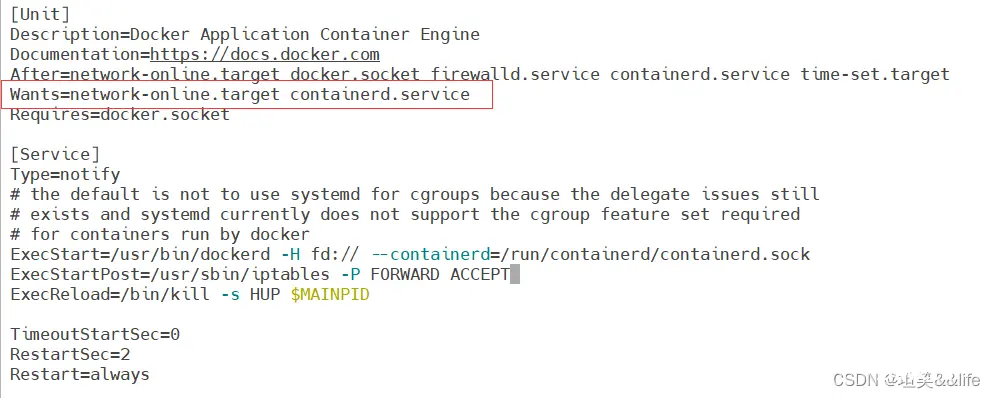

Kubernetes1.29.4离线安装部署;脚本化快速部署;容器运行时采用Containerd;逐步支持多平台部署。_kubeadmin离线安装...

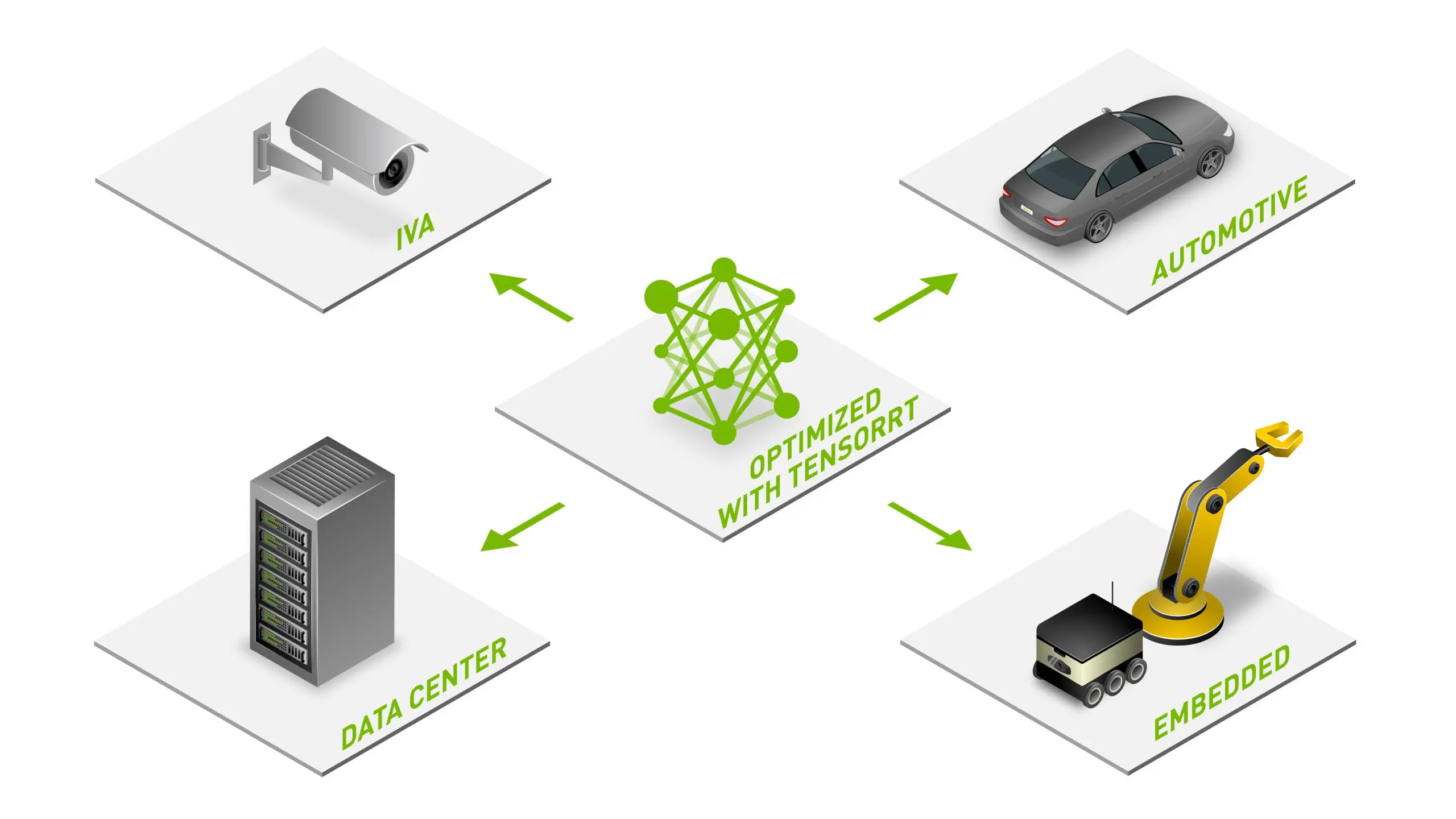

NVIDIA®TensorRT™是一款用于高性能深度学习推理的SDK,包含深度学习推理优化器和运行时,可为推理应用程序提供低延迟和高吞吐量。YOLOv10是清华大学研究人员近期提出的一种实时目标检测方法,通过消除NMS、优化模型架构和引入创新模块等策...

近期,从几百个AI大模型中突围的Kimi,因免费试用、模型大、响应快、扩展功能多等特点受到欢迎,被称为GPT4.0超级平替,火爆出圈!相信很多人手机中已经拥有了Kimi了吧!_kimi本地化部署...

思通数科的语音识别技术基于先进的深度学习算法,通过端到端的建模方式,实现了对多种采样率和场景下的语音进行精准识别。该技术不仅在中文普通话的识别上达到了高准确率,同时也支持略带口音的中文和英文识别,满足多语种的识别...

生成式人工智能的采用率显着上升。在2022年OpenAIChatGPT推出的推动下,这项新技术在几个月内就积累了超过1亿用户,并推动了几乎所有行业的开发活动激增。到2023年,开发人员开始使用来...