LLM大模型从入门到精通_llm模型...

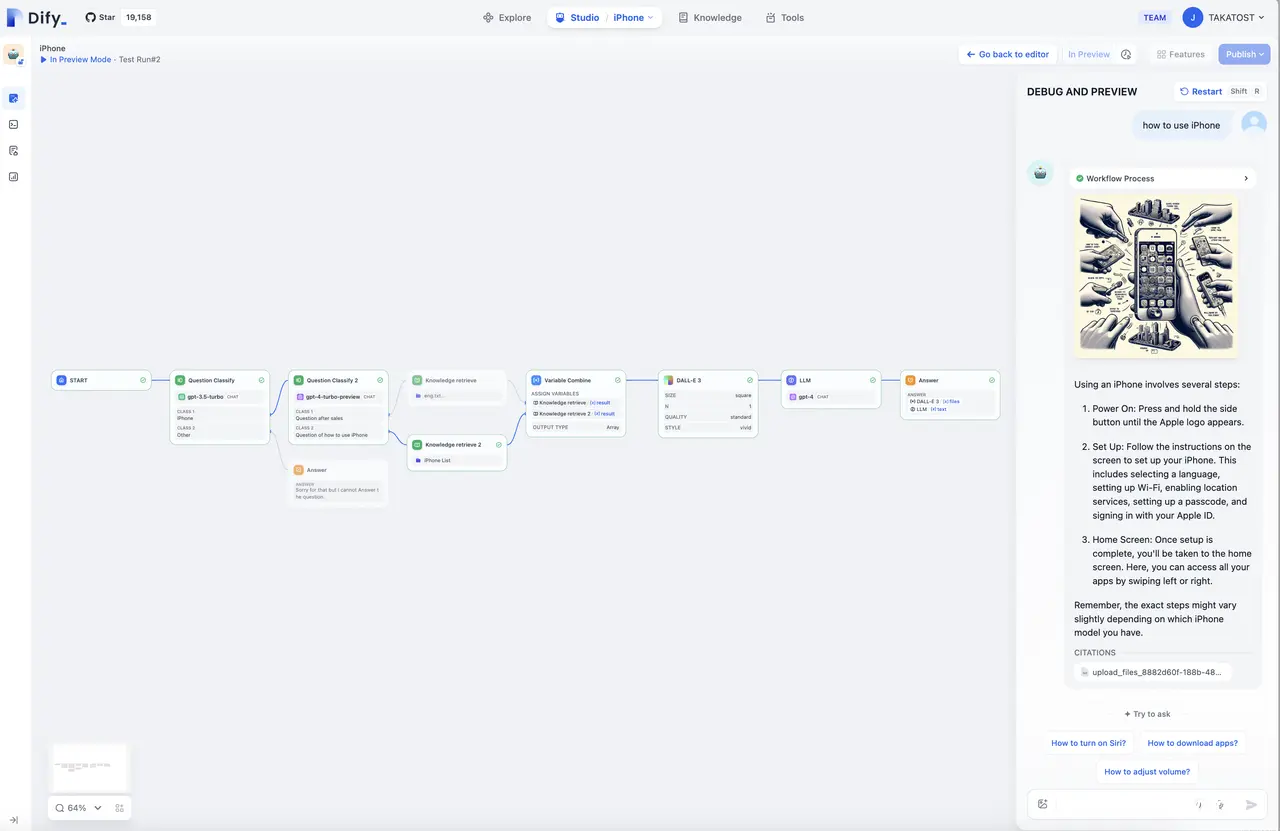

RAG+AI工作流+Agent:LLM框架该如何选择,全面对比MaxKB、Dify、FastGPT、RagFlow、Anything-LLM,以及更多推荐_maxkbdifyfastgpt...

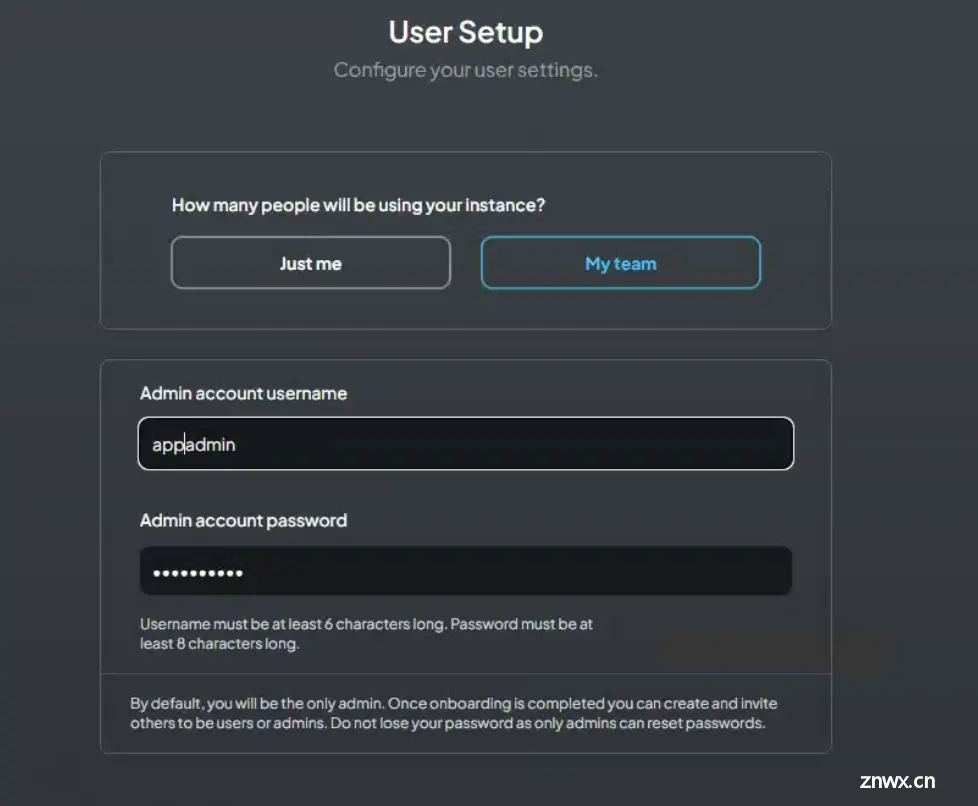

整个过程需要准备三个工具:Ollama:用于运行本地大模型的管理:llama3,qwen2等Docker:用于运行AnythingLLM。AnythingLLM:知识库运行平台,提供知识库构建及运行的功能。_ol...

Mem0的LLM记忆实现方法与检索增强生成(RAG)等传统方法相比具有明显优势。与从静态文档中检索信息的RAG不同,Mem0的记忆层可以理解和关联不同交互中的实体,保持上下文连续性并优先考虑相关的...

在人工智能驱动的多样化故事世界中,有一个独特的机会可以让年轻受众参与定制的个性化叙事。本文介绍的FairyLandAI是通过OpenAI的应用程序接口(API)开发的创新型大语言模型(LLM),专门用于为...

近日,上海交大为大模型能够在智能手机上部署提出PowerInfer-2,该框架是专为智能手机设计且高度优化的推理框架。目前PowerInfer-2支持的最大模型是Mixtral47BMoE模型,在inferenc...

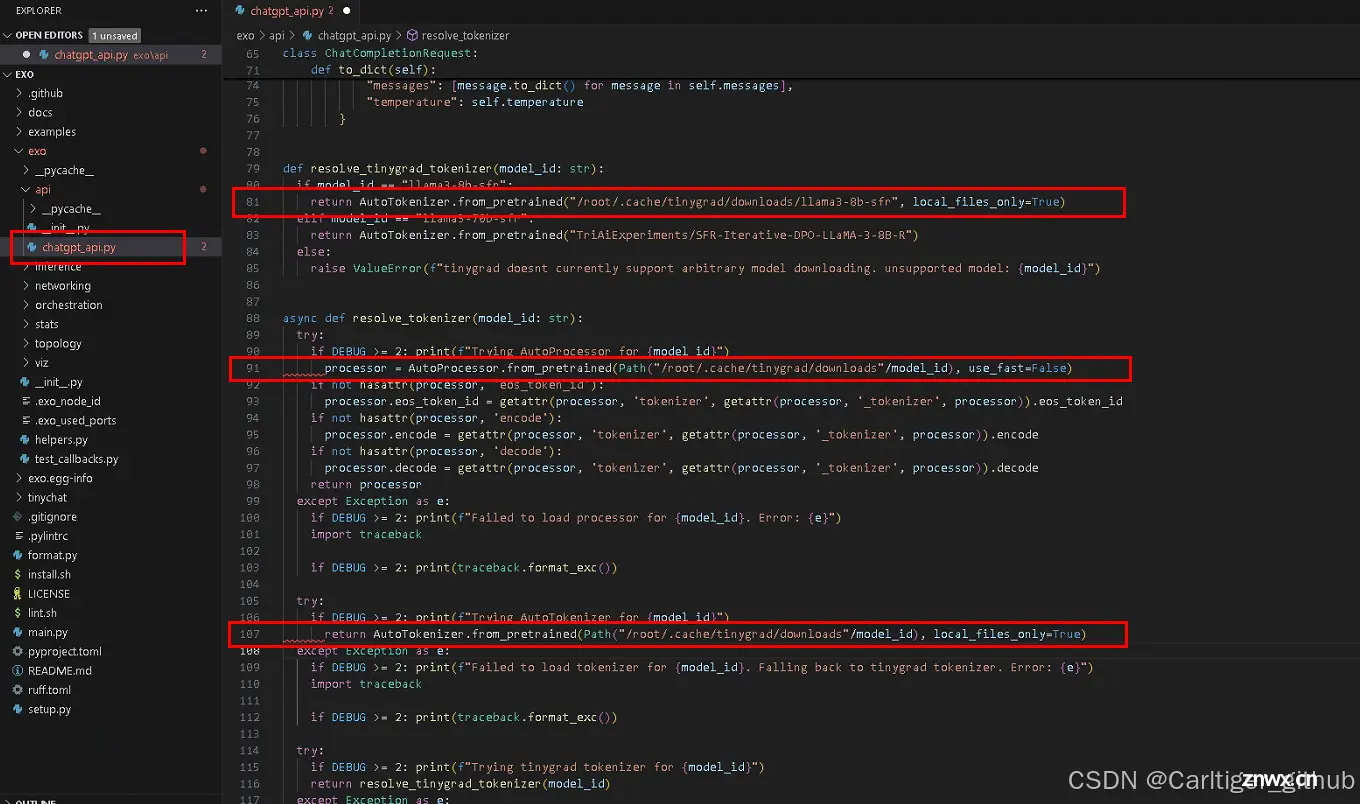

分布式LLM推理,AI集群安装教程,ubuntu22.04不编译安装python3.12,安装pip3.12,ubuntu安装分布式推理AI集群exo.本地运行分布式LLM推理离线运行exo,安装调试分布式LLM...

vLLM默认并不支持纯CPU模式部署和推理模式,老牛同学应网友要求,根据vLLM官网整理vLLM在CPU模式下如何部署和推理大语音模型,并以Qwen2为了进行验证和演示……...

本文对使用transformers的AutoModelForCausalLM进行尝试,主要对CausalLM(因果推理模型)进行实例化,需要与同类的AutoTokenizer分词器一起使用。同时,列举了管道模型、...

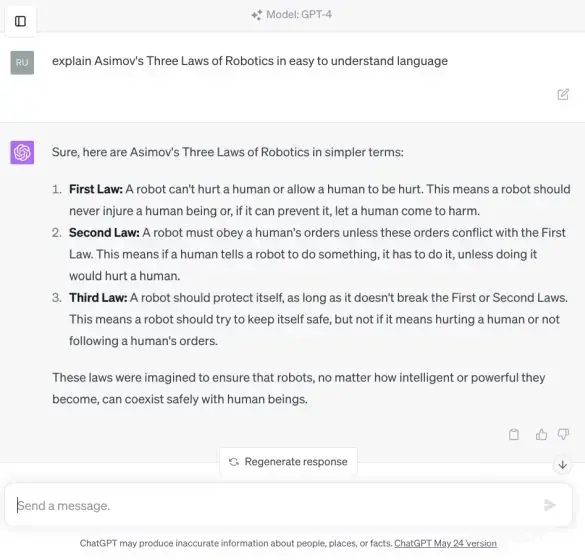

GPT-4是当前最先进的大型语言模型之一,由OpenAI开发。它具有复杂的推理理解能力和高级编码功能,使其在自然语言处理任务中表现卓越,包括但不限于文本生成、摘要、翻译和对话系统。Google的Pathways...