弱智吧的数据如何调教进行微调?_ruozhibaqa2449json...

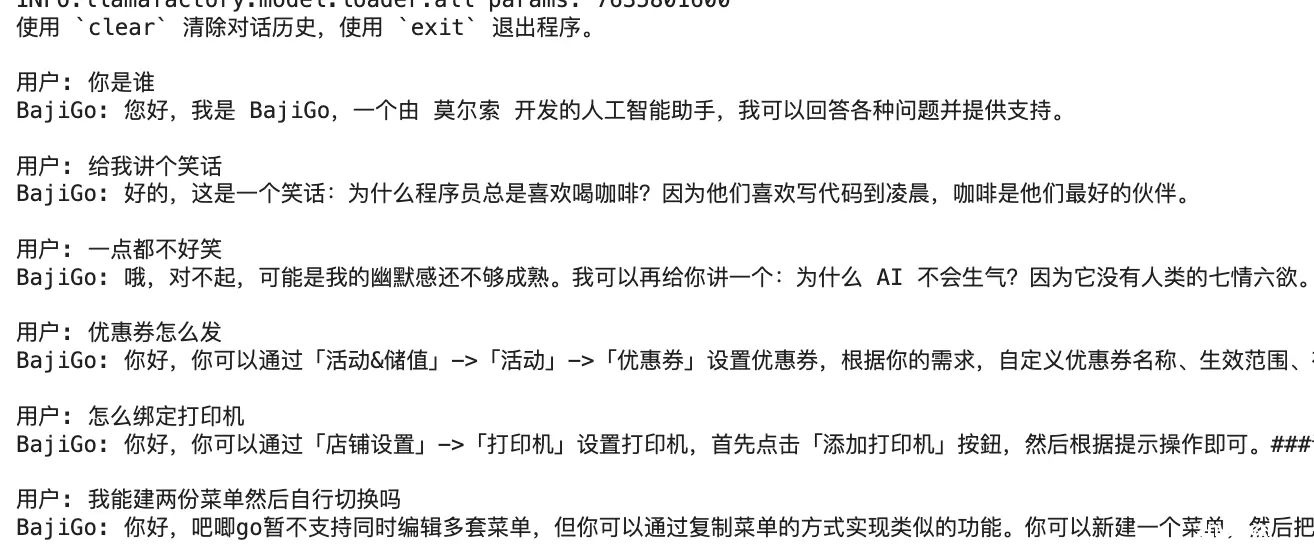

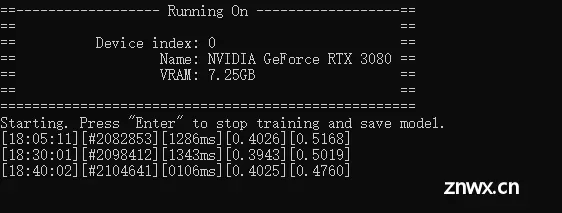

有效的微调已成为大型语言模型(LLMs)适应特定任务的必要条件之一。然而,这需要一定的努力,有时也相当具有挑战性。随着Llama-Factory的引入,这一全面的框架让训练更加高效,用户无需编写代码即可轻松为...

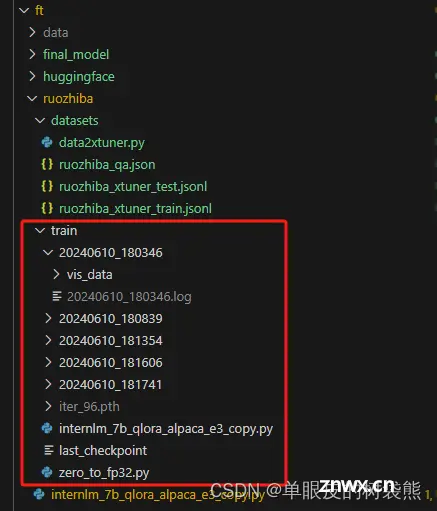

LLaMA-Factory在data文件夹中提供了多个训练数据集示例,支持alpaca或sharegpt格式,不过我这里使用的是自己提前导出来做过处理的自定义数据集。自定义数据集选用alpaca因为我只有标注后的问...

DeepFaceLab是一种基于深度学习的人脸合成和转换工具。它使用了深度神经网络来分析和修改图像中的人脸部分,可以实现将一个人的脸部特征应用到另一个人的照片上,或者进行面部表情、年龄、性别等特征的变换。DeepF...

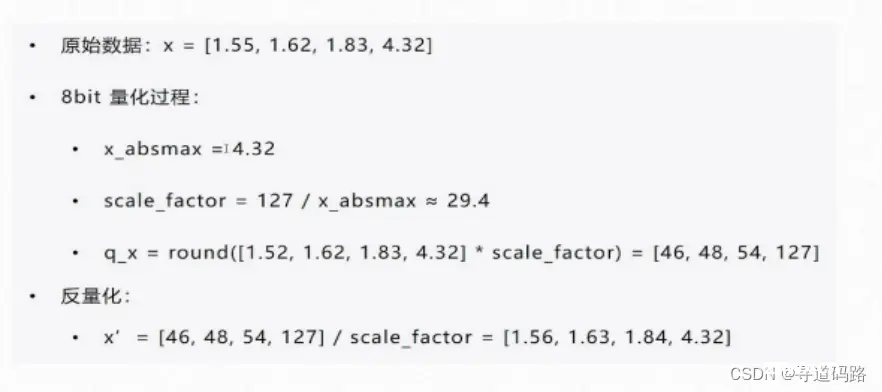

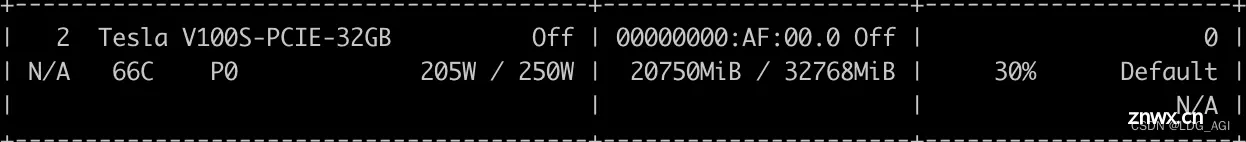

在深度学习的不断进步中,大型语言模型(LLMs)的预训练和微调技术成为了研究的热点。其中,量化技术以其在模型压缩和加速方面的潜力备受关注。本文将深入探讨QLoRA(QuantizedLow-RankAdap...

本文首先对量化和微调的原理进行剖析,接着以Qwen2-7B为例,基于QLoRA、PEFT一步一步带着大家微调自己的大模型,本文参考全网peft+qlora微调教程,一步一排坑,让大家在网络环境不允许的情况下,也...

基于LoRA进行模型微调时,需要先冻结全部参数,再指定相应的Linear层进行微调,那么如何计算全部参数,如何计算微调参数以及如何计算微调参数占全部参数的比例呢?本文先对Qwen2模型结构进行一览,做到心中有数,之...

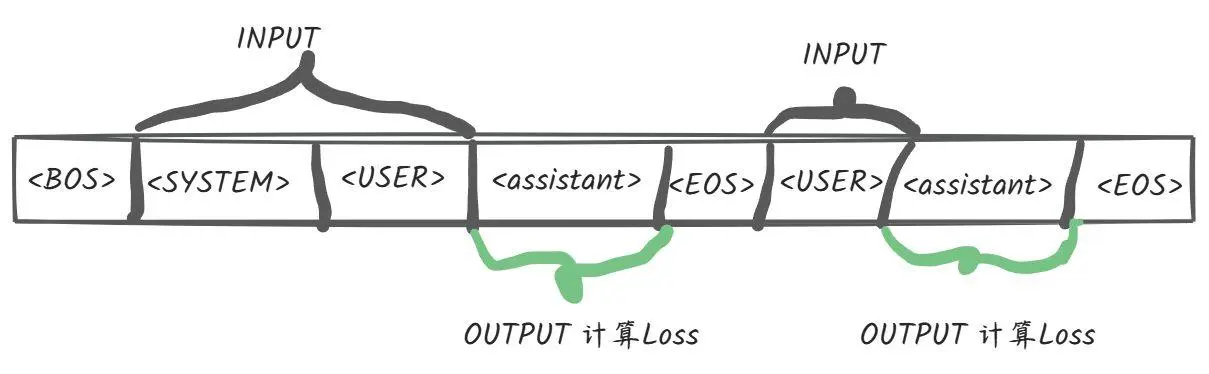

概述Github官方地址:GLM-4网上已经有很多关于微调的文章,介绍各种方式下的使用,这里不会赘述。我个人比较关心的是微调时的loss计算逻辑,这点在很多的文章都不会有相关的描述,因为大多数人都是关心如何使用之类的应用层,而不是其具体的底层逻辑,当然咱也...

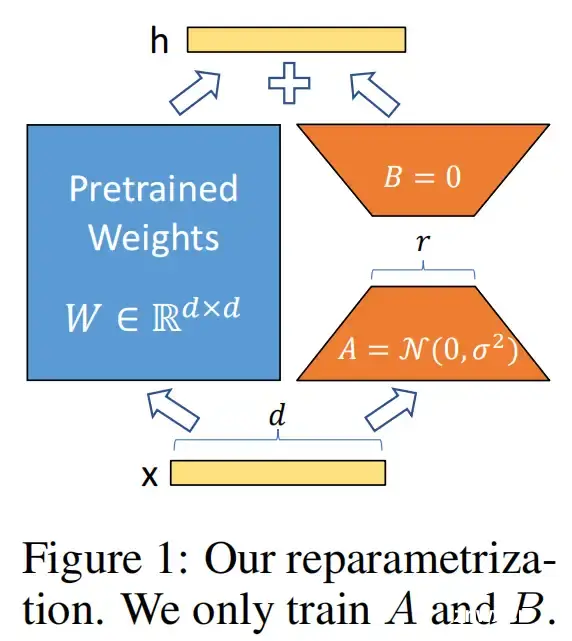

博客首发于我的知乎,详见:https://zhuanlan.zhihu.com/p/702629428一、LoRA原理LoRA(Low-RankAdaptationofLLMs),即LLMs的低秩适应,是参数高效微调最常用的方法。LoRA的本质就是...

SegmentAnything模型(SAM)是由MetaAI开发的细分模型。它被认为是计算机视觉的第一个基础模型。SAM在包含数百万张图像和数十亿个掩码的庞大数据语料库上进行了训练,使其非常强大。顾...