2024-08-20 12:31:01

具备1120*1120高分辨率下的中英双语多轮对话能力,在中英文综合能力、感知推理、文字识别、图表理解等多方面多模态评测中,GLM-4V-9B表现出超越GPT-4-turbo-2024-04-09、Gemi...

2024-08-19 12:33:03

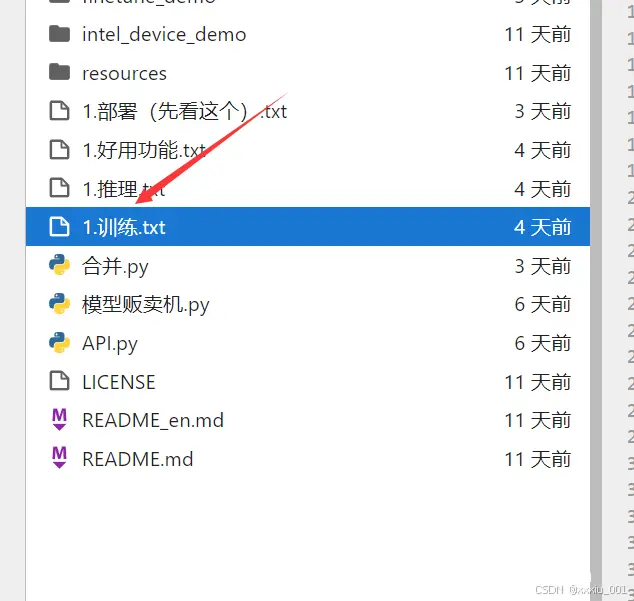

我们打开output文件夹,这里面的所有文件都是你刚刚保存的模型,后面的数字就是不同步数下保存的模型。然后save_steps的意思是模型多少步会保存一次的意思,这里我输入的是50也就是说,模型每50步的时候,...

2024-08-17 16:01:03

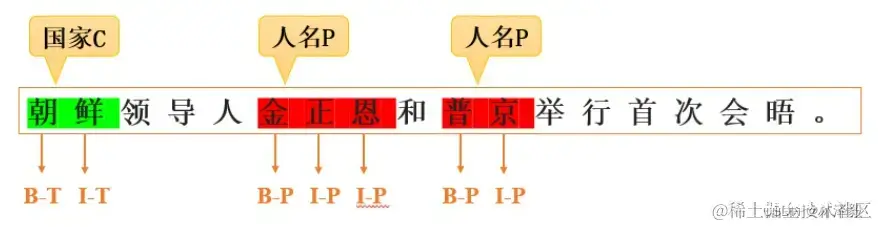

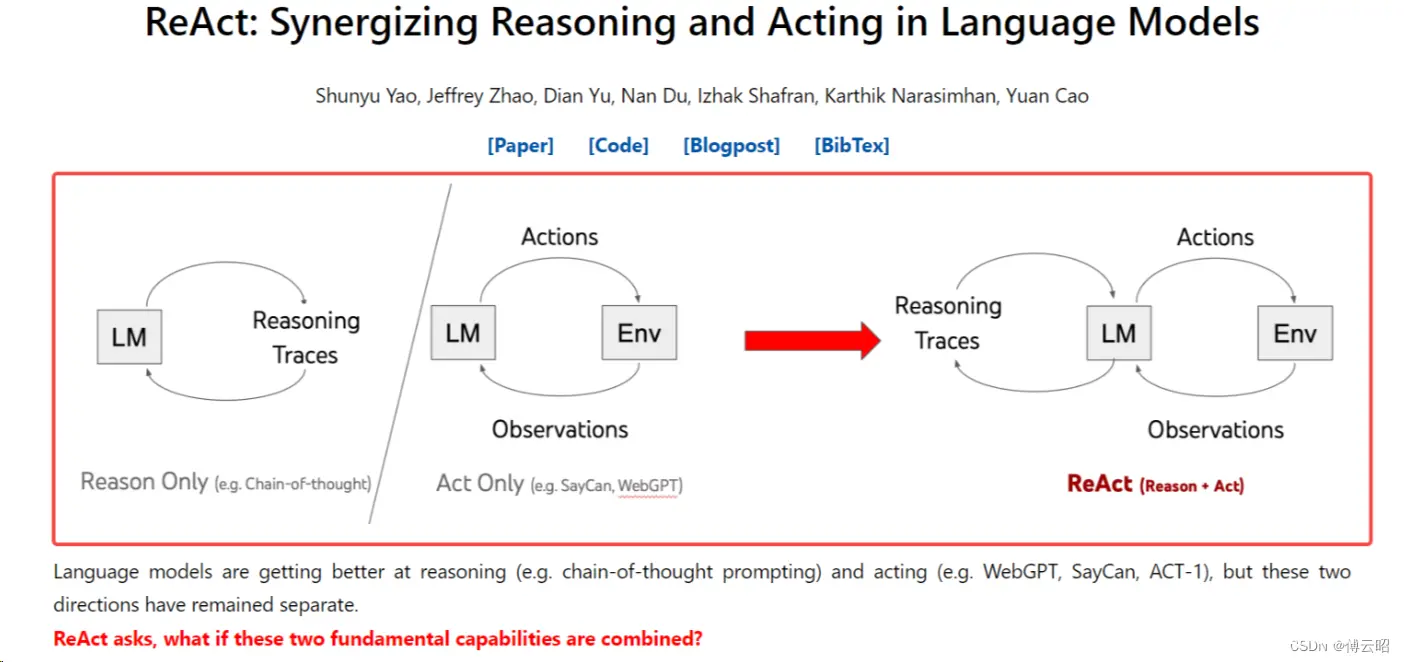

大模型指令微调(InstructionTuning)是一种针对大型预训练语言模型的微调技术,其核心目的是增强模型理解和执行特定指令的能力,使模型能够根据用户提供的自然语言指令准确、恰当地生成相应的输出或执行相关任务...

2024-08-03 14:31:01

参考了一些官方和他人帖子:主要就是LLM类的继承和重写#函数继承和重写@property我们这里的本地模型是chatglm6B,结果:显存:速度:10个字需要0.12s。_langchainchatglm4...

2024-06-27 10:01:06

GitHub-THUDM/GLM-4:GLM-4series:OpenMultilingualMultimodalChatLMs|开源多语言多模态对话模型我是在云服务器上(算力云)推理的GLM4...

2024-06-17 10:01:09

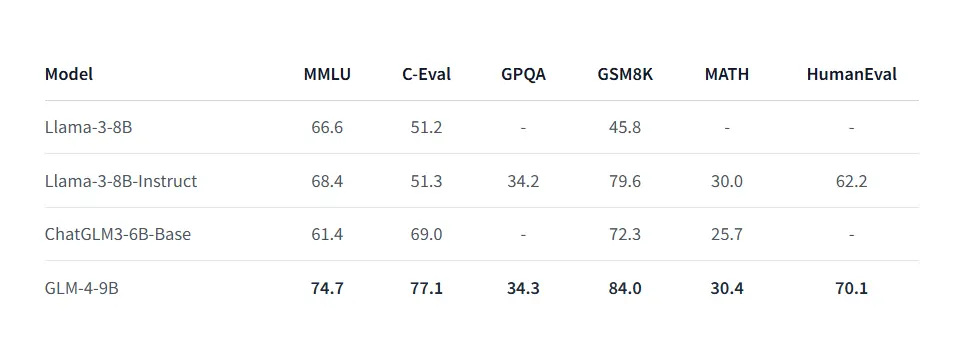

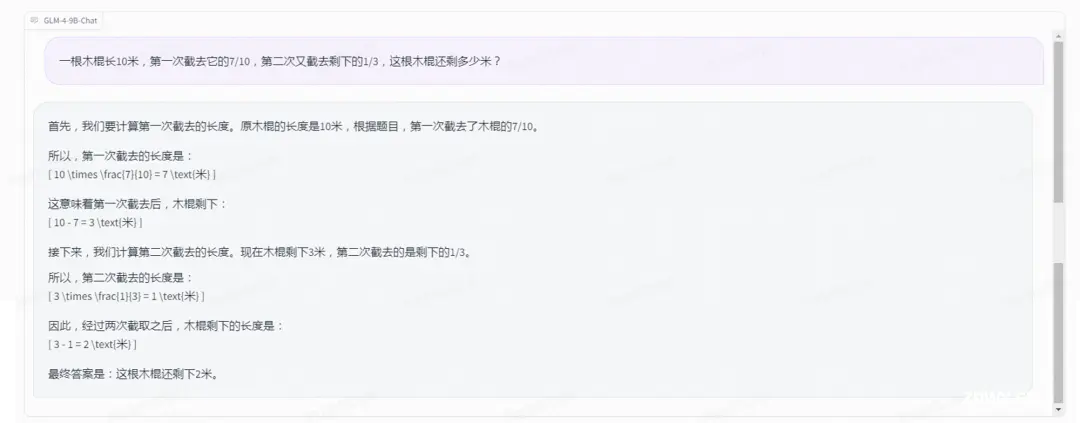

GLM-4-9B是智谱AI推出的最新一代预训练模型GLM-4系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B及其人类偏好对齐的版本GLM-4-9B-Chat均表现...

2024-06-11 15:01:21

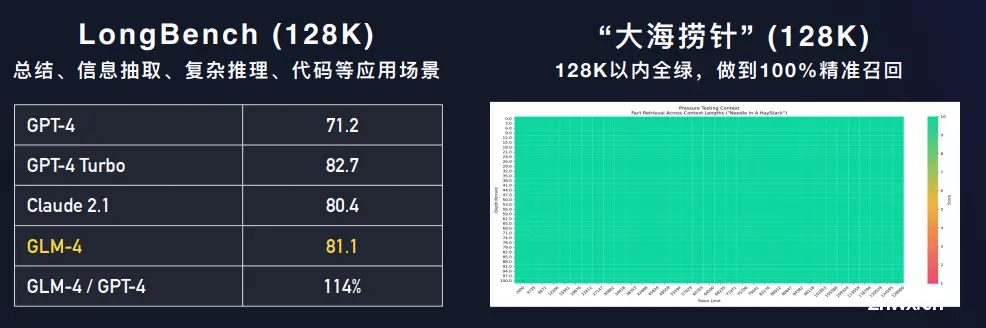

这是在智谱AI开发者大会上推出的新一代基座大语言模型,GLM4相比较此前最大的特点是三个变化:性能全面提升、上下文长度更长、支持更强的多模态能力。GLM4(GLM4)详细信息|名称、简介、使用方法,开源情况,...