智谱AI发布国产最强大模型GLM4,理解评测与数学能力仅次于Gemini Ultra和GPT-4,编程能力超过Gemini-pro,还有对标GPTs商店的GLMs

数据学习(Datalearner) 2024-06-11 15:01:21 阅读 64

本文来自DataLearnerAI官方网站:智谱AI发布国产最强大模型GLM4,理解评测与数学能力仅次于Gemini Ultra和GPT-4,编程能力超过Gemini-pro,还有对标GPTs商店的GLMs | 数据学习者官方网站(Datalearner)

https://www.datalearner.com/blog/1051705395420733

GLM4是智谱AI发布的第四代基座大语言模型,全称General Language Model,最早由清华大学KEG小组再2021年发布。这个基座模型也是著名的开源国产大模型ChatGLM系列的基座模型。本次发布的第四代GLM4的能力相比此前的基座模型提升了60%,已经与世界最强模型Gemini Ultra和GPT-4接近!

GLM-4基座模型介绍 各项评测结果大幅提升:性能全面增强GLM4最高支持128K超长上下文GLM4的多模态支持GLM-4 All ToolsGLMs商店总结

GLM-4基座模型介绍

这是在智谱AI开发者大会上推出的新一代基座大语言模型,GLM4相比较此前最大的特点是三个变化:性能全面提升、上下文长度更长、支持更强的多模态能力。GLM-4在DataLearnerAI的模型信息卡地址:GLM4(GLM4)详细信息 | 名称、简介、使用方法,开源情况,商用授权信息 | 数据学习 (DataLearner)

各项评测结果大幅提升:性能全面增强

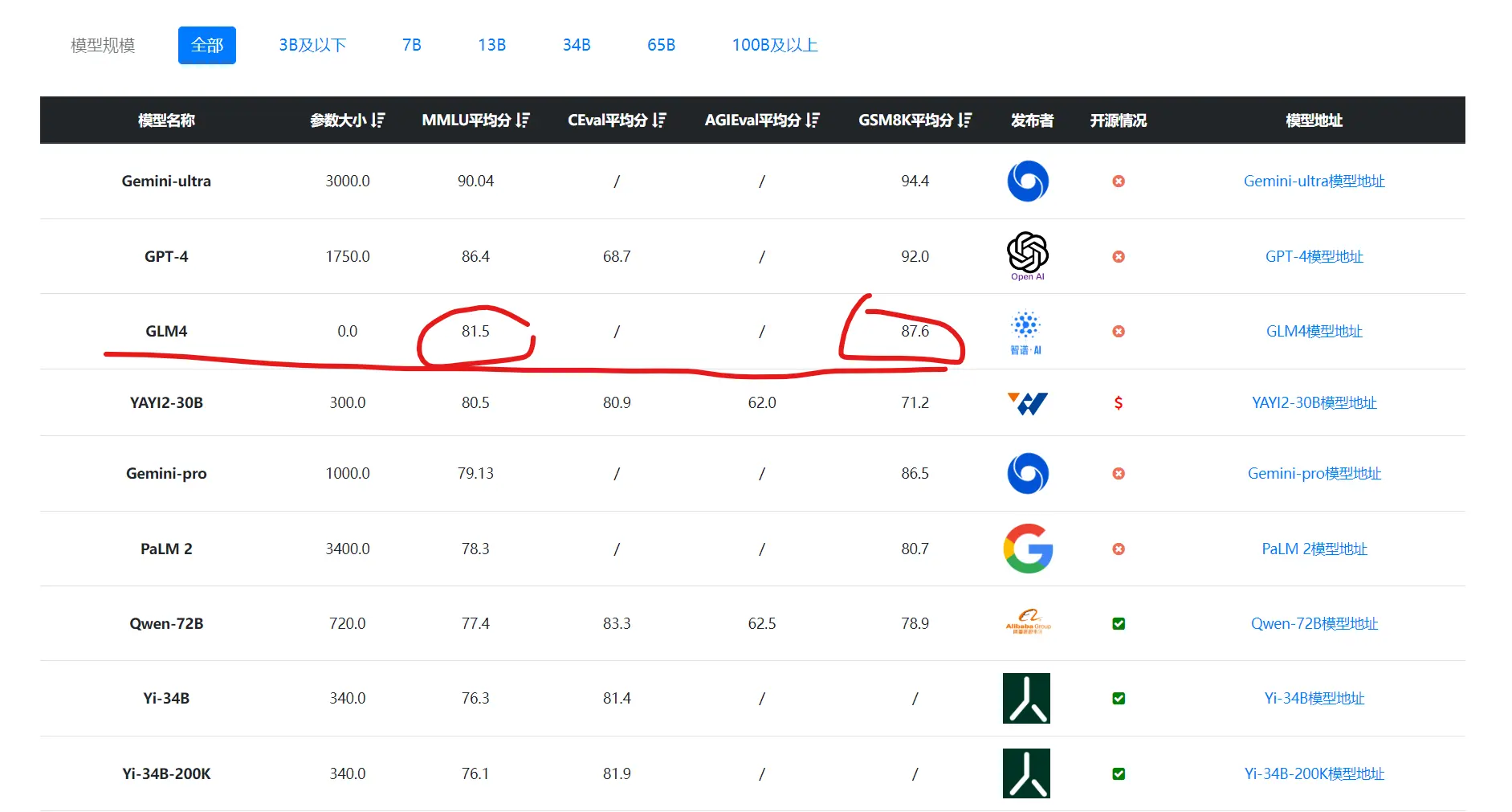

GLM4公布了其在各项评测的结果,包括MMLU理解评测、GSM8K数学逻辑和代码水平上,都有大幅提升。

下图是DataLearner综合评测按照MMLU排序的结果:

数据来源:大模型综合评测对比 | 当前主流大模型在各评测数据集上的表现总榜单 | 数据学习 (DataLearner)

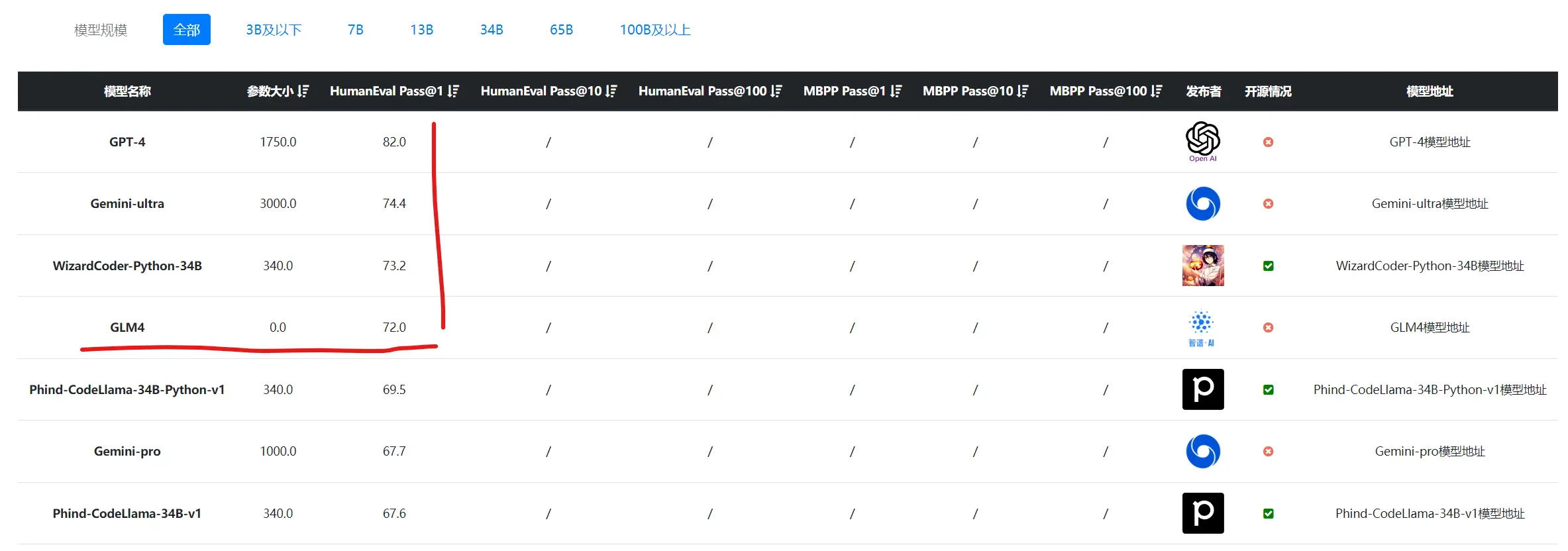

以及编程评测按照HumanEval排序的结果,可以看到,不论哪个对比,GLM4的表现都可以理解为与GPT-4和Gemini Ultra差不多,应该是比GPT-4略低。

数据来源:大模型代码能力评测对比 | 当前主流大模型在代码能力上的表现总榜单 | 数据学习 (DataLearner)

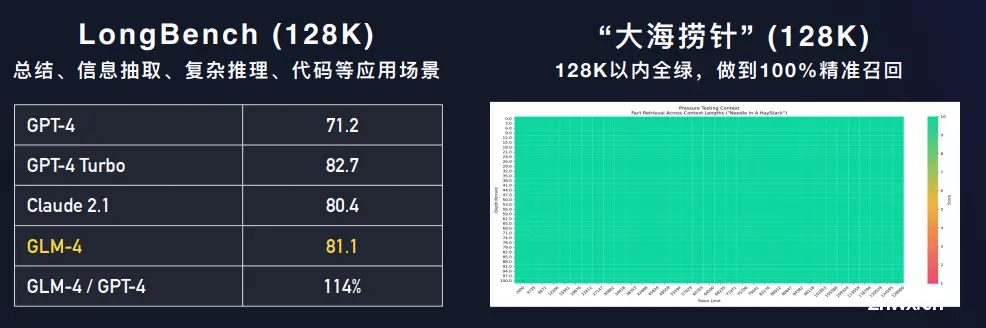

GLM4最高支持128K超长上下文

在之前的模型中,智谱AI的模型最高支持32K上下文长度,而本次GLM4的发布,将上下文的长度提升到了128K,与GPT-4对齐。他们也根据此前的“needle in a haystack”(大海捞针)测试(详情参考此前GPT-4与Claude的测试:GPT-4-Turbo的128K长度上下文性能如何?超过73K Tokens的数据支持依然不太好! | 数据学习者官方网站(Datalearner) 和 如何提高大模型在超长上下文的表现?Claude实验表明加一句prompt立即提升效果~ | 数据学习者官方网站(Datalearner) )。

从上图看,GLM4-128K的在超长上下文的水平表现上与GPT-4-Turbo和Claude-2.1几乎完全一致。表现非常不错~

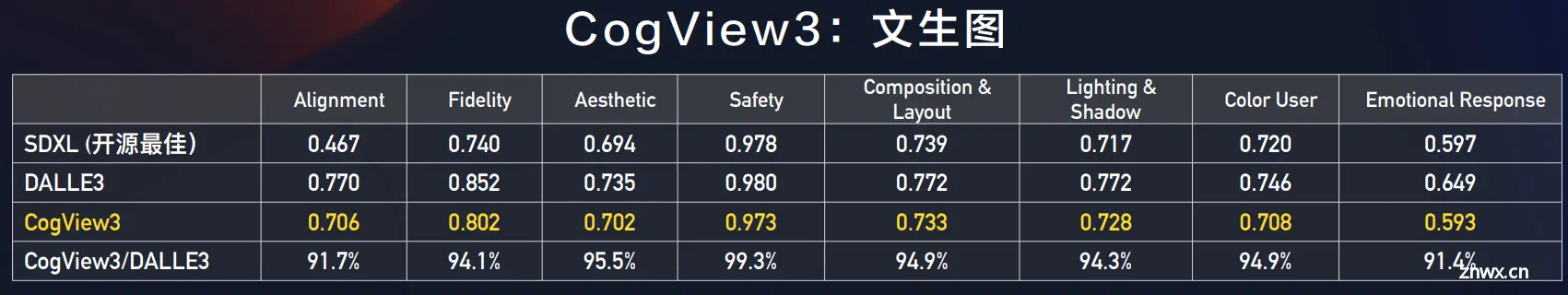

GLM4的多模态支持

除了基础语言能力的提升,GLM4在多模态的支持上也更强。这里提到的就是CogView3,这是底层基于GLM4为语言模型的多模态大模型,在各项评测结果中非常不错,与DALL·E3的水平几乎一致。

下图是一些生成图片的样例:

画面还是非常精致的。

GLM-4 All Tools

此次,智谱AI还推出了对标GPT-4 All Tools的GLM-4 All Tools,一个集合了各种工具,可以自主规划任务分解任务并执行的一个类似AI Agent模式的大模型系统。这个系统相比较基座模型,可以通过调用代码解释器、网络浏览器工具等提升模型的水平。根据测试,这个模型系统比基座模型在各项评测结果中有更好的提升。

GLMs商店

此次智谱AI还推出了对标GPTs商店的GLMs商店,开发者可以自定义GLMs来推出基于GLM4的自定义大模型服务,也会有开发者分成计划,不过官网还未更新,暂不确定具体能力和水平。

更多详情参考原文:智谱AI发布国产最强大模型GLM4,理解评测与数学能力仅次于Gemini Ultra和GPT-4,编程能力超过Gemini-pro,还有对标GPTs商店的GLMs | 数据学习者官方网站(Datalearner)

上一篇: 智能文字识别技术——AI赋能古彝文保护

下一篇: AI赋能100%提高项目管理效率

本文标签

智谱AI发布国产最强大模型GLM4 还有对标GPTs商店的GLMs 理解评测与数学能力仅次于Gemini Ultra和GPT-4 编程能力超过Gemini-pro

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。