大家好,我是默语,擅长全栈开发、运维和人工智能技术。在PyTorch模型的推理阶段,RuntimeError是常见的问题之一。这类错误通常会导致模型推理延迟,严重影响模型的实时性能和用户体验。本篇博客将深入探讨R...

让我们简要回顾一下深度神经网络中BatchNorm的基本概念。这个想法最初是由Ioffe和Szegedy在一篇论文中引入的,作为加速卷积神经网络训练的一种方法。假设zᵃᵢ表示深度神经网络给定层的输入,其中a是从a=...

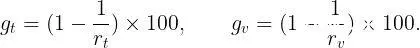

直接去下载官方的yolov8源码就行,那里面集成了obb。...

本文介绍了Transformer模型推理性能优化技术KVCache,通过缓存Self-Attention和Cross-Attention中的键值对,减少重复计算,提升解码速度。在大模型如GPT中,KVCache能有效减少计算量,尤其...

源2.0是浪潮信息发布的新一代基础语言大模型。我们开源了全部的3个模型源2.0-102B,源2.0-51B和源2.0-2B。并且我们提供了预训练,微调,推理服务的相关脚本,以供研发人员做进一步的开发。源2.0是...

边缘计算(EdgeComputing)是一种分布式计算架构,它将计算、存储和数据处理任务从数据中心或云计算平台移动到数据产生的地点,即“边缘”设备上。边缘计算常用于需要实时数据处理的应用场景,比如智能城市、自动驾驶...

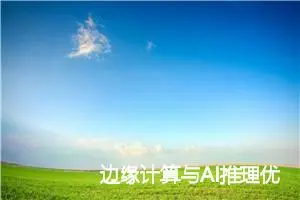

我们打开output文件夹,这里面的所有文件都是你刚刚保存的模型,后面的数字就是不同步数下保存的模型。然后save_steps的意思是模型多少步会保存一次的意思,这里我输入的是50也就是说,模型每50步的时候,...

TensorRT是NVIDIA开发的一款高性能深度学习推理引擎,旨在优化神经网络模型并加速其在NVIDIAGPU上的推理性能。它支持多种深度学习框架,并提供一系列优化技术,以实现更高的吞吐量和更低的延迟...

各位同学大家好,我是第三期的学员Proton,我本身。但是学业过程中用到大量计算机知识,因此正在艰难自学的过程中。看到很多非计算机专业的同学与朋友。对于有疑问,包括充满疑惑,因此分享一下我的一些理解。...

Gemma是Google推出的轻量级、先进的开放模型系列,采用与Gemini模型相同的研究成果和技术构建而成。它们是仅使用解码器的文本到文本大型语言模型(提供英语版本),为预训练变体和指令调整变体具有开...