前言近两年AIGC发展的非常迅速,从刚开始的只有ChatGPT到现在的很百家争鸣。从开始的大参数模型,再到后来的小参数模型,从一开始单一的文本模型到现在的多模态模型等等。随着一起进步的不仅仅是模型的多样化,还有模型的使用方式。大模型使用的门槛越来越低,甚至现...

在LLM中,token代表模型可以理解和生成的最小意义单位,是模型的基础单元。根据所使用的特定标记化方案,token可以表示单词、单词的一部分,甚至只表示字符。token被赋予数值或标识符,并按序列或向量排列...

SGLang是一种大语言模型和视觉语言模型的服务框架。它基于并改进了多个开源LLM服务引擎的优秀设计,包括LightLLM[4]、vLLM[5]和Guidance[6]。它利用了FlashInfer[7]的高性能注意...

LoLLMSWebUI安装与使用教程lollms-webuiLoLLMsWebUI-提供了一个用户友好的界面,用于访问和利用各种大型语言模型(LLM)和多模态智能系统。项目地址:https://gitc...

本文将演示如何在笔记本上运行千亿级模型,后端Koboldcpp运行在Ubuntu,前端界面使用安卓手机通过Termux且使用SillyTavern进行连接,模型使用104B的的Q4KM量化...

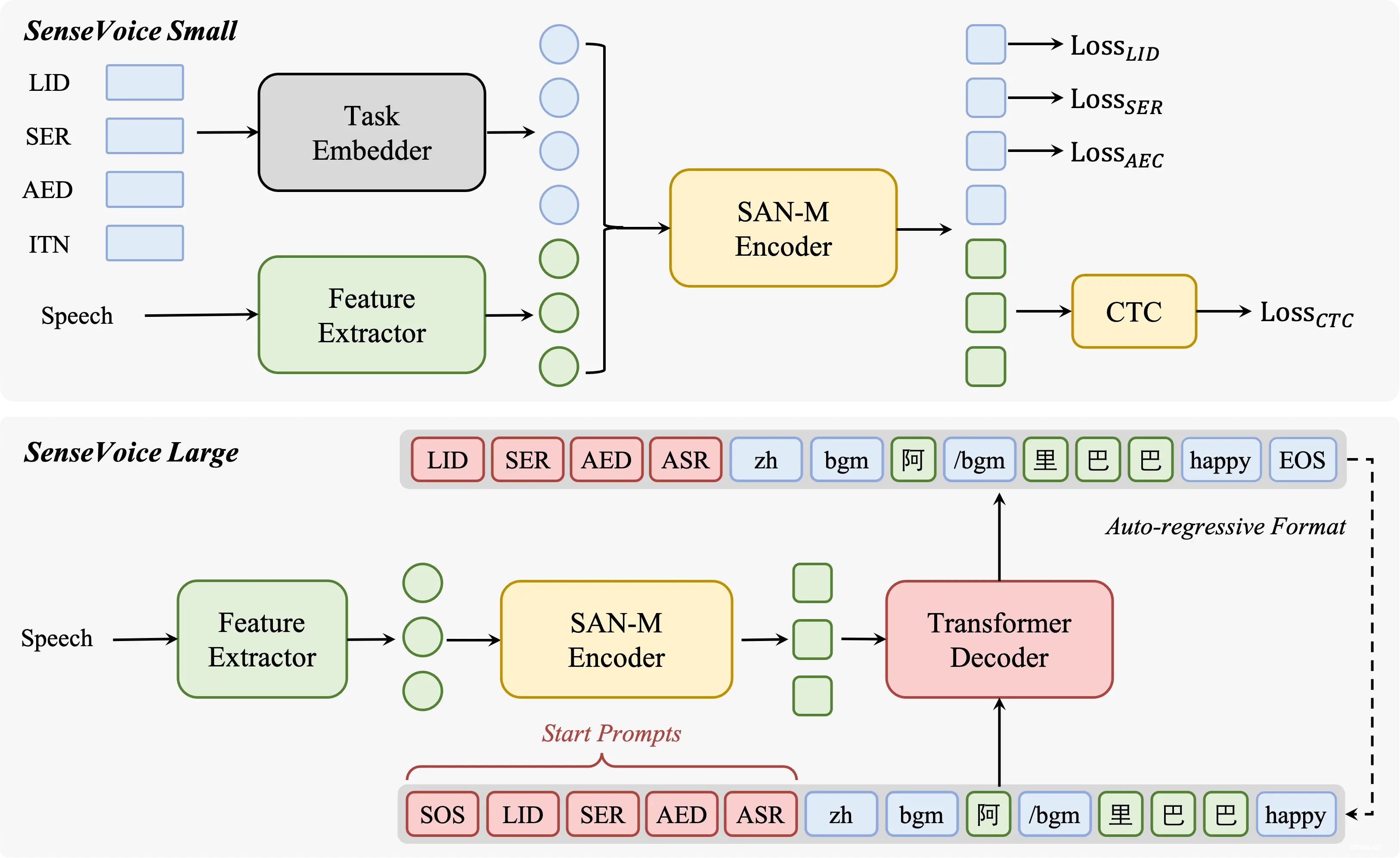

深入了解FunAudioLLM,阿里巴巴通义实验室开源的先进语音技术项目。SenseVoice和CosyVoice两大模型,以其高精度多语言语音识别、情感辨识和自然语音生成能力,引领语音交互的新时代。本文详细解析...

,它是一种非常强大的人工智能模型,特别擅长处理和生成自然语言文本;为什么叫它是LLM,因为它通过深度学习技术,经过海量文本数据训练而成;有着非常庞大的数据库,它优越的自然语言处理能力NLP,能够理解并生成像人类一...

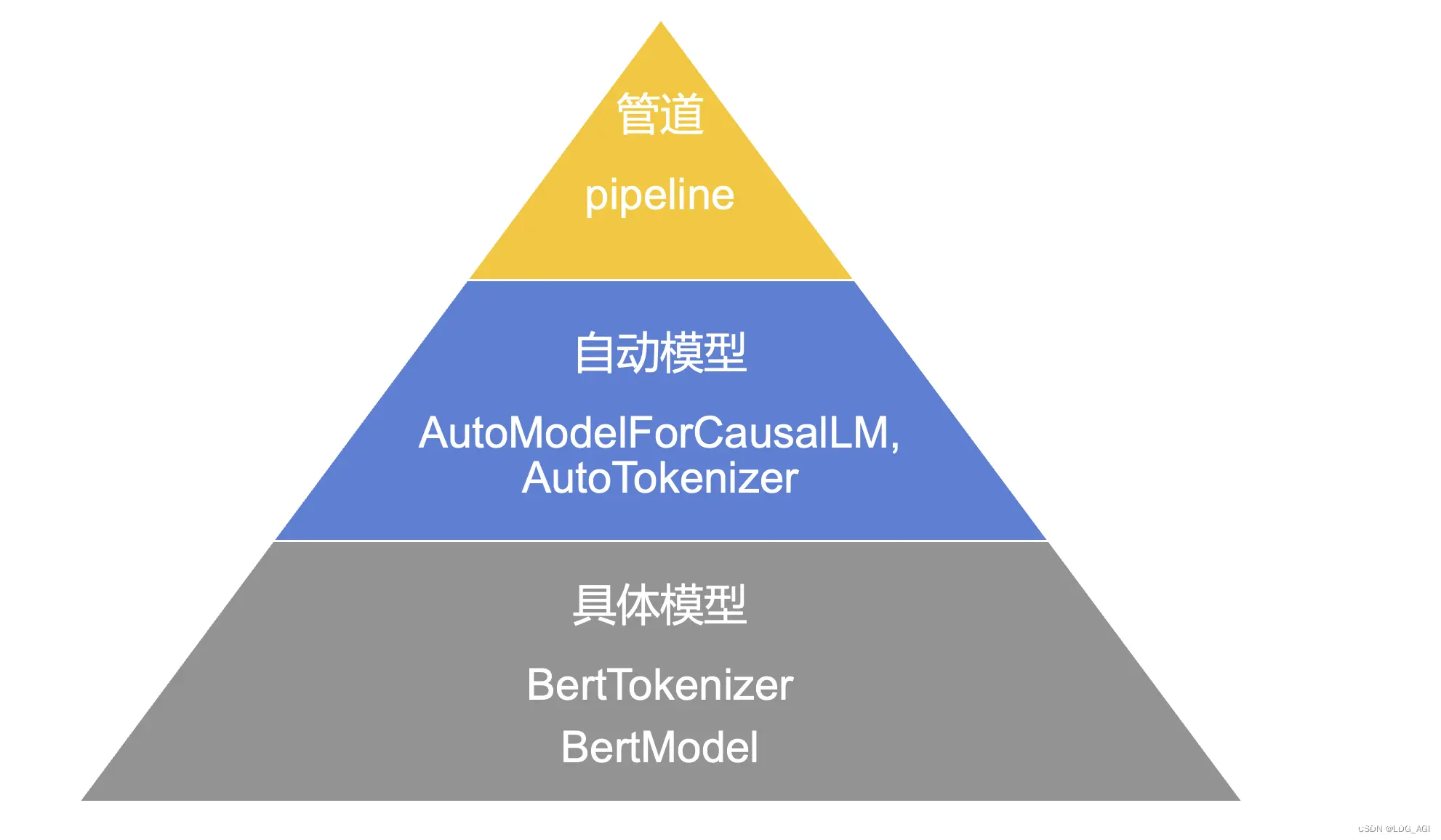

Transformers包括管道pipeline、自动模型auto以及具体模型三种模型实例化方法,如果同时有配套的分词工具(Tokenizer),需要使用同名调度。在上述三种应用方式中:管道方式使用最简单,但灵活...

训练性能在本文指机器(GPU、NPU或其他平台)在指定模型和输入数据的背景下,完成一次端到端训练所需要花费的时间,考虑到不同模型的训练数据量和训练轮次(epoch)差异,此处定义的性能是在完成一个batch训练所...

李宏毅生成式AI课程的LabHomework5实验的笔记_李宏毅2024-hw...