打开编辑,可以直接修改文件保存的路径,即本机目录。llama3:70b,一张A100(80G显存)可以运行起来,45G显存就可以运行,但能不能推理没尝试过。如果在演示中,出现限制次数问题,可以在应用中,点击应用...

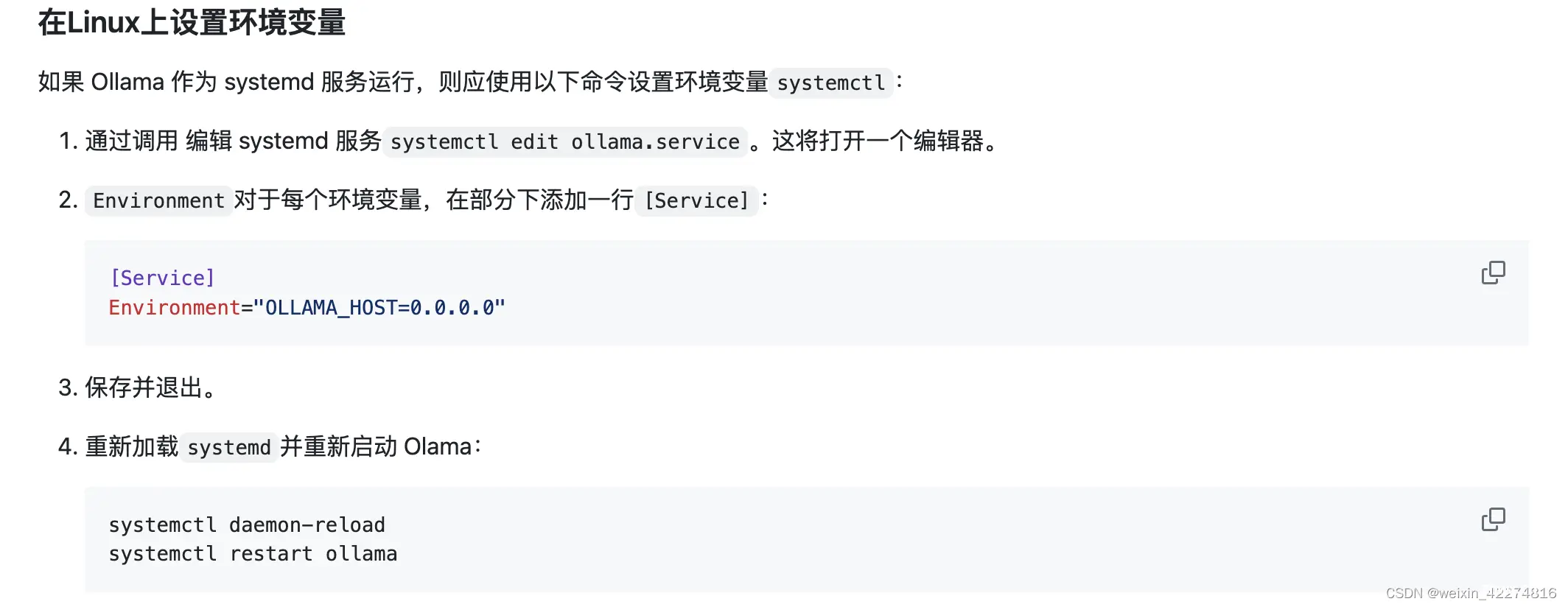

需要在linux中设置环境变量,将ollama作为systemd服务运行。#Linux中docker中的应用无法访问本地的ollama问题。运行命令最好以sudo权限运行。,其它系统参考官方文档。_exitingchainwith...

Docker下OpenWebUI,Ollama的安装实践_open-webuidocker...

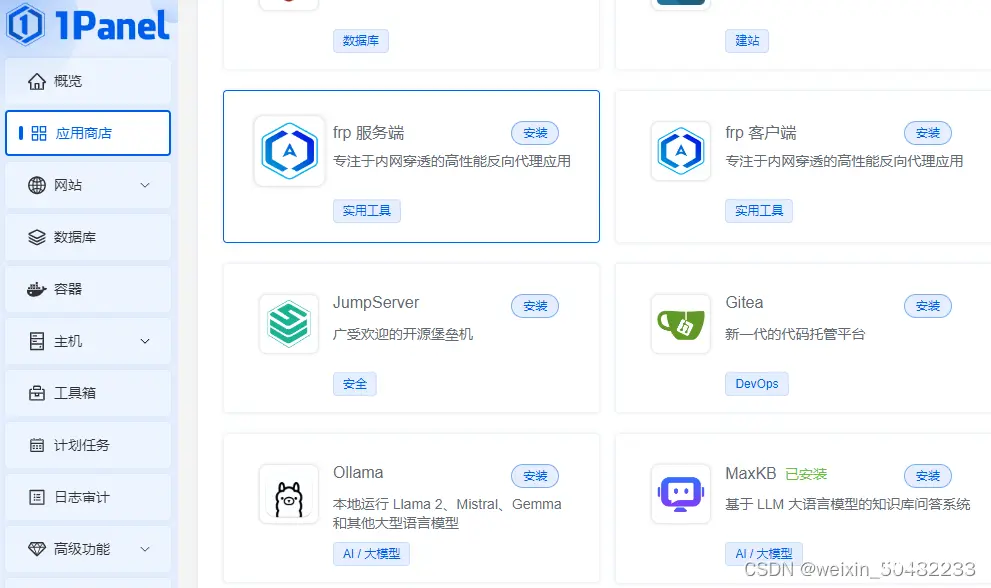

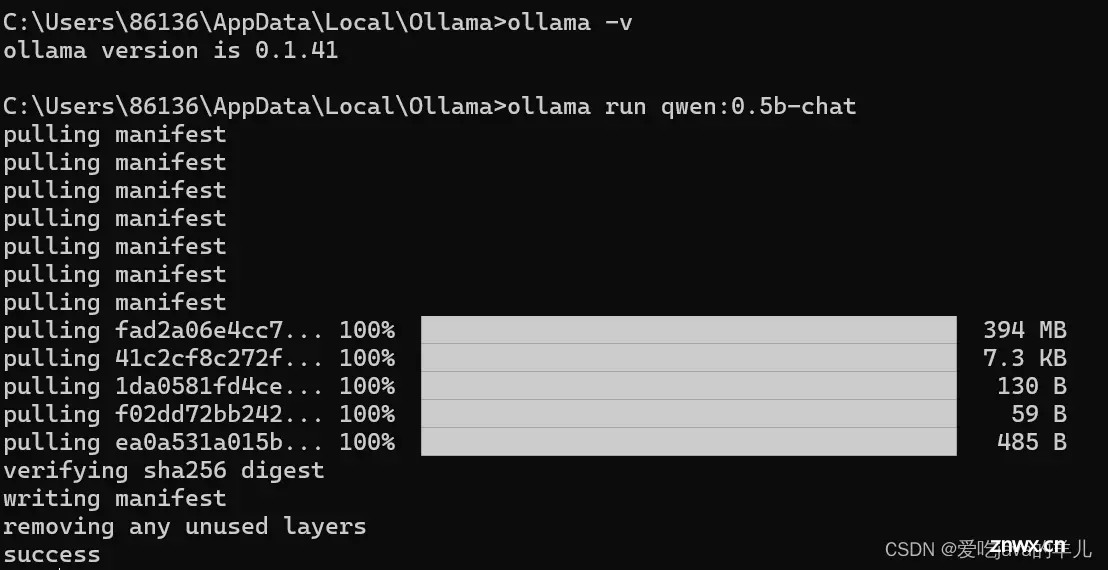

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。qwen-2(Qwen-2,量子阱增强神经网络版本2)是阿里巴巴集团开发的先进人工智能语言模型。基于Qwen-1的成功...

LobeChat:现代化设计的开源ChatGPT/LLMs聊天应用与开发框架,支持语音合成、多模态、可扩展的(functioncall)插件系统,一键免费拥有你自己的ChatGPT/Gemini/Cla...

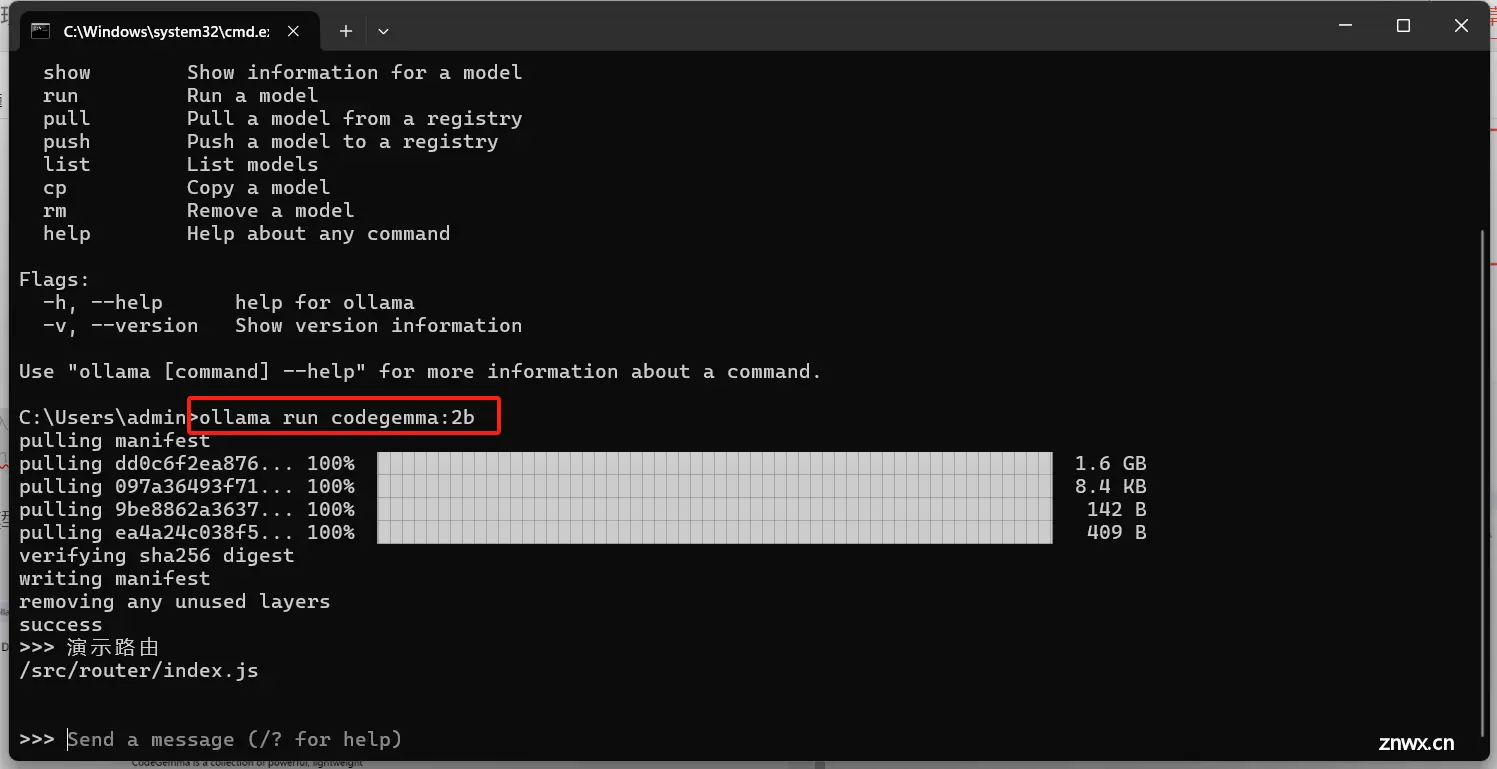

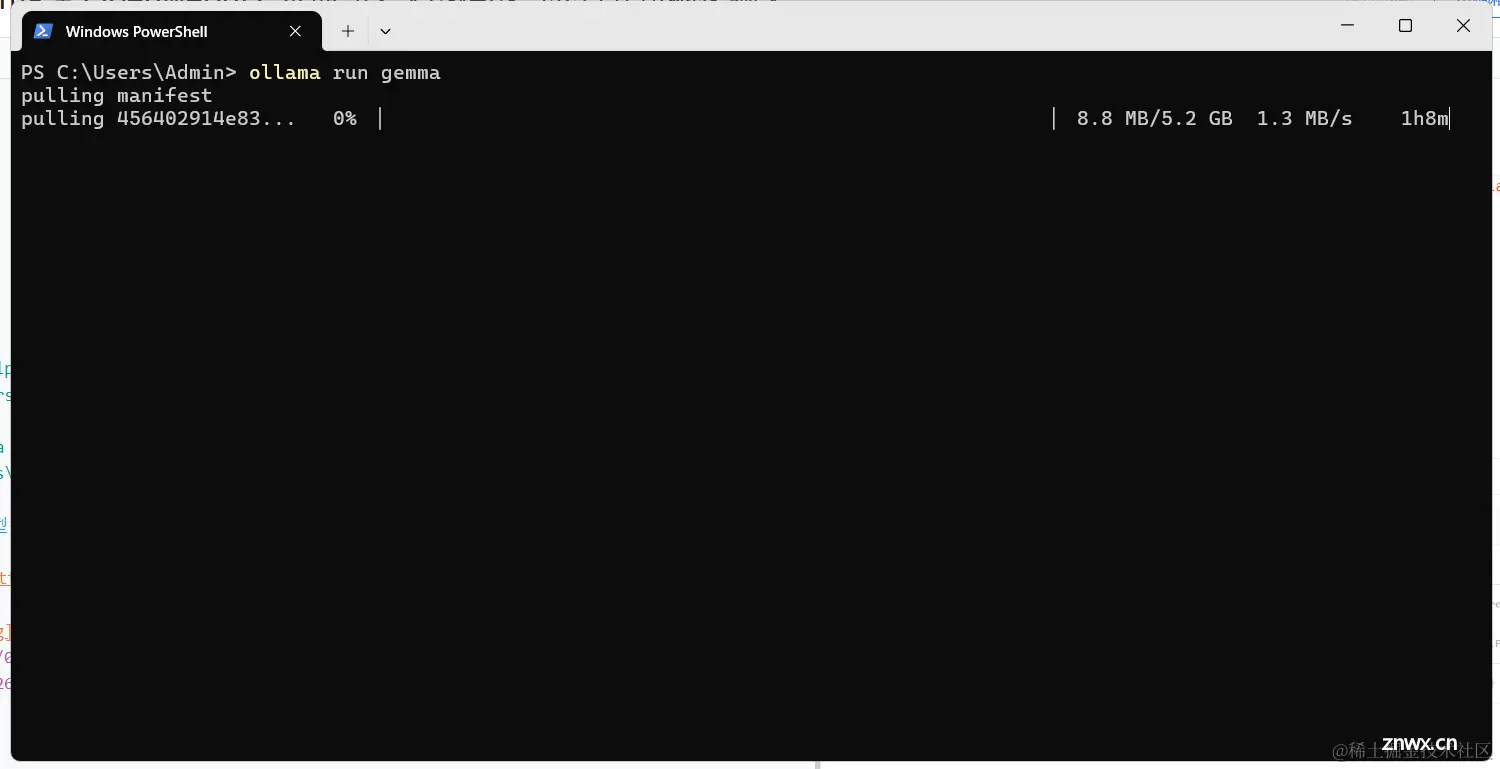

##AI模型:windows本地运行下载安装ollama运行llama3、llama2、GoogleCodeGemma、gemma等可离线运行数据模型【自留记录】CodeGemma没法直接运行,需要中间软件。下载...

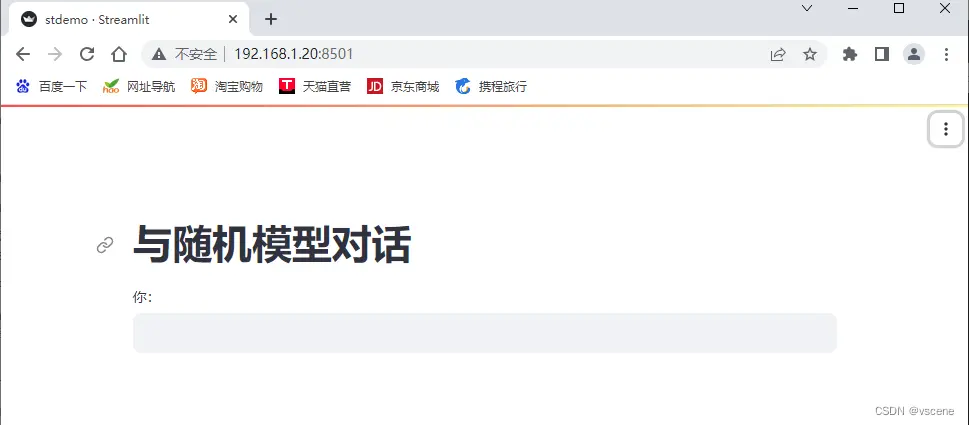

轻轻松松搞定私有大模型的Web页面,手撸的ChatBaby让AI不再神话_ollamapython调用...

官网:https://ollama.com/Ollama是一个用于部署和运行各种开源大模型的工具;它能够帮助用户快速在本地运行各种大模型,极大地简化了大模型在本地运行的过程。用户通过执行几条命令就能在本地运行开源...

VMware版本:VMwareWorkstationFullv12.1.0-3272444中文正式版镜像版本:CentOS-7-x86_64-DVD-2009。_centos7安装ollama...

Ollama是一个允许用户在本地启动并运行大型语言模型,它提供了一个简单易用的内容生成接口,类似于OpenAI,但无需开发经验即可直接与模型进行交互_openwebui...