大语言模型(英文:LargeLanguageModel,缩写LLM),是一种人工智能模型,旨在理解和生成人类语言。我们可以想象一下,LLM就像一个图书馆的守护者,它阅读了数不尽的书籍,从古老的传说到现代的科学论...

本文将为你提供一个全面的学习路线,帮助你从基础知识出发,逐步深入到大模型的实践应用,并培养代码思维,让你能够更好地理解和应用这一前沿技术。_人工智能大模型基础与实践...

AI大语言模型(LargeLanguageModels,LLMs)是近1-2年来人工智能领域的重要发展,它们通过深度学习技术,特别是基于Transformer的架构(如GPT、BERT等),实现了对自然语言处理的...

某司以军工及政务特种领域的大模型私有化落地为核心方向,打磨覆盖数据治理,微调数据生成,知识库构建,领域大模型训练、编排、应用全周期的大模型开发产品集,提供军事智能问答、军事情报分析、智能空战助手、指挥辅助决策及自动化...

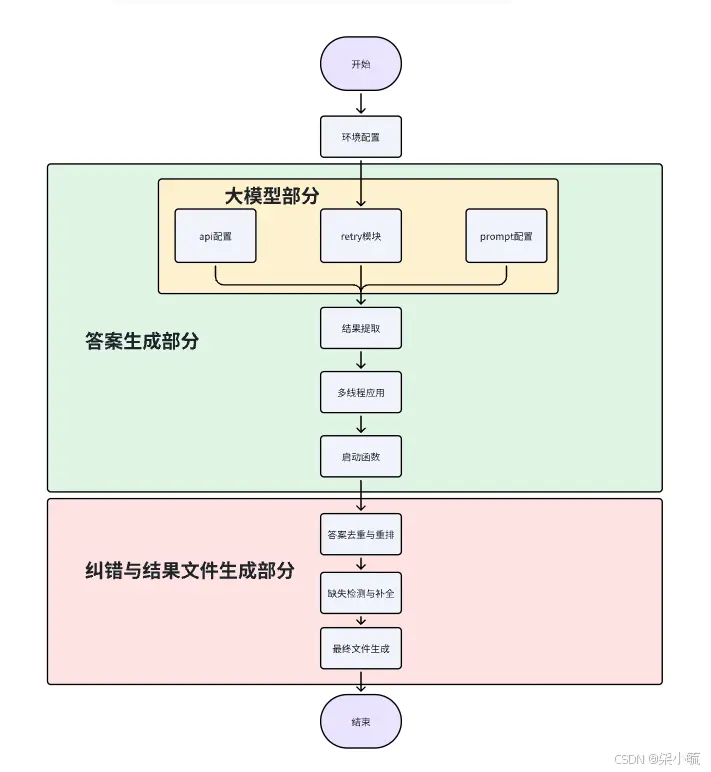

随着人工智能技术的迅猛发展,AI大模型(如GPT、BERT等)在各类任务中展现了强大的能力。然而,这些大模型的背后是海量数据和复杂的算法支撑。在这篇博客中,我们将深入探讨如何利用Python进行数据挖掘,并结合AI大...

CosyVoice是由阿里通义实验室开源的先进语音合成模型,它在多语言语音生成、零样本语音生成、跨语言声音合成和指令执行能力方面表现出色。CosyVoice模型支持one-shot音色克隆,仅需3~10秒的原始音...

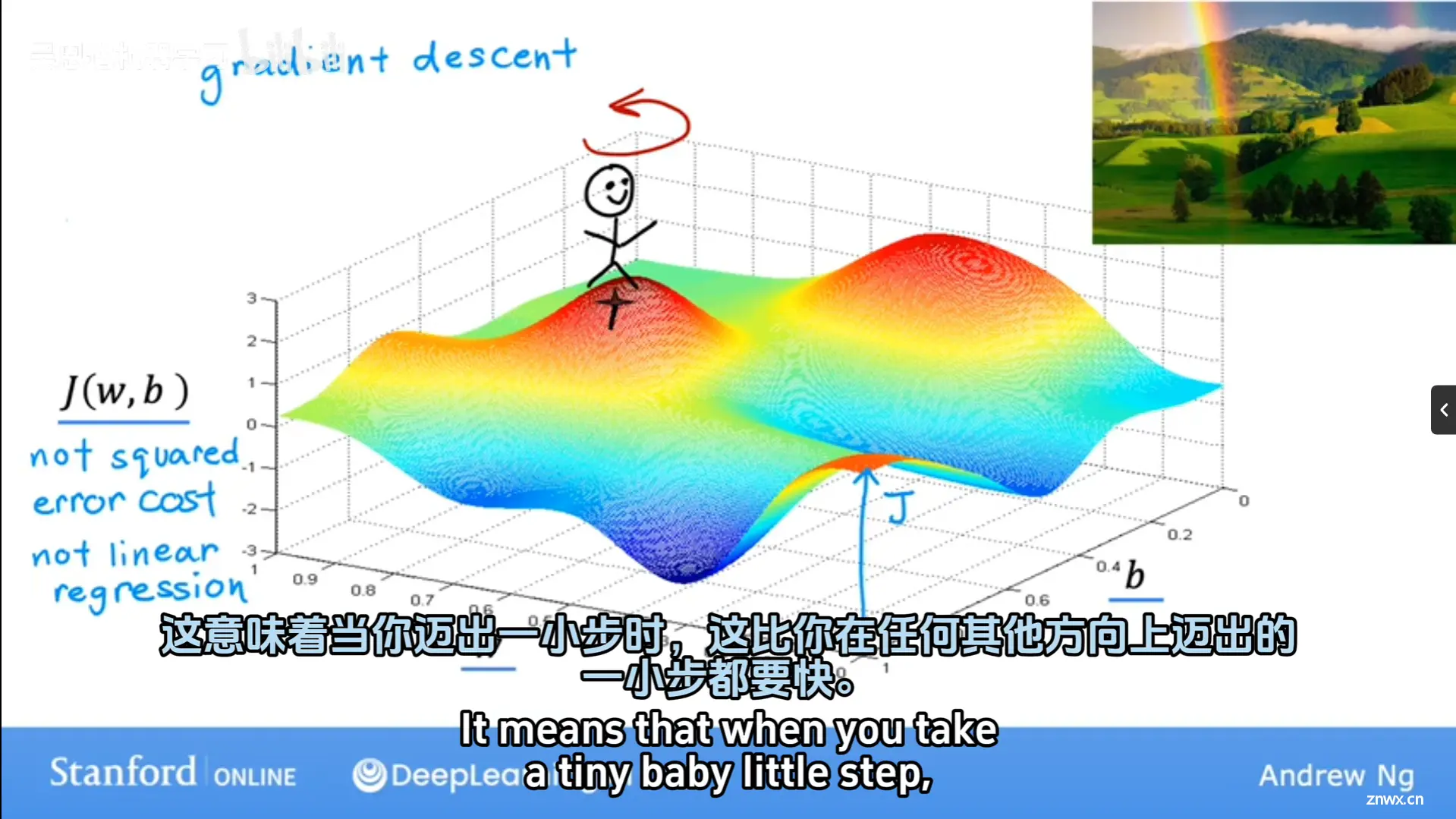

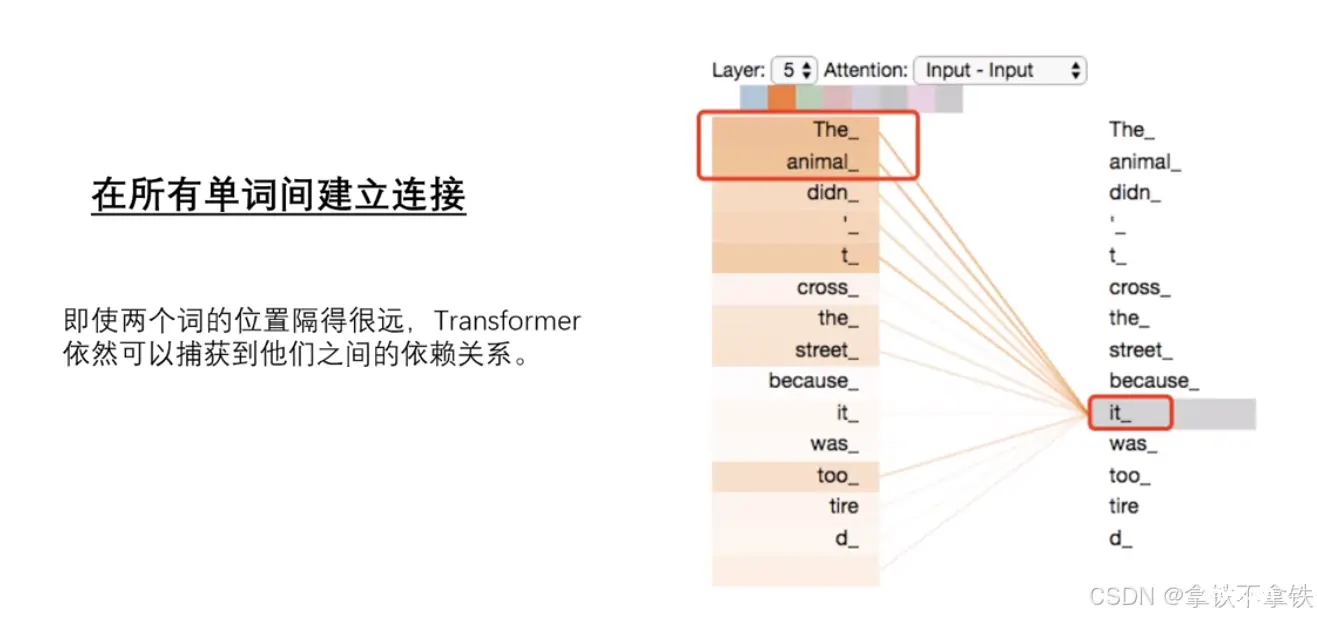

Transformer模型是一种在自然语言处理(NLP)及其他序列到序列(Seq2Seq)任务中广泛使用的深度学习模型框架。其基本原理和核心组件,尤其是自注意力机制(Self-AttentionMechanism)...

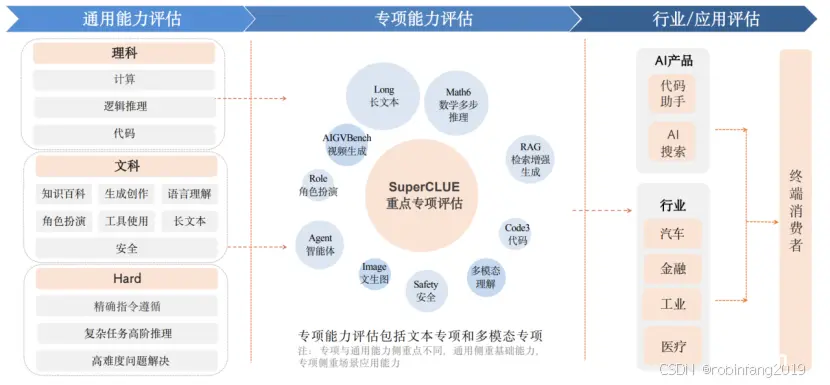

SuperCLUE是一个中文通用大模型的综合性评测基准,其前身是CLUE(TheChineseLanguageUnderstandingEvaluation),自2019年成立以来,CLUE基准一直致力于...

本文聚焦2024年以来学术界和产业界的SOTA多模态大模型(MultimodalLargeLanguageModels,MLLM),分享架构设计中的深刻见解与最佳实践。我们会发现,最新流行的MLLM架构...

Transformer自注意力机制是一种在自然语言处理(NLP)领域中广泛使用的机制,特别是在Transformer模型中,这种机制允许模型在处理序列数据时,能够捕捉到序列内部不同位置之间的相互关系。1、查询(Q...