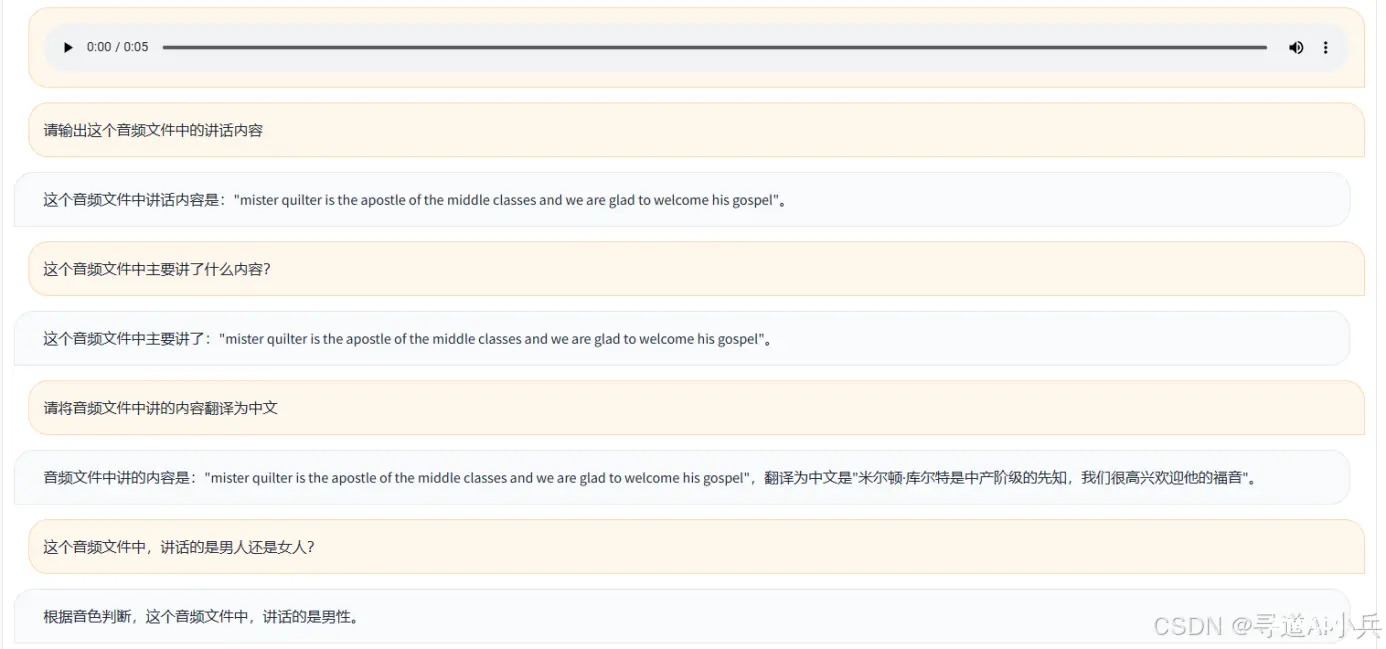

在自然语言处理的浩瀚星海中,Qwen-Audio-Chat模型以其卓越的性能和创新性,犹如一颗冉冉升起的新星,照亮了智能对话技术的前行之路。它不仅代表着对话系统的前沿发展,更是为实现自然、流畅且富有洞察力的交...

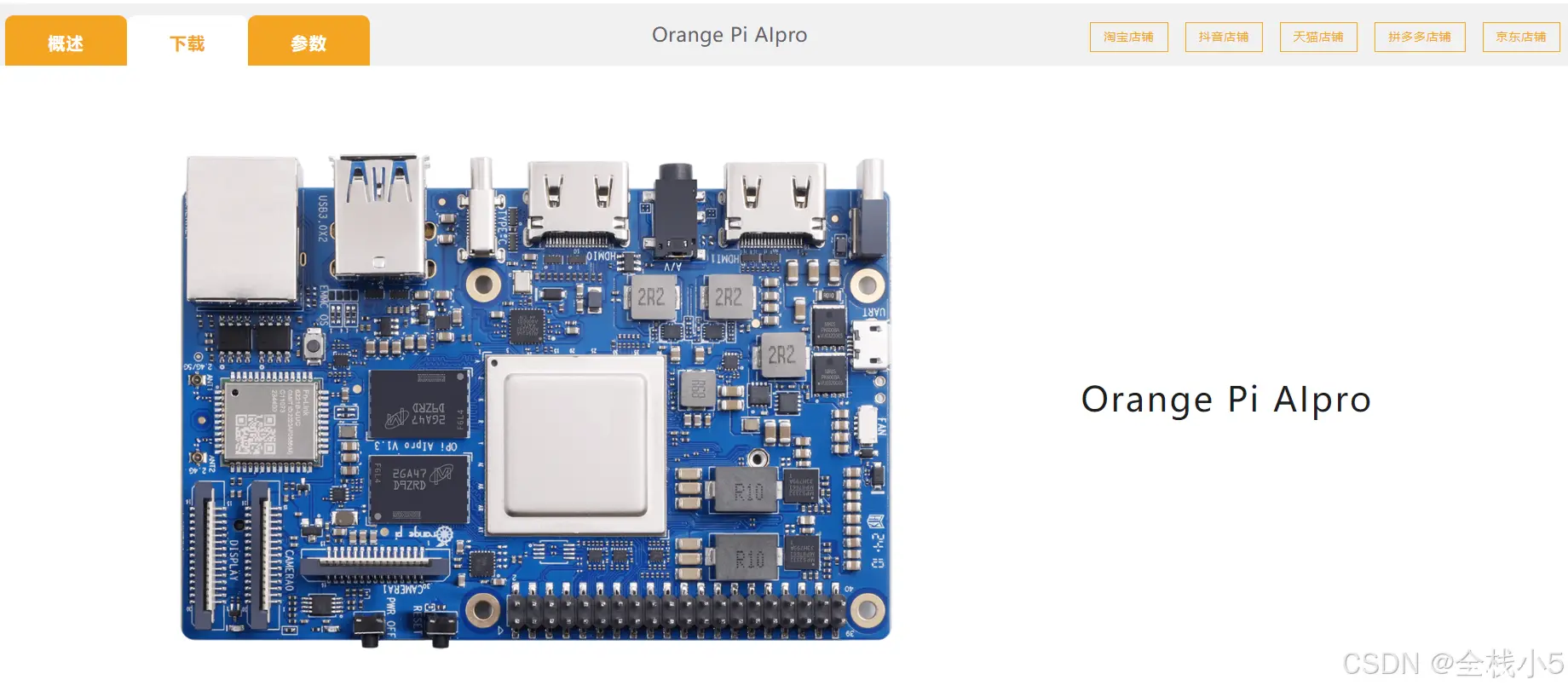

作为业界首款基于昇腾深度研发的AI开发板,OrangePiAIpro无论在外观上、性能上还是技术服务支持上都非常优秀。接口丰富,扩展能力强。支持Ubuntu、openEuler操作系统,满足大多数AI算法...

目录收起代码开源/模型使用方法:76B大模型,司南评测优于GPT-4O8B端侧小模型,消费级单卡可部署试用Demo:正文开始!_internvl2-llama3-76b...

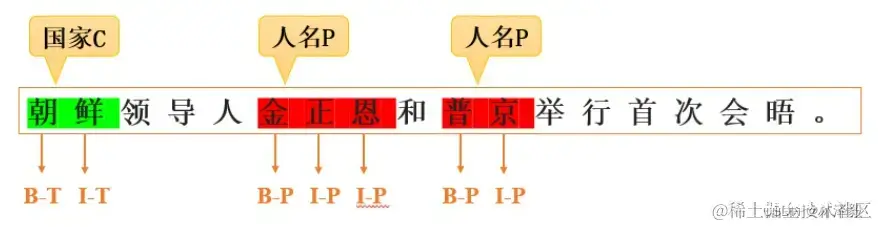

LLM大模型从入门到精通_llm模型...

递归特征消除(RFE)、顺序前向选择(SFFS)、和顺序后向选择(SBFS)都表明,‘weight’、‘modelyear’和‘horsepower’是最重要的特征。仅使用这三个特征,我们就能获得可靠的R²分数...

本文介绍了如何在CANoe中使用Matlab/Simulink模型进行汽车软件的快速原型开发和仿真节点构建。详细阐述了连接、配置、调用方法,并分析了其在不同场景的应用优势。\r...

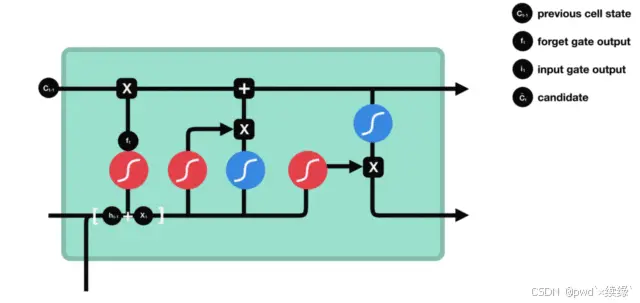

🏷️在介绍LSTM模型之前,我们再次见一下CNN是什么?many-to-one:MNIST(glimpse输入)字符分类many-to-many:机器翻译🏷️接下来我们先简单介绍传统的RNN模型,了解其优缺...

大模型指令微调(InstructionTuning)是一种针对大型预训练语言模型的微调技术,其核心目的是增强模型理解和执行特定指令的能力,使模型能够根据用户提供的自然语言指令准确、恰当地生成相应的输出或执行相关任务...

一、关键字检索和向量检索1、关键字检索2、向量检索二、向量检索分析1、向量简介2、二维空间向量计算示例3、文本向量(重点★★)4、文本向量示例(重点★)...

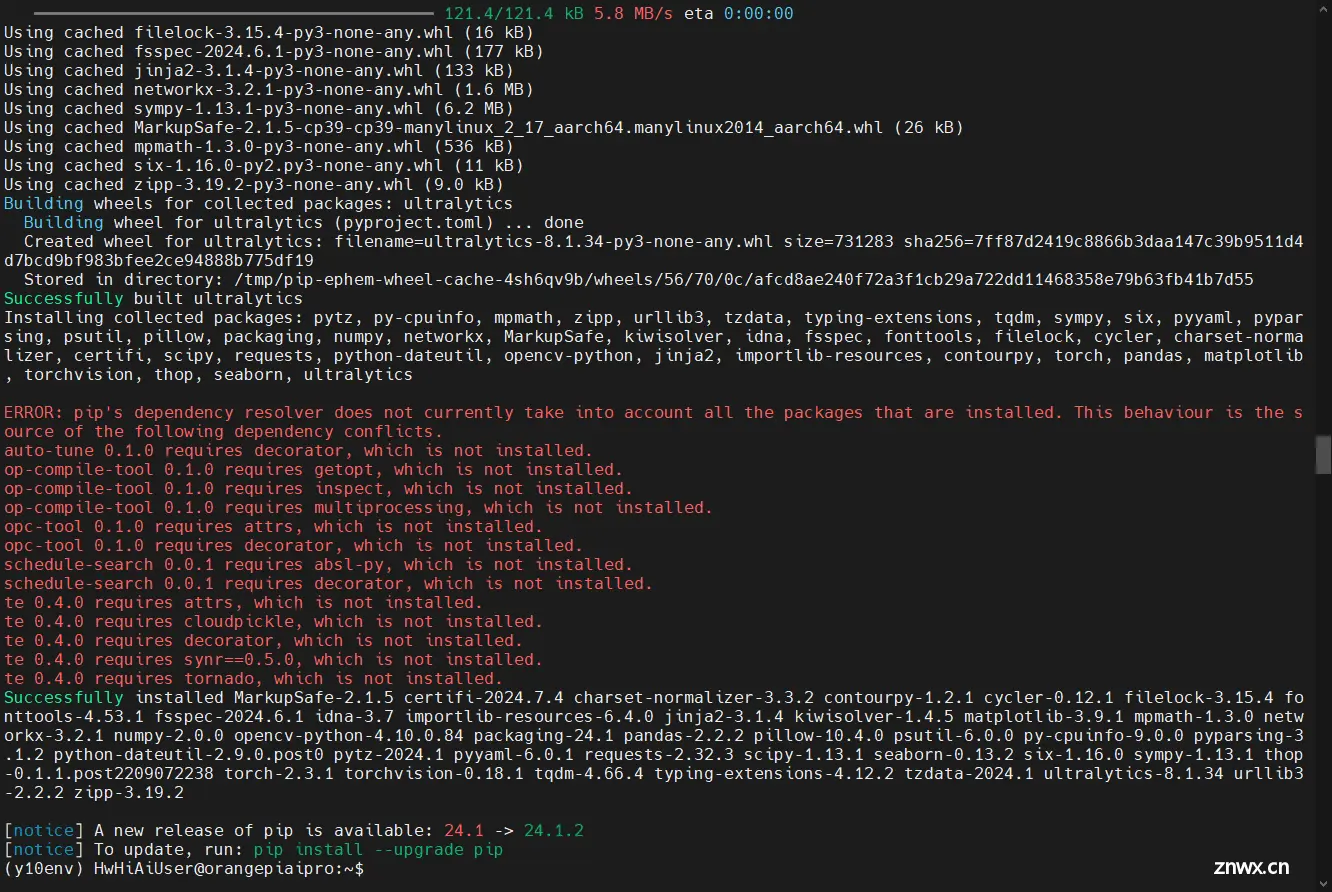

随着AI技术在计算机视觉领域应用的流行,YOLO系列模型已成为实时目标检测的主流范式。2024年5月23日,清华大学发布了YOLOv10实时端到端目标检测模型,该模型创下了目标检测各个数据集上的模型准确度和推理延迟...