空洞卷积是一种用于扩大感受野而不增加计算量的卷积操作。通过在卷积核的权重之间引入空洞(即间隔),空洞卷积能够捕捉更大范围的信息,同时保持计算效率。空洞卷积的公式为:其中,(r)是空洞率,控制了感受野的大小。...

在处理复杂数据时,可以通过引入,让模型根据输入数据的特点动态调整关注点,聚焦最关键的信息,来提高模型的处理能力和效率。这种比传统方法更高效、灵活的技术足以应对各种复杂任务和挑战,具有强大的适应性,因此它的应用范围非...

本文介绍了如何将TripletAttention注意力机制集成到YOLOv8中,并详细讲解了集成的原理、实现步骤、代码示例以及模型部署与应用的细节。通过引入TripletAttention机制,我们能够显著提升YOLOv8在目标检测任务...

Attention(注意力)机制如果浅层的理解,跟他的名字非常匹配。他的核心逻辑就是「从关注全部到关注重点注意力机制其实是源自于人对于外部信息的处理能力。由于人每一时刻接受的信息都是无比的庞大且复杂,远远超过人脑的...

在目标检测领域,YOLO系列模型一直以其快速、高效的特性广受欢迎。YOLOv8作为这一系列的最新版本,具备较高的检测速度和较强的识别能力。然而,随着对复杂场景和小目标检测需求的增加,进一步优化模型的特征提取和识别效率...

YOLOv10专栏持续复现网络上各种顶会内容,同时专栏内容可以用于YOLOv8改进~,欢迎大家订阅!!!_yolov10bifpn...

通过这种方式,SELA可以更好地捕捉到图像中细粒度的局部信息,增强了对局部特征的敏感度。到此本文的正式分享内容就结束了,在这里给大家推荐我的YOLOv10改进有效涨点专栏,后期我会根据各种最新的前沿顶会进行论文复现,也会对一些老的改进机...

神经网络训练不起来怎么办(5):批次标准化(BatchNormalization)简介_哔哩哔哩_bilibiliTask3:《深度学习详解》-3.7批量归一化-**产生不好训练的误差表面的原因**:输入特征不同维度的值范围差距大可能导致误差表面不...

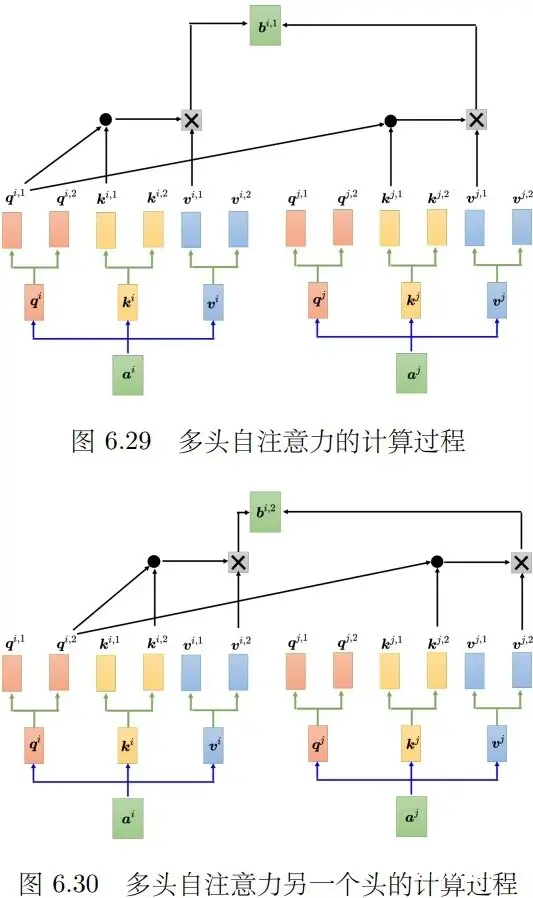

编码器部分:由N个编码器层堆叠而成,每个编码器层由两个子层连接结构组成,第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接,第二个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接�...

摘自知乎博主作者:月来客栈首先让我们先一起来看看作者当时为什么要提出Transformer这个模型?需要解决什么样的问题?现在的模型有什么样的缺陷?现在主流的序列模型都是基于复杂的循环神经网络或者是构造而来的Enc...