定义的chinese_multiple_choice_questions该函数的主要逻辑是通过正则表达式匹配和提取文本中的问题和选项。对于选择题,它提取了问题的编号、文本和选项,并将它们存储在一个字典中。对于简答题...

将OpenVINO™ModelOptimizer、ChatGLM-6B以及P-Tuning微调技术相结合,可以构建出一个高效、灵活且性能优异的AI新闻小助手。该助手能够利用优化后的ChatGLM-6B模型快速...

等等。理解代码基本无问题,主要是要熟悉如何编写。_星火13b训练学习率...

本文尝试梳理。包括模型结构选择、数据预处理、模型预训练、指令微调、对齐、融合多模态以及链接外部系统等环节。目前主要有三种模型架构,基于Transformer解码器,基于GeneralLanguageModel,...

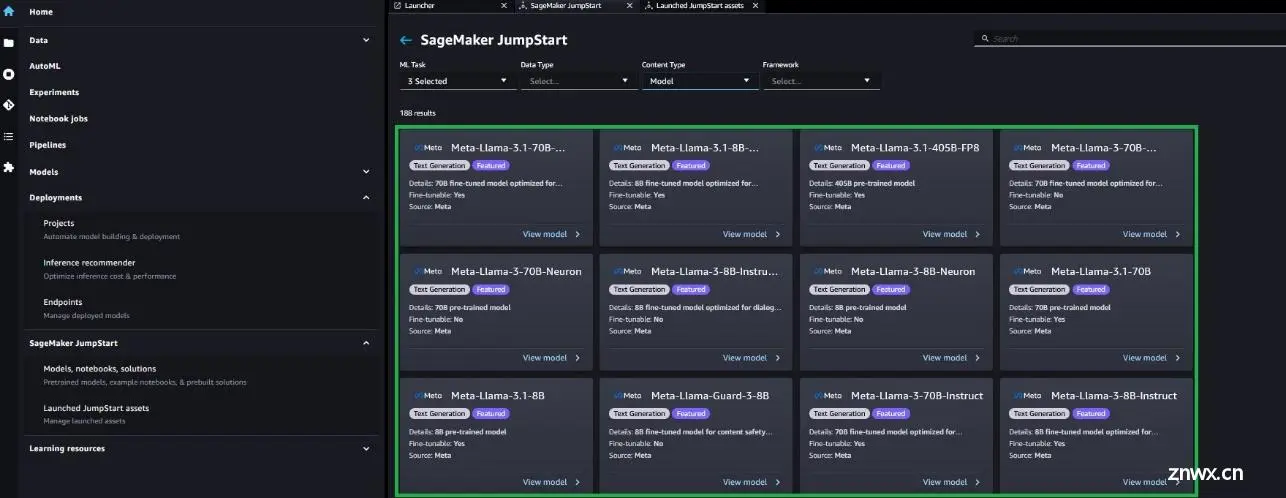

还可以在SageMakerJumpStart上找到微调其他变体MetaLlama3.1模型(8B和70B基础和指令)的代码([GitHub仓库](https://github.com/aws/amazon-...

在Diffusion图像生成框架中,使用LoRA(Low-RankAdaptation)微调,难点在于,需要精确控制模型参数的更新以避免破坏预训练模型的知识,同时保持生成图像的多样性和质量,这涉及到复杂的...

经典神经网络(15)GLM模型原理详解及其微调(文本摘要)_glm模型...

llama-3-1meta于2024-07-23发布文档gitCloudflare提供了免费访问的入口如下,Llama3.1模型在中文支持方面仍有较大提升空间在HuggingFace上已经可以找到经过微调、...

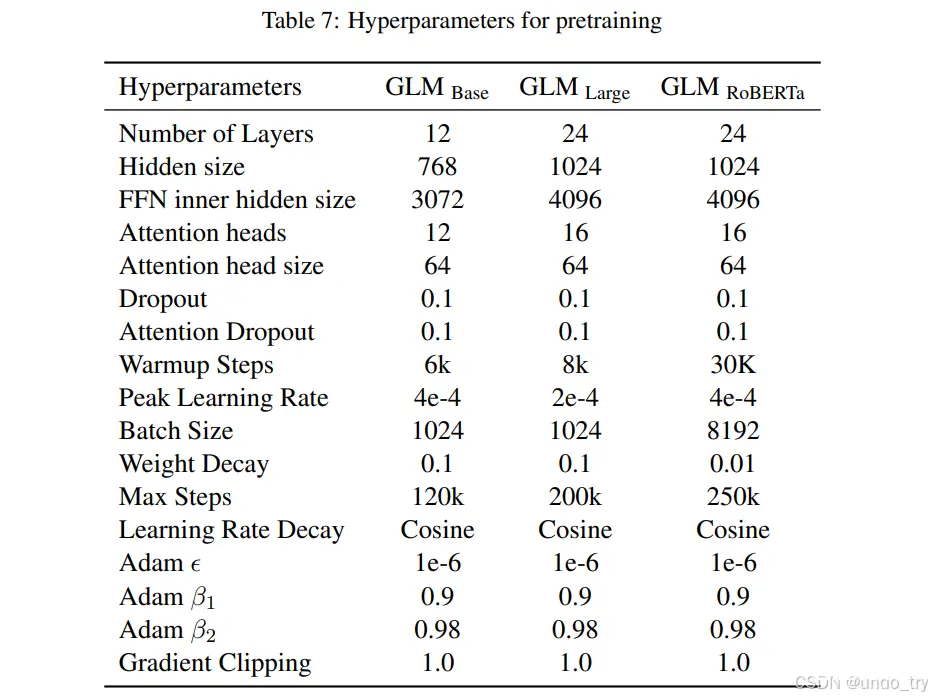

设定beta2为0.98比默认的0.999稍低,可能会使得优化过程对历史信息的依赖程度降低,从而提高优化过程的灵活性,但也可能增加训练过程中的噪声。在使用Adam或其他类似的优化算法(如RMSpro...

微调框架:swift微调模型:internvl-chat-v1_5微调任务:多模态大模型在指定任务上的OCR能力微调优化微调显存:55G,多batch时对单卡要求较高(4090不能满足需求)_internvl大...