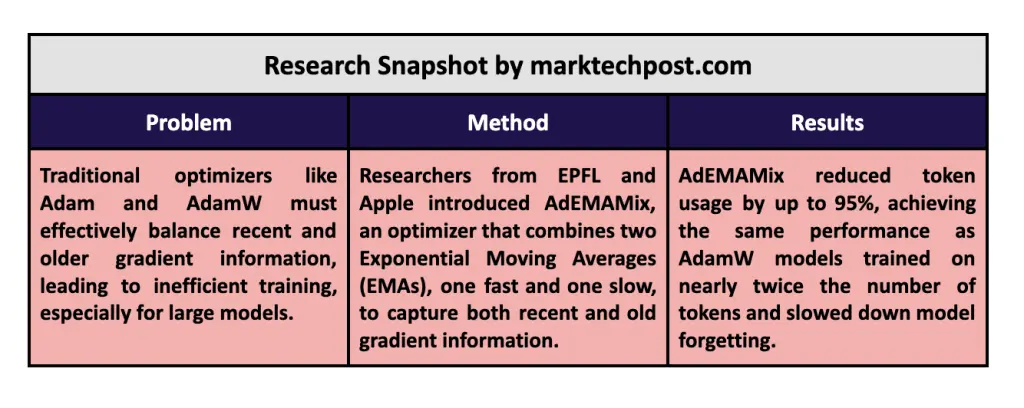

具体来说,AdEMAMix维护了一个快速变化的EMA,优先考虑最近的梯度,同时跟踪一个较慢变化的EMA,保留训练过程早期的信息。例如,在对RedPajama数据集上的一个13亿参数的语言模型进行训练时,研究...

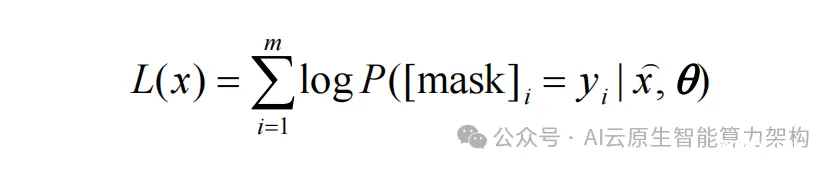

目前大部分的模型架构都是decode-only(casualLM),少量的有encode-decode,encode-only,为啥大部分LLM是decode-only的,原因可能是以下几点:从mask的角度看...

LangChain的核心优势在于其能够轻松构建自定义链,这些链通常是线性的,类似于有向无环图(DAG),每个步骤都严格按顺序执行,每个任务只有一个输出和一个后续任务,形成一个没有循环的线性流程。_langchain...

多模态预训练大模型架构与GPT和BERT类似,也是基于自注意力机制Transformer深度学习模型,其最大特点是模型的输入由单一模态的文本拓展到文本、语音、图像、视频等多个模态数据同时作为输入。多模态...

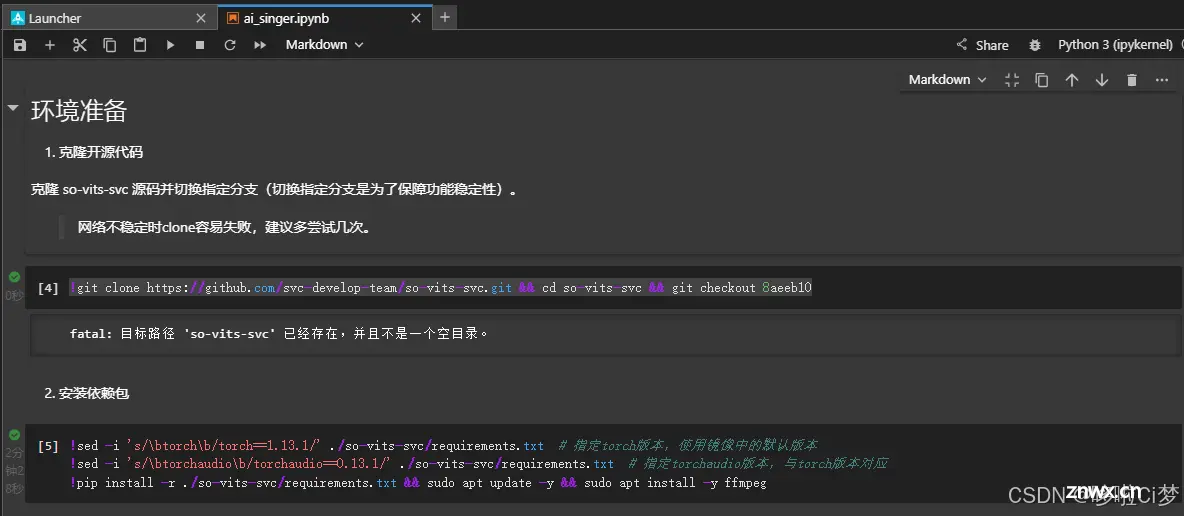

好久没更新了,但是按耐不住对人工智能大模型的好奇,这个项目很简单很微小,但也是一次尝试。留下一点笔记,做个纪念。最后吐槽一下,Ai唱的好像还没有我自己唱的好。_训练自己的语音模型...

本期讲解了关于阻塞队列的特性,实现过程中存在的问题,以及解决和代码的实现,并且还利用了阻塞队列实现了生产者消费者模型;并且还理解了生产者消费者模型在实际开发中作用...

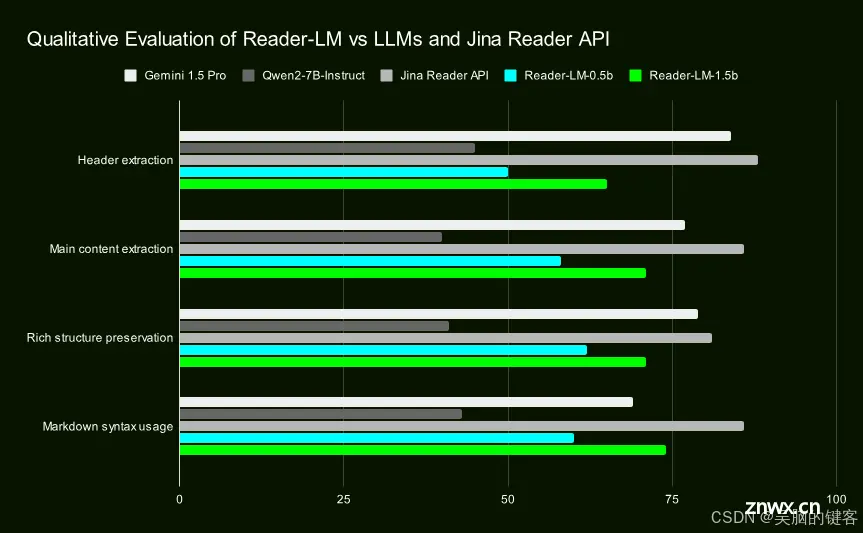

JinaAI发布了两个小型语言模型:Reader-LM-0.5B和Reader-LM-1.5B。这两个模型经过专门训练,可以将原始HTML转换为标记符,而且都是多语言模型,支持多达256K字节的上...

2024年9月4日,亚马逊云科技在AmazonBedrock上新了StabilityAI最新的的三款文本图像生成模型:他们分别是和。全新的模型在处理多主题提示词、图像质量和图片排版上较上一代模型有显著提升,能...

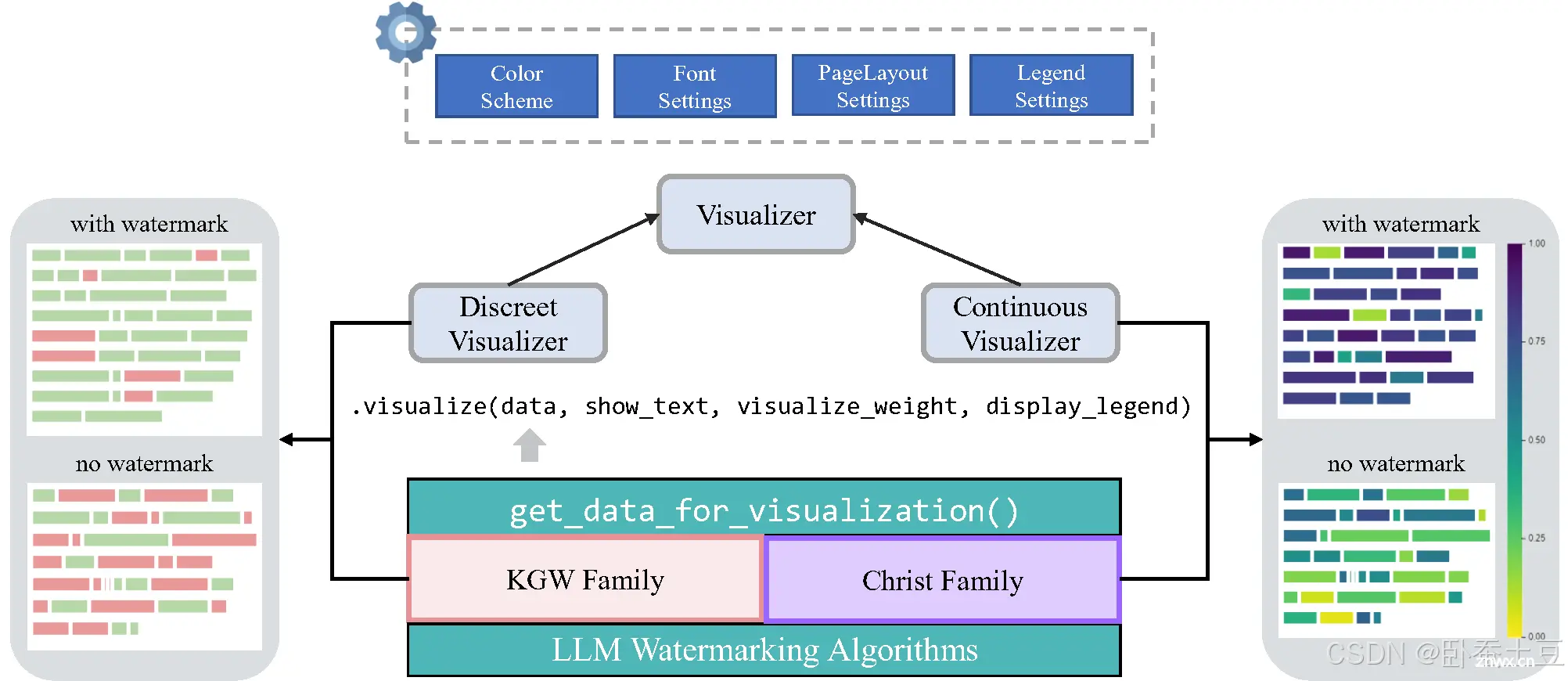

随着生成式大模型(如GPT-4)的广泛应用,如何识别和追踪这些模型生成的内容成为了一个重要课题。大模型内容水印(LargeModelContentWatermarking)应运而生,旨在为生成内容嵌入标记,以实...

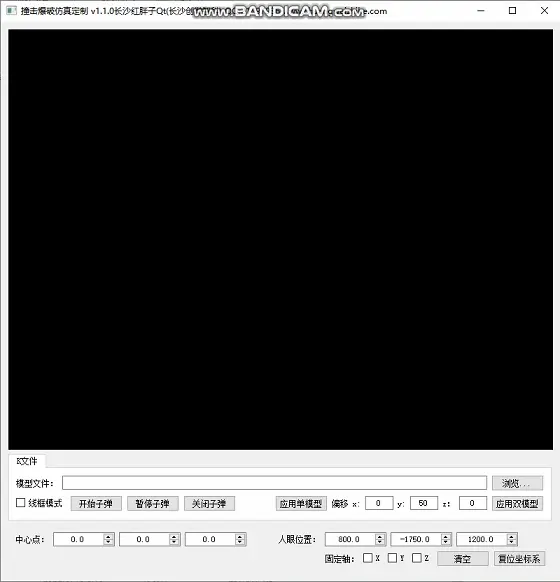

1.使用osg三维引擎进行动力学模型仿真性能测试;2.打开动力学仿真模型文件,.k后缀的模型文件,测试加载解析过程;3.解决第三方company的opengl制作的三维引擎,绘制面较多与弹丸路径模拟较卡顿的问题...