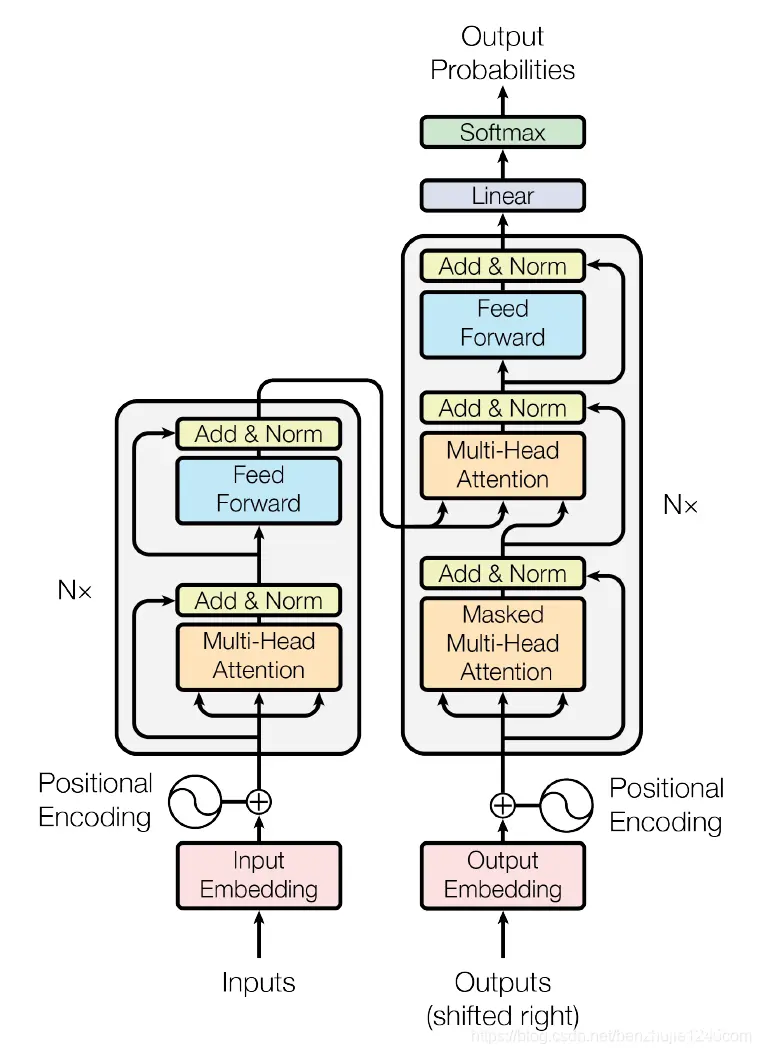

写在前面在本文中,我们利用Nixtla的NeuralForecast框架,实现多种基于Transformer的时序预测模型,包括:Transformer,Informer,Autoformer,FEDfor...

今天给大家分享一篇关于深度学习模型Transformer的文章。我愿称之为讲解Transformer模型最好的文章。_transformer架构...

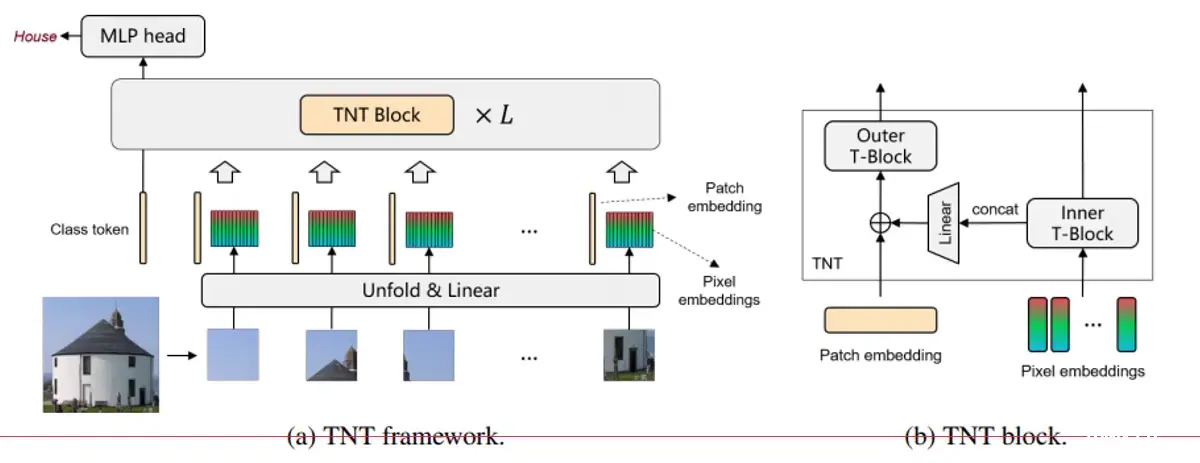

Transformer在计算机视觉中的应用-VIT算法_tnt模型库...

cannotimportname\'CommitOperationAdd\'from\'huggingface_hub\'(unknownlocation)_importerror:cannotimportname...

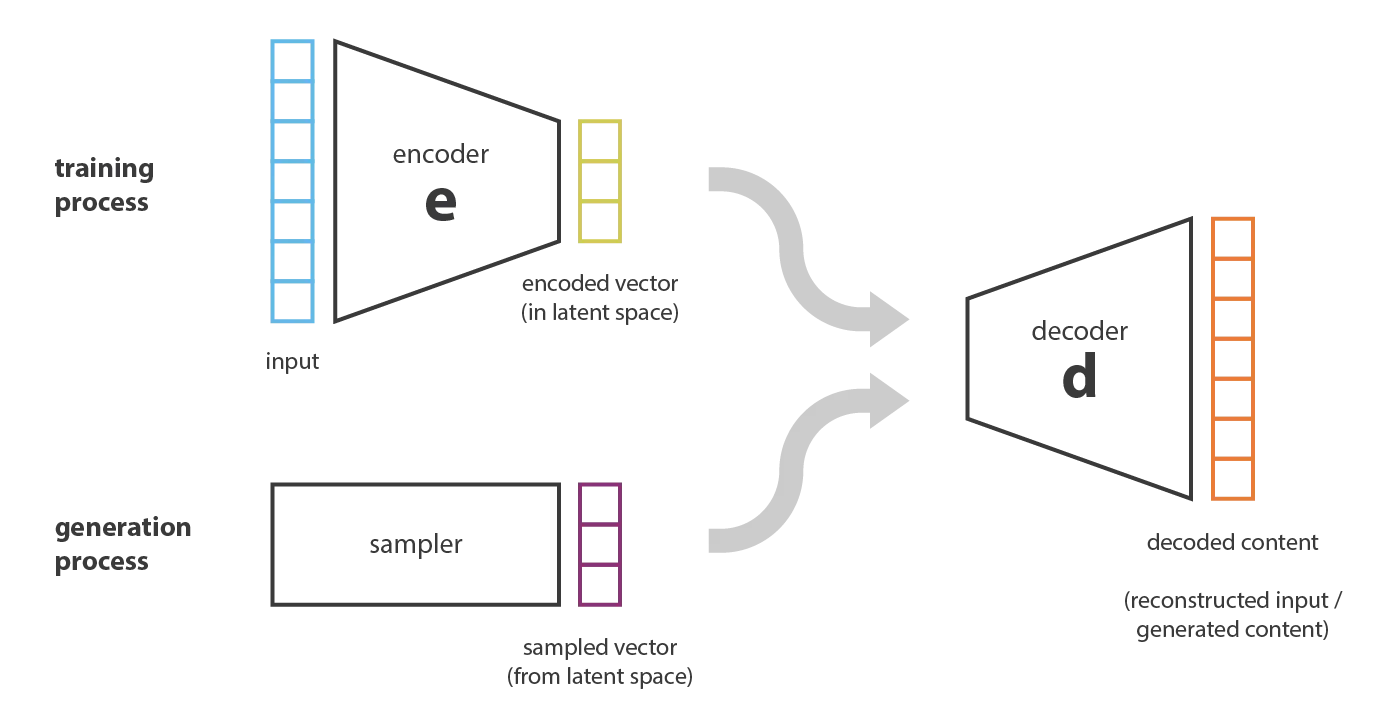

本文深入探讨生成式AI的核心技术,包括GANs、VAEs、自回归模型和Transformers,详细描述其原理、实现方法及实际应用,结合代码示例和现实案例,展示最新技术进展和应用场景。_gantransform...

基于LoRA进行模型微调时,需要先冻结全部参数,再指定相应的Linear层进行微调,那么如何计算全部参数,如何计算微调参数以及如何计算微调参数占全部参数的比例呢?本文先对Qwen2模型结构进行一览,做到心中有数,之...

![[AI]如何让语言模型LLMs流式输出:HuggingFace Transformers实现](/uploads/2024/06/12/1718161271748053676.webp)

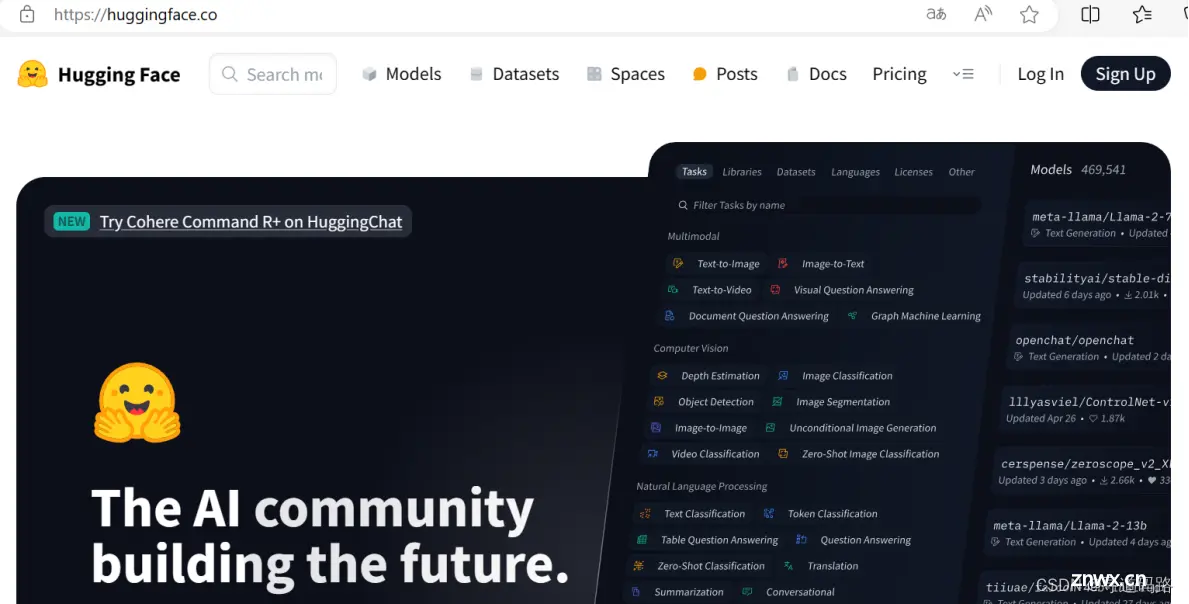

HugginFaceTransforms是一个非常方便的库,集成了非常多SOTA的模型,包含:LLAMA,GPT,ChatGLMMoss,等。目前基本上主流的方案都是基于HugginFaceTransf...

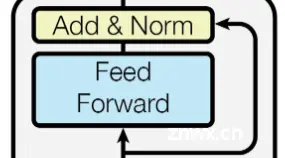

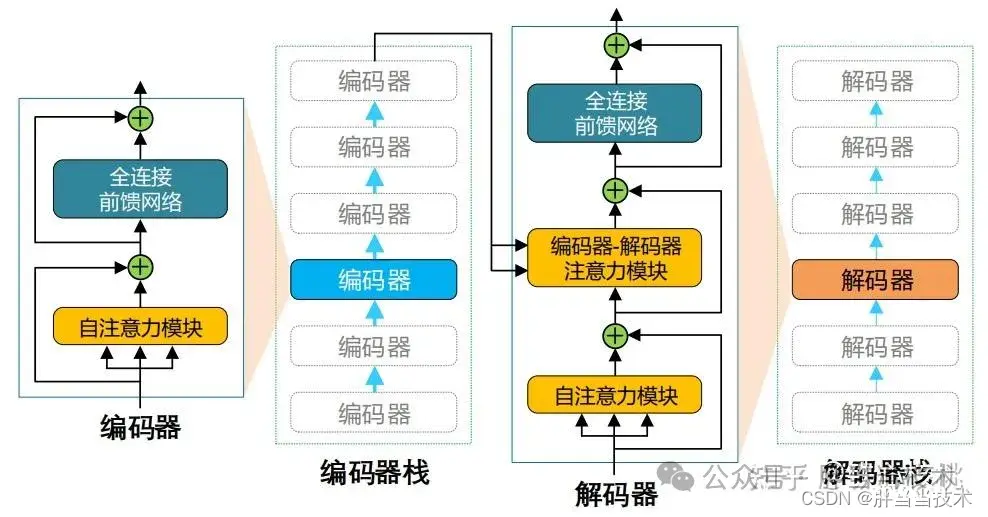

【代码】深入理解Transformer,兼谈MHSA(多头自注意力)、Cross-Attention(交叉注意力)、LayerNorm、FFN、位置编码。_mhsa...

在的官方网站上,您可以发现一个丰富的开源宝库,其中包含了众多机器学习爱好者上传的精选模型,供大家学习和应用。此外,您也可以将自己的模型分享至社区,与他人共同进步。HuggingFace因其开放和协作的精神被誉...

上篇文章以对话模式为例讲了目前人工智能的整体架构,但是大模型依然有很多细节问题,这里作者讲一讲目前的Transformers模型原理。_人工智能transformer...