(警告:不要将您不理解或没有自己审核过的代码粘贴到DevToolsConsole中。这可能会让攻击者窃取您的身份或控制您的计算机。请在下面键入“允许粘贴”以允许粘贴。当需要将拷贝的内容粘贴到浏览器的控制台console中时,产生警告信...

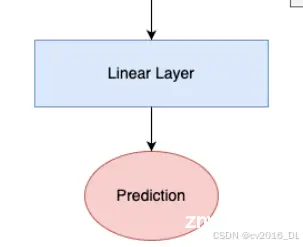

在机器学习特别是生成对抗网络(GANs)中,衡量和优化生成数据与真实数据之间的差异是至关重要的。WassersteinLoss,也称为Earth-Mover’sDistance,提供了一种有效的方法来度量两个概...

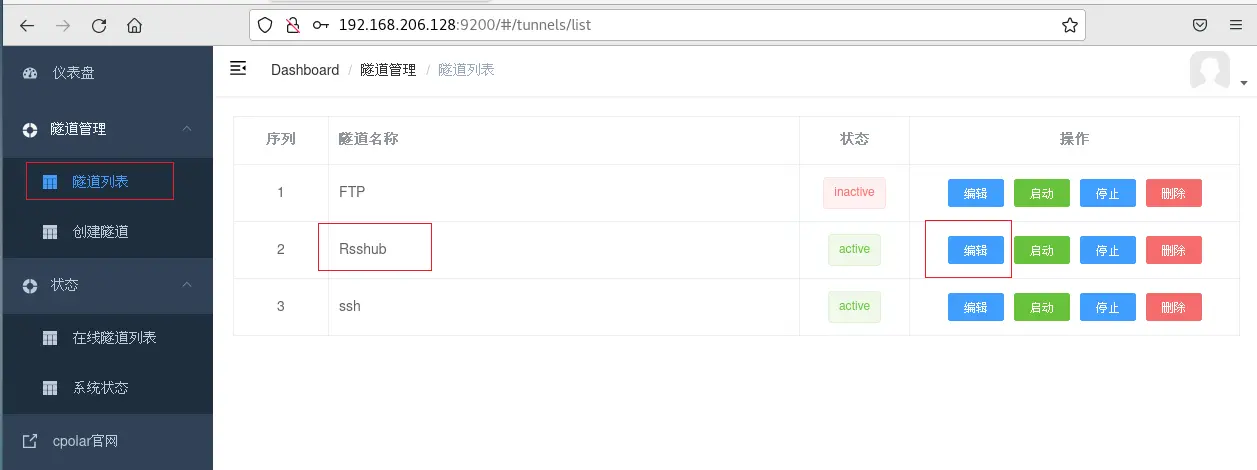

Rsshub借助于开源社区的力量快速发展,目前已适配数百家网站的上千项内容。要使用RSS,首先需要生成RSS订阅源。这可以通过RssHub等工具来完成。一旦生成了RSS订阅源,就可以搭配RSS阅读器来浏览自己感兴...

从2017年在《AttentionisAllYouNeed》中首次提出以来,Transformer模型已经成为自然语言处理(NLP)领域的最新技术。在2021年,论文《AnImageisWorth1...

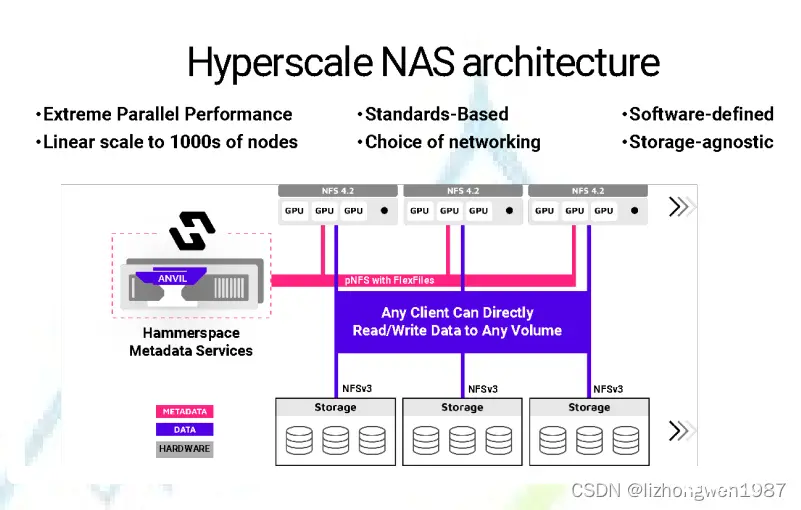

[Hammerspace](https://hammerspace.com/)是一款超大规模NAS产品,是第一款基于pNFSFlex文件布局技术实现的并行文件系统,同时具有横向扩展NAS的易用性以及传统并行文件...

Transformer是大语言模型(LargeLanguageModel,LLM)的基础架构Transformers库是HuggingFace开源的可以完成各种语言、音频、视频、多模态任务情感分析文本生成命名...

DiverseBranchBlock(DBB)是一种具有多分支结构的卷积模块,其核心思想是在训练阶段通过多个不同的分支进行特征提取,从而增强模型的表达能力。在推理阶段,这些分支通过重参数化技术合并为一个卷积层,从而保证了推理效率。DBB...

本文介绍了OpenLayers的安装、核心概念、API应用,包括Map、View、Layer和Source等组件,以及创建基础和高级示例的过程,展现了其在WebGIS开发中的重要性。...

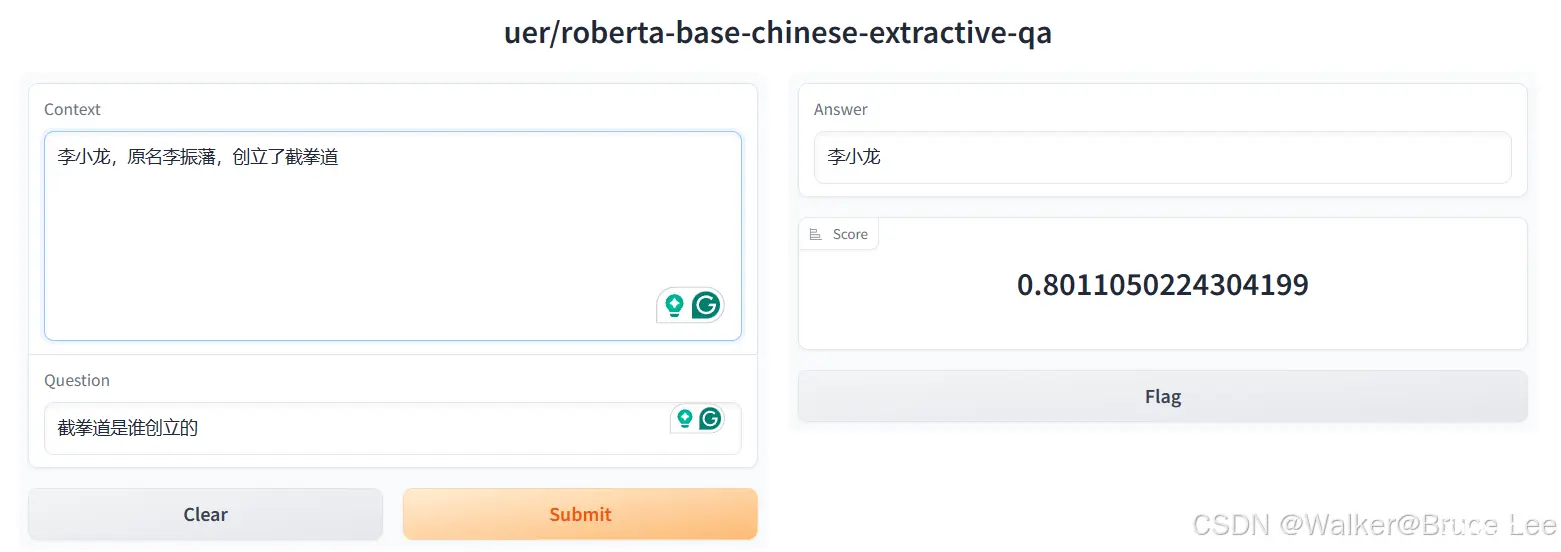

本文对transformers之pipeline的问答(question-answering)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文...

过去的几个月,我们目睹了使用基于transformer模型作为扩散模型的主干网络来进行高分辨率文生图(text-to-image,T2I)的趋势。和一开始的许多扩散模型普遍使用UNet架构不同,这些模型使用transformer架构作为扩散过程...