在端侧部署Transformer模型需要仔细考虑性能和兼容性。Python虽然功能强大,但对于部署来说有时并不算理想,特别是在由C++主导的环境中。这篇博客将指导您如何使用Optimum-Intel和OpenVINO™Ge...

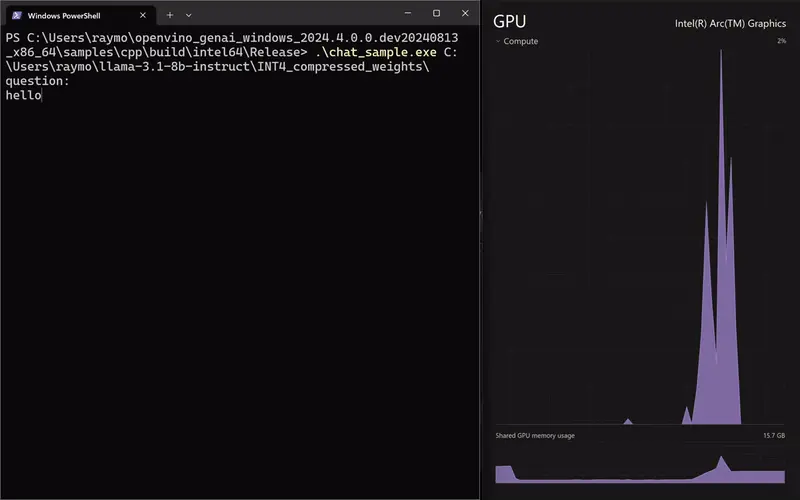

OpenVINO™GenAIAPI提供了一个原生的C++接口,消除了对Python依赖的需求,使开发者可以用更高效的方式创建AI应用程序。下面是一个基于Windows操作系统的分步骤指南,手把...

将OpenVINO™ModelOptimizer、ChatGLM-6B以及P-Tuning微调技术相结合,可以构建出一个高效、灵活且性能优异的AI新闻小助手。该助手能够利用优化后的ChatGLM-6B模型快速...

边缘计算(EdgeComputing)是一种分布式计算架构,它将计算、存储和数据处理任务从数据中心或云计算平台移动到数据产生的地点,即“边缘”设备上。边缘计算常用于需要实时数据处理的应用场景,比如智能城市、自动驾驶...

AI智能体作为通用人工智能的核心载体,可以模仿人类的思维逻辑,将复杂任务进行拆解,并借助外部工具解决任务。通过利用OpenVINOTM和Qwen-Agent这样的工具,我们可以非常快捷地在本地构建一个AI智能体应用,在...

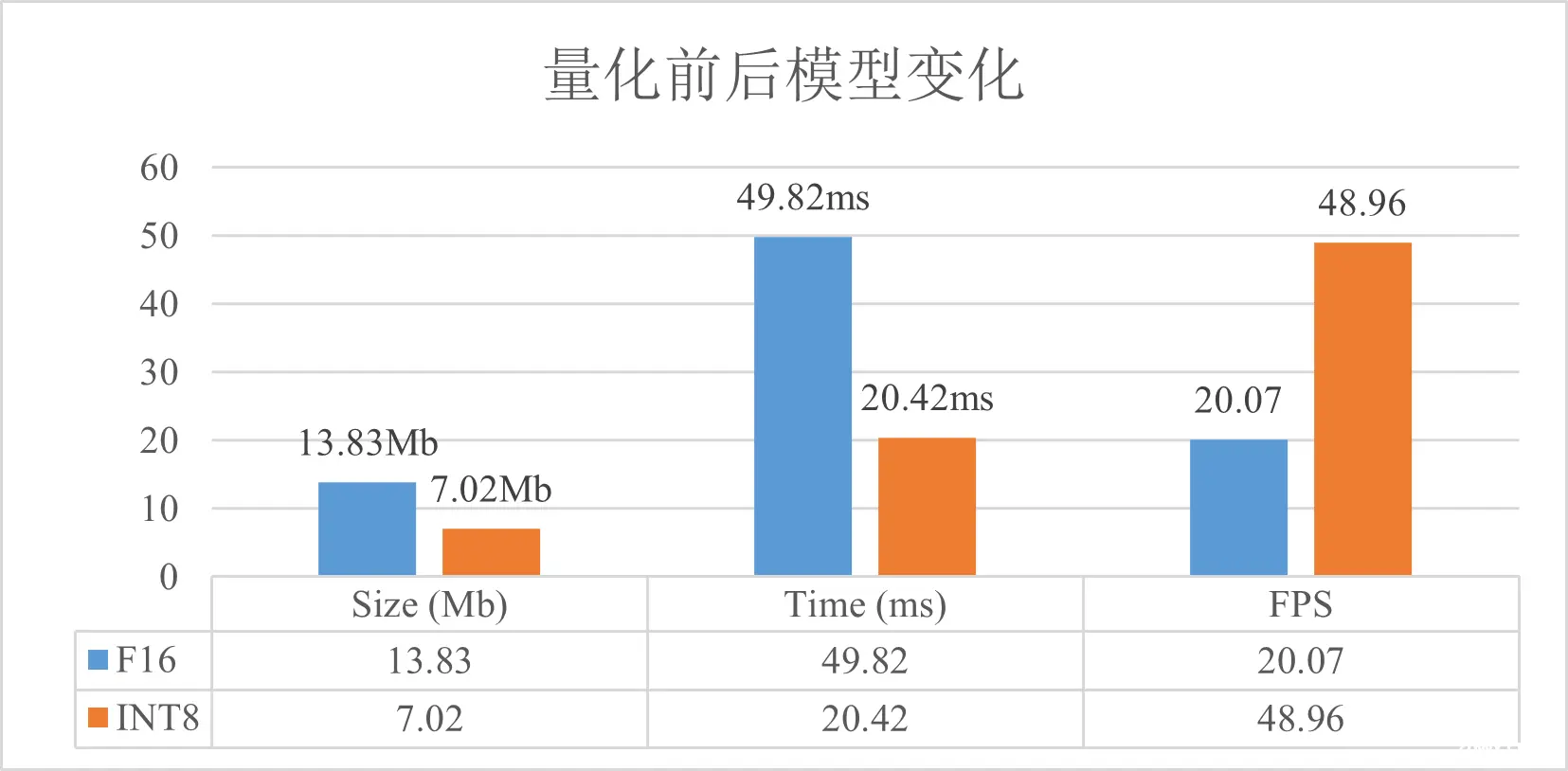

学习如何构建用于AI推理解决方案的计算机视觉和异常检测应用程序。使用开源的Anomalib库进行无监督学习,并处理不平衡数据集,以便实时处理罕见的缺陷问题,在制造业、医疗保健、农业等领域提高质量控制水平。此外,...

英特尔发行版OpenVINO™工具套件基于oneAPI而开发,可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,适用于从边缘到云的各种英特尔平台上,帮助用户更快地将更准确的真实世界结果部署到生产系统中。YOLOv10是清华大学研究人员近期提出...

点击蓝字关注我们,让开发变得更有趣作者|武卓博士英特尔OpenVINO布道师排版|李擎使用OpenVINO™在你的AIPC上离线运行Llama3之快手指南在人工智能领域,大型语言模型(LLMs)的发展速度令人震...

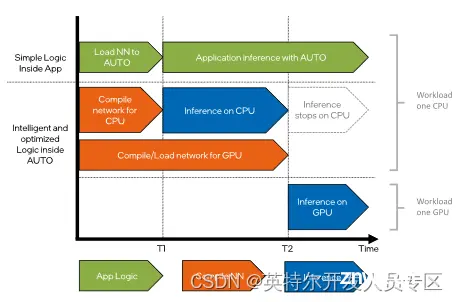

本文介绍了在使用OpenVINO™工具套件部署AI推理时,如何利用OpenVINO™提供的多种方式去优化程序启动初次推理的响应时间,包括了使用AUTOPlugin,使用模型缓存或者说使用mmap方式读取模型。_op...