本地运行大模型耗资源,需要选择较小的模型作为基础模型。在终端中运行时可能会出现CUDA错误,表示显存不足,导致提供的端口失效。中文支持不够完善。\\3.文中提到的技术软件工具有:Ollama、Chatbox...

Docker环境安装anythingllm。_anythingllmdocker...

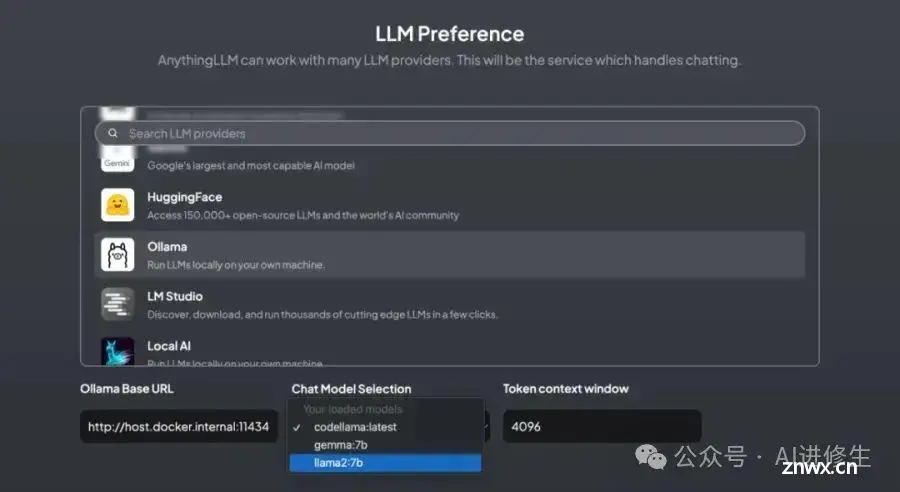

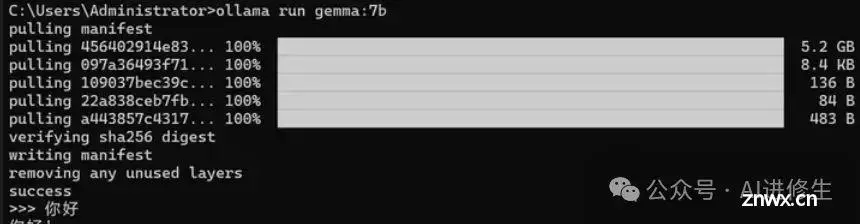

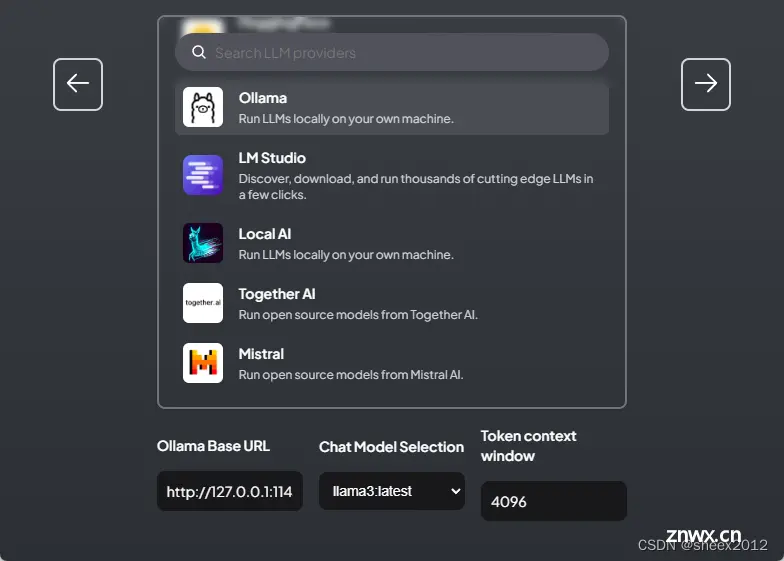

整个过程需要准备三个工具:Ollama:用于运行本地大模型的管理:llama3,qwen2等Docker:用于运行AnythingLLM。AnythingLLM:知识库运行平台,提供知识库构建及运行的功能。_ol...

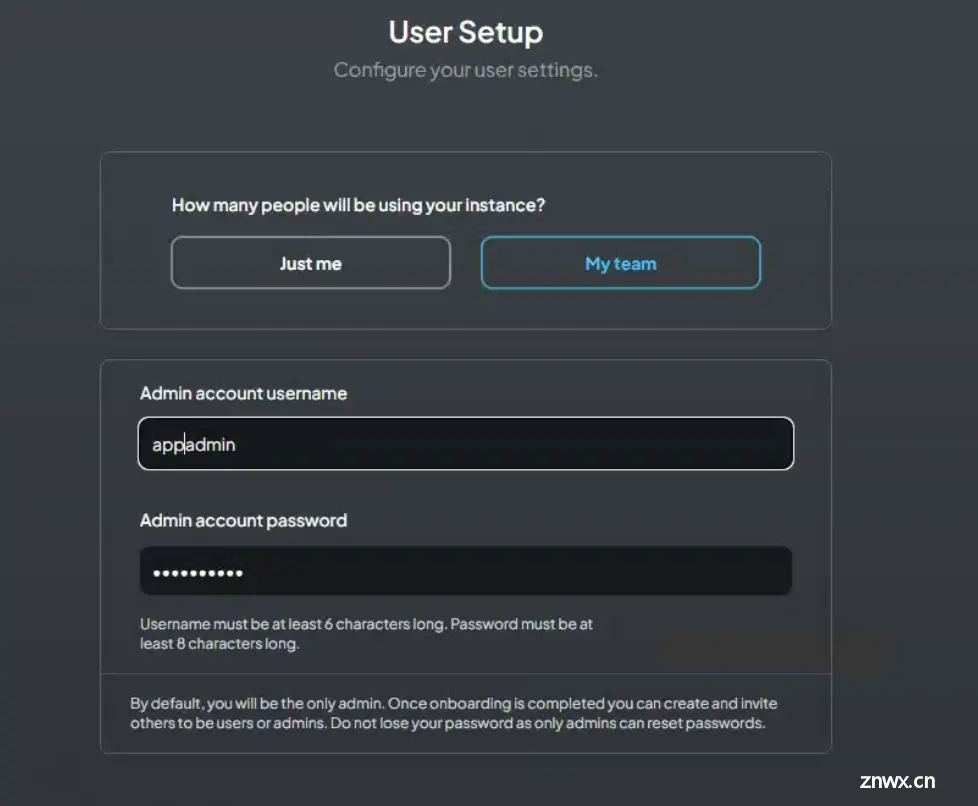

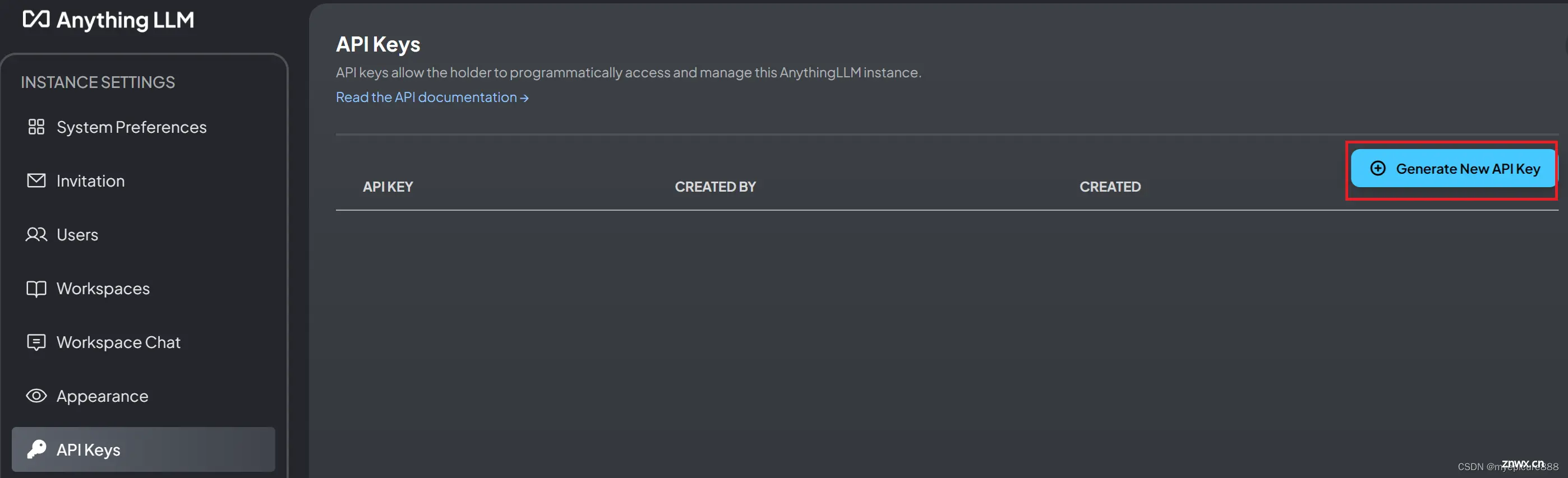

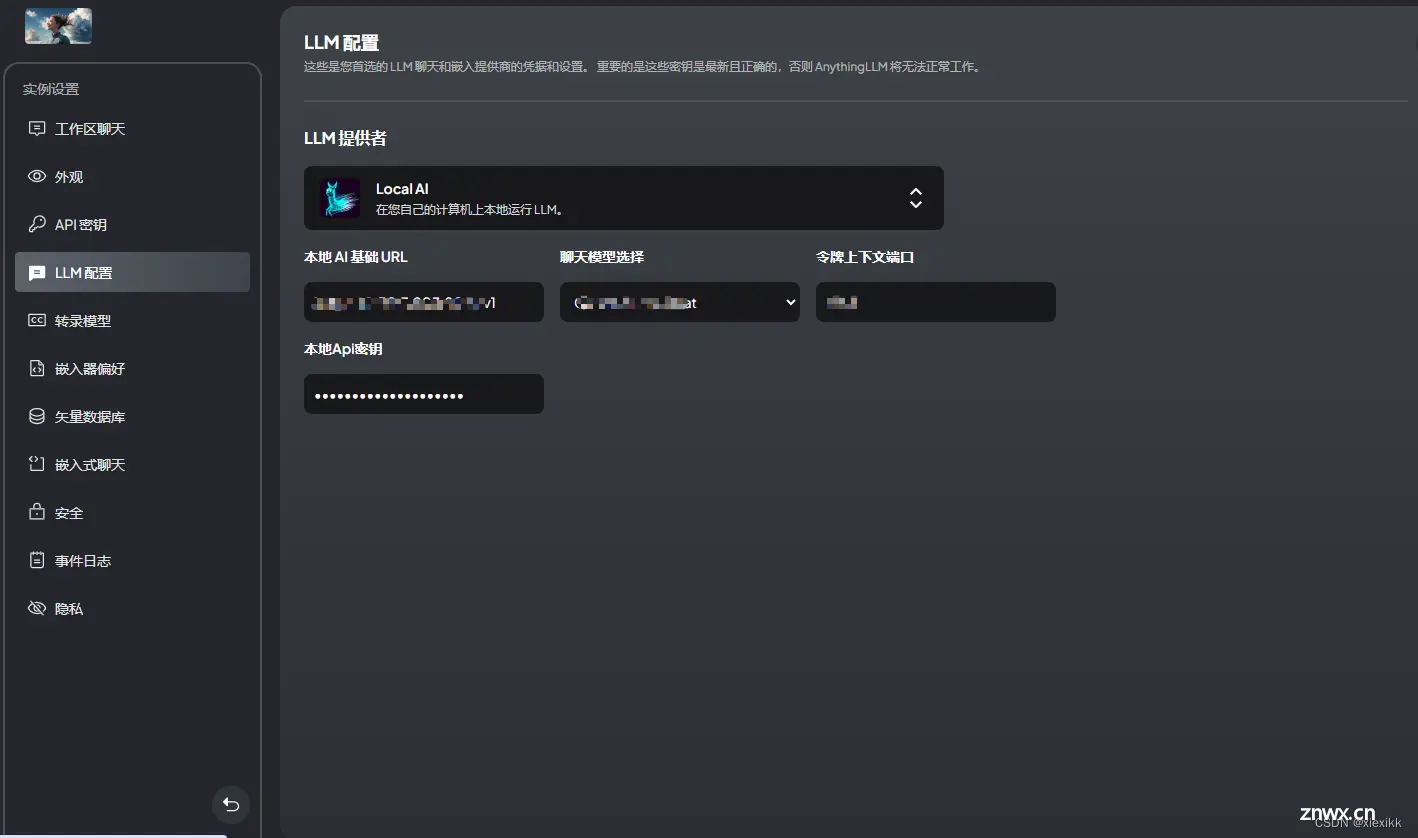

就可以访问anythingLLM了。3.安装Enchanted。1.拉取镜像,终端执行。3.配置ollama。_anythingllmdocker...

AnythingLLM是使用大语言模型LLM的一站式简便框架。_anythingllmdocker...

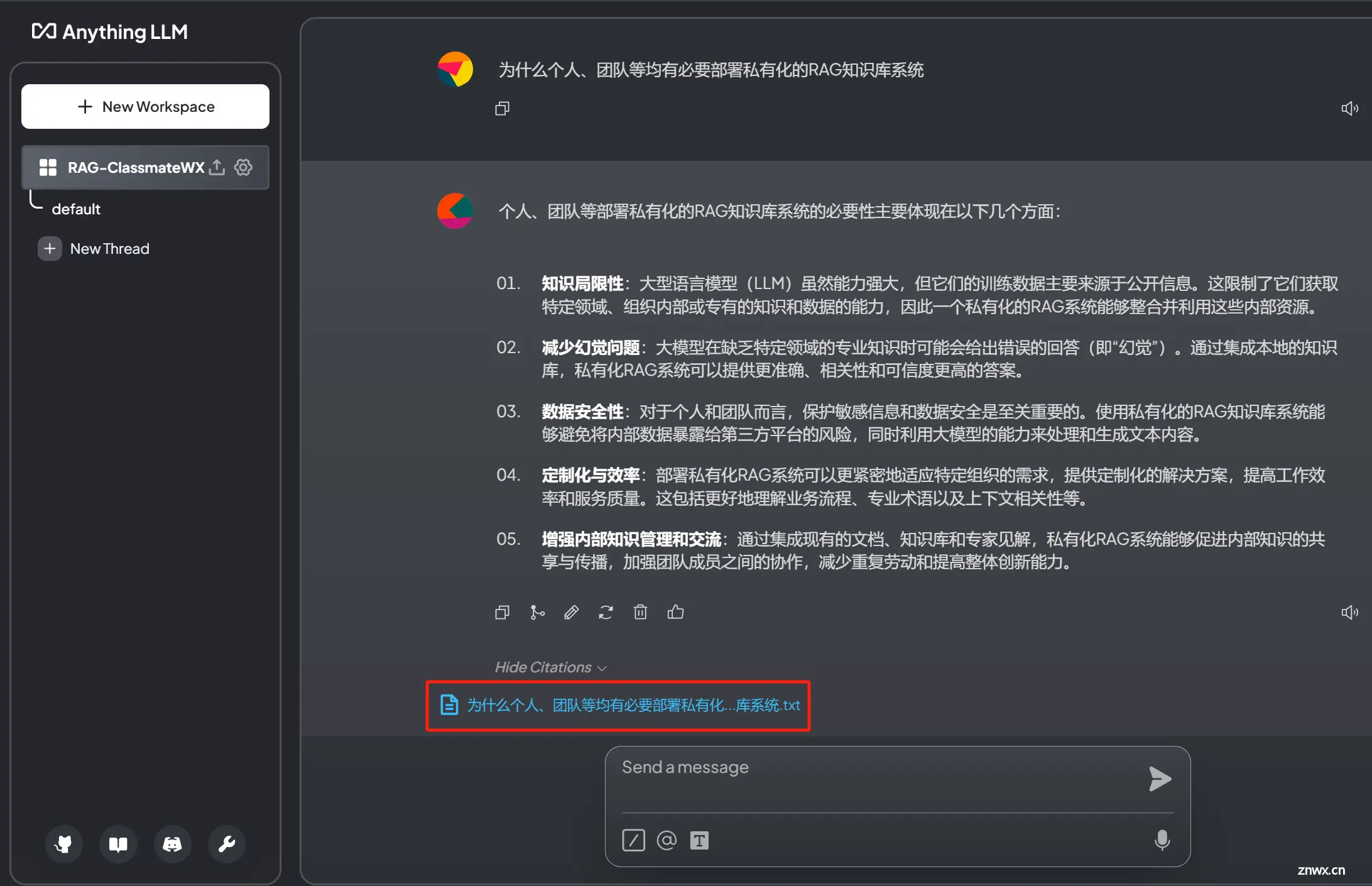

大语言模型在垂直细分领域存在知识局限、幻觉、数据安全等一些问题,可通过RAG(检索增强生成)方案来解决。本文基于AnythingLLM框架,搭建团队私有知识库系统,并进行使用和验证,RAG系统在保留输出的有效性同时,还保留了创造性……...

将上面的dockerrun命令转换为docker-compose.yml文件,并设置open-webui和anythingllm服务依赖于ollama服务,方便管理。这将停止并移除容器,但不会删除卷。每个服务都...

本地运行大模型耗资源,需要选择较小的模型作为基础模型。在终端中运行时可能会出现CUDA错误,表示显存不足,导致提供的端口失效。若使用HuggingFace,需要申请APIKey并且需要本地有Pyth...

本文介绍了LLM在落地应用中的不足,并引入了RAG框架和原理,以及RAG在私有知识库建设中的重要作用。并以Ollama和AnythingLLM为实现手段,构建了并测试了本地知识库,测试结果表明,有了RAG的加持,...

AnythingLLM是一个全栈应用程序,您可以使用商业现成的LLM或流行的开源LLM和vectorDB解决方案来构建私有ChatGPT,无需任何妥协,您可以在本地运行,也可以远程托管并能够智能聊天以...