在打造企业AI大模型的路上,我们常常会遇到一系列的选型和概念挑战。例如,如何选择合适的模型,如何挑选GPU,以及什么是微调和监督微调等。本文旨在深入剖析这些常见问题,为大家提供一个全面的概览,帮助大家更好地理解和...

Datawhale学习项目来源:Datawhale团队、百度智能云、飞桨AI+X系列:和学习生态伙伴联合发起,将人工智能(AI)与各个学科、领域、行业(X)结合,激发无限潜力和创造力(X),让学习者拥有更多可能性(...

AIGC大模型参数的5B、7B是指模型中可训练参数的数量。这里的“B”表示10亿(Billion),即10^9。因此,5B表示50亿个可训练参数,7B表示70亿个可训练参数。_大模型参数量6b7b的意思...

2023年全球AI浪潮迭起,大语言模型热度空前,生成式人工智能为千行百业高质量发展带来更多想象空间。作为前沿科技风向标、汇聚全球开发者的顶级盛会,WAVESUMMIT2023深度学习开发者峰会正式定档8月16...

AI爆款文案是指利用人工智能技术生成的具有吸引力、传播力和转化力的文案内容。它具备以下几个显著特点:AI爆款文案能够精准把握目标受众的需求和兴趣。通过深度学习和大数据分析,AI能够理解消费者的心理和行为,从而...

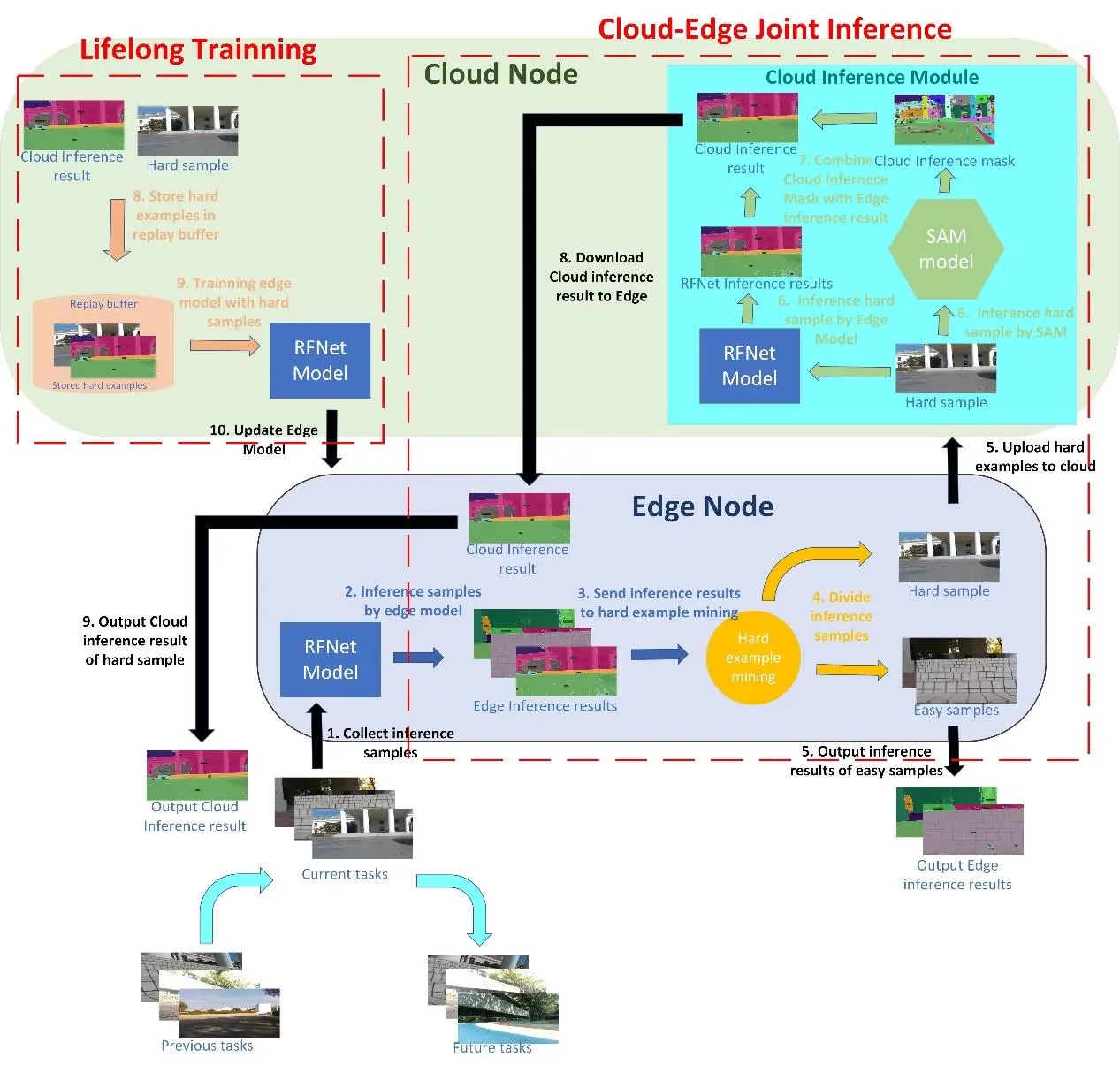

采用基于难例样本挖掘的云边协同策略,将大部分简单推理样本在边缘端由边缘小模型处理,少部分难例推理样本上传云端由云端SAM大模型处理,从而在保证推理时延的情况下提高推理准确率。...

中英文多模态大模型VisualGLM-6B微调部署全流程_fromsat.modelimportautomodel...

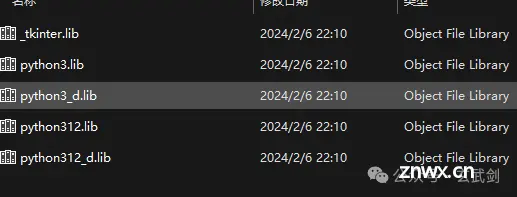

利用C++与Python调用千帆免费大模型,构建个性化AI对话系统千帆大模型已于2024年4月25日正式免费,调用这个免费的模型以实现自己的AI对话功能,遵循以下步骤_如何在自己程序上调用千帆...

当用户提出一个问题时,首先需要将其转化为机器可读的形式。这通常意味着将问题转换为文本格式。AI大模型可以接受各种输入形式,如语音、图像或视频,但最终都需要转换为文本数据才能进行处理。根据IBM的一项研究,目前有超过8...

当今人工智能领域,最受关注的毋庸置疑是大模型。然而,高昂的训练成本、漫长的训练时间等都成为了制约大多数企业入局大模型的关键瓶颈。这种背景下,向量数据库凭借其独特的优势,成为解决低成本快速定制大模型问题的关键所在。...