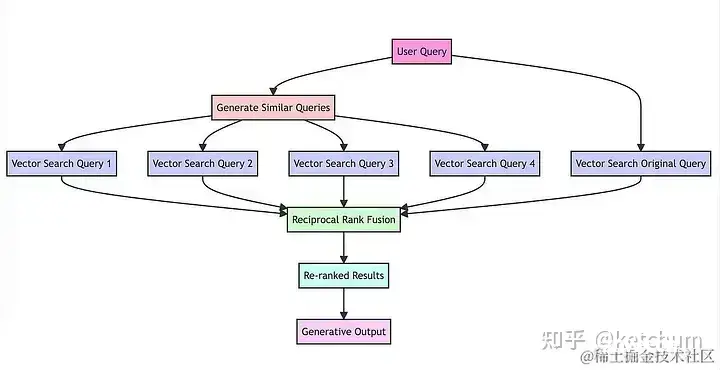

RAG(Retrieval-AugmentedGeneration)的核心思想是:将传统的信息检索(IR)技术与现代的生成式大模型(如chatGPT)结合起来。具体来说,RAG模型在生成答案之前,会首先从一个大...

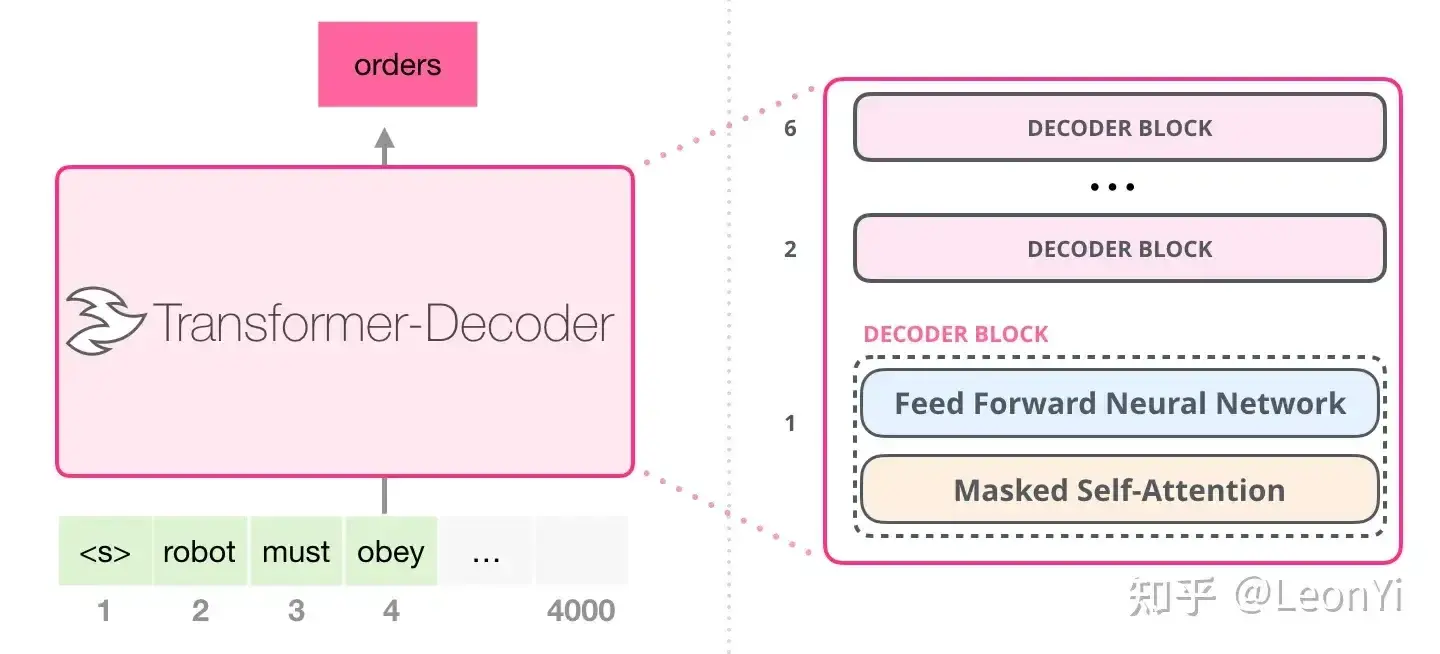

本文是【训练LLM系列】的第一篇,主要重点介绍NanoGPT代码以及中文、英文预训练实践。最新版参见我的知乎:https://zhuanlan.zhihu.com/p/716442447除跑通原始NanoGPT代码之外,分别使用了《红楼梦》、四大名著和几十本...

检索增强生成(RetrievalAugmentedGeneration),简称RAG,已经成为当前最火热的LLM应用方案。_llmrag...

Docker环境安装anythingllm。_anythingllmdocker...

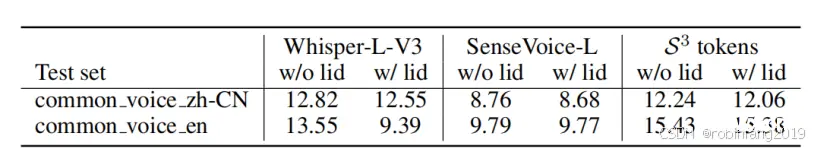

阿里开源大模型FunAudioLLM,一个创新的框架,旨在促进人类与大型语言模型(LLMs)之间的自然语音交互。FunAudioLLM的核心是两个开创性的模型:用于语音理解的SenseVoice和用于语音生成的C...

等,进一步支撑你的行动,以提升本文的帮助力。_获取openwebui的请求头...

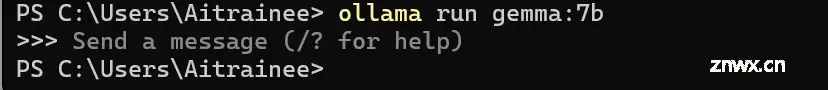

本地部署了大模型,下一步任务便是如何调用的问题,实际场景中个人感觉用http请求的方式较为合理,本篇文章也将通过http请求的方式来调用我们本地部署的大模型,正文开始。_ollamapython调用...

本文实现了工程实践下并发控制下LLM服务器部署并提供流式响应。使得LLM服务器可以同时处理多个请求,并实现“当请求达到一定数量后,直接拒绝后续的推理请求”功能,防止服务器过载以及排队时间过长影响用户体验(直接告知...

1.用prompt让LLM直接生成结构化的数据例1.让GPT-4o-mini生成CSV格式的住宅数据表:创建一个包含10行住房数据的CSV文件。每一行应包括以下字段:-id(从1开始的递增整数)-房屋面积(平方米)-房屋价格-地点-...

本文介绍了Bellman-Ford算法,用于解决含有负权边的单源最短路径问题。与Dijkstra算法相比,Bellman-Ford允许边的权重为负数,通过n-1次迭代更新最短路径。文章详细阐述了算法思路,包括初始化...