2024-10-02 15:31:01

vLLM是一个用于大语言模型服务的高性能框架。高吞吐量:通过优化的推理引擎,vLLM能够处理大量并发请求。低延迟:采用创新的调度算法,最小化请求的等待时间。兼容性:支持多种流行的语言模型,如GPT、LLaMA、OP...

2024-08-19 09:05:02

本文实现了工程实践下并发控制下LLM服务器部署并提供流式响应。使得LLM服务器可以同时处理多个请求,并实现“当请求达到一定数量后,直接拒绝后续的推理请求”功能,防止服务器过载以及排队时间过长影响用户体验(直接告知...

2024-07-17 11:31:01

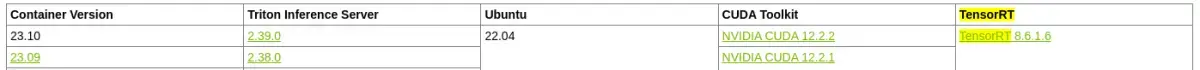

而在Triton+vLLM的组合中,Triton不会做任何的调度处理,而是将请求全部打给vLLM,让vLLM根据PagedAttention和异步API自行处理请求,vLLM的调度策略更适配大语言模型decode...

2024-06-13 08:03:08

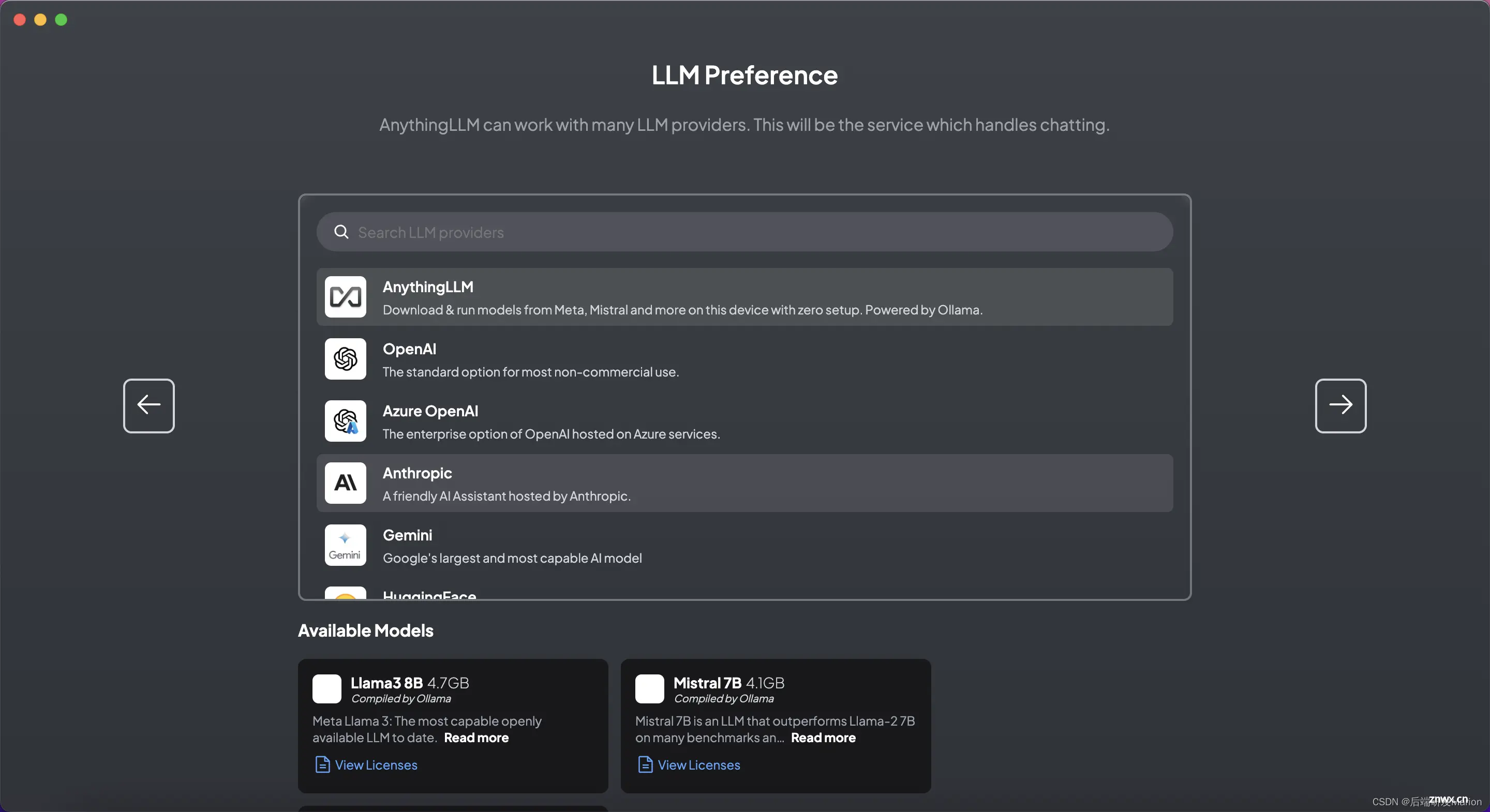

如果需要,可以使用AnythingLLM的开发者API进行自定义集成,以满足特定的业务需求。_open-webui自定义知识库...