AI系统是一个集成了硬件、软件和数据,用于执行人工智能任务的复杂系统。它涵盖了从数据收集、预处理、模型训练、推理到最终应用部署的整个过程。AI系统的核心在于通过机器学习算法和深度学习模型,使计算机能够模拟人类的智...

gpu资源也是服务器中常见的一种资源,gpu即显卡,一般用在人工智能、图文识别、大模型等领域,其中nvidiagpu是nvidia公司生产的nvidia类型的显卡,amdgpu则是adm公司生产的amd类型gpu。企业中服务器最常见...

在这个显卡昂贵的年代,很多想要尝试一下AI的人可能都止步于第一步。这个时候我们可以租用在线的GPU资源来使用AI。autoDL就是这样的一个云平台。_autodlollama...

GPU已经成为AI创业团队必不可少的关键资源。然而AI热潮也让GPU一卡难求,所幸还有共享GPU、GPU云服务作为可选方案。那么在不同的阶段,创业团队应该选择自己买卡、共享GPU还是GPU...

CPU(中央处理器)和GPU(图形处理单元)是计算机系统中最重要的两种处理器。它们各自的架构设计和技术体系决定了其在不同应用领域中的性能和效率。本文将详细分析CPU和GPU的架构,重点探讨它们在人工智能(A...

我们在Linux系统上成功配置了Docker支持GPU。利用GPU加速,您可以显著提升高性能计算任务的效率。无论是单个容器还是通过DockerCompose管理的多容器环境,Docker的GP...

ubuntu22.04安装RTX4090显卡驱动GPUDriver(PyTorch准备)_ubunturtx4090驱动...

英伟达H100算力出租,Punkhash探索AI无限,GB200/H800算力租赁解决方案GPU算力租赁成本揭秘史上最贵芯片NvidiaH100是什么?_英伟达h100租金...

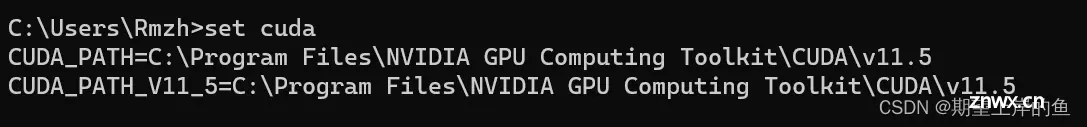

Tensorflow-gpu保姆级安装教程(Win11,Anaconda3,Python3.9)_tensorflow-gpu...

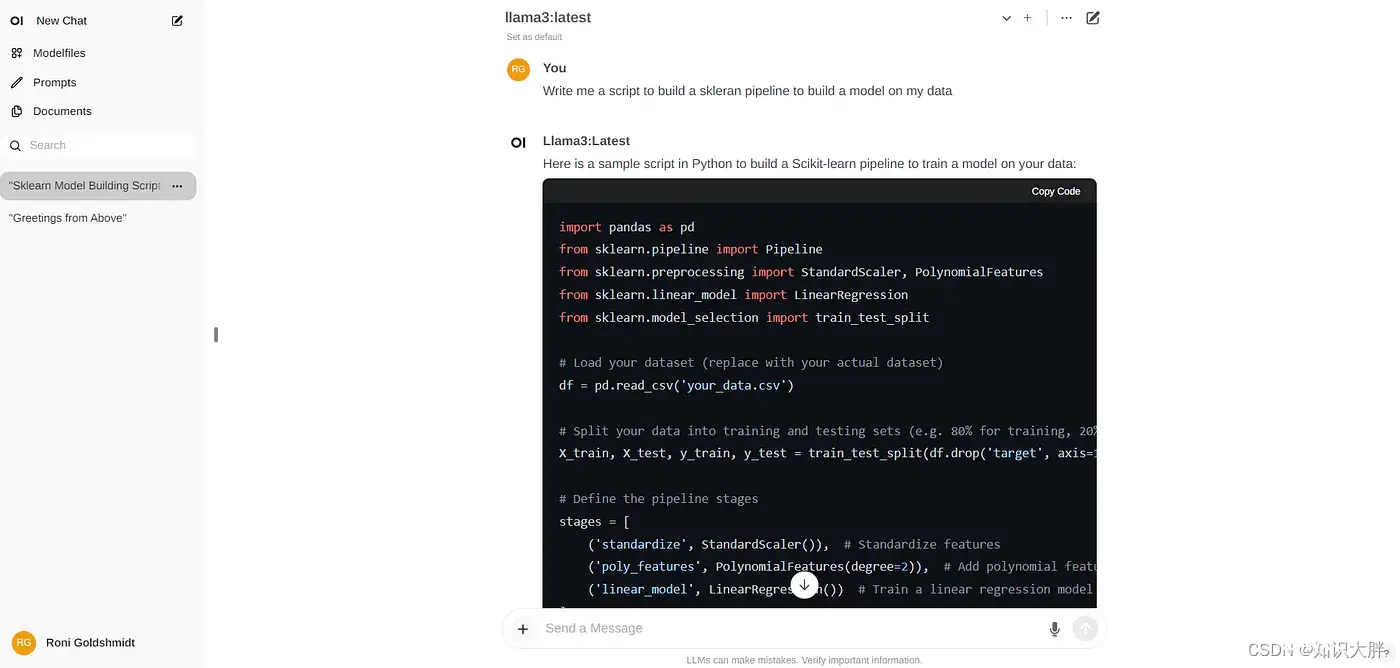

Ollama是一个强大的框架,专为大型语言模型的本地执行而设计。它提供了一种用户友好的方法来部署和管理人工智能模型,使用户能够直接从他们的机器运行各种预训练或自定义模型。Ollama的多功能性突出在于其全面的模型库,范围从较小的80...