介绍如何通过Ollama+Docker在本地部署大模型_ollamadocker...

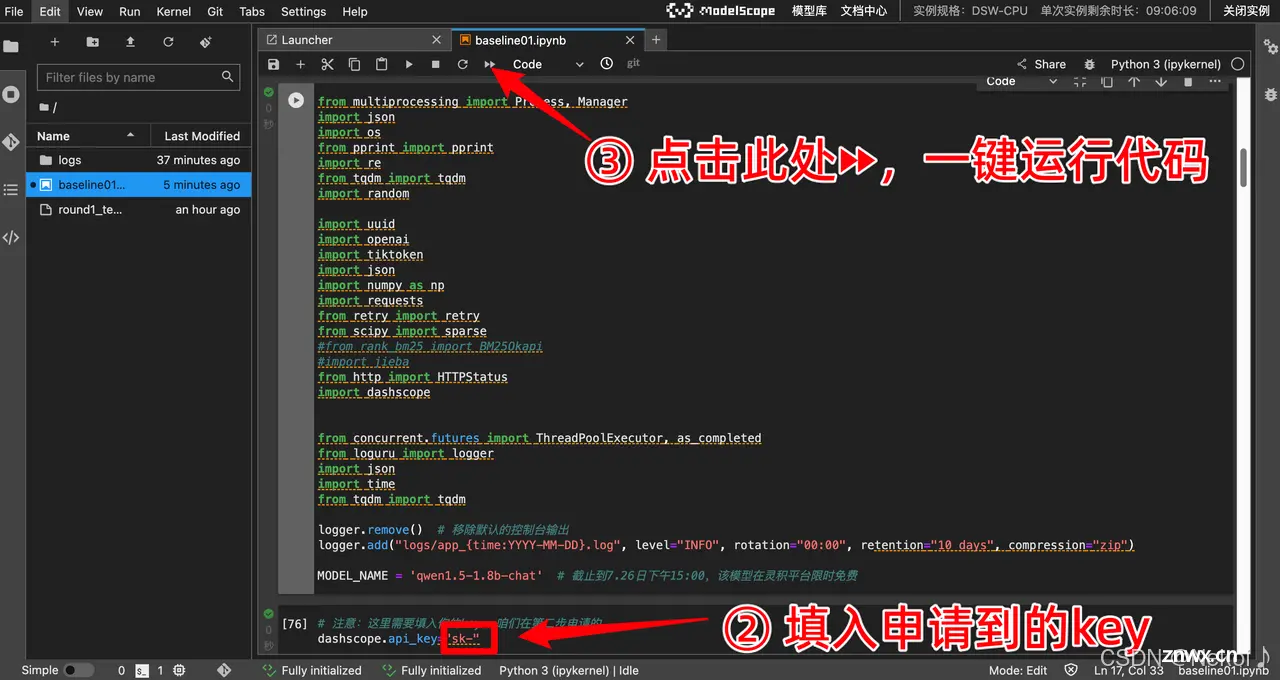

AI+逻辑推理比赛是由上海科学智能研究院、复旦大学联合阿里云在上智院·天池平台发布“第二届世界科学智能大赛”的逻辑推理赛道:复杂推理能力评估,该比赛聚焦于通过解决复杂的逻辑推理题,测试大型语言模型的逻辑推理能力。选手...

在AI大语言模型中,温度(Temperature)和top_k是两个重要的超参数,它们主要影响模型生成文本时的多样性、创造性以及可控性。_temperatureai...

![[Linux#43][线程] 死锁 | 同步 | 基于 BlockingQueue 的生产者消费者模型](/uploads/2024/08/26/1724647022902080345.webp)

本文探讨了多线程编程中的关键问题,包括死锁的产生与解决、条件变量的使用,以及基于BlockingQueue的生产者消费者模型的实现与注意事项。...

如果你使用商用大模型,或者使用开源大模型本地化部署,除了生成的质量之外,另外一个关键的指标就是生成token的速度。而且并不是简单的每秒生成多少个token,而是拆成了两个阶段:1.prefill:预填充,...

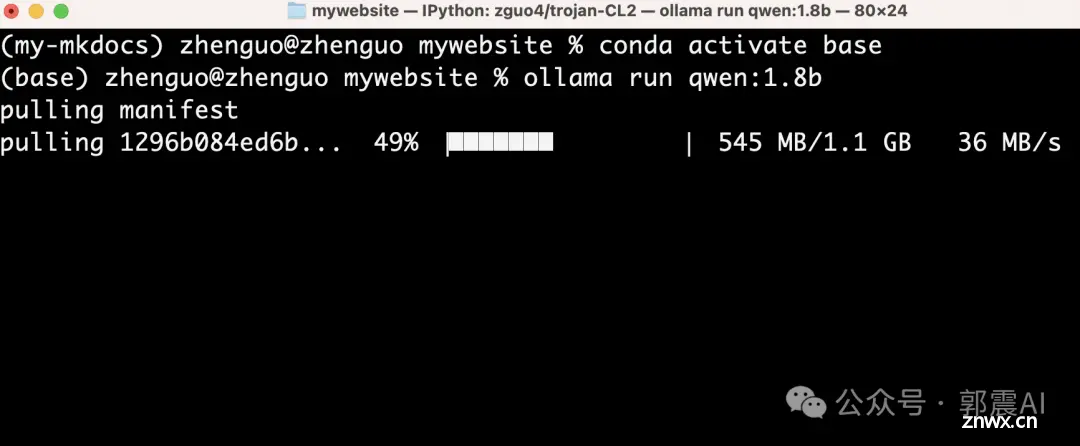

你好,我是郭震这篇教程主要解决:1).有些读者朋友,电脑配置不高,比如电脑没有配置GPU显卡,还想在本地使用AI;2).Llama3回答中文问题欠佳,想安装一个回答中文问题更强的AI大模型。3).想成为AI开...

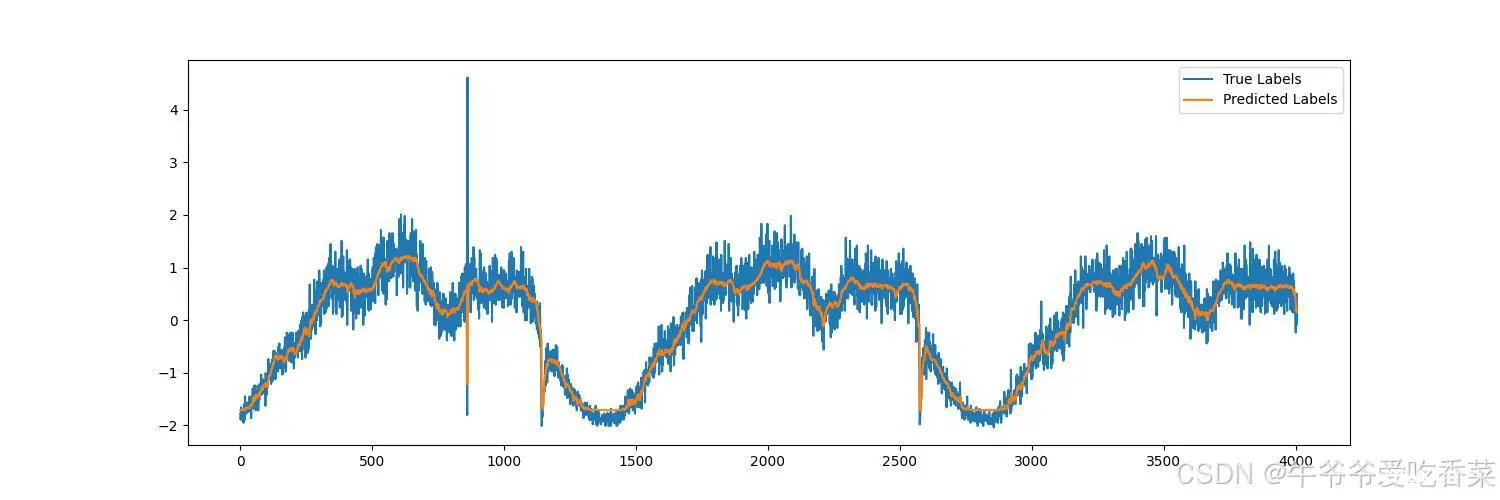

本文讲述了注意力机制在出租车客流预测方面的作用,详细介绍了模型代码结构以及模型的调参过程,可以很好的理解模型结构。_cnn+lstm实例...

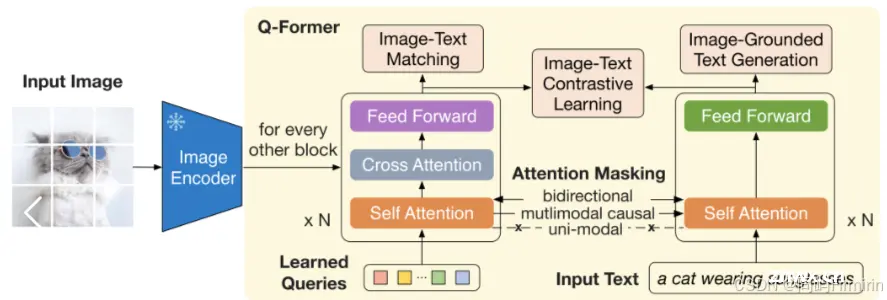

面试中遇到的问题,自己在实践中注意到了却没有深究原因,没有回答好,特此记录和探讨这个问题。多模态大模型中需要一个输入投影模块,将视觉特征投射到LLM能理解的语言特征维度,这里就可以选择各种不同的模块。LLaVA最初...

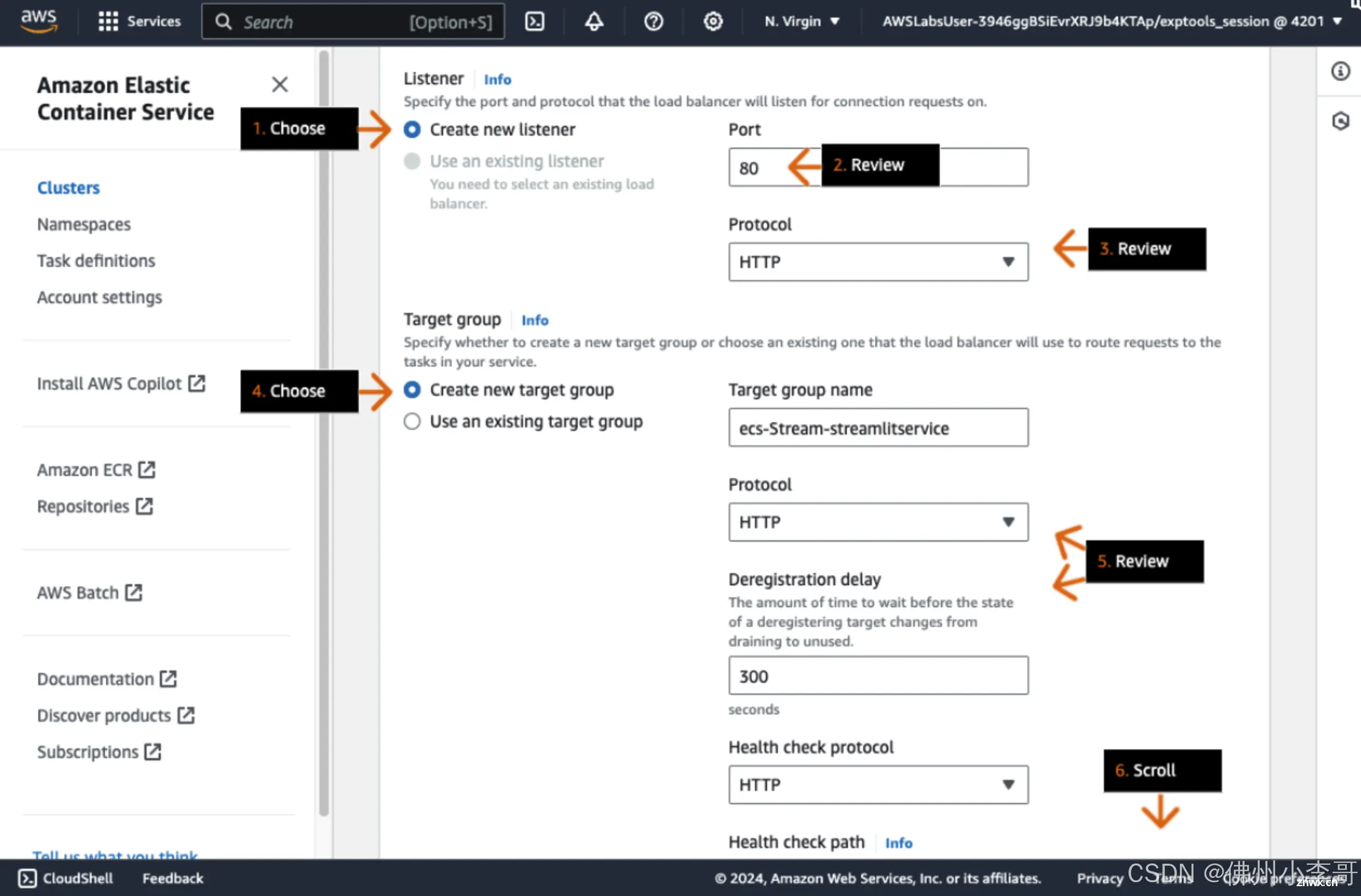

AmazonSageMaker是亚马逊云科技提供的一站式机器学习服务,旨在帮助开发者和数据科学家轻松构建、训练和部署机器学习模型。SageMaker提供了从数据准备、模型训练到模型部署的全流程工具,使用户能...

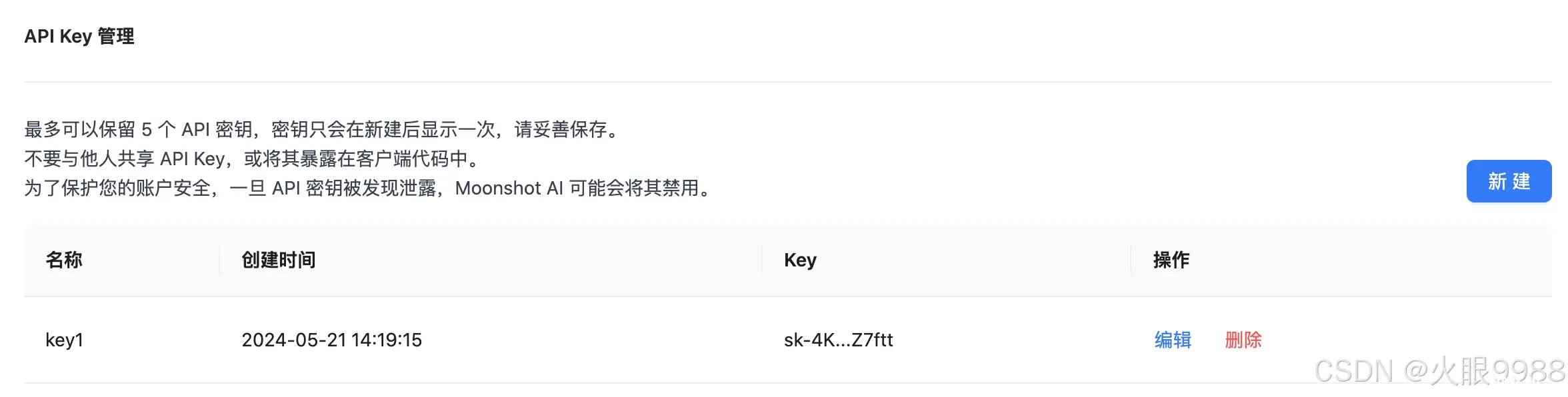

Kimi是月之暗面公司出品的人工智能大模型助手,在国内中文大模型中算还是不错的。接下来我们将详细介绍,如何接入KimiAI智能大模型,并提供可使用的生产代码(Java)。_moonshot-v1-8k下载...