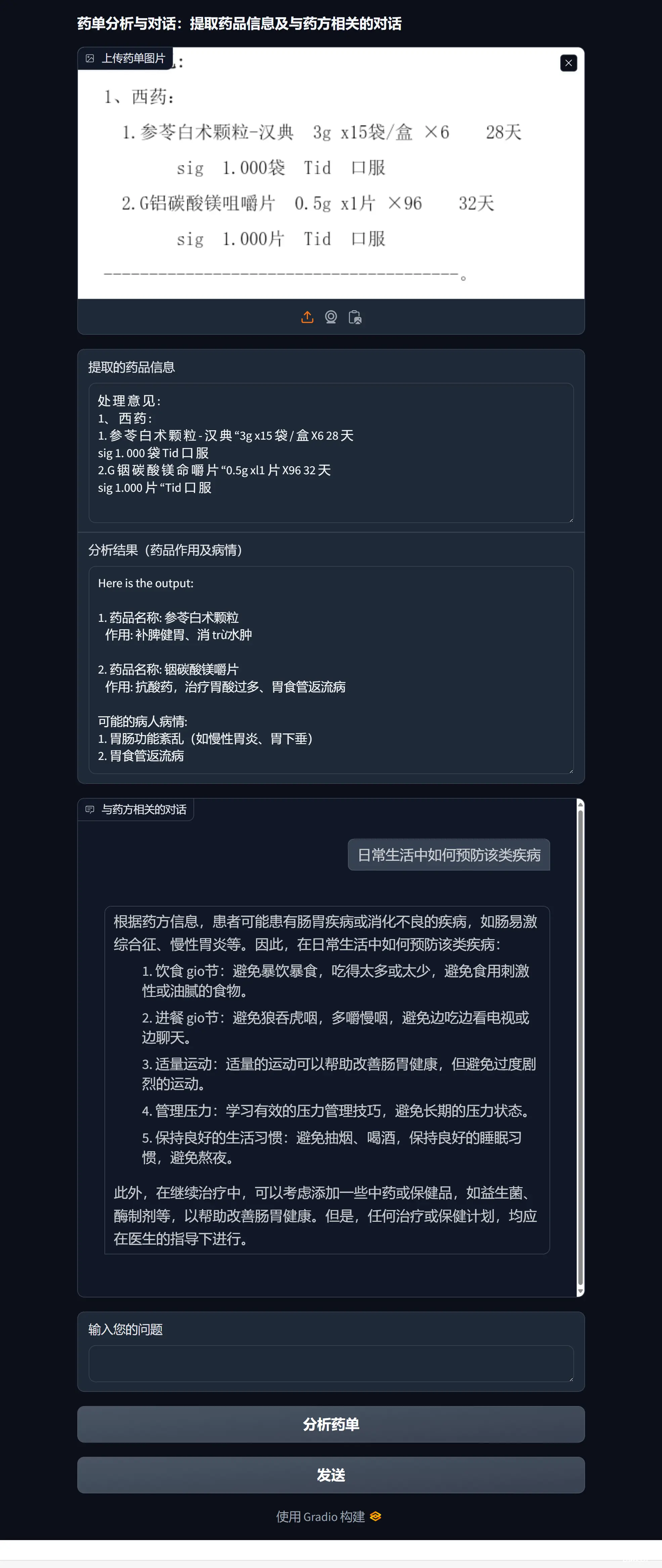

开发一个基于RAG(Retrieval-AugmentedGeneration)技术的智能对话机器人,能够从药单图片中提取信息,并结合大模型分析药品信息,推测病情,进一步为用户提供健康咨询。项目亮点包括OCR图像...

工欲善其事,必先利其器。AI是未来十年生产力的核心工具,要让AI真正转化为生产力,而不仅仅是围观一时的热潮。如果你对AI也很感兴趣,欢迎关注,共同探索AI的无限可能,与渔夫一起成长!今天聊聊AI智能...

这两天在AI圈,世界人工智能大会(WAIC)在线上线下持续火热发酵。作为一年一度的AI盛事,此次大会无疑是各大AI厂商秀肌肉的最佳展示舞台。根据WAIC官方数据,今年有500余家企业参展,市外企业和国际企业占比超过...

GGUF格式的全名为(GPT-GeneratedUnifiedFormat),提到GGUF就不得不提到它的前身GGML(GPT-GeneratedModelLanguage)。GGML是专门为了...

近年来,随着深度学习技术的迅猛发展,AI大模型已经成为人工智能领域的重要研究方向和热点话题。AI大模型,指的是拥有巨大参数规模和强大学习能力的神经网络模型,如BERT、GPT等,这些模型在自然语言处理、计算机视觉...

近年来,AI技术的发展日新月异,从最初的专用型AI到如今的全能型AI,技术进步的速度令人惊叹。OpenAI计划推出的“草莓”模型就是一个典型的例子,它不仅擅长解决数学问题,还能处理主观的营销策略,展现了其惊人的多...

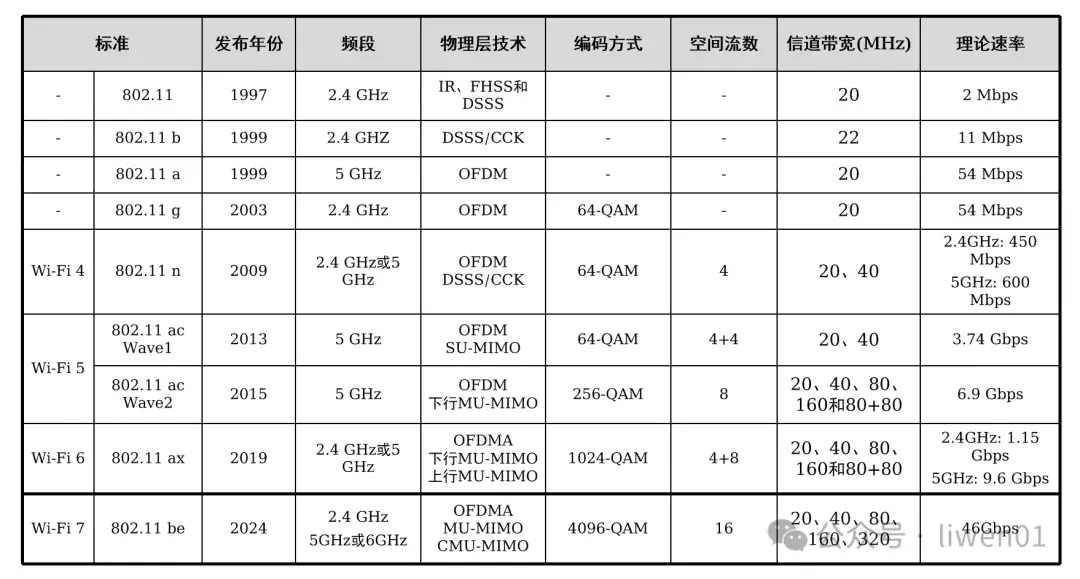

liwen012024.09.01前言最近十几年,通信技术发展迅猛,通信标准更新频繁,有的设备还在使用802.11/b/g/n协议,有的已支持到WiFi6、WiFi7。而国内有关无线WiFi的书籍或资料却很少,就算能找着的,大多也是比较老旧。...

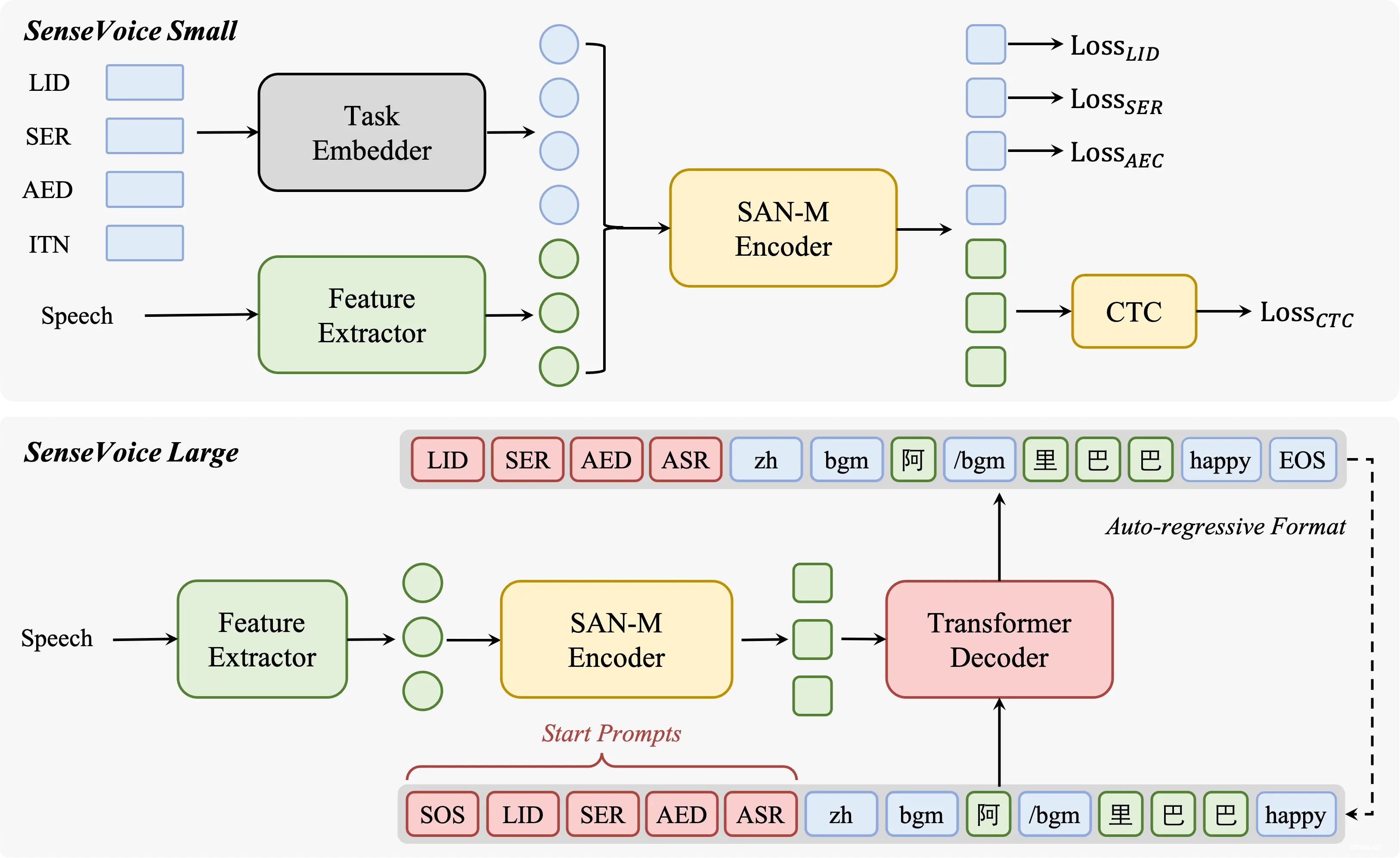

深入了解FunAudioLLM,阿里巴巴通义实验室开源的先进语音技术项目。SenseVoice和CosyVoice两大模型,以其高精度多语言语音识别、情感辨识和自然语音生成能力,引领语音交互的新时代。本文详细解析...

通过llama.cpp运行7B.q4(4bit量化),7B.q8(8bit量化)模型,测量了生成式AI语言模型在多种硬件上的运行(推理)速度.根据上述测量结果,可以得到以下初步结论:(1...

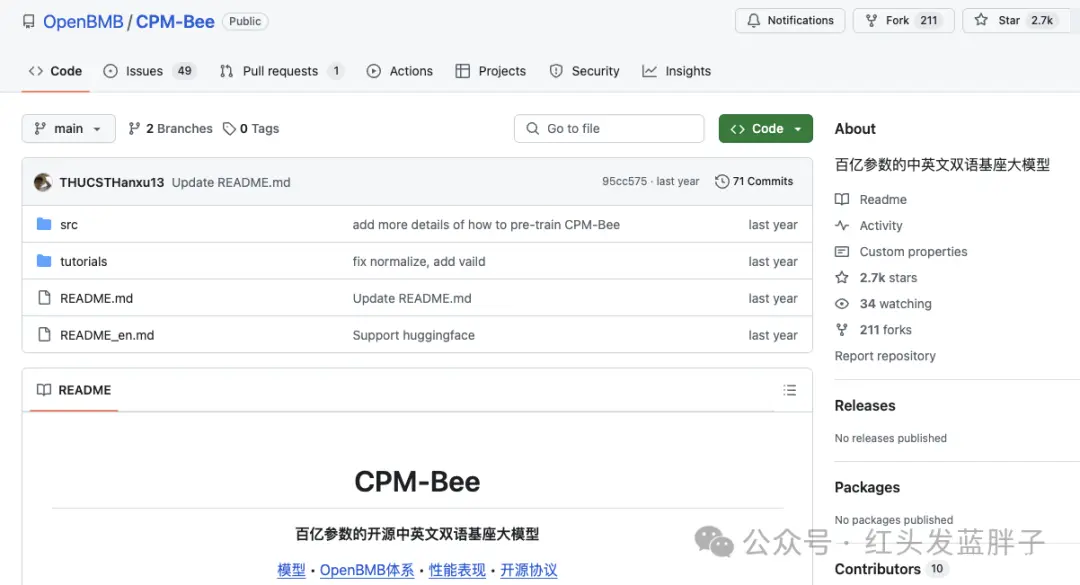

近年来,随着人工智能技术的飞速发展,中国在大模型领域崭露头角,涌现出了一批具有国际竞争力的通用大模型。这些模型不仅在中文自然语言处理方面展现出色,也在多模态理解、图像处理、对话系统等多个领域表现优异。今天,我为大家盘...