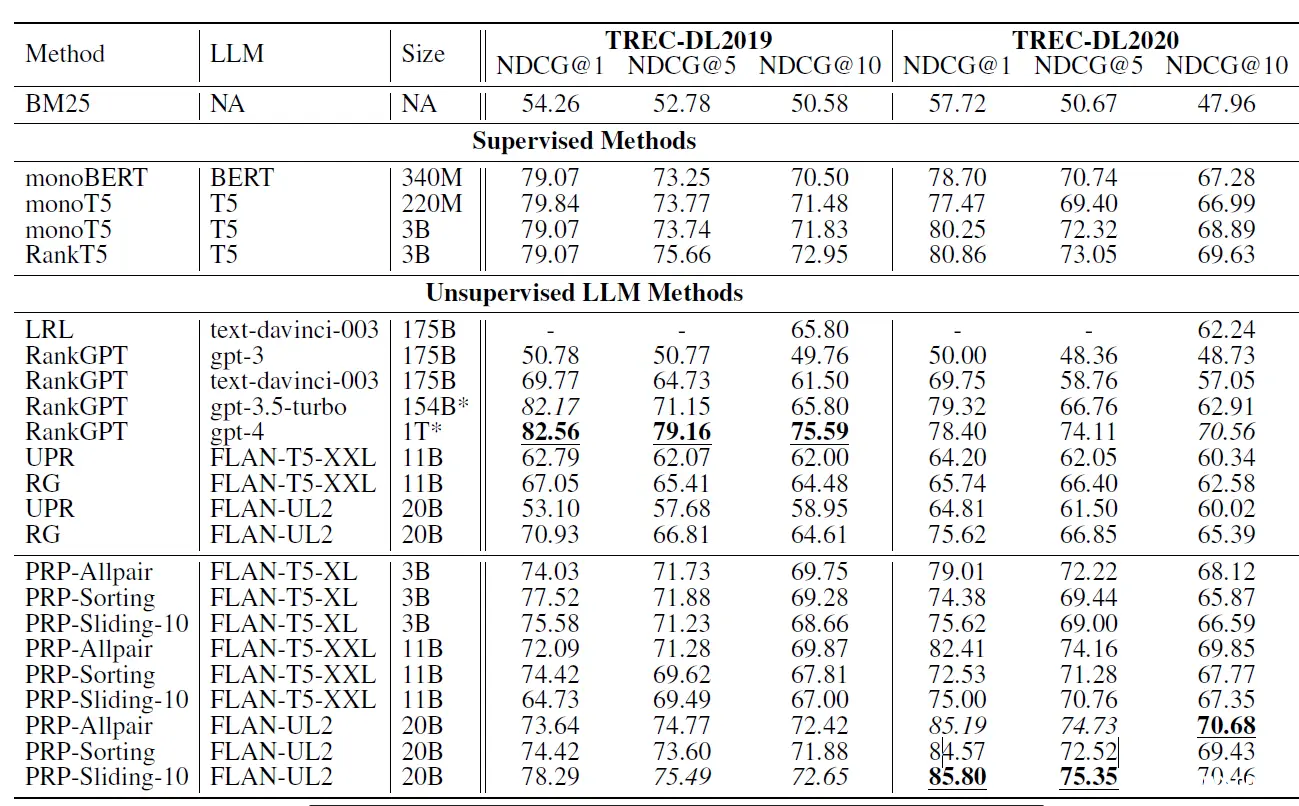

RAG这一章我们集中看下精排的部分。粗排和精排的主要差异其实在于效率和效果的balance。粗排和精排的主要差异其实在于效率和效果的balance。粗排模型复杂度更低,需要承上启下,用较低复杂度的模型...

随着大语言模型(LLMs)规模和复杂性的增长,寻找减少它们的计算和能耗的方法已成为一个关键挑战。一种流行的解决方案是量化,其中参数的精度从标准的16位浮点(FP16)或32位浮点(FP32)降低到8位或4位等低位格式。虽然这种方法显...

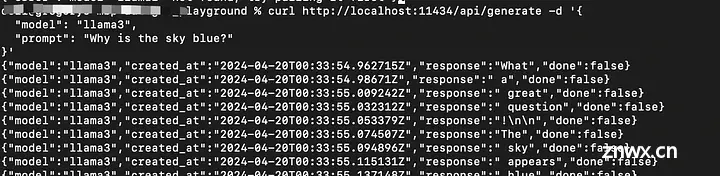

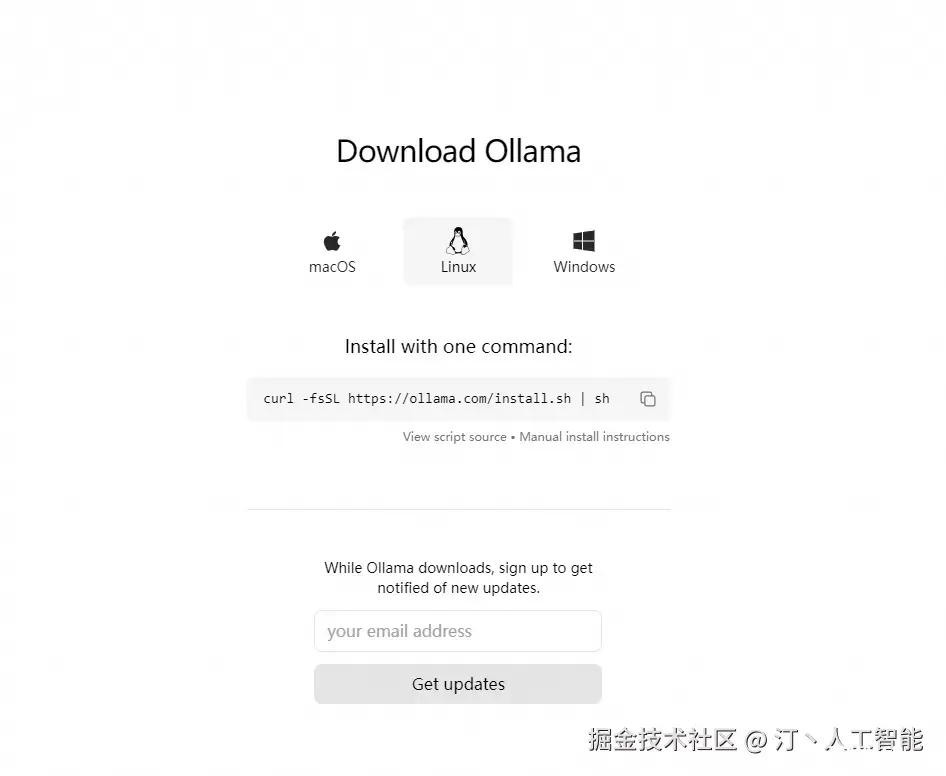

关注TechLead,复旦AI博士,分享AI领域全维度知识与研究。拥有10+年AI领域研究经验、复旦机器人智能实验室成员,国家级大学生赛事评审专家,发表多篇SCI核心期刊学术论文,上亿营收AI产品研发负责人。利用Ollama本地LLM(大语言模型)...

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。以下是其主要特点和功能概述:简化部署:Ollama目标在于简化在Docker容器中部署大型语言模型的过程,使得非专业用户...

我没找到好的解决办法,issue里说的情况都是在用源码安装后遇到的,我直接在干净环境ubuntu20.24cuda12.2下面pip安装,仍然遇到了问题。而且问题指向是torch里的class缺少属性,因此我猜测是to...

检查ninjaecho$?_vllm部署qwen2...

在上一篇博文中,我们使用Flask这一Web框架结合LLM模型实现了后端流式WebAPI接口,本篇将基于Vue3实现AI问答页面,本人习惯使用HBuilder进行前端页面的开发,当然各位网友可以选择自己喜欢的前端...

本文详细介绍了如何使用Streamlit构建大语言模型的Web界面,包括选择Streamlit的原因、应用流程、布局示例和一个简化版的聊天机器人示例。此外,还展示了如何在ChatGLM3-6B中应用Streaml...

本文尝试梳理。包括模型结构选择、数据预处理、模型预训练、指令微调、对齐、融合多模态以及链接外部系统等环节。目前主要有三种模型架构,基于Transformer解码器,基于GeneralLanguageModel,...

一、前言本文主要是在复现和实践Phi2-mini-Chinese后,简要分析下Phi2-mini-Chinese这个项目,做一个学习实战总结。原文发布于知乎:https://zhuanlan.zhihu.com/p/718307193,转载请注明出数。P...