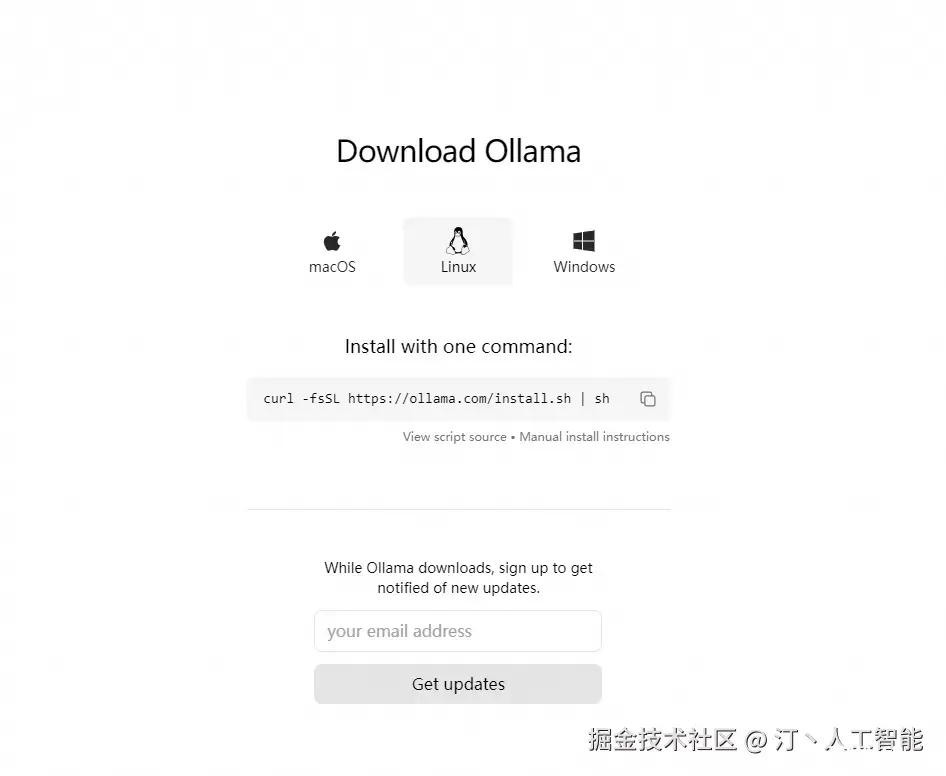

Ollama是一个开源项目,它使在本地机器上运行大型语言模型(LLM)变得简单且用户友好。它提供了一个用户友好的平台,简化了LLM技术的复杂性,使其易于访问和定制,适用于希望利用AI力量而无需广泛的技术专...

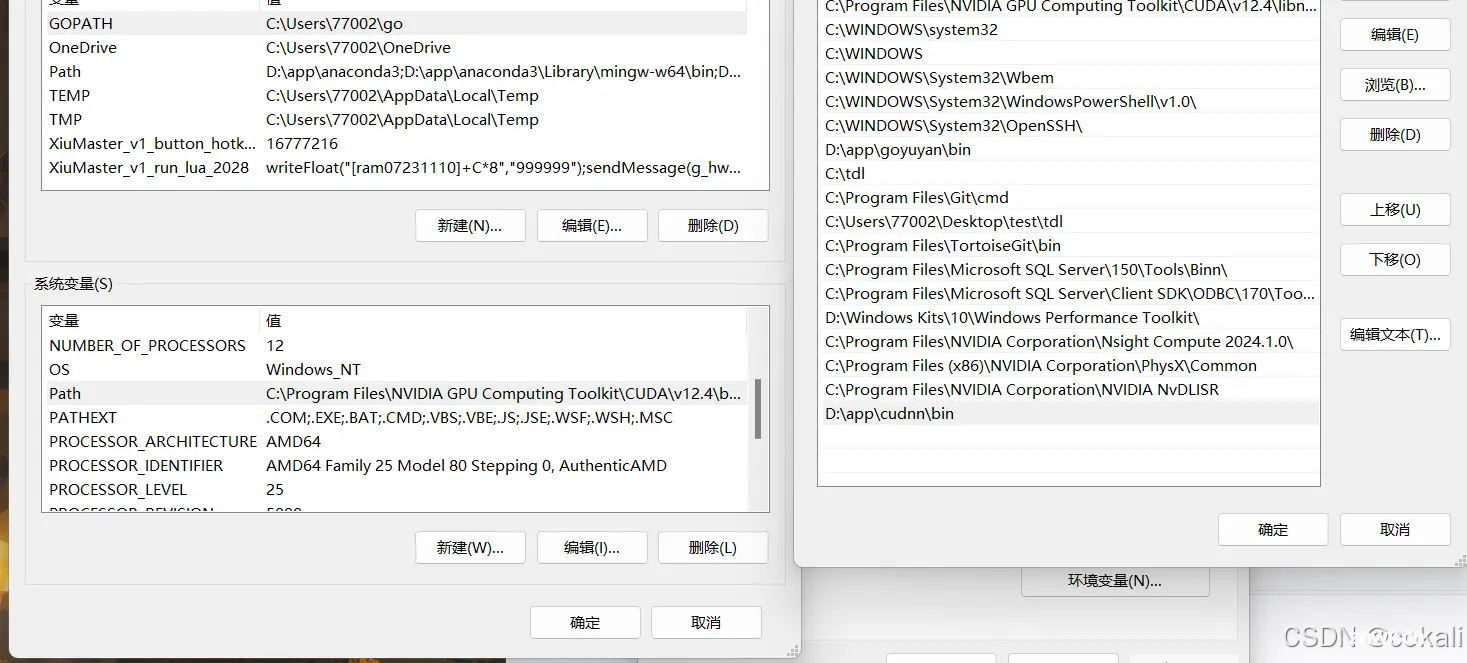

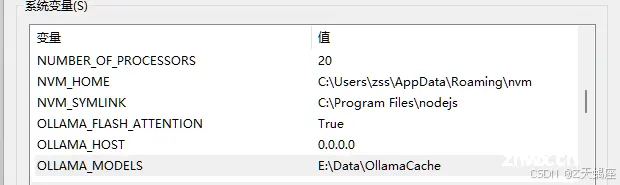

文章的主要目的是提供一个详细的指南,说明如何在Windows操作系统上安装和配置Ollama工具,以便用户能够在本地环境中轻松地部署和使用大型语言模型。帮助读者了解Ollama的基本功能,并提供实用的操作步骤,使他们能够有效地使用Olla...

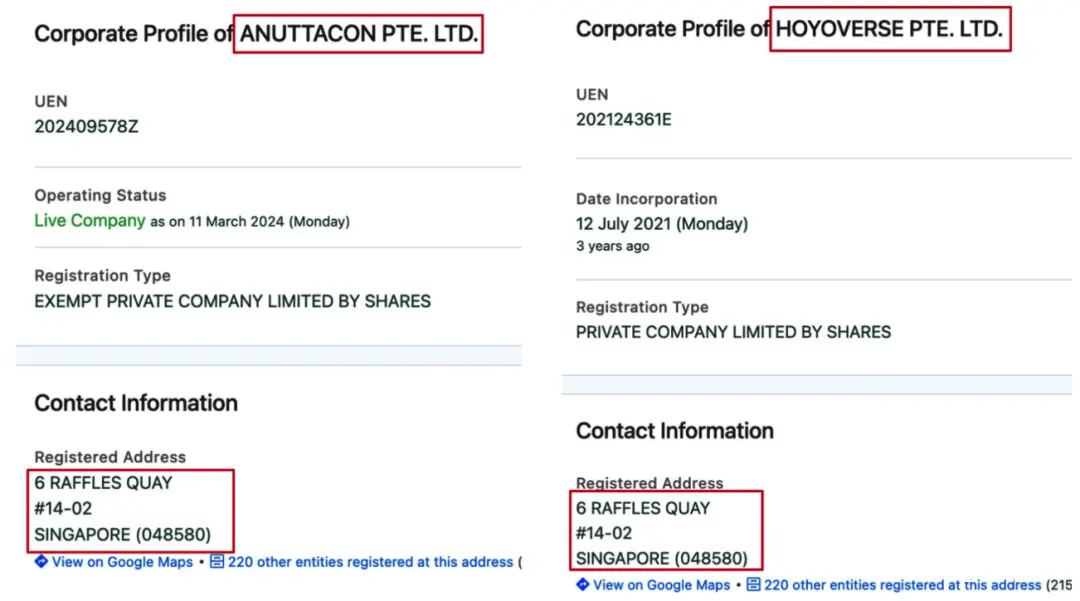

梦晨发自凹非寺量子位|公众号QbitAI米哈游创始人蔡浩宇,“退休”后新AI创业项目曝光,起因竟是他在网上发的一条“暴论”。AIGC已经彻底改变了游戏开发……大部分从业者可以考虑转行了。新公司名为Anu...

关注TechLead,复旦AI博士,分享AI领域全维度知识与研究。拥有10+年AI领域研究经验、复旦机器人智能实验室成员,国家级大学生赛事评审专家,发表多篇SCI核心期刊学术论文,上亿营收AI产品研发负责人。利用Ollama本地LLM(大语言模型)...

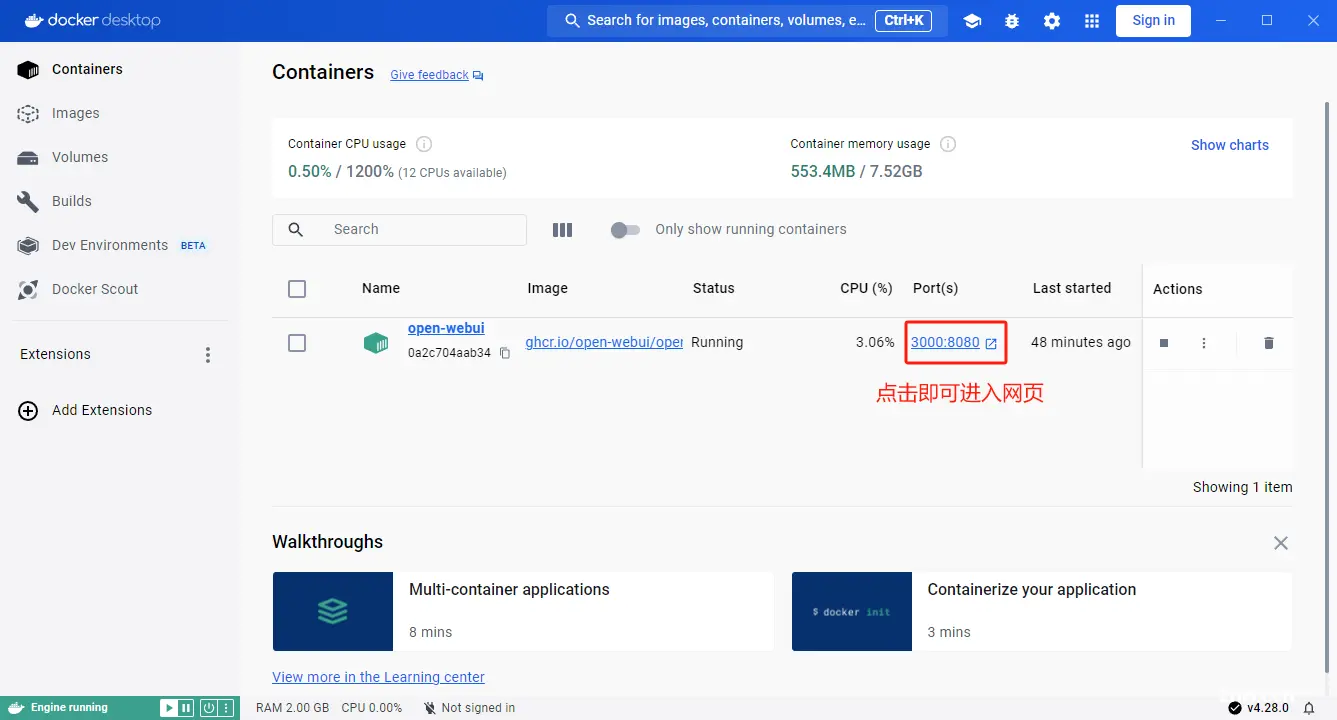

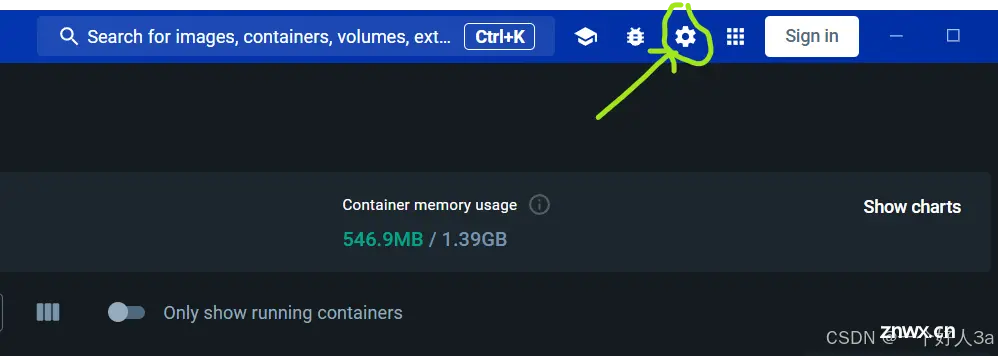

本人在刚好学习了docker的基本使用,又发现ollama这个在本地部署ai的项目正好可以用docker来部署。但我第一次部署本地ai时却收到了这个报错信息,我的电脑内存是32G的,却说我的系统只有1.4G,所以一...

ollama个人部署_16g显存可以运行ollama多大的模型...

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。以下是其主要特点和功能概述:简化部署:Ollama目标在于简化在Docker容器中部署大型语言模型的过程,使得非专业用户...

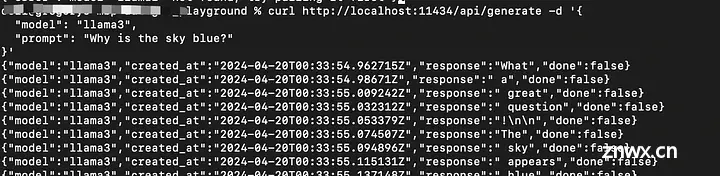

Ollama是一个基于Go语言开发的可以本地运行大模型的开源框架。Ollama提供了简单的命令行界面,使得用户能够轻松地下载、运行和管理大型语言模型,无需复杂的配置和环境设置。Ollama支持多种流行的语...

Ollama是一款可以开始使用本地的大型语言模型。启动并运行大型语言模型。运行Llama2、CodeLlama和其他模型。自定义并创建您自己的模型。Ollama提供了丰富的功能,包括模型的训练、部署、监控等。...

Ollama作为一款开源工具,为用户提供了便捷的本地大模型部署和调用方式,其卓越的兼容性和灵活性使得在多种操作系统上运行大规模语言模型变得更加简易。通过Docker的安装与部署,用户可以快速上手并灵活使用各类大型...