在Linux环境中,有多种方法可以查看CPU的型号和其他相关信息。一些常用的方法_linux查看cpu型号...

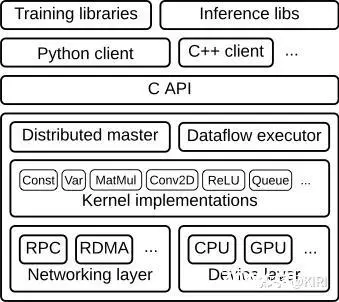

CPU(中央处理器)和GPU(图形处理单元)是计算机系统中最重要的两种处理器。它们各自的架构设计和技术体系决定了其在不同应用领域中的性能和效率。本文将详细分析CPU和GPU的架构,重点探讨它们在人工智能(A...

-tune:base|peak|all指定测试范围,只测base或peak,默认all全部测试。--copies:32,线程数。默认为config中设置。-n:1测试次数,默认是跑3次,如果想快速出结果可以...

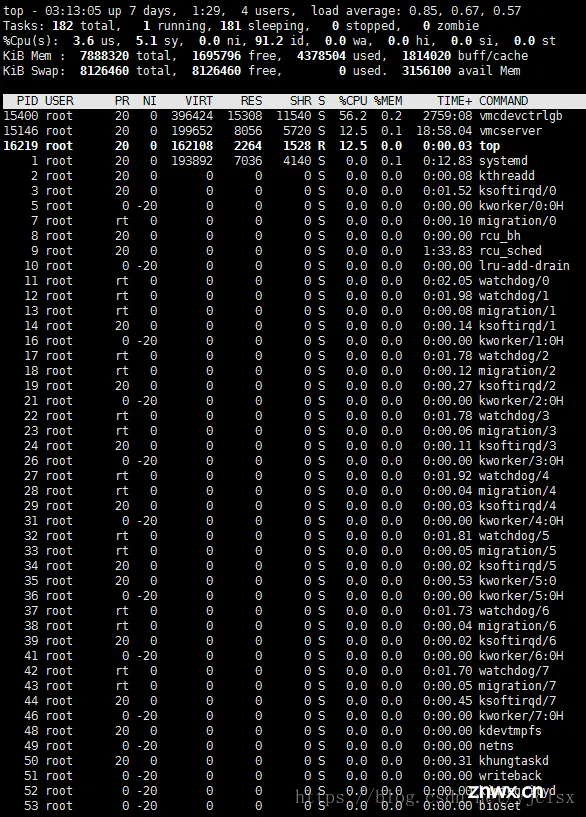

上述最后提到的缓冲的交换区总量,这里解释一下,所谓缓冲的交换区总量,即内存中的内容被换出到交换区,而后又被换入到内存,但使用过的交换区尚未被覆盖,该数值即为这些内容已存在于内存中的交换区的大小。-d:number...

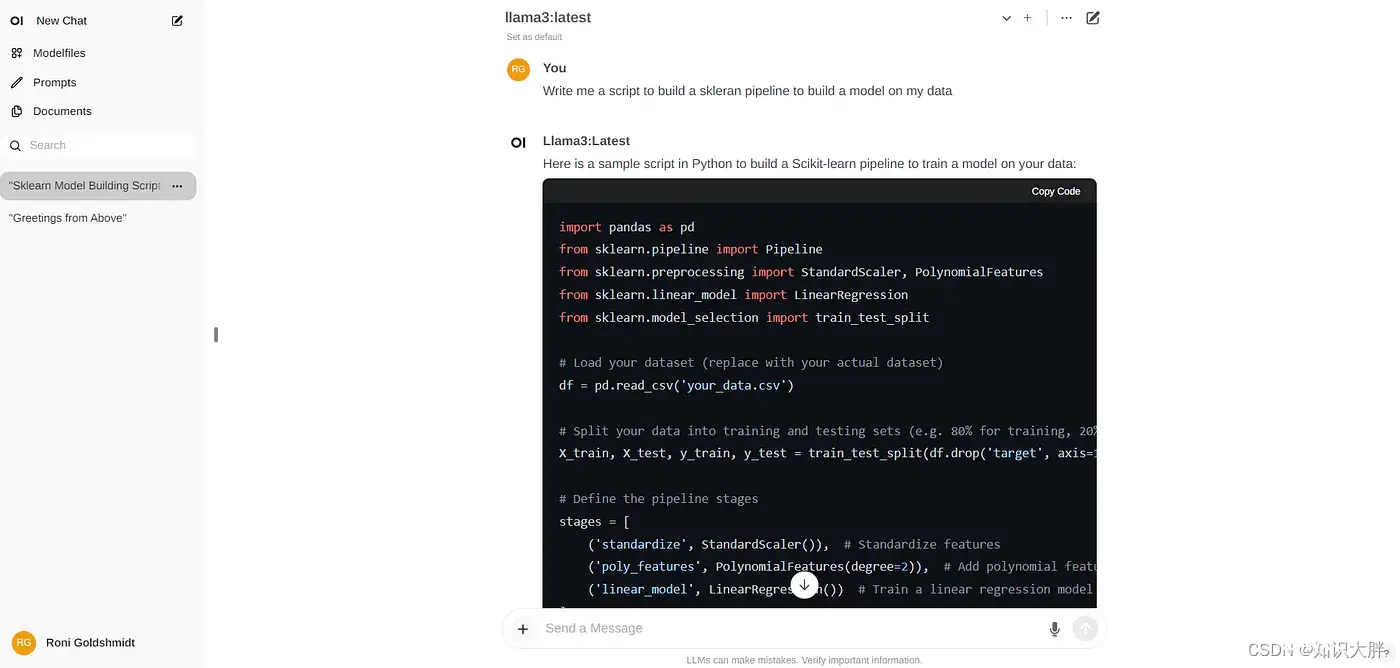

Ollama是一个强大的框架,专为大型语言模型的本地执行而设计。它提供了一种用户友好的方法来部署和管理人工智能模型,使用户能够直接从他们的机器运行各种预训练或自定义模型。Ollama的多功能性突出在于其全面的模型库,范围从较小的80...

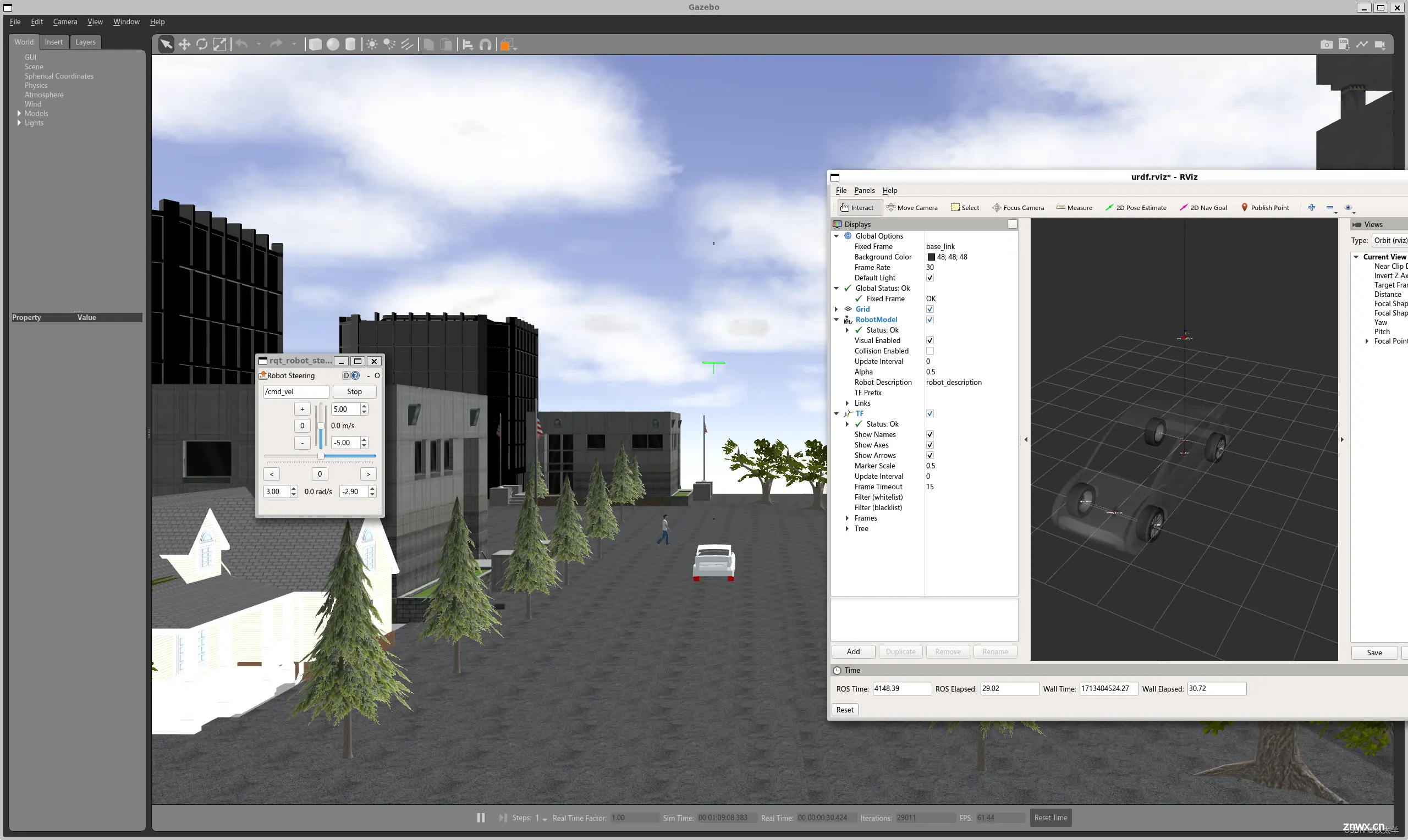

本文详细介绍了如何在Autoware.ai1.13版本中安装、配置Gazebo仿真环境,并解决了一个启动问题。步骤包括安装Vehicle_sim,设置传感器配置,如矢量地图和障碍物跟踪,以及本地化、路径规划等关键功能...

不高于不高于注意:具体情况还需要根据服务器的实际负载和应用场景来判断。物理内存长期高于80%可以考虑增加内存容量,或者优化应用程序对内存的使用。可以考虑降低内存容量,或部署更多的应用。长期高于80%这种情况建议可以...

2024年4月18日,meta开源了Llama3大模型[1],虽然只有8B[2]和70B[3]两个版本,但Llama3表现出来的强大能力还是让AI大模型界为之震撼了一番,本人亲测Llama3-70B版本的推理...

YOLOv8项目推理从CPU到GPU;YOLOv8;从CPU到GPU。_yololv8使用gpu...

算子开发在人工智能和机器学习领域扮演着重要角色,特别是在构建和优化神经网络模型时。以下是关于算子开发、AICPU算子、CANN算子、AscendC编程以及Cube计算单元、Vector计算单元和Scalar计...