ChatGLM3是智谱AI和清华大学KEG实验室联合发布的对话预训练模型。ChatGLM3-6B的基础模型ChatGLM3-6B-Base采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语...

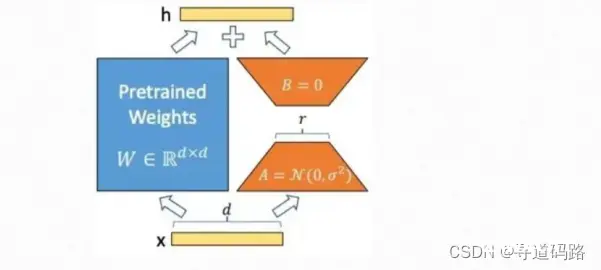

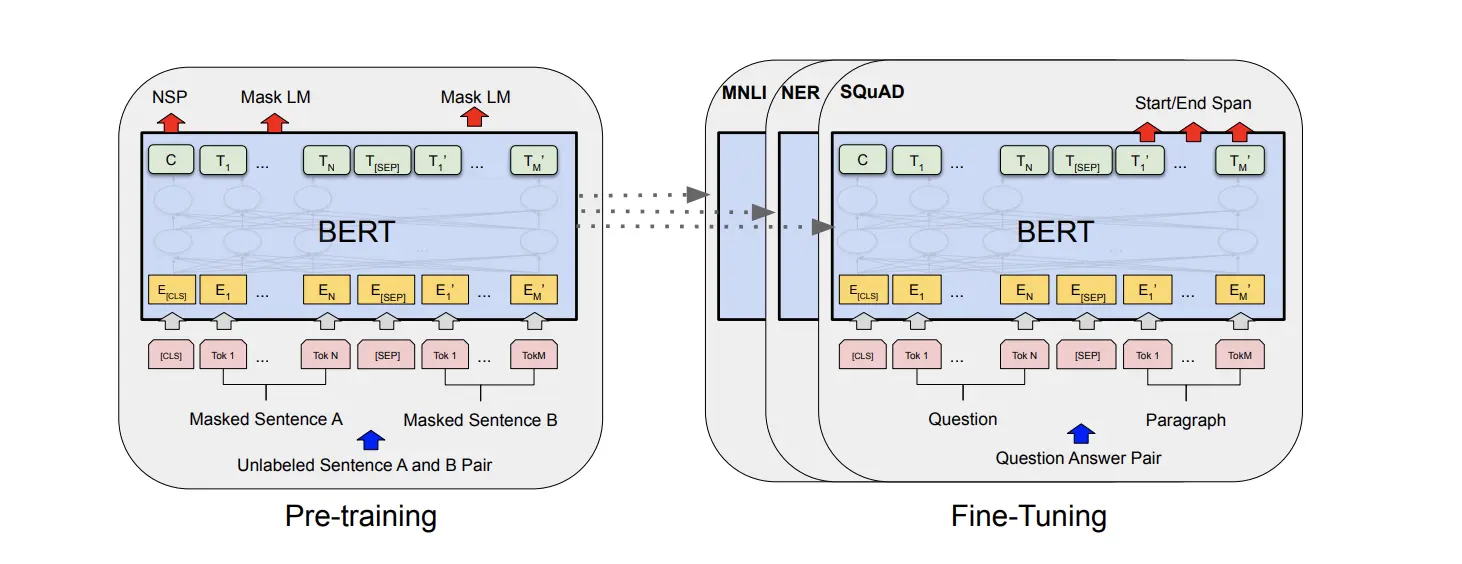

在自然语言处理领域,大语言模型的预训练-微调技术已经成为一种常见的方法。其中,LoRA(Low-RankAdaptation)是一种新颖的微调技术,通过引入低秩矩阵来调整模型的行为,以提高模型在新任务上的表现。...

人工智能大语言模型微调技术:SFT监督微调、LoRA微调方法、P-tuningv2微调方法、Freeze监督微调方法_loraptuningv2...

以上只是一个简洁的思路,如果有其他想法欢迎在评论区留言。...

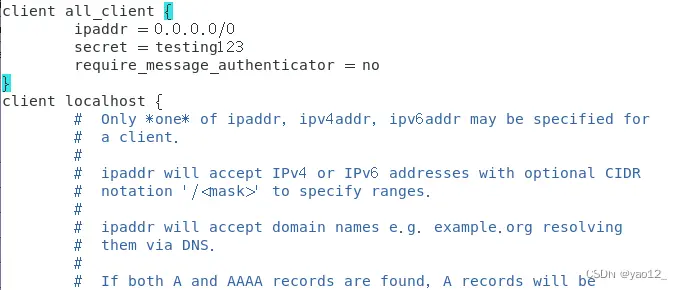

网上搜索和很多FreeRADIUS+Daloradiu实现Web管理的搭建案例,自己按照案例尝试搭建都没有成功,自己发现并解决了问题,因此将成功搭建的经验写下来帮助那些想要搭建的IT同行们。_daloradi...

本文详细介绍了如何在Linux系统上部署StableDiffusionWebUI,首先介绍了StableDiffusion和LoRA模型的基本概念,然后完成WebUI的下载、安装和配置。在部署过程中,作者分享了...

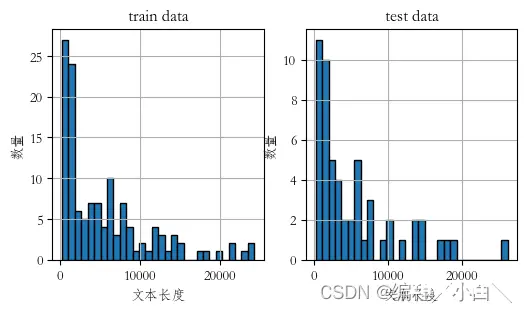

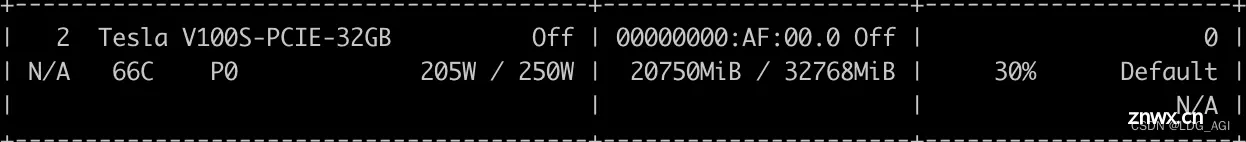

在课程前言我们也提到过,如果你直接开始训练,可能会不停的调整训练参数,比如素材图质量、数量、训练轮次等,一轮又一轮,一次又一次的不停调试,观察每一次的Loss损失函数值和其他数据,那么这就是一个耗费时间和精力以及...

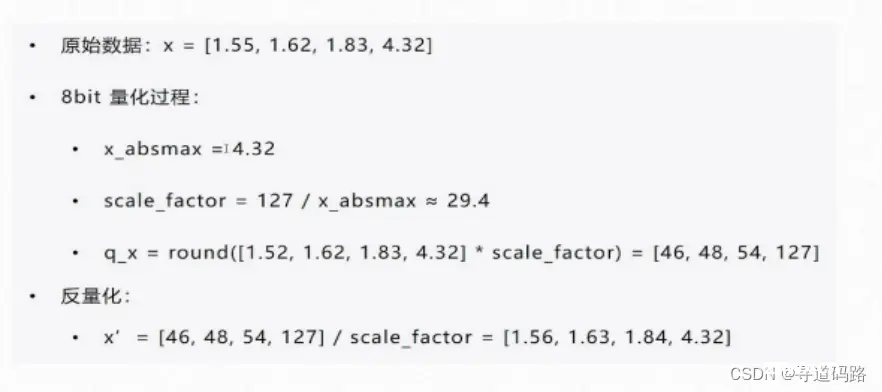

在深度学习的不断进步中,大型语言模型(LLMs)的预训练和微调技术成为了研究的热点。其中,量化技术以其在模型压缩和加速方面的潜力备受关注。本文将深入探讨QLoRA(QuantizedLow-RankAdap...

本文首先对量化和微调的原理进行剖析,接着以Qwen2-7B为例,基于QLoRA、PEFT一步一步带着大家微调自己的大模型,本文参考全网peft+qlora微调教程,一步一排坑,让大家在网络环境不允许的情况下,也...

centos7安装部署freeradius和daloradius实现web管理_freeradiusweb管理面板...