最近在玩LLM,听闻PAI-DSW有三个月免费试用,试了一下感觉还不错,就是有一些学习成本。刚通过vllm+open-webui成功部署了Qwen2.5-7B-Instruct,也是摸索了一段时间,记录一下以便需...

Ollama是一个基于Python的工具,专为本地调用大型语言模型而设计。它提供了用户友好的接口,使开发者能够在本地环境中快速加载和管理模型,简化了大模型的集成与使用流程。Ollama适用于各种应用场景,...

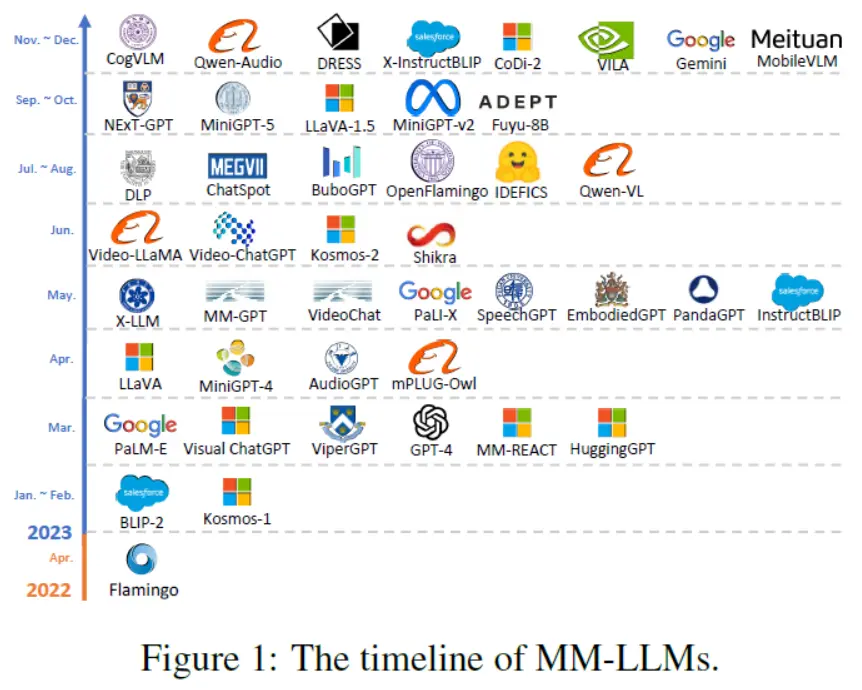

AI之MLM:《MM-LLMs:RecentAdvancesinMultiModalLargeLanguageModels多模态大语言模型的最新进展》翻译与解读目录《MM-LLMs:Recent...

LangChain的核心优势在于其能够轻松构建自定义链,这些链通常是线性的,类似于有向无环图(DAG),每个步骤都严格按顺序执行,每个任务只有一个输出和一个后续任务,形成一个没有循环的线性流程。_langchain...

vLLM是一个用于大语言模型服务的高性能框架。高吞吐量:通过优化的推理引擎,vLLM能够处理大量并发请求。低延迟:采用创新的调度算法,最小化请求的等待时间。兼容性:支持多种流行的语言模型,如GPT、LLaMA、OP...

最近在给我们的客户私有化部署我们的TorchV系统,客户给的资源足够充裕,借此机会记录下部署千问72B模型的过程,分享给大家!_qwen2-72b-instruct...

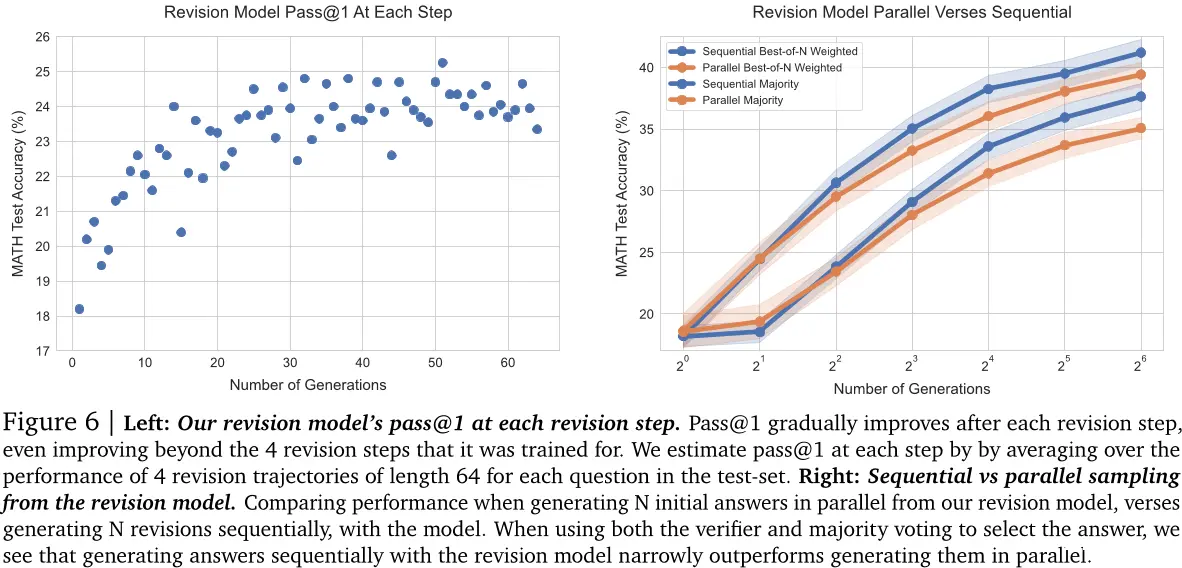

本文研究了如何在推理时利用额外计算资源来提高大型语言模型(LLM)的性能,并通过实验验证了这种方法的有效性。具体来说,作者提出了一个自适应的“最优计算”策略,可以根据问题难度动态地选择不同的测试时间计算方法,从而...

OpenAI推出了o1,这是一种通过强化学习训练的大型语言模型,专门用于进行复杂的推理任务。o1在回答问题之前会“思考”,能够在响应用户之前生成一条长的内部思维链。在编程竞赛问题(Codeforces)中,OpenAIo1的排名在89%分位,位列美国数学奥...

特定的ChatLanguageModel和StreamingChatLanguageModel实现(请参见“可观测性”列)允许配置ChatModelListener,用于监听以下事件:对LLM的请求LLM的响应错误这些事件包含的属性包...

我们为LLM确立了一个跨模型的统一工具调用API。有了它,你就可以在不同的模型上使用相同的代码,在Mistral、Cohere、NousResearch或Llama等模型间自由切换,而无需或很少需要根据模型更改工具调用相关的代码。此外,我们还在...