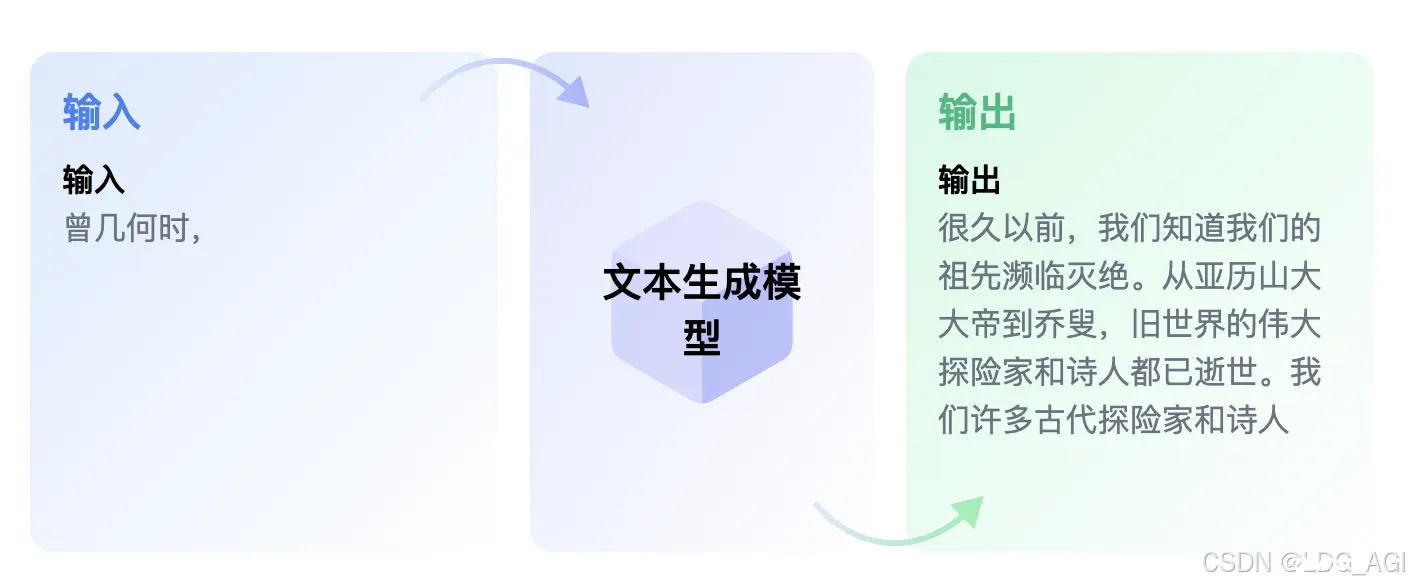

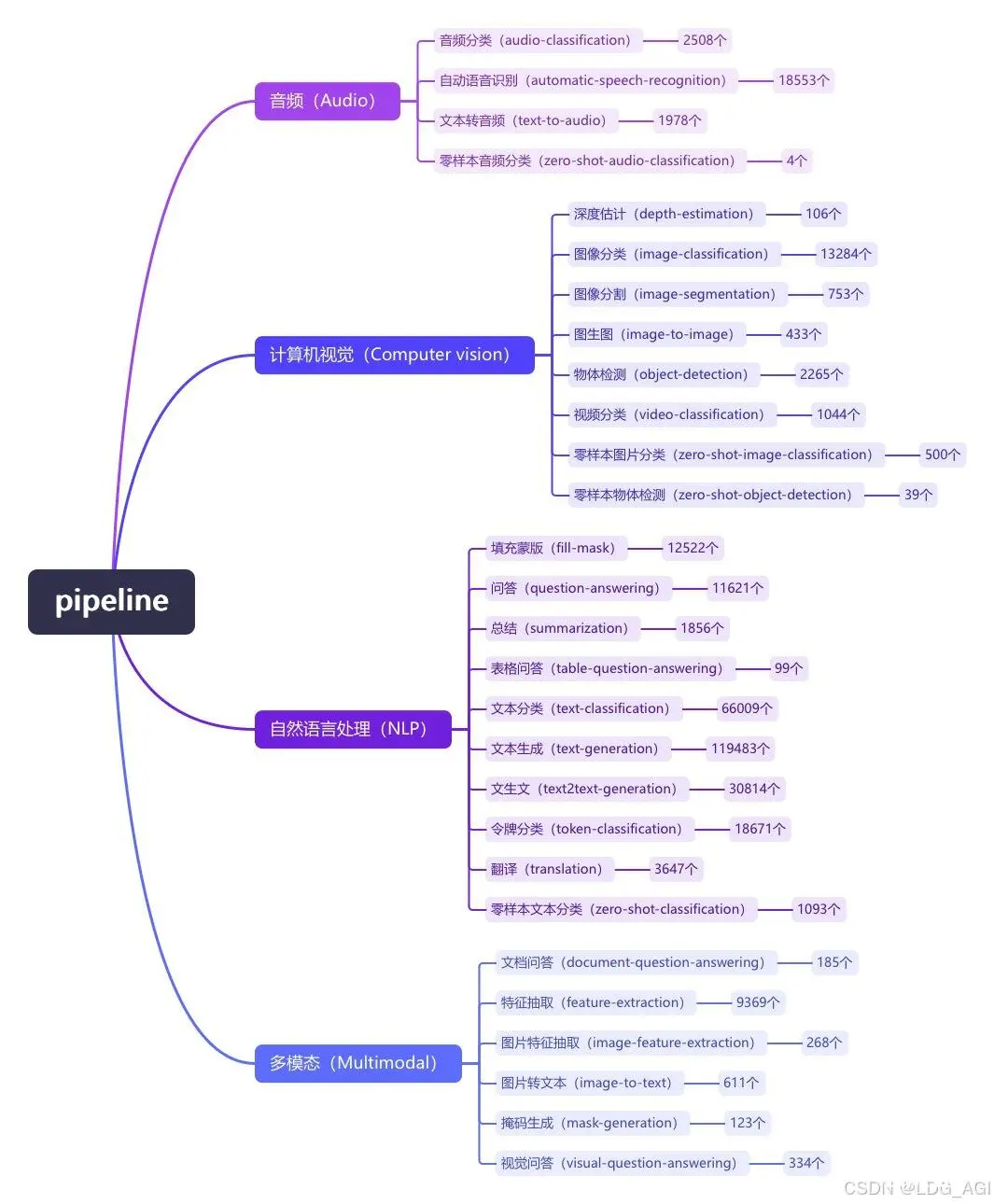

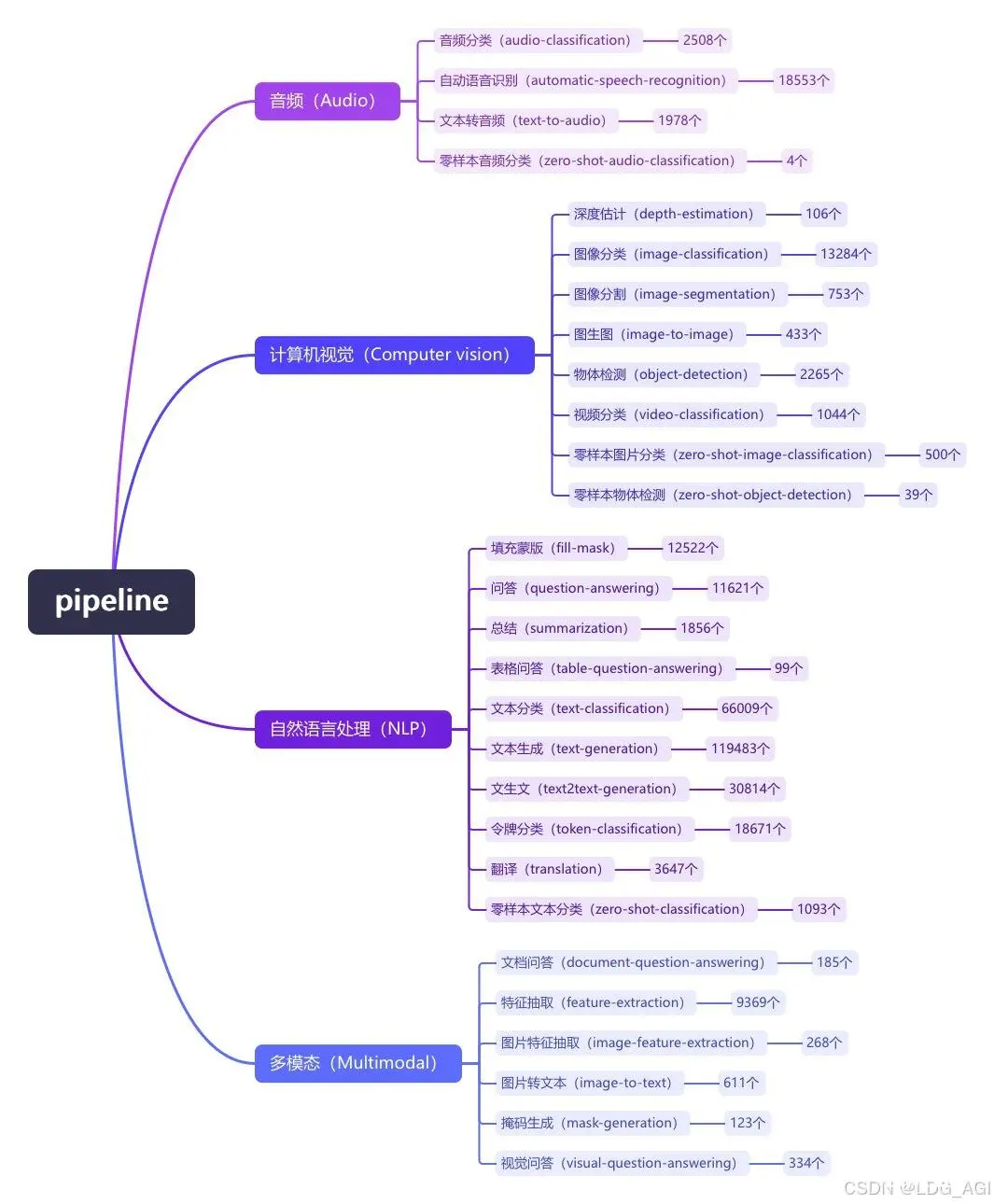

本文对transformers之pipeline的文生文(text2text-generation)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipelin...

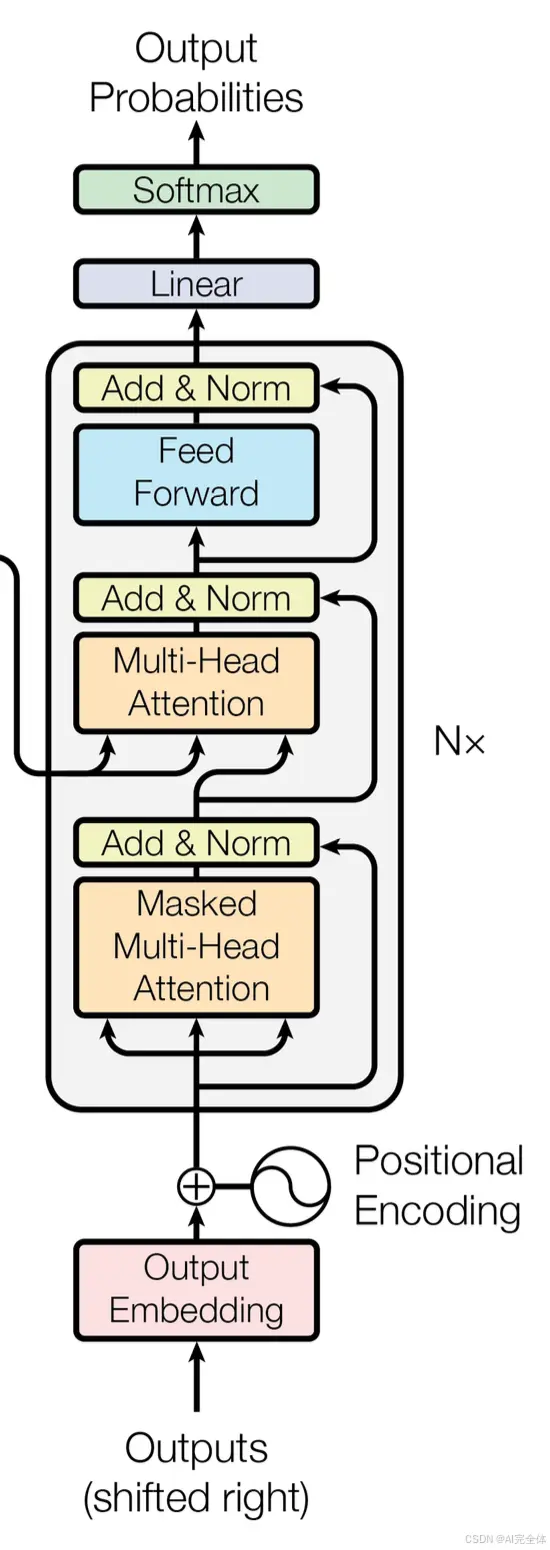

编码器部分:*由N个编码器层堆叠而成*每个编码器层由两个子层连接结构组成*第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接*第二个子层连接结构包括一个前馈全连接子层和规范化层以...

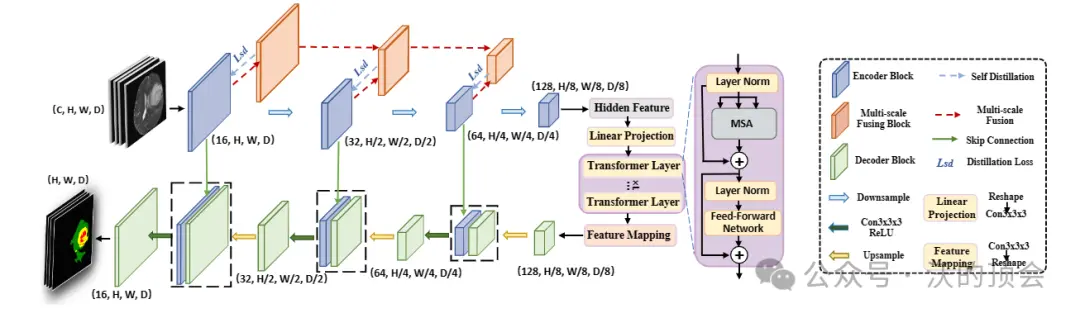

TransUnet是一种用于医学图像分割的深度学习模型。它是基于Transformer模型的图像分割方法,由AI研究公司HuggingFace在2021年提出。医学图像分割是一项重要的任务,旨在将医学图像中的不...

阅读Transformer论文并用Pytorch从头实现了简单的Transformer模型...

![[医疗 AI ] 3D TransUNet:通过 Vision Transformer 推进医学图像分割](/uploads/2024/09/17/1726549266226012434.webp)

医学图像分割在推进医疗保健系统的疾病诊断和治疗计划中起着至关重要的作用。U形架构,俗称U-Net,已被证明在各种医学图像分割任务中非常成功。然而,U-Net基于卷积的操作本身限制了其有效建模远程依赖关系的能力。...

在此框架内,CrossTransformer模块采用可扩展采样来计算两种模态之间的结构关系,从而重塑一种模态的结构信息,以与SwinTransformer同一局部窗口内两种模态的相应结构保持一致。在编码器...

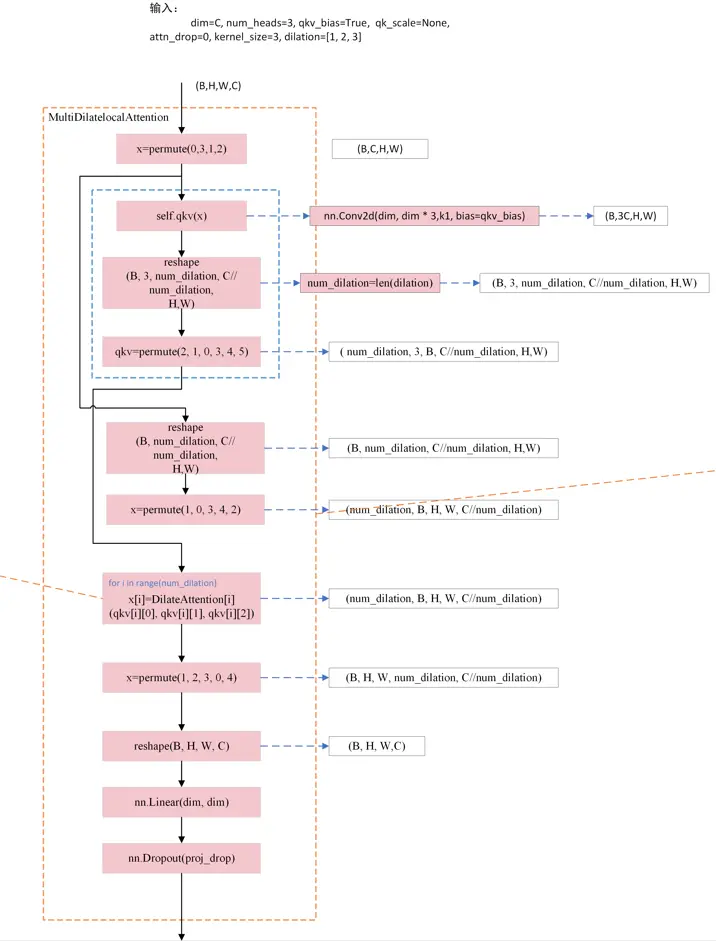

本文针对DilateFormer中的空洞自注意力机制原理和代码进行详细介绍,最后通过流程图梳理其实现原理。_multidilatelocalattention...

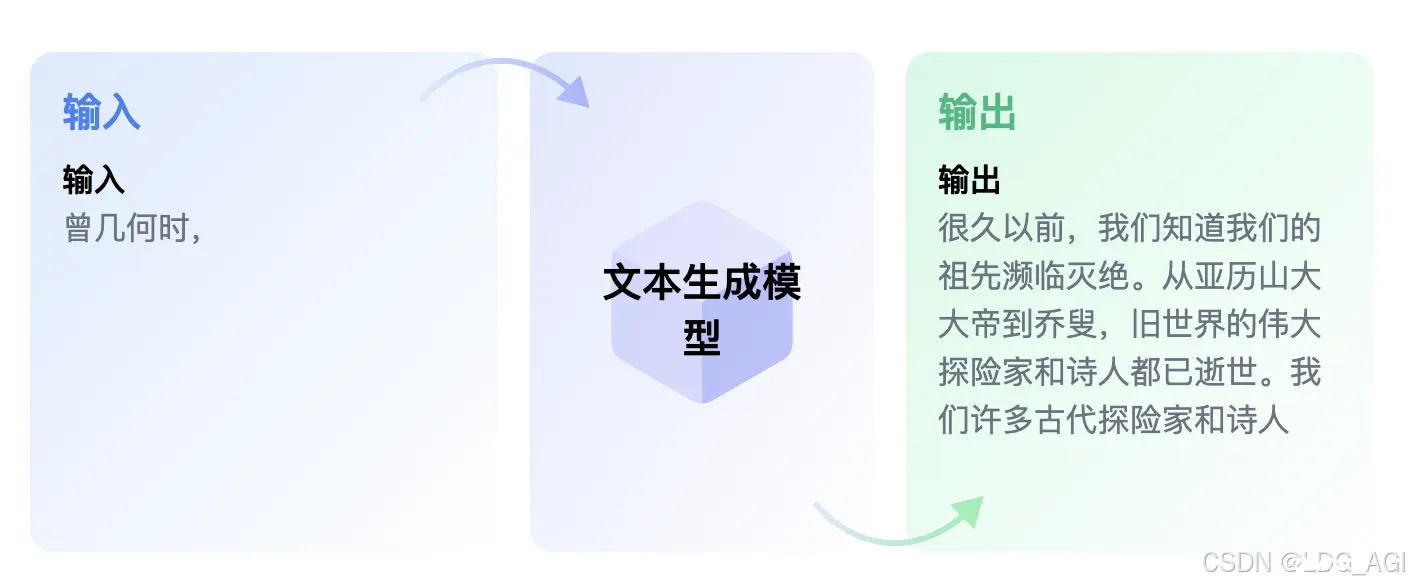

本文对transformers之pipeline的文本生成(text-generation)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文中...

本文对transformers之pipeline的文本分类(text-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline...

本文对transformers之pipeline的表格问答(table-question-answering)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipe...