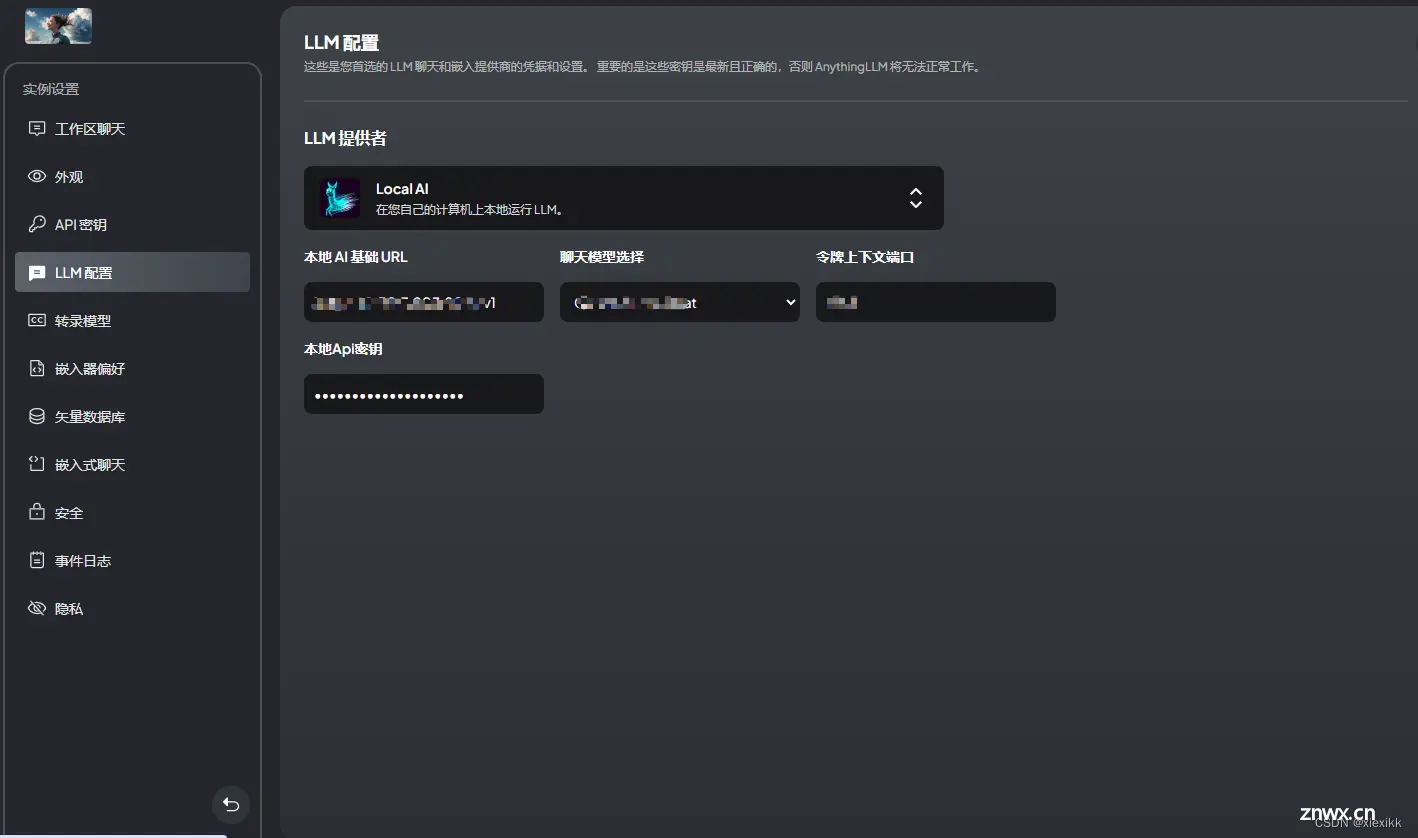

AnythingLLM是一个全栈应用程序,您可以使用商业现成的LLM或流行的开源LLM和vectorDB解决方案来构建私有ChatGPT,无需任何妥协,您可以在本地运行,也可以远程托管并能够智能聊天以...

IDC最新发布《AI大模型技术能力评估报告,2023》显示,百度文心大模型拿下12项指标的7个满分,综合评分第一,尤其是算法模型、通用能力等基础技术领跑全行业,算法模型获得唯一一个满分。据悉,今年峰会主论坛将对...

![[AI]如何让语言模型LLMs流式输出:HuggingFace Transformers实现](/uploads/2024/06/12/1718161271748053676.webp)

HugginFaceTransforms是一个非常方便的库,集成了非常多SOTA的模型,包含:LLAMA,GPT,ChatGLMMoss,等。目前基本上主流的方案都是基于HugginFaceTransf...

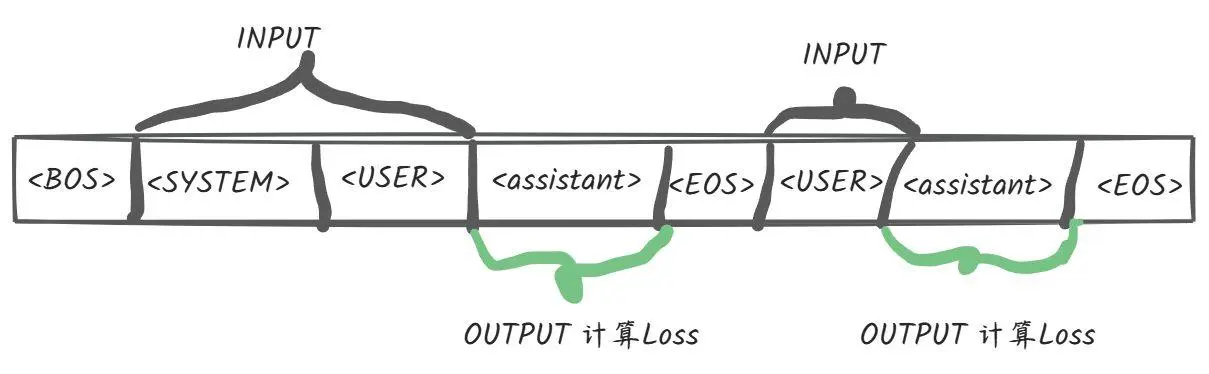

概述Github官方地址:GLM-4网上已经有很多关于微调的文章,介绍各种方式下的使用,这里不会赘述。我个人比较关心的是微调时的loss计算逻辑,这点在很多的文章都不会有相关的描述,因为大多数人都是关心如何使用之类的应用层,而不是其具体的底层逻辑,当然咱也...

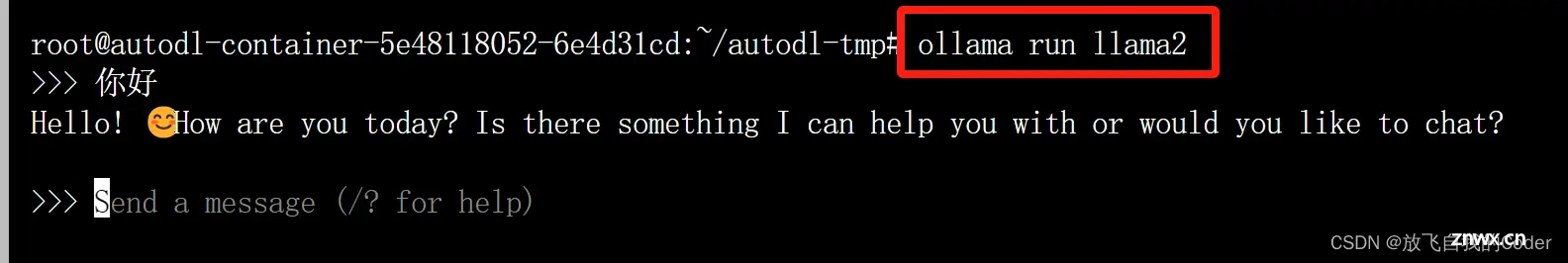

【linux使用ollama部署运行本地大模型完整的教程,openai接口,llama2例子】_ollamalinux...

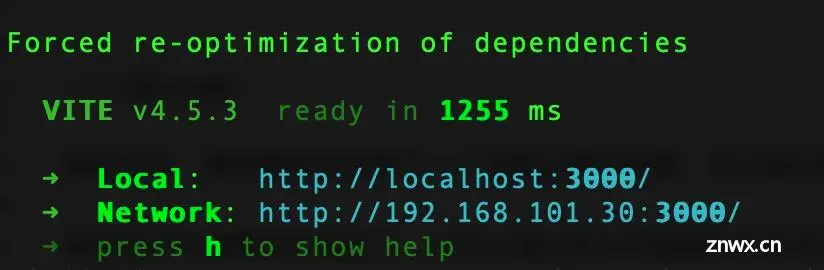

在上一篇博文中,我们在本地部署了**Llama38B**参数大模型,并用Python写了一个控制台对话客户端,基本能愉快的与Llama大模型对话聊天了。但控制台总归太技术化,体验不是很友好,我们希望能有...

部署一个私人AI模型涉及将训练好的模型应用到实际环境中,使其能够对外提供预测服务。下面是一个详细的部署教程,以Python环境、Flask作为Web服务框架、TensorFlow模型为例进行说明。假设您已经有一个...

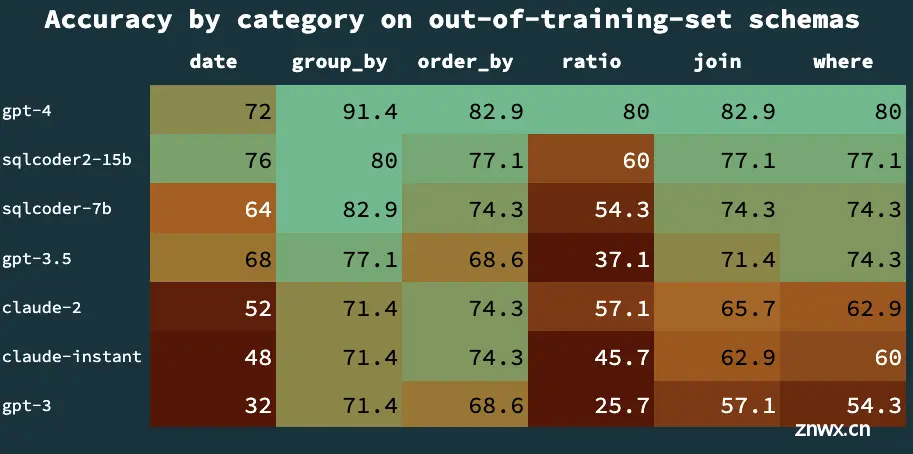

在AI的浪潮之巅,一款名为SQLCoder-7b的模型在huggingface上震撼发布,它不仅在文本转SQL生成上与GPT-4平分秋色,更在数据处理的速度和准确性上实现了惊人突破,甚至有超越GPT-4的势头。_...

本文对FacebookMetaAI最新提出的大语言模型LLaMA进行简单的介绍,以及对其开源出的代码和细节进行了详细的说明。_llama模型结构...

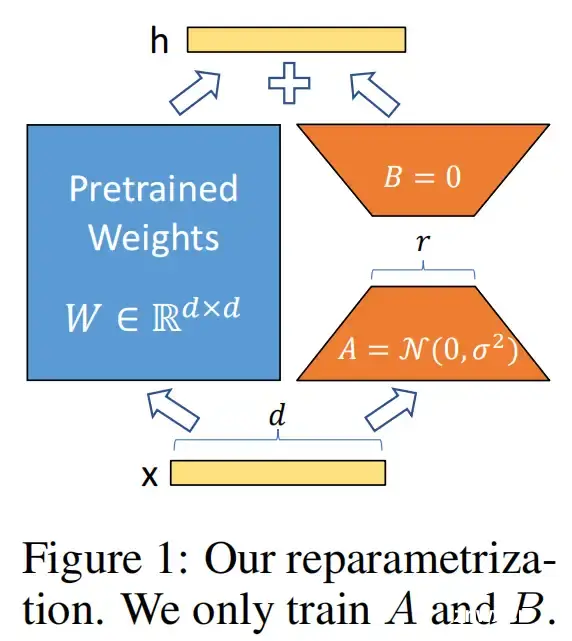

博客首发于我的知乎,详见:https://zhuanlan.zhihu.com/p/702629428一、LoRA原理LoRA(Low-RankAdaptationofLLMs),即LLMs的低秩适应,是参数高效微调最常用的方法。LoRA的本质就是...