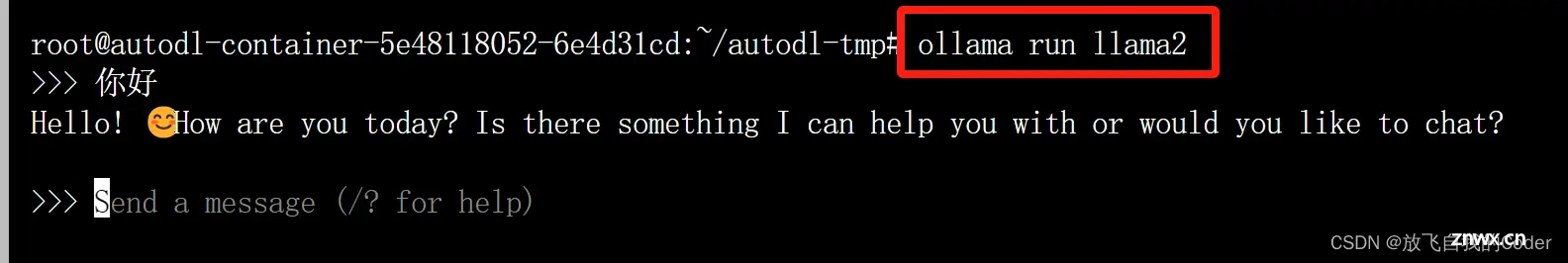

【linux使用ollama部署运行本地大模型完整的教程,openai接口,llama2例子】_ollamalinux...

在上一篇博文中,我们在本地部署了**Llama38B**参数大模型,并用Python写了一个控制台对话客户端,基本能愉快的与Llama大模型对话聊天了。但控制台总归太技术化,体验不是很友好,我们希望能有...

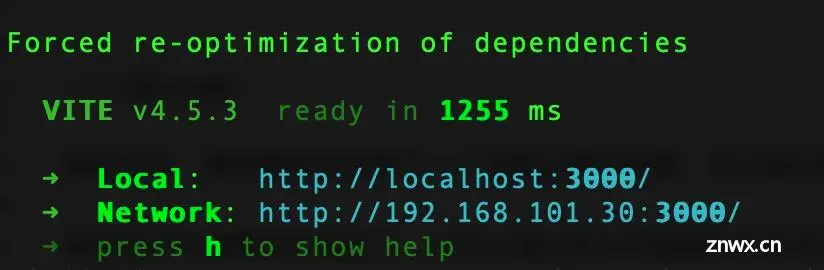

重命名镜像(如果是通过代理下载的)dockertagghcr.dockerproxy.com/open-webui/open-webui:mainghcr.io/open-webui/open-webui:...

ASR:funasr支持语音实时语音打断:这是通过子进程的控制创建与杀掉,这里是通过有人再次说话就打断tts参考:1)ASR(实时语音转录,支持自动vad识别)Pipe2)ollamaapi接口decode3)t...

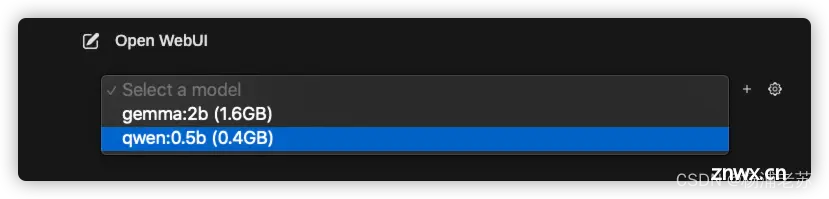

利用ollama和open-webui本地部署通义千问Qwen1.5-7B-Chat模型_ollama部署千问...

OpenWebUI是针对LLM的用户友好的WebUI。_openwebui...

ollama工具的出现让大语言模型的部署变得格外的轻松,但是在windows系统部署之后发现无法使用GPU进行加速,通过多方面查找资料发现可以在docker中使用命令启用GPU加速。另外通过Docker也可以快速...

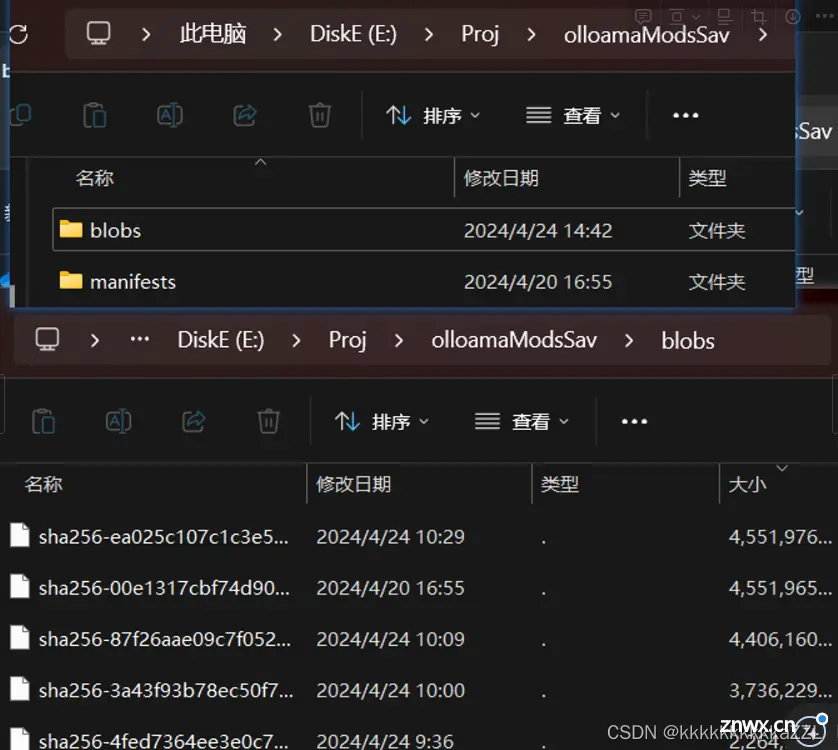

两个web框架都可以,先说简单的ollama-webui-lite()轻量级,只使用nodejs先装https://ollama.com/download新建文件夹E:\\Proj\\olloamaModsS...