Dify介绍:Dify是一款开源的大语言模型(LLM)应用开发平台。它融合了后端即服务(BackendasService)和LLMOps的理念,使开发者可以快速搭建生产级的生成式AI应用。即使是非技...

Meta创始人兼CEO马克·扎克伯格在博文中阐述了Llama开源AI的愿景,认为其有潜力成为AI领域的Linux。他表示,开源AI能满足不同组织的需求,提供数据保护和经济实惠的解决方案,避免被封闭供应商锁定。Meta...

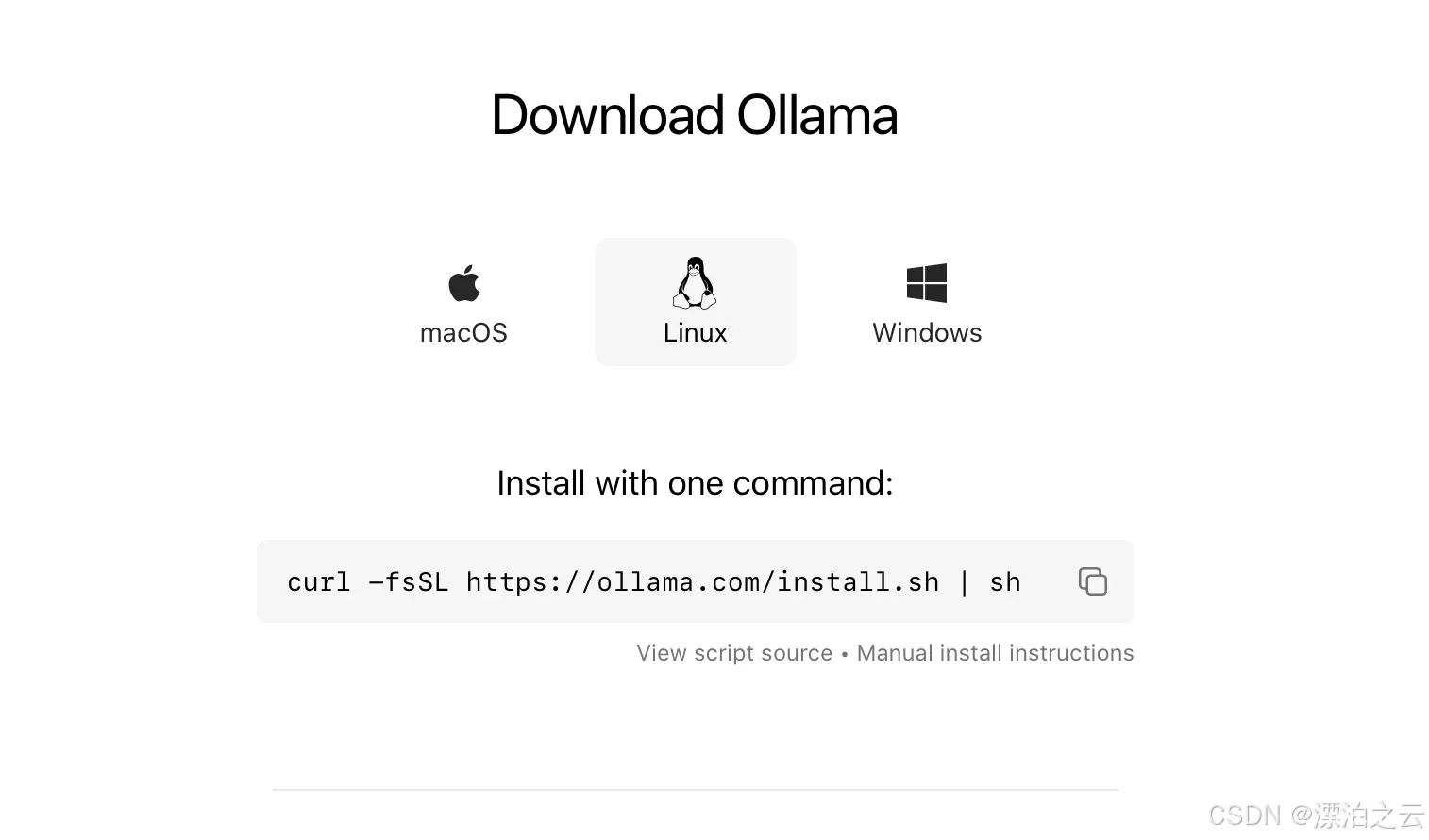

通过本文的步骤,您可以在Ubuntu系统上使用Docker轻松地运行Ollama。Ollama是一款强大的AI工具,可以帮助开发者在本地环境中运行和管理机器学习模型。本文将详细介绍如何在Ubuntu系统上使用Docker...

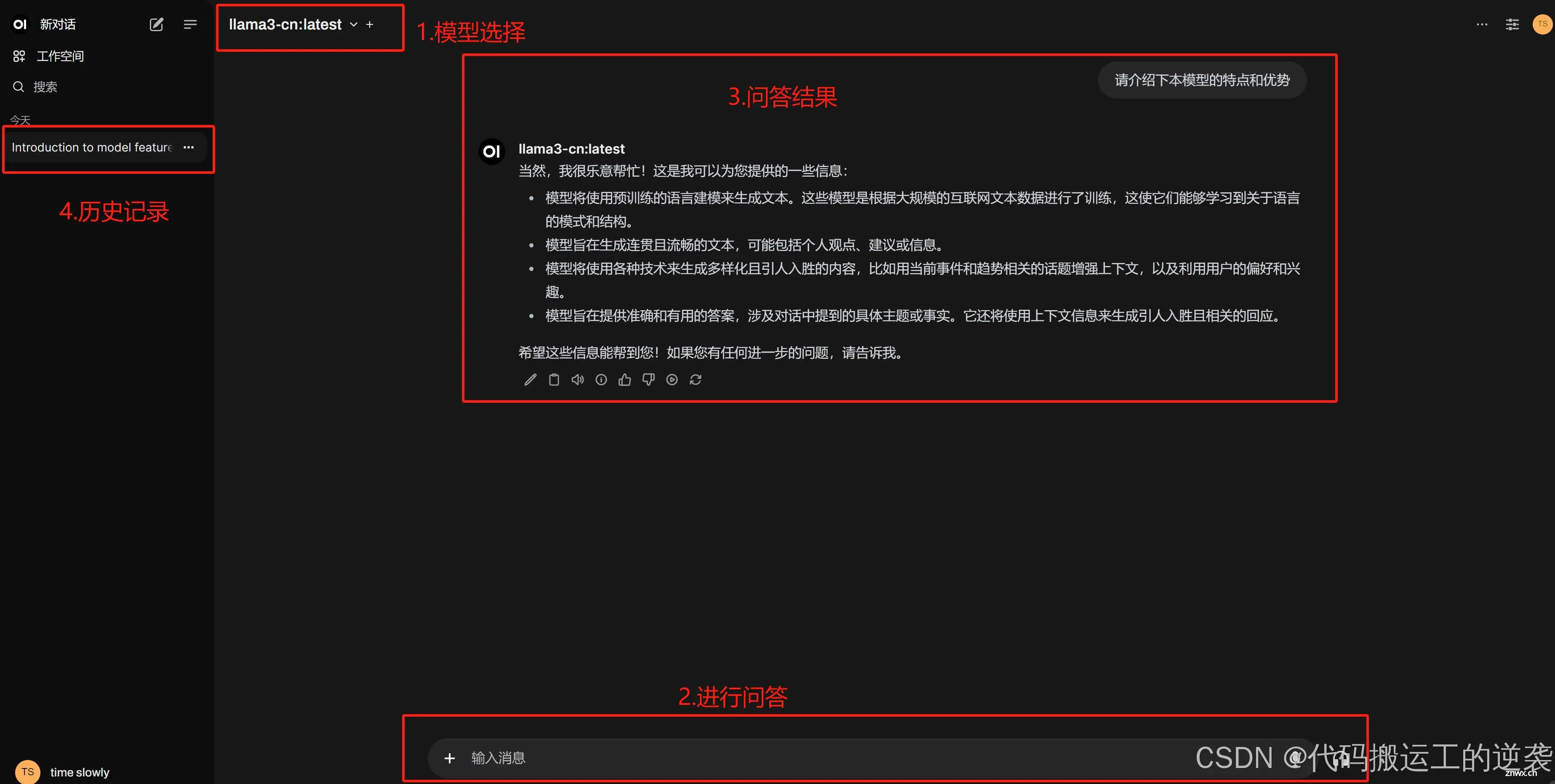

本教程主要关于开源AI大模型部署在个人电脑上,能够让用户轻松在本地运行大模型,这里的本地既可以指完全杜绝网络的个人PC,也可以指能够进行网络连接的PC...

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如Llama2。配置说明,该脚本会同时安装docker服务和ol...

事实上,AIAgent的研究还处于早期阶段,该领域还没有明确的定义。但是Astra和GPT-4o已经可以成为一个很好的早期示例了。NVIDIA高级研究员、AIAgent项目负责人JimFan表...

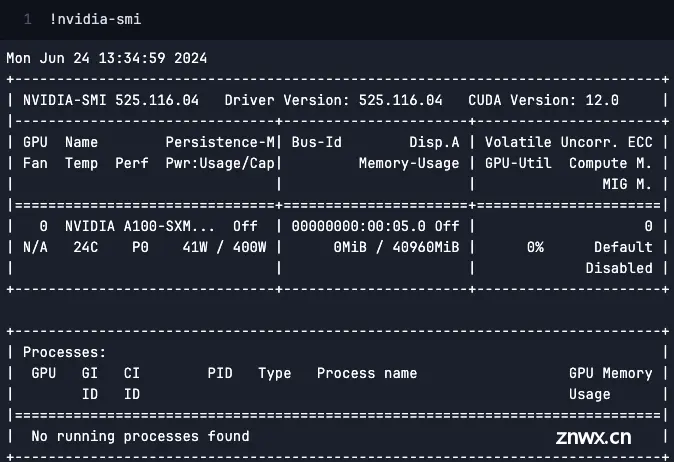

作者:运维有术星主随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀升。特别是对于需要处理大规模数据和复杂算法的AI大模型,GPU资源的使用变得至关重要。对于运维工程师而言,...

上次在MacbookPro上安装了StableDiffusion,体验了本地所心所欲地生成各种心仪的图片,完全没有任何限制的惬意。今天想使用MacbookPro安装一个本地大语言模型体验一下,刚好在2024...

本文主要介绍如何在Windows系统快速部署Ollama开源大语言模型运行工具,并安装OpenWebUI结合cpolar内网穿透软件,实现在公网环境也能访问你在本地内网搭建的大语言模型运行环境。近些年来随着...

就可以访问anythingLLM了。3.安装Enchanted。1.拉取镜像,终端执行。3.配置ollama。_anythingllmdocker...