【AI大模型】Ollama+OpenWebUI+llama3本地大模型

CSDN 2024-08-11 11:33:09 阅读 91

本地部署大模型

0.引言1.部署安装1.1部署工具1.2 概念介绍1.3 ollama安装后的基本使用1.4 大模型权重下载1.4.1 ollama在线下载1.4.2 huggingFace下载大模型权重及如何使用ollama进行调用

2.带有UI界面的使用3.参考

0.引言

(1)目的

本教程主要关于开源AI大模型部署在个人电脑上,能够让用户轻松在本地运行大模型,这里的本地既可以指完全杜绝网络的个人PC,也可以指能够进行网络连接的PC;

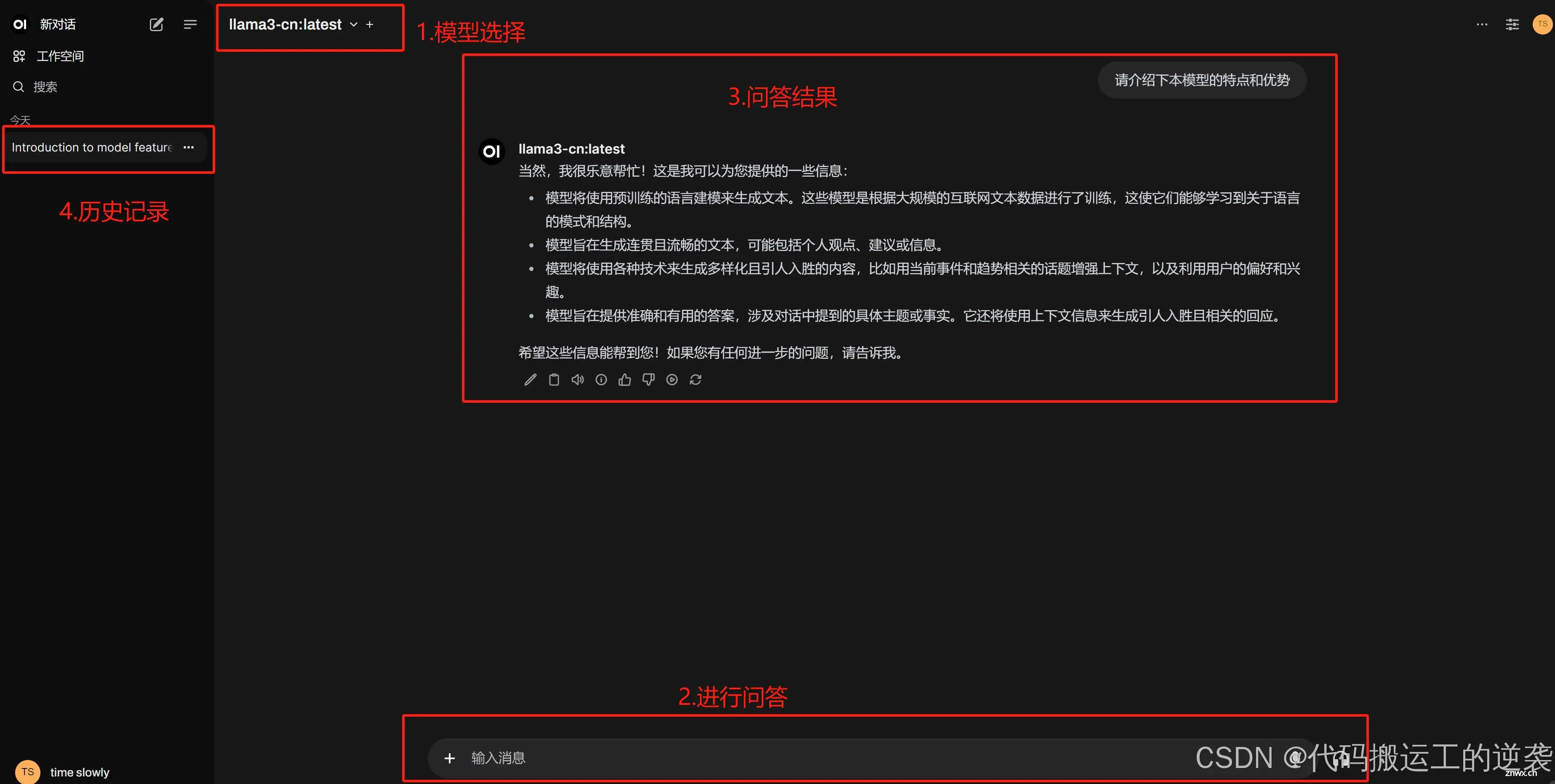

(2)部署后的使用预览

这里有两种使用方式,首先是cmd终端,其次是带有WebUI界面的;

1.部署安装

1.1部署工具

大模型管理工具:ollama;大模型权重:ollama(在线下载),huggingFace权重(主要GGUF格式)Web-UI(利用docker以及open-web-UI库进行web端使用大模型)

1.2 概念介绍

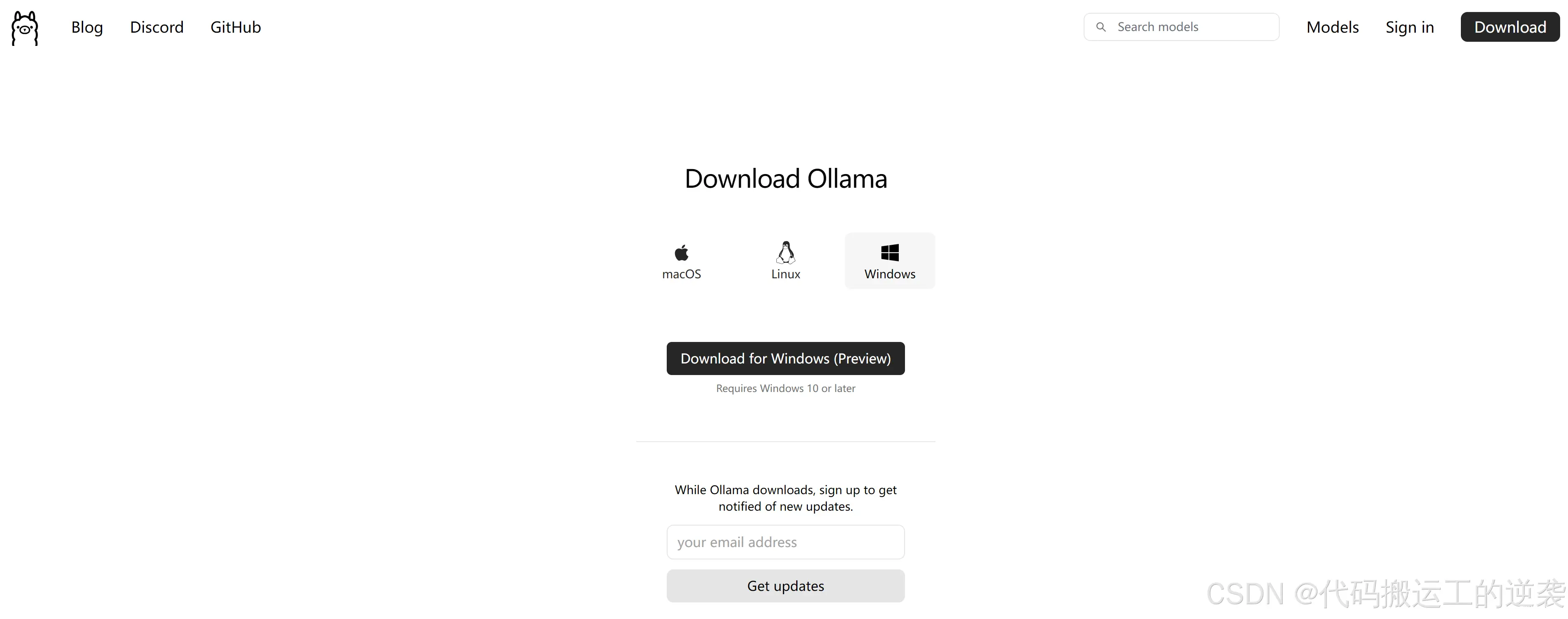

(1)什么是ollama以及ollama安装

重点是部署和管理,

本教程环境为win11系统,ollama在win系统就跟安装软件一样,下载ollama.exe文件进行安装即可 win安装地址,这里需要说明的是ollama.exe默认只能安装在C盘,但调用的大模型权重文件位置可以放在其它盘(详见后续教程)。

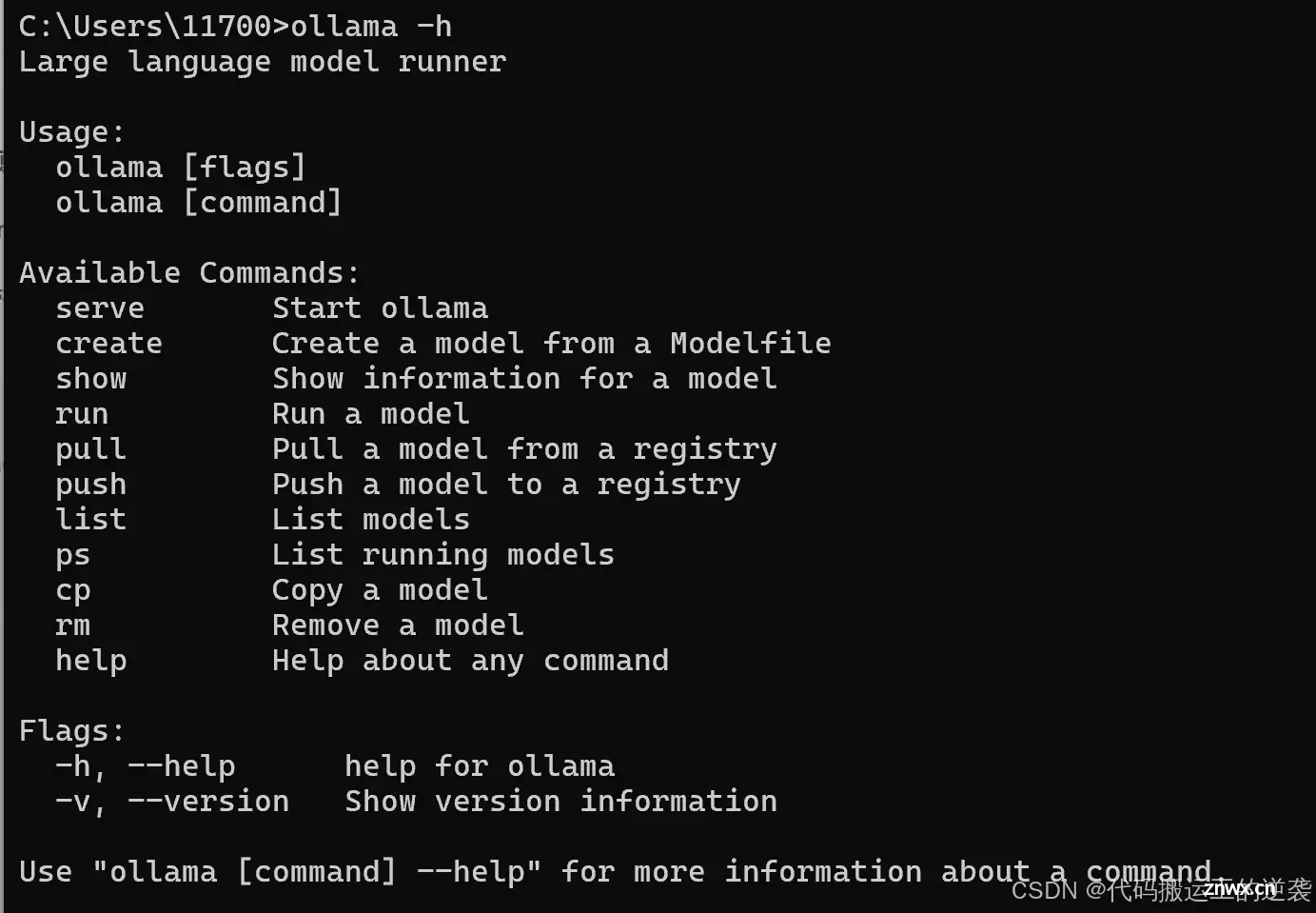

1.3 ollama安装后的基本使用

安装完成后可以在cmd终端查看使用(类似docker使用一样)

指令说明

<code>ollama -h# 查看ollama帮助使用

ollama list #查看已有大模型

ollama pull+大模型模型 #下载大模型

ollama run +大模型 # 运行大模型

ollama create +大模型配置文件 #ollama配置其它途径下载的权重文件,如huggingFace

ollama rm yi:8b #卸载yi:8b大模型

ollama cp yi:

#ctrl+d退出

1.4 大模型权重下载

常用的模型如llama3,通义千问(qwen)等部分模型权重可以通过两种方式下载:

ollama在线下载:ollama模型地址huggingFace下载:huggingFace网站镜像,受限与国内网络,huggingFace需要梯子官网链接,这里的网站镜像功能跟官网一样,不需要梯子。

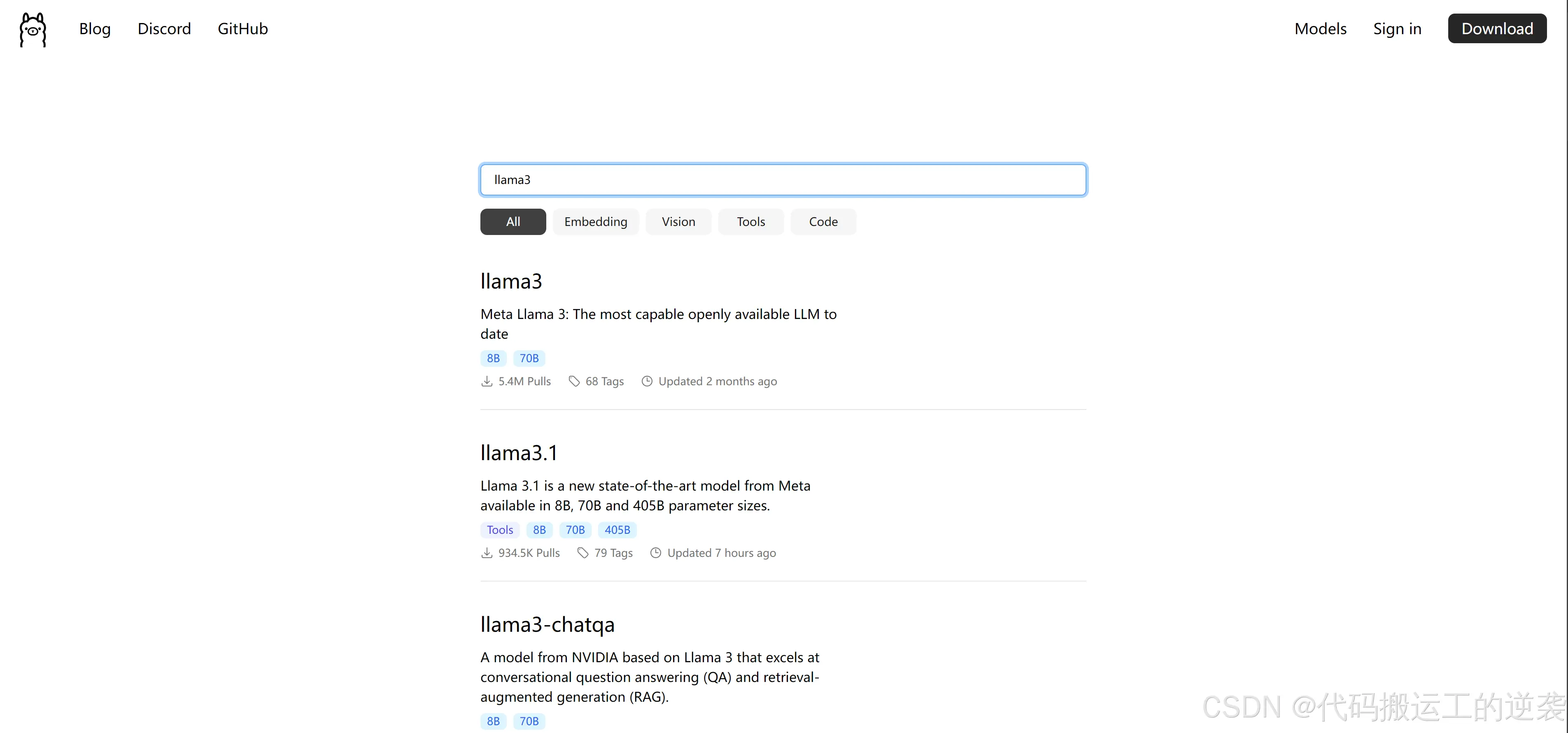

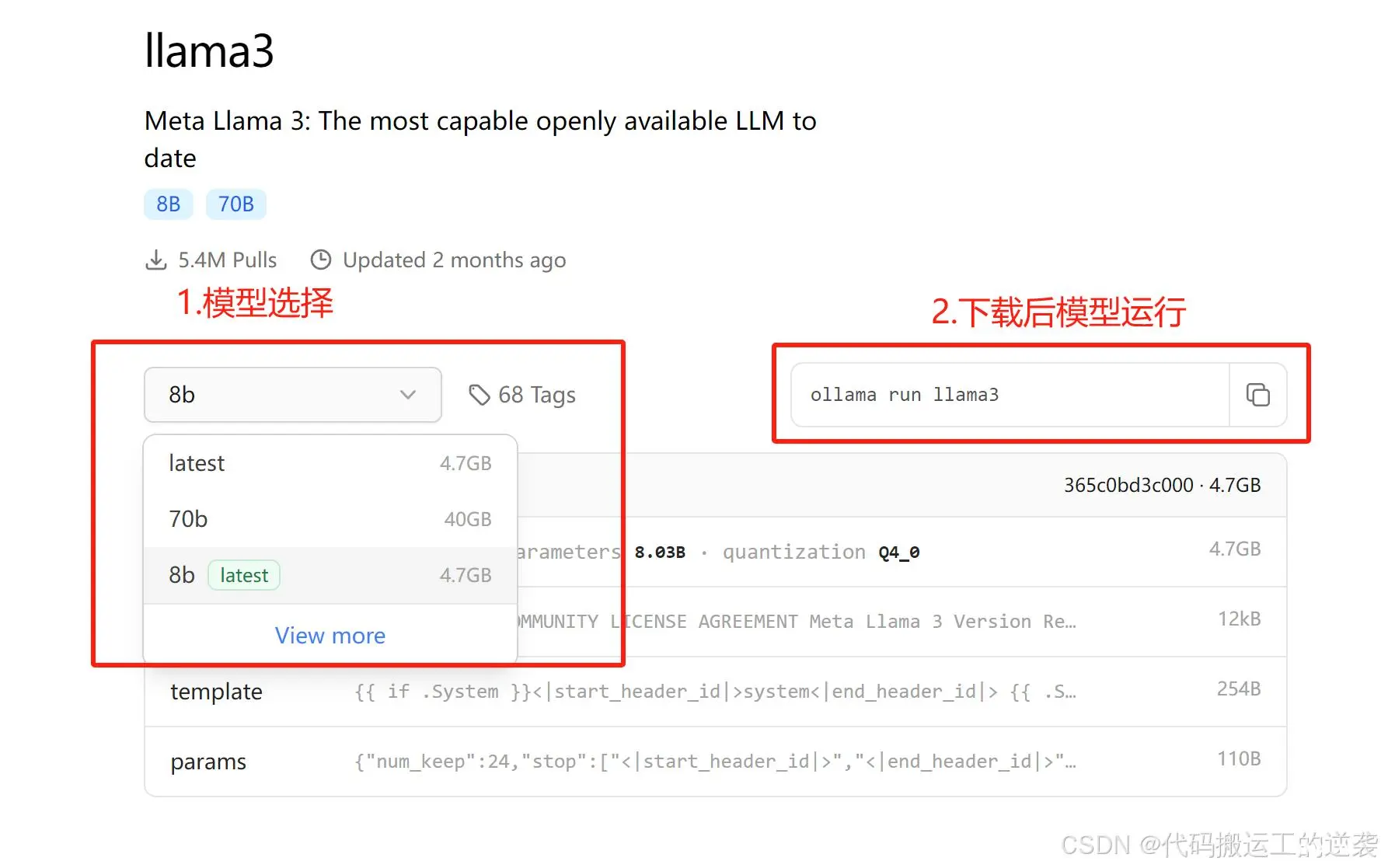

1.4.1 ollama在线下载

在ollama网站中models,利用cmd终端命令进行下载:ollama pull llama3:8b

下载完成后cmd终端查询已有大模型命令:ollama list

运行使用:ollama run llama3:8b

1.4.2 huggingFace下载大模型权重及如何使用ollama进行调用

(1)首先是模型权重下载

如何从hugging Face官网下载大模型权重,参考本链接教程:huggingFace模型权重下载教程

需要注意的是:推荐下载大模型格式为gguf或者GGUF,因此这里在搜索大模型时,最好加上gguf,如下图

(2)huggingFace下载的大模型如何配置使用

下载到本地的模型文件不能直接导入到Ollama,需要编写一个配置文件,随便起个名字,如config.txt,配置文件内容如下

<code># 主要是FROM需要改成自己从hugging face上面下载的路径

FROM "/Users/liaoxuefeng/llm/llama3-8b-cn-q6/Llama3-8B-Chinese-Chat.q6_k.GGUF"

TEMPLATE """{ {- if .System }}

<|im_start|>system { { .System }}<|im_end|>

{ {- end }}

<|im_start|>user

{ { .Prompt }}<|im_end|>

<|im_start|>assistant

"""

SYSTEM """"""

PARAMETER stop <|im_start|>

PARAMETER stop <|im_end|>

最后cmd调用命令:

ollama create llama3-cn -f ./config.txt #即可将下载的模型导入ollama中

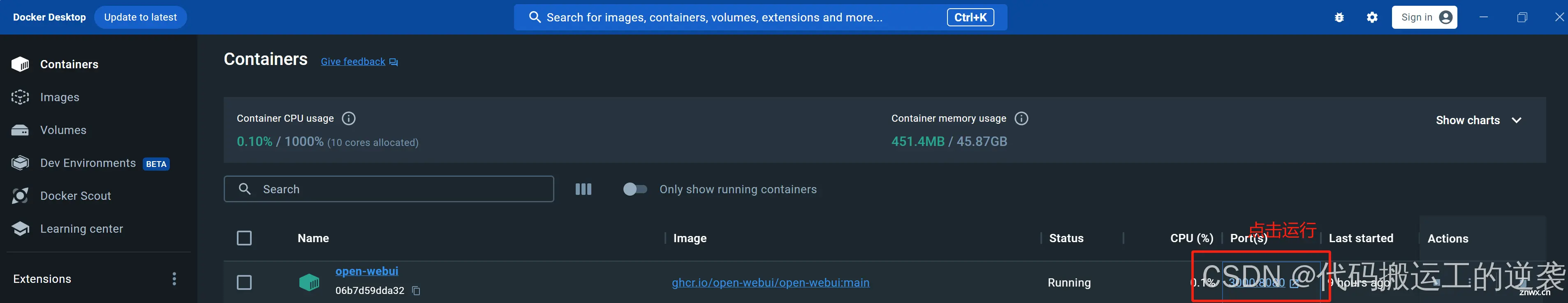

2.带有UI界面的使用

这里主要安装不管是大模型还是stableDiffusion文生图等常用的网页交互库:open-webUI

,安装webUI需要先安装docker ,然后利用docker安装webUI并运行。

(1)具体安装教程

参考链接教程的第3部分docker以及webUI安装

部署后使用:在docker 容器点击进入,见下图

(2)注意!!!

此外关于链接教程的3.4 离线部署部分重点!!!!

3.参考

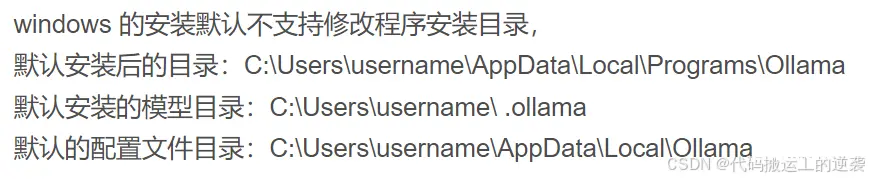

(1)ollama的默认路径地址

(2)未完待续

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。