当遇到`org.yaml.snakeyaml.error.YAMLException:java.nio.charset.MalformedInputException:Inputlength=`错误时,通常是由于YAML文件的编...

就在昨天1024程序员节,JetBrains突然宣布WebStorm现在对非商业用途免费啦。以后大家再也不用费尽心思的去找破解方法了,并且公告中的关于非商业用途定义也很有意思。...

本文对transformers之pipeline的令牌分类(token-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipelin...

因为在Transformer的编码器结构中,并没有针对词汇位置信息的处理,因此需要在Embedding层后加入位置编码器,将词汇位置不同可能会产生不同语义的信息加入到词嵌入张量中,以弥补位置信息的缺失....

非常的麻烦,而且浏览器中对变量的追踪功能也有限,同时我也一直好奇WebStorm中Debug启动方式的作用,今天研究了一下,果然WebStorm提供了更简单的方法,记录一下。涉及到稍复杂的逻辑,就需要在代码中侵入增加...

编写符合行业规范的代码是一项重要的专业技能!_vscode代码格式化...

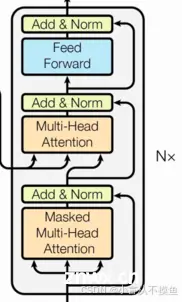

由N个解码器层堆叠而成每个解码器层由三个子层连接结构组成第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接第二个子层连接结构包括一个多头注意力子层和规范化层以及一个残差连接第三个子层连接结构包括一个...

Transformer是一种基于自注意力机制(Self-Attention)的深度学习模型架构,广泛应用于自然语言处理和其他序列到序列的任务。_transformer详解...

本文详细讲解transformers推理大语言模型的初始化过程,包括Python包搜索、LazyModule延迟模块、模块搜索和Python包API设计美学……...

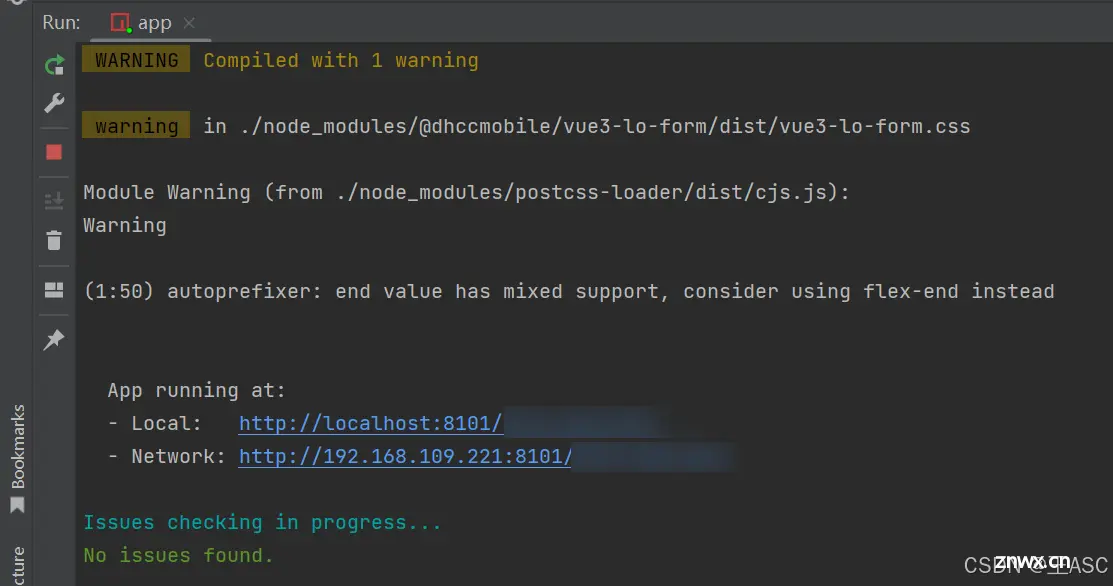

在Vue3项目开发中,合理配置开发工具可以大大提升我们的工作效率。本文将介绍如何配置Vite,使其在使用VueDevTools时将默认编辑器从VSCode更改为WebStorm,从而实现更符合...