通道注意力模块(ChannelAttentionModule)和空间注意力模块(SpatialAttentionModule)。这两个模块分别在通道维度和空间维度上对特征进行增强。通道注意力模块:主要关注...

交叉注意力机制(Cross-AttentionMechanism)是一种在深度学习中广泛使用的技术,尤其在序列到序列(sequence-to-sequence)模型和Transformer模型中被大量应用。...

【YOLOv8改进-注意力机制】CAA:上下文锚点注意力模块,处理尺度变化大或长形目标_caa模块...

iRMB倒置残差块是一种高效的卷积模块,主要用于提高模型的表达能力和计算效率。它结合了倒置残差块和注意力机制,使得模型能够更好地关注关键区域并减少计算量。倒置残差块(InvertedResidualBlock):...

MultiHeadAttention多头注意力作为Transformer的核心组件,其主要由多组自注意力组合构成,AttentionIsAllYouNeed,self-attention。_多头自注意力机...

多头自注意力机制是Transformer模型的核心组件,也是众多先进大语言模型架构的基础。它允许模型在不同的表示子空间中并行地关注输入序列的不同部分,从而增强了模型的表达能力和泛化能力。MHSA可以应用于各种类型的...

YOLO(YouOnlyLookOnce)系列模型以其卓越的实时目标检测能力在计算机视觉领域取得了广泛应用。YOLOv8在之前版本的基础上进行了优化,提升了模型的精度和效率。然而,在处理复杂背景和小物体检测任务时,YOLOv8仍有提升...

在计算机视觉领域,注意力机制(AttentionMechanism)已成为提升模型性能的关键技术之一。注意力机制通过模拟人类视觉的选择性注意力,能够在海量数据中自动聚焦于最相关的信息,从而提高模型的效率和准确性...

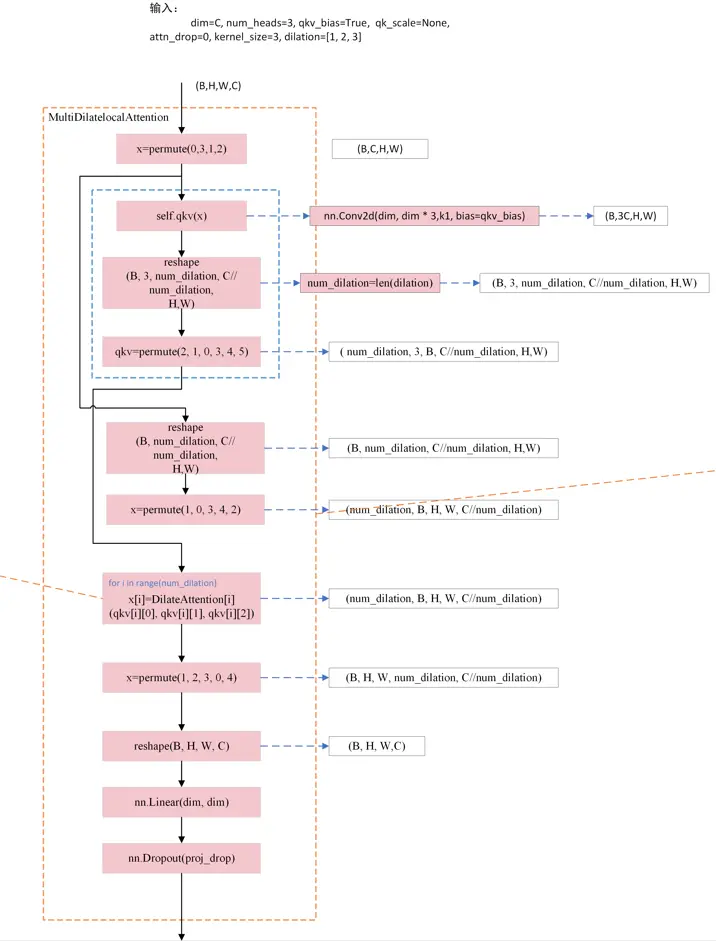

本文针对DilateFormer中的空洞自注意力机制原理和代码进行详细介绍,最后通过流程图梳理其实现原理。_multidilatelocalattention...

空洞卷积是一种用于扩大感受野而不增加计算量的卷积操作。通过在卷积核的权重之间引入空洞(即间隔),空洞卷积能够捕捉更大范围的信息,同时保持计算效率。空洞卷积的公式为:其中,(r)是空洞率,控制了感受野的大小。...