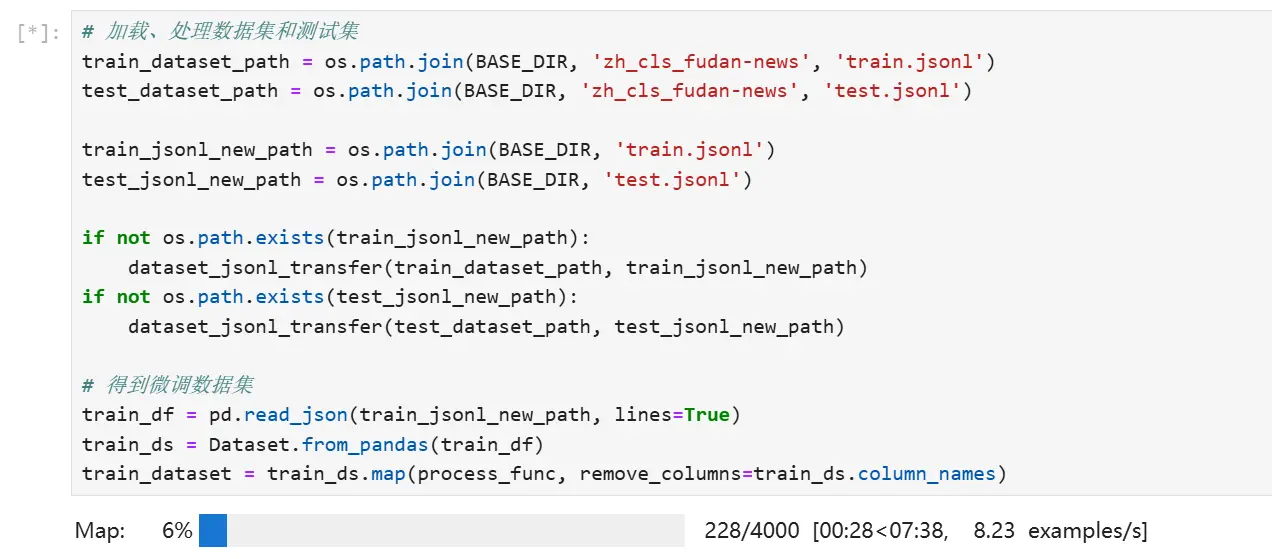

本教程详细介绍了LoRA参数高效微调技术,包括数据集准备和处理、模型加载、参数设置等,然后以Qwen2-0.5B预训练模型实践,进行了文本分类能力微调,微调过程通过SwanLab可视化界面查看,最终微调模型进行测试数据评估……...

大模型落地实战指南:从选择到训练,深度解析显卡选型、模型训练技、模型选择巧及AI未来展望---打造AI应用新篇章_微调大模型的gpu选型...

老牛同学验证和对比,在文本推理上,Qwen2-7B确实比Llama3-8B要快很多。后续老牛同学中文文本推理相关的API接口,就主要采用更快Qwen2-7B大模型了~_qwen2-72b本地部署...

进入存放python脚本的目录,运行命令:pythonxxx.py。如果你前端使用的是vue并且用了vue-router,那么就需要配置该代码,否则你进行router跳转的时候,就会出现404的问题。将该安装的...

LogoDiffusion——基于sd绘画模型的AILOGO生成器_logodiffusion...

论文提出了CachedAttention,一种新的注意力机制允许在多轮对话中重用KVCache,显著减少重复计算开销从而提升推理性能。...

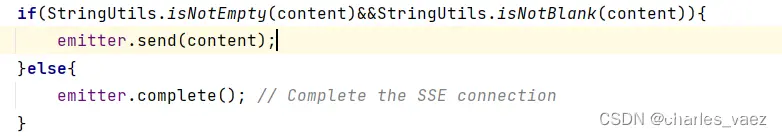

SpringAI调用OpenAI及Ollama系列模型,良心之作,全网唯一,绝非搬运,希望能给您带来一些些帮助!_springaimaven...

文心一言的原理是基于深度学习和自然语言处理技术开发的,通过Transformer模型架构、预训练和微调过程以及关键技术如知识增强、上下文感知和个性化生成等,实现了对人类语言的深度理解和高效生成。_文心一言底层模型...

本文介绍了当前主流的AI大模型BERT、GPT、Transformer和T5,阐述了各自的特点和应用,强调了这些模型在自然语言处理中的关键作用以及对技术进步的推动。...

![[Linux]条件变量:实现线程同步(什么是条件变量、为什么需要条件变量,怎么使用条件变量(接口)、例子,代码演示(生产者消费者模型))](/uploads/2024/07/19/1721351227383048390.webp)

在保证数据安全的前提下,让线程能够按照某种特定的顺序访问临界资源,从而有效避免饥饿问题,叫做同步。饥饿问题饥饿问题指的是某些线程由于某种原因无法获得它们所需要的资源或执行机会,导致它们长时间得不到处理,甚至永远得不到...