本次笔记,我将分为选择模型、调参、特征工程三个部分来尝试。...

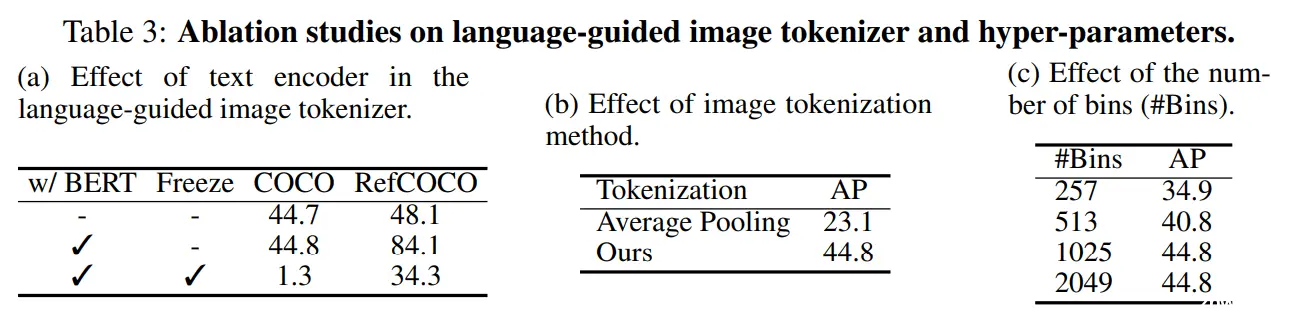

本文是关于NIPS2024论文VisionLLM的简要介绍。VisionLLM是一个多模态的大语言模型框架,可以借助大语言模型的力量,实现自定义的传统视觉任务,例如检测、分割、图像标题等。框架最大的特点就是灵活性...

LightGBM是一个实现GBDT算法的框架,具有训练速度快、内存消耗低、准确率高、分布式支持等优点,主要通过Histogram算法、带深度限制的Leaf-wise叶子生长策略和直方图做差加速等技术进行优...

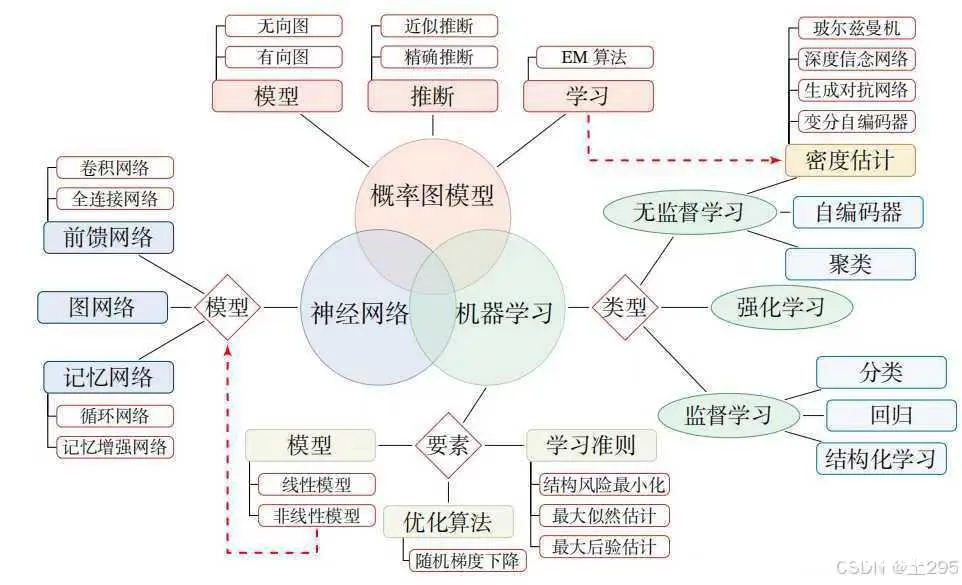

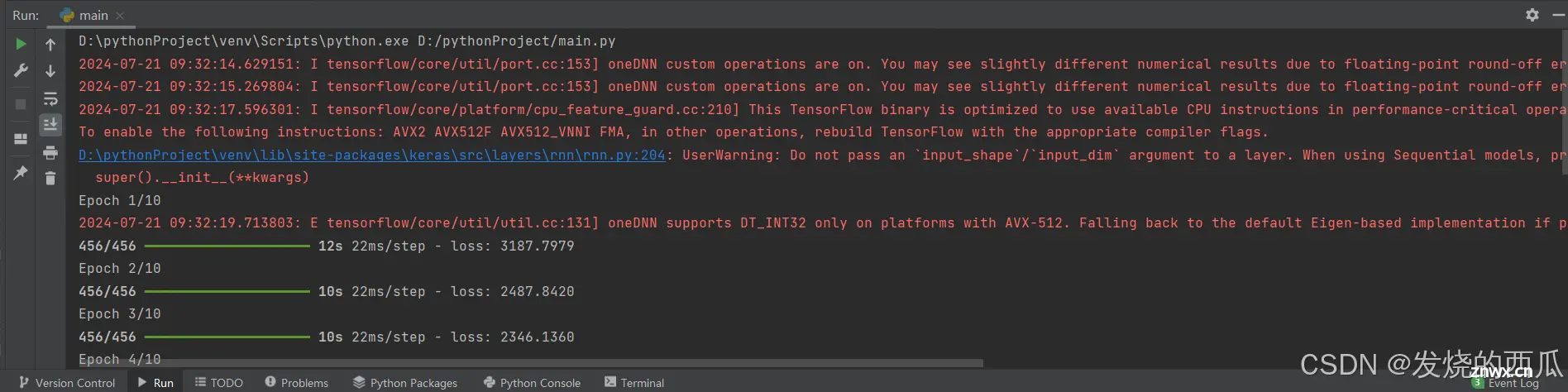

深度学习是机器学习一个分支,通过神经网络模拟人脑的学习方式,可以处理大量数据并且从中自动学习和提取特征,进行预测。深度学习就是将这些神经元模型层层堆叠起来的复杂结构,按一定的层次形成一个庞大的网络,从网络最底层接...

由于Task3是在Task2基础上做的改进,实操起来感觉比较简单,难度主要在于对Transformer的理解,以及在基础参数上自己尝试做出优化以抵达更高的上限。...

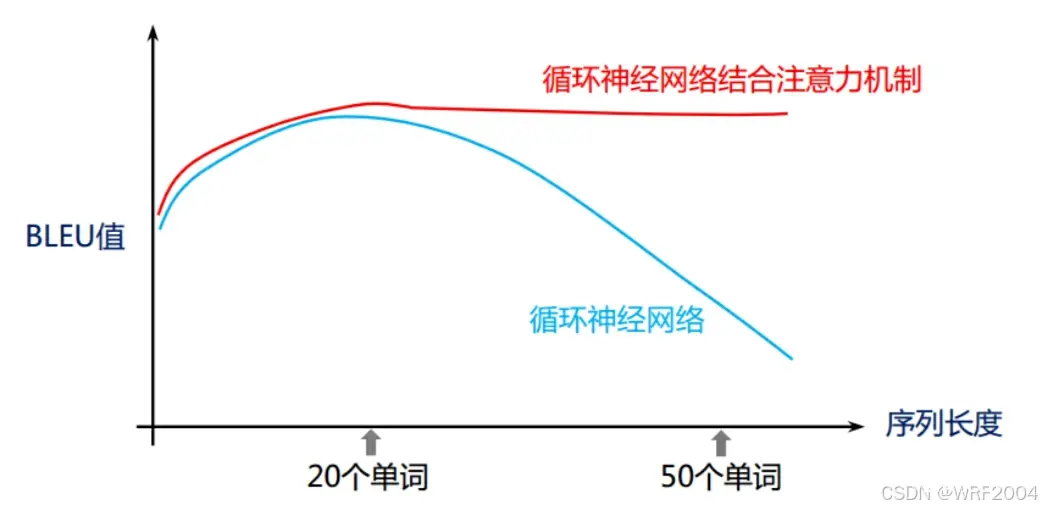

结构基本上和编码器是一致的,在基于循环神经网络的翻译模型中,解码器只比编码器多了输出层,用于输出每个目标语言位置的单词生成概率,而在基于自注意力机制的翻译模型中,除了输出层,解码器还比编码器多一个编码解码注意力子层,...

DatawhaleAI夏令营机器学习-Task2学习笔记...

经过这次预测模型的学习与实践,我深刻体会到了机器学习,特别是LightGBM这一高效梯度提升框架在解决回归与分类问题中的强大能力。理论基础:首先,我巩固了梯度提升算法的基本原理,理解了它是如何通过迭代地构建弱学习器(...

那在还没有学习进程之前,就问大家,操作系统是怎么管理进行进程管理的呢?很简单,先把进程描述起来,再把进程组织起来!我们拿大学为例子1.我们平时见得到校长吗?见不到——管理者和被管理者是不需要见面的2.这个就引出...

昨天我已经用了将近25分钟的时间把baseline按照说明文档的要求跑了一遍,过程较为顺利,除了手机验证码和网络出现了一点意外,整个过程非常丝滑,runall完整跑下来用了13分钟,最后的结果在群里也算还不错,是0...