作者:运维有术星主随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀升。特别是对于需要处理大规模数据和复杂算法的AI大模型,GPU资源的使用变得至关重要。对于运维工程师而言,...

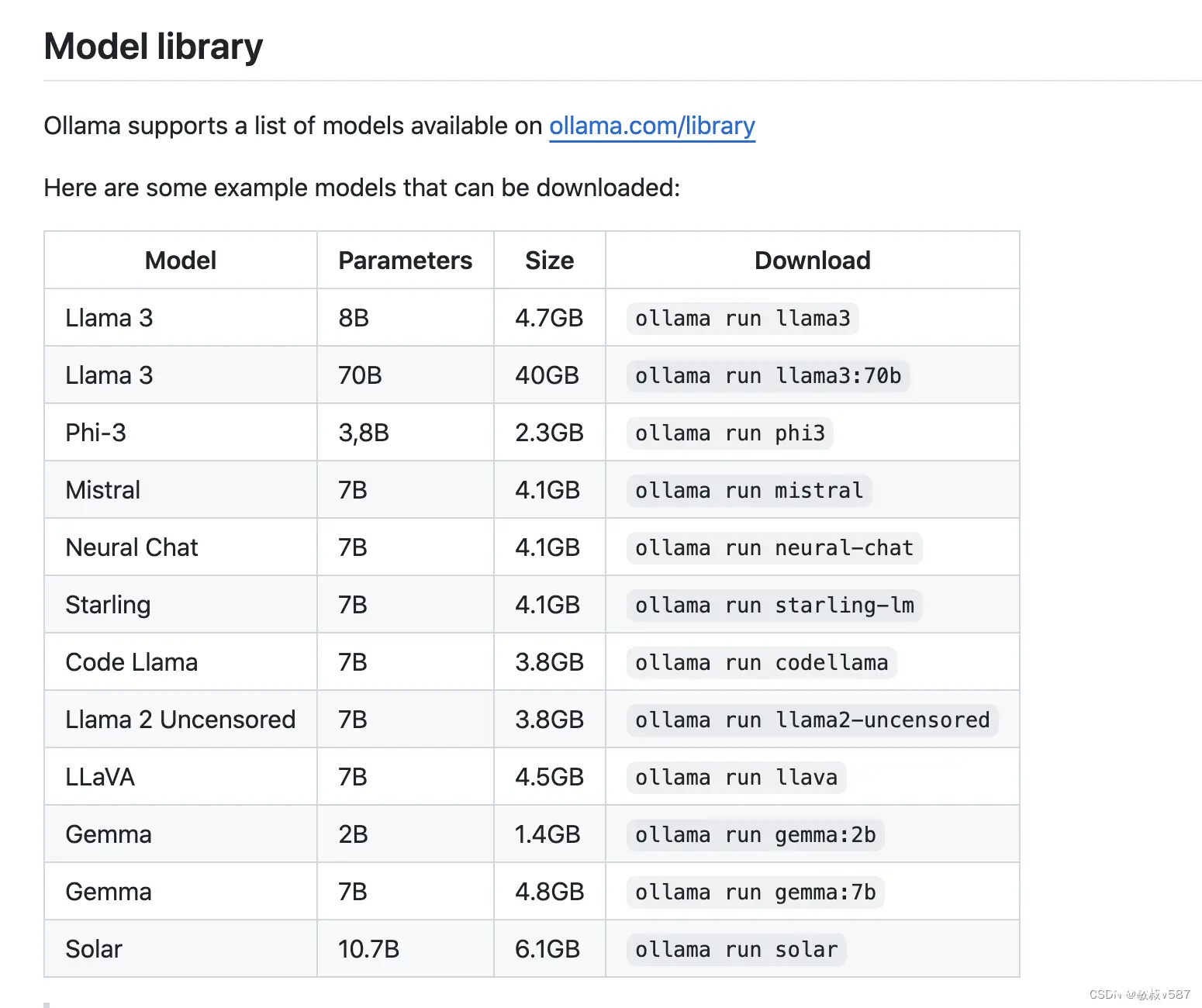

本文主要介绍如何在Windows系统快速部署Ollama开源大语言模型运行工具,并安装OpenWebUI结合cpolar内网穿透软件,实现在公网环境也能访问你在本地内网搭建的大语言模型运行环境。近些年来随着...

再进入默认的模型路径会发现model文件夹消失,设置的文件夹里生成了。可以删除默认的模型路径,让它重新生成。在运行ollama的终端按。_linuxollama修改模型位置...

转载:KubeSphere最佳实战:探索K8sGPU资源的管理,在KubeSphere上部署AI大模型Ollama随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀...

工作需要,最近研究在本地搭建AI问答平台的方法,设计到简单的文本问答、Word文档问答、Pdf文档问答、excel/csv文档问答以及图片问答。搭建AI其实很简单,只需要去下载一个Ollama就可以了,在Ollama...

Ollama不仅仅是一个AI和ML(MachineLearning)工具平台,它是技术社区中的一股清流,以其直观高效的工具,让AI模型的开发变得触手可及。无论是资深专家还是新手,都能在Ollama上找到...

Ollama用于在本地运行和部署大型语言模型(LLMs)的工具,可以非常方便的部署本地大模型。_ollamawebui...

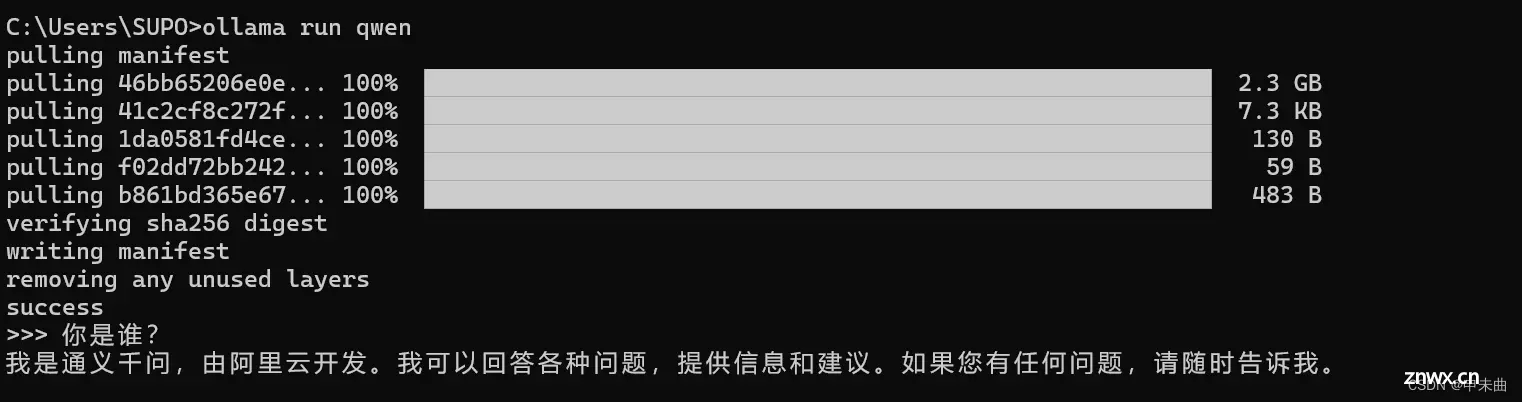

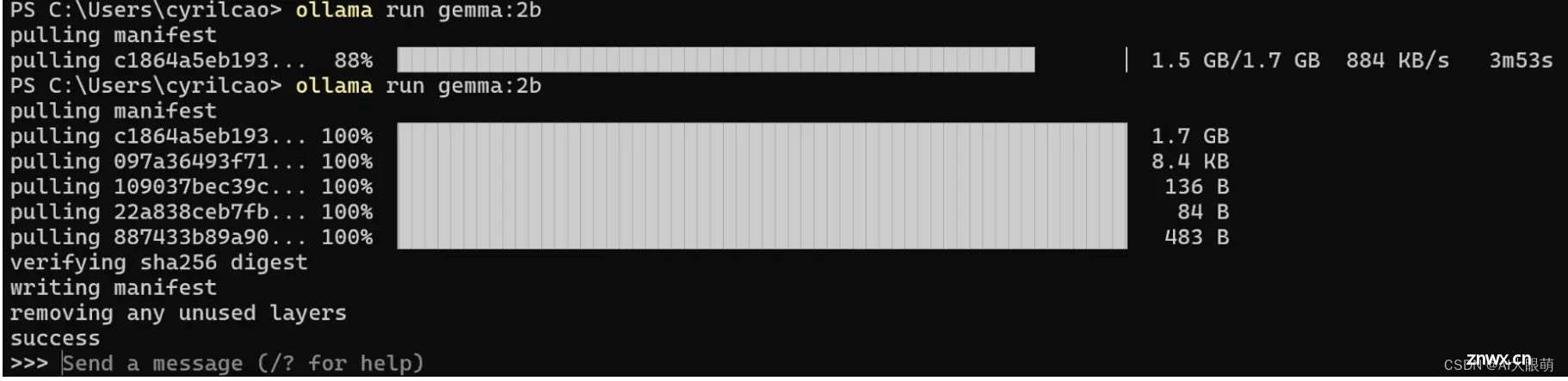

Ollama是一个开源的LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如Lla...

本文介绍了作者在国内使用大模型遇到的挑战,如网络限制和高昂费用,随后介绍了一个开源平台Ollama和标准化APIlangchain,如何通过它们在本地免费运行和定制大模型,包括安装、模型下载和使用示例,以及如何将...

服务器Ubuntu22.04系统下ollama的详细部署安装和搭配open_webui使用_ubuntu安装ollama...