我们除了可以使用Langchain进行模型对话、提示词创作、嵌入模型,还可以使用其他的组件对大模型封装使用,打造我们自己的大模型。_langchain文心一言agent...

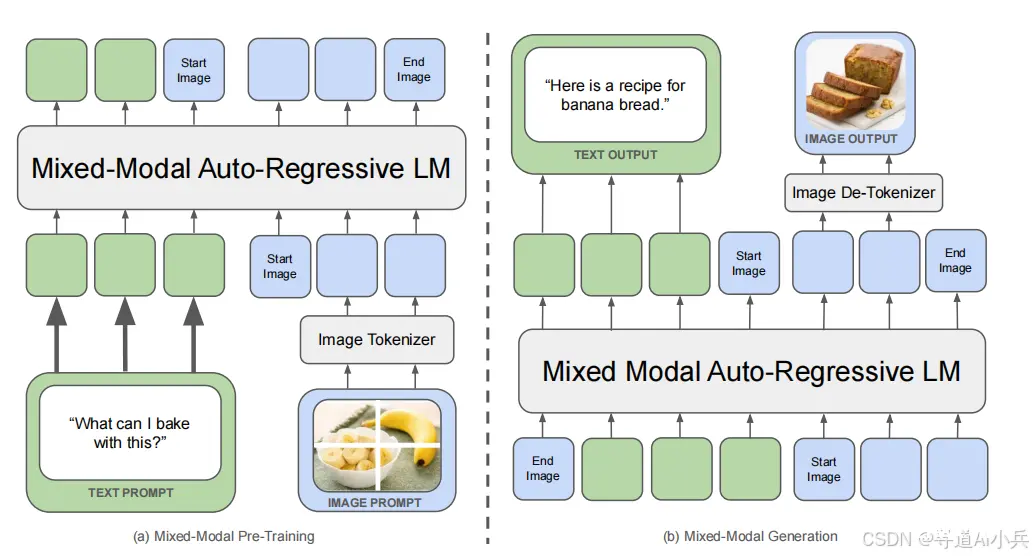

FAIRatMeta的研究团队推出了一款创新的多模态基础模型——Chameleon。Chameleon模型以其卓越的性能和独特的设计理念,成功在多模态理解和生成任务中树立了新的标杆。它不仅能够理解和生成文本...

OrangePiAIPro开发板是一款香橙派和华为联合精心打造的高性能AI开发板,搭载了昇腾AI处理器,可实现图像、视频等多种数据分析处理OrangePiAIpro(8-12T)采用昇腾AI技术路线,...

2010年底,当第一款Kinect传感器发布时,我们看到了这款相对实惠的3D相机带来的大量新奇应用,从沉浸式纪录片到实时互动装置,再到几何重建。我们从使用破解的DIY红外相机(还记得旧款PS3Ey...

在人工智能技术的迅猛发展中,AI大模型以其无与伦比的数据处理能力和深度学习能力,正逐步成为医疗健康领域变革的引领者。本文旨在深入探讨AI大模型在医疗领域的十大创新应用场景,展示其如何显著提升医疗服务效率、赋能临床决...

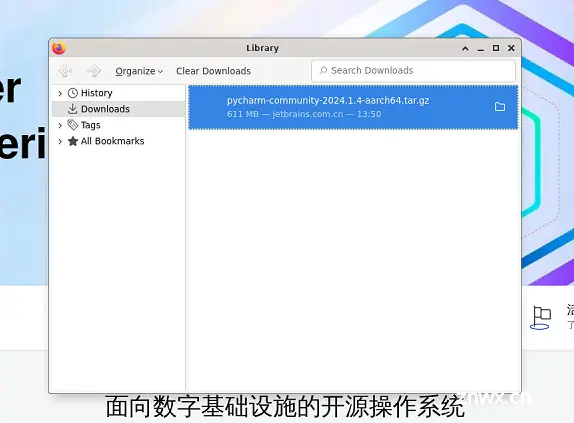

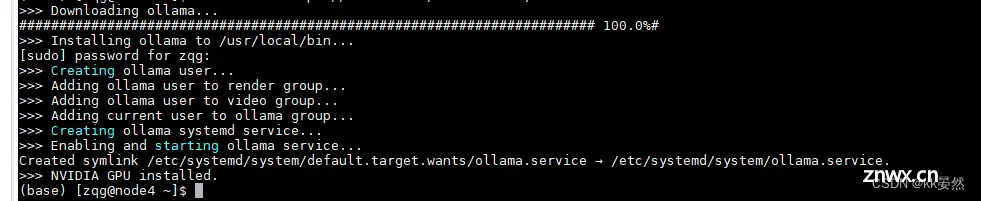

Ollama是一个专注于简化大规模机器学习模型开发的框架。它提供了一系列工具来帮助开发者轻松地定义、训练和部署大型语言模型。优点:•提供了简洁的API,易于上手。•支持多种硬件加速选项,如GPU和...

此外,特征选择的质量也直接影响模型的性能。COA-SVM算法的结合为多特征预测模型的优化提供了新的思路,能够有效提升SVM模型在复杂数据上的性能。通过借助浣熊优化算法的优势,在超参数调整和特征选择策略上取得了显著成果...

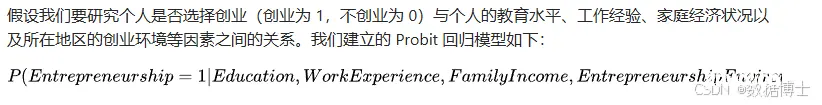

在经济学领域,Probit回归模型常用于研究消费者的购买决策、企业的投资行为以及市场的进入与退出等问题。综上所述,Probit回归模型在不同学科领域都有着丰富的应用和研究成果,为我们解决实际问题提供了有力的方...

这个脚本的主要功能是创建一个局部可变形模型,并在一系列图像中搜索这个模型,然后显示搜索结果和搜索时间。...

一、AI编程简介1、GPT大模型可替代的工作特点-\"输入文本->输出文本\"2、大模型的编程能力3、GPT大模型进行编程工作的优缺点4、AI编程技巧5、提示工程应用于AI编...