本文介绍了如何使用LLaMAFactory框架,在ModelScope平台上对Yi-6B模型进行监督微调,包括环境配置、WebUI的使用、参数设置以及模型的训练、对话和合并过程。通过WebUI,用户可以直观地管理...

ChatGLM3是智谱AI和清华大学KEG实验室联合发布的对话预训练模型。ChatGLM3-6B的基础模型ChatGLM3-6B-Base采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语...

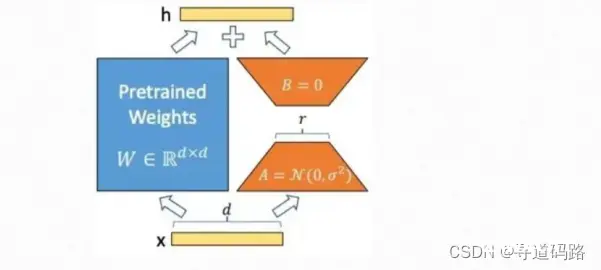

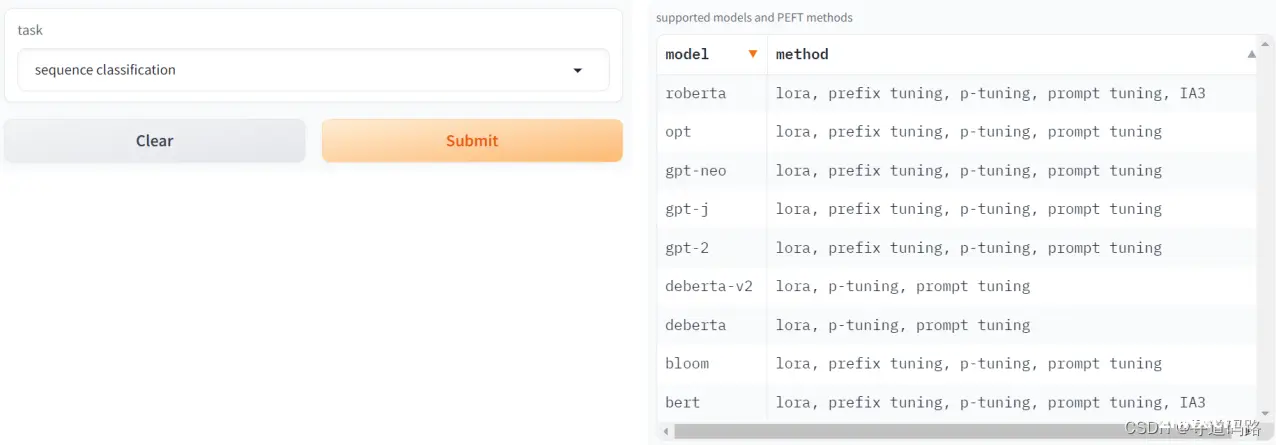

在自然语言处理领域,大语言模型的预训练-微调技术已经成为一种常见的方法。其中,LoRA(Low-RankAdaptation)是一种新颖的微调技术,通过引入低秩矩阵来调整模型的行为,以提高模型在新任务上的表现。...

人工智能大语言模型微调技术:SFT监督微调、LoRA微调方法、P-tuningv2微调方法、Freeze监督微调方法_loraptuningv2...

以上只是一个简洁的思路,如果有其他想法欢迎在评论区留言。...

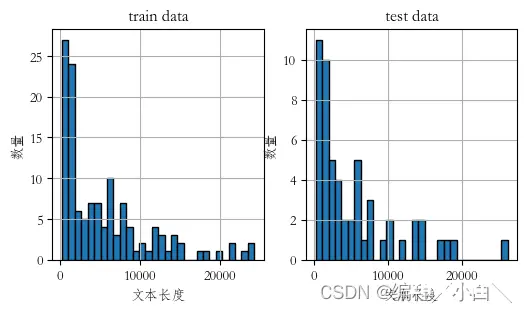

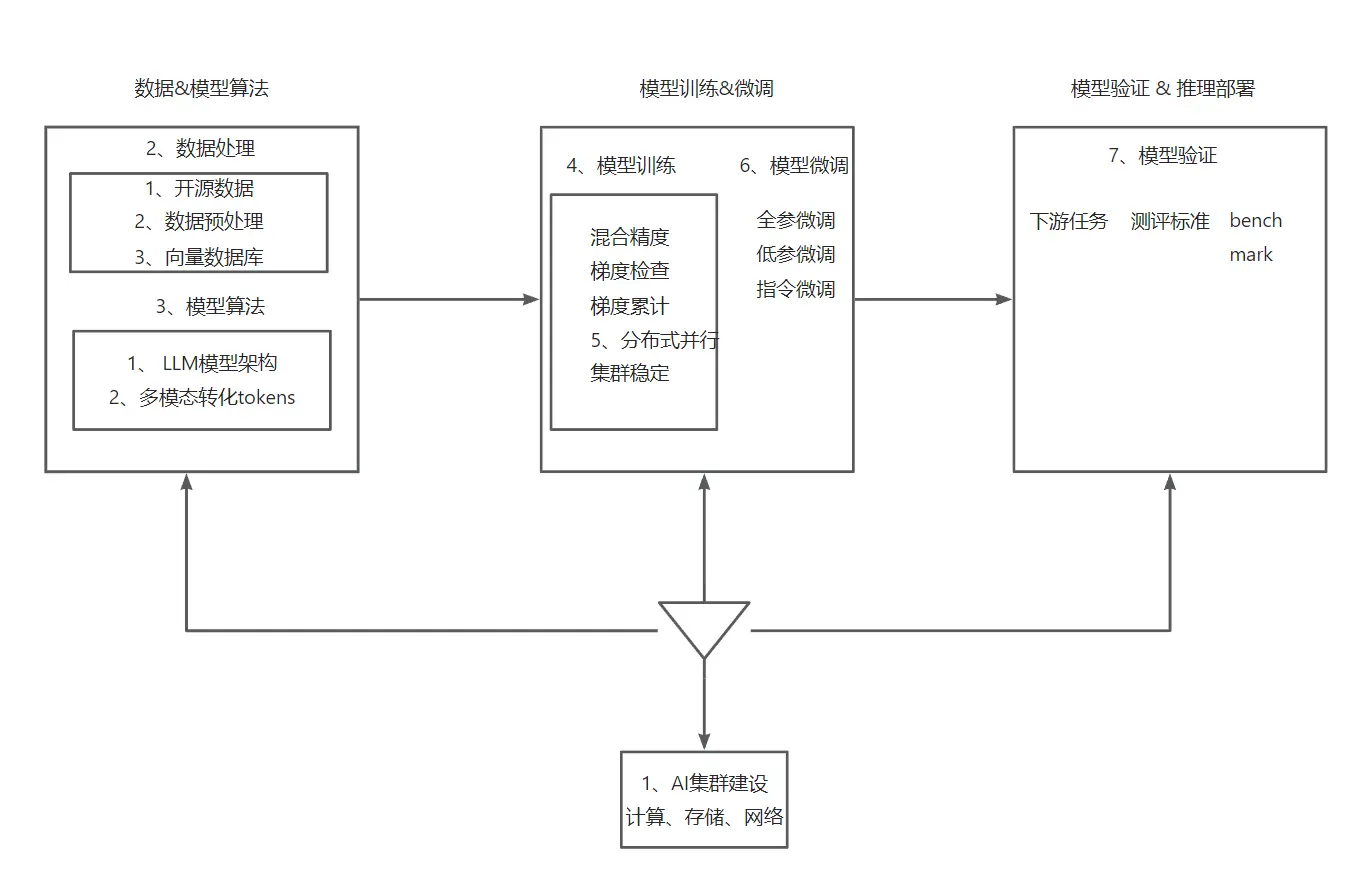

之前一直对于大模型的微调和训练这两个名词不是很清晰,所有找了一个时间来弄明白到底有什么区别以及到底要怎么去使用去做。并且上手实践一下。_大模型微调和训练的区别...

在人工智能的广阔领域里,大语言模型(LLMs)的微调技术扮演着至关重要的角色。它不仅为模型注入了适应特定任务的能力,而且还是通往专业领域的关键。本文旨在深入探讨基于P-TuningV2技术的ChatGLM3...

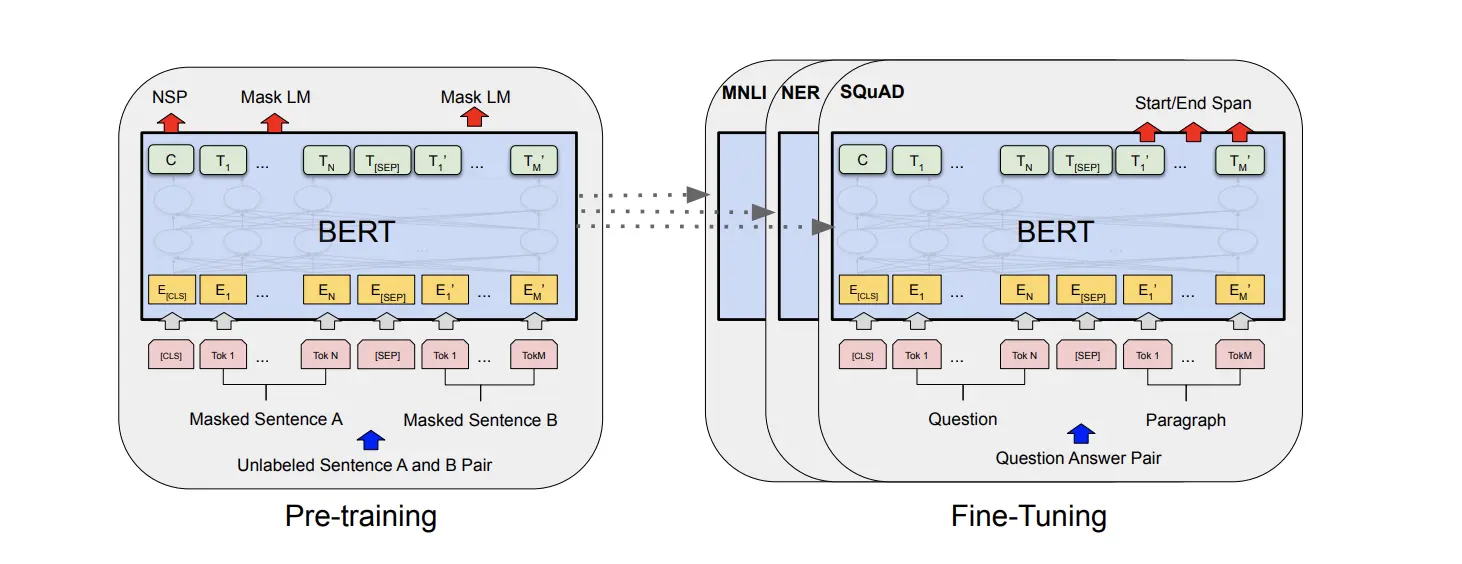

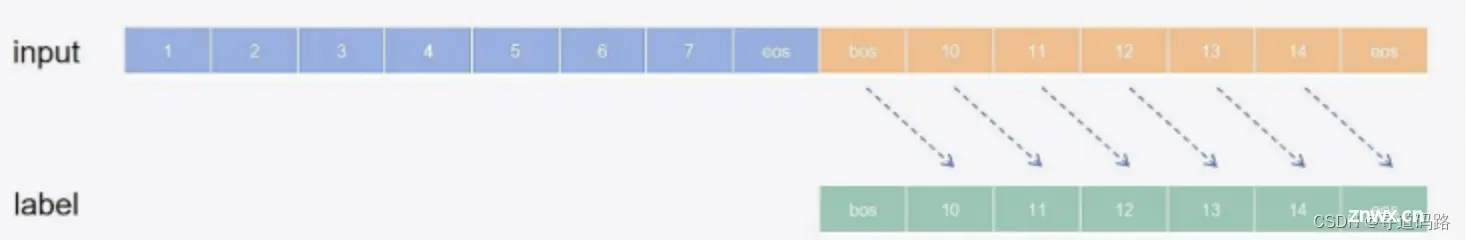

在自然语言处理(NLP)领域,预训练模型的应用已经越来越广泛。预训练模型通过大规模的无监督学习,能够捕捉到丰富的语言知识和上下文信息。然而,由于预训练模型通常需要大量的计算资源和时间进行训练,因此在实际使用时,我...

随着人工智能的迅猛发展,自然语言处理(NLP)在近年来取得了显著的进展。大型语言模型(LLMs)在多种NLP任务中展现了卓越的性能,这得益于它们在大规模文本数据集上进行的预训练和随后的微调过程。这些模型不仅能够理...

在人工智能的广阔研究领域内,大型预训练语言模型(LargeLanguageModels,LLMs)已经成为推动技术革新的关键因素。这些模型通过在大规模数据集上的预训练过程获得了强大的语言理解和生成能力,使其...