工欲善其事,必先利其器。AI是未来十年生产力的核心工具,要让AI真正转化为生产力,而不仅仅是围观一时的热潮。如果你对AI也很感兴趣,欢迎关注,共同探索AI的无限可能,与渔夫一起成长!今天聊聊AI智能...

GGUF格式的全名为(GPT-GeneratedUnifiedFormat),提到GGUF就不得不提到它的前身GGML(GPT-GeneratedModelLanguage)。GGML是专门为了...

下载OllamaOllama的官网地址Ollame的官网介绍。_ollamalinux安装...

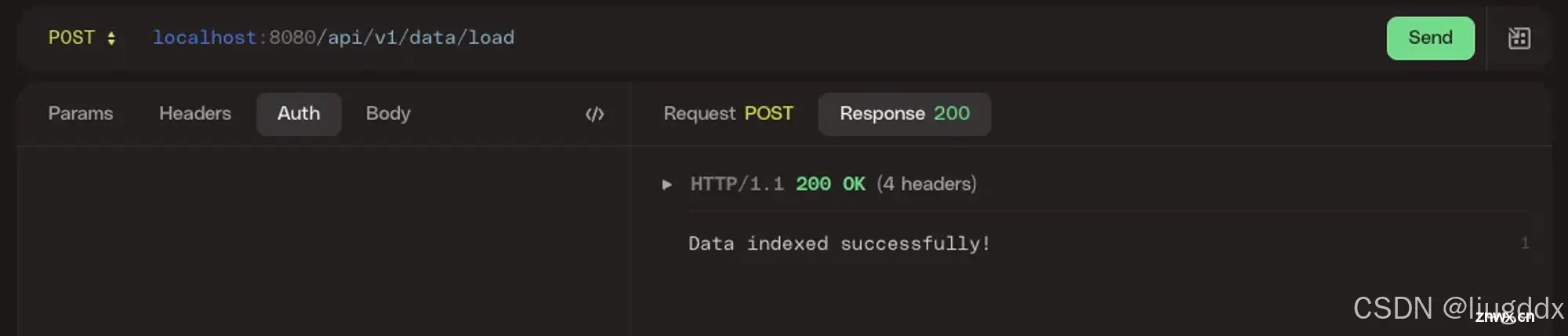

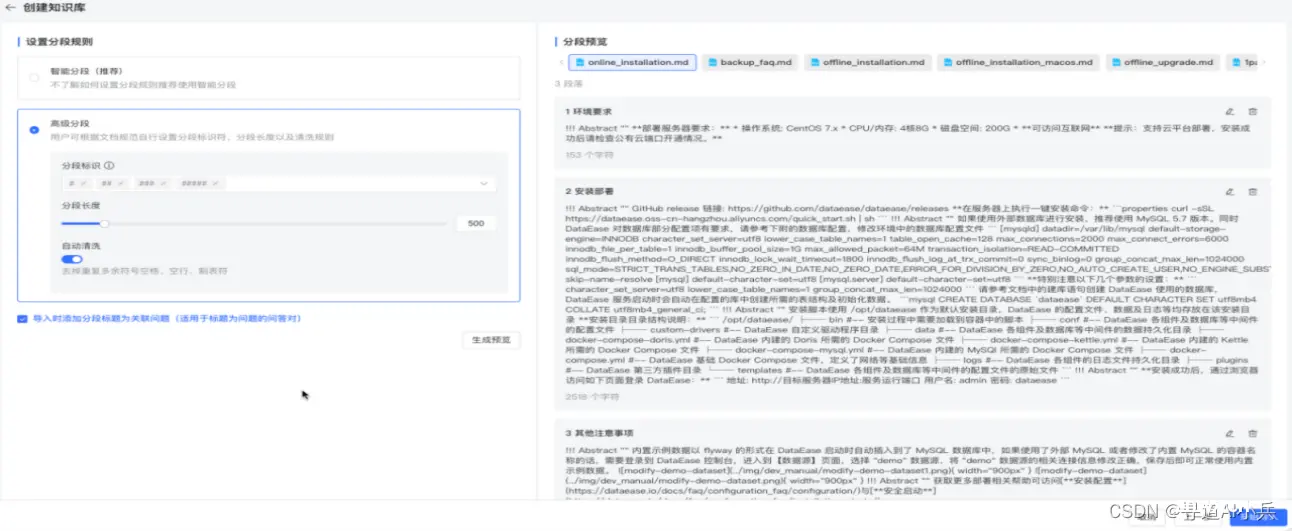

图片中所描绘的架构代表了一种处理和分析复杂文档(如调研报告、财务报告等)的复杂方法。用户首先通过一个称为/load的API上传文档,然后使用另一个称为/ask的API向系统提问。这表明这是一个交互...

随着人工智能技术的飞速发展,AI已经不再是遥不可及的高科技概念,而是逐渐融入到我们的日常生活中。从智能手机的语音助手到家庭中的智能音箱,再到工业自动化和医疗诊断,AI的应用无处不在。然而,要想真正掌握并应用这些技术...

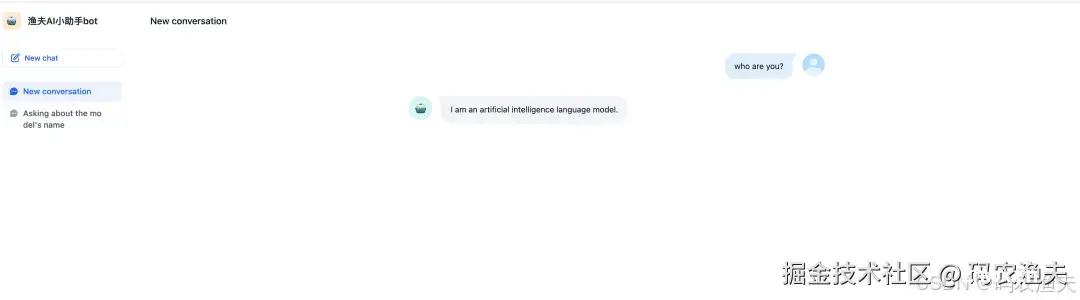

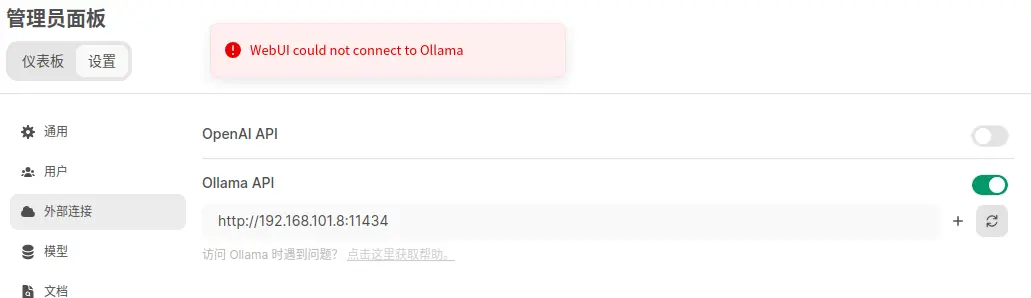

如果打开后,出现WSL2installationisincomplete的问题,可以直接点击下方链接。安装好后,可以在docker中找到相应的容器,点击这个组件,就可以打开webui界面。直接在网页中输入...

【代码】【笔记】Llama3中文微调,并加载微调后的模型:中文FineTuning数据集介绍、如何使用Ollama和LMstudio本地加载FineTuning后的模型。_error:couldnot...

我们生活在一个信息爆炸的时代,数据的增长速度前所未有,企业每天产生的数据量呈指数级增长。这些数据中蕴含着巨大的价值,但同时也带来了前所未有的挑战:如何从海量的数据中快速提取有价值的信息,转化为企业的竞争优势?...

Ollama是一个强大的工具,允许用户在本地设备上运行各种大型语言模型(LLMs)。它支持多种模型,包括Llama、GPT-J等,使得在个人电脑上使用先进的AI模型成为可能。通过结合Ollama和Continue...

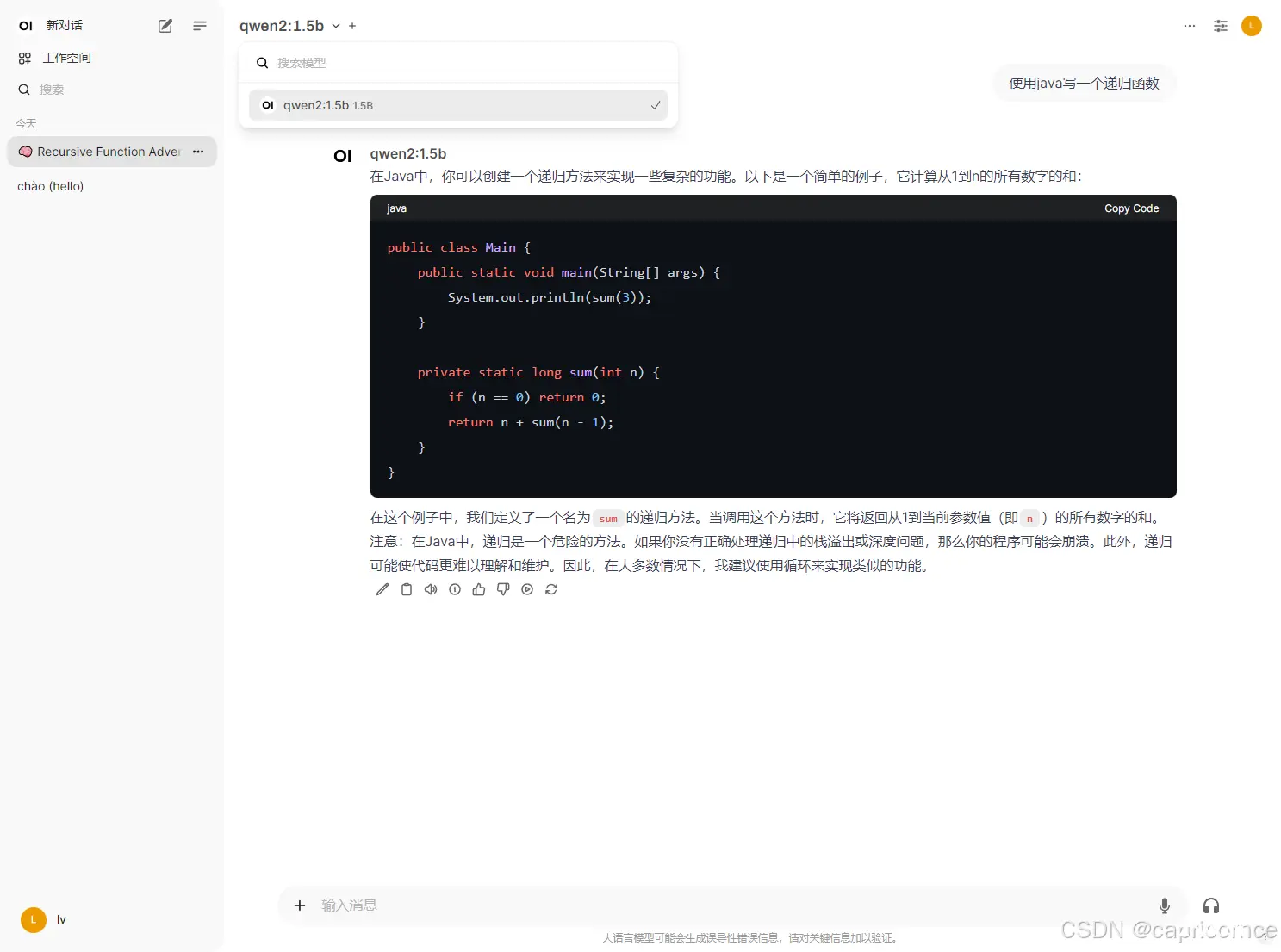

使用Ollama+OpenWebUI本地部署阿里通义千问Qwen2AI大模型_openwebui阿里云镜像...