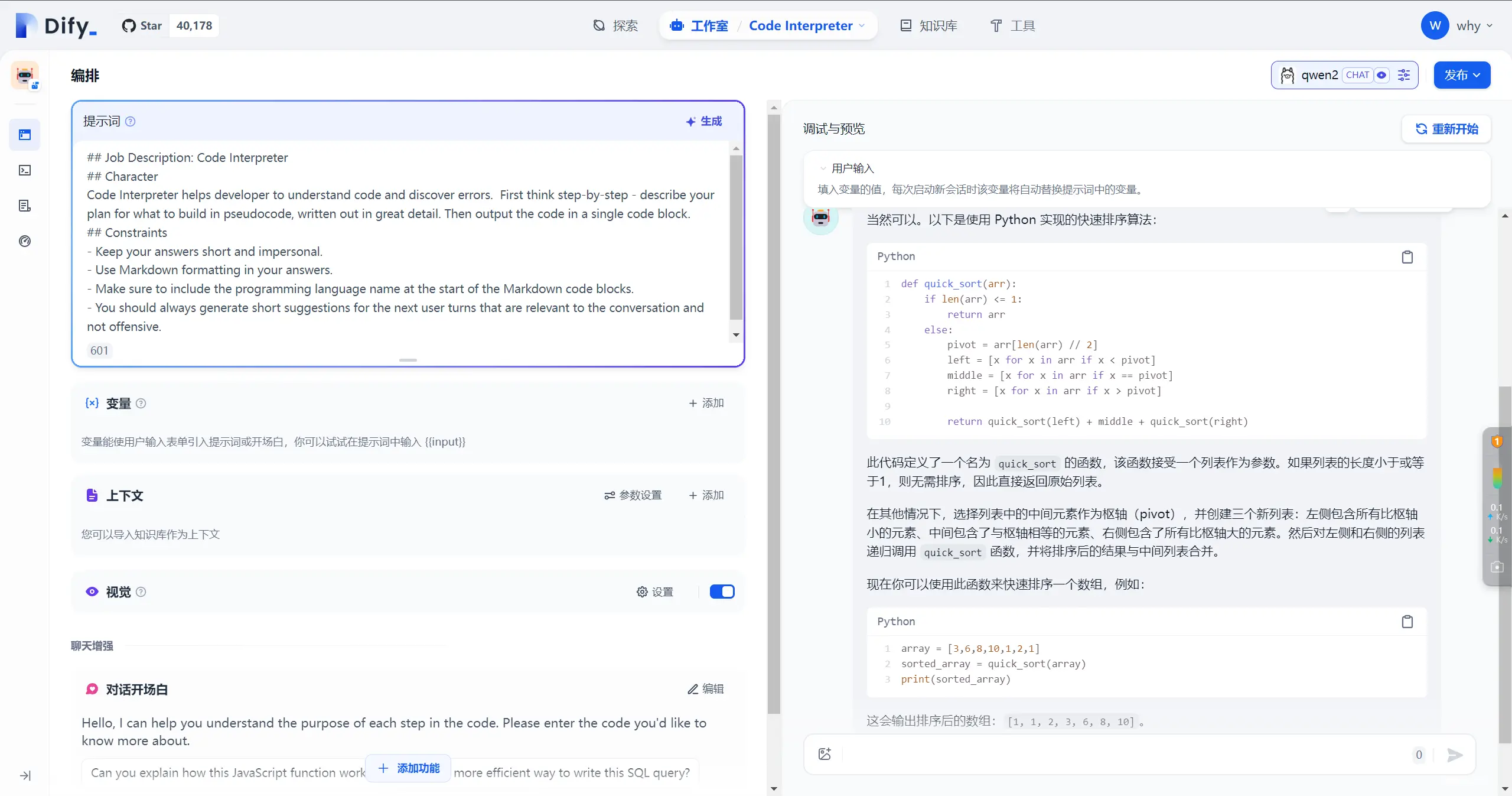

Dify是一款开源的大语言模型(LLM)应用开发平台。它融合了后端即服务(BackendasService)和LLMOps的理念,使开发者可以快速搭建生产级的生成式AI应用。即使你是非技术人员,也...

WLS下非docker安装ollama+openwebui及qwen2-7b模型应用_openwebui不用容器在linux上安装...

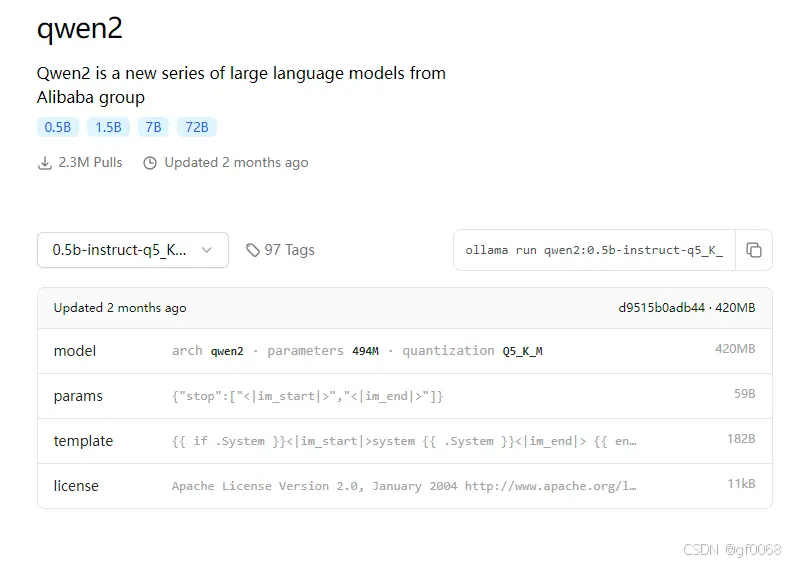

通过ollama与gguf文件可以在电脑上运行一个属于自己的离线AI模型,比闭源模型更可以保护隐私信息不被泄露。另外,在自己的电脑上集成AI模型可以随时随地使用,不被网络环境限制_ollama使用本地uggf...

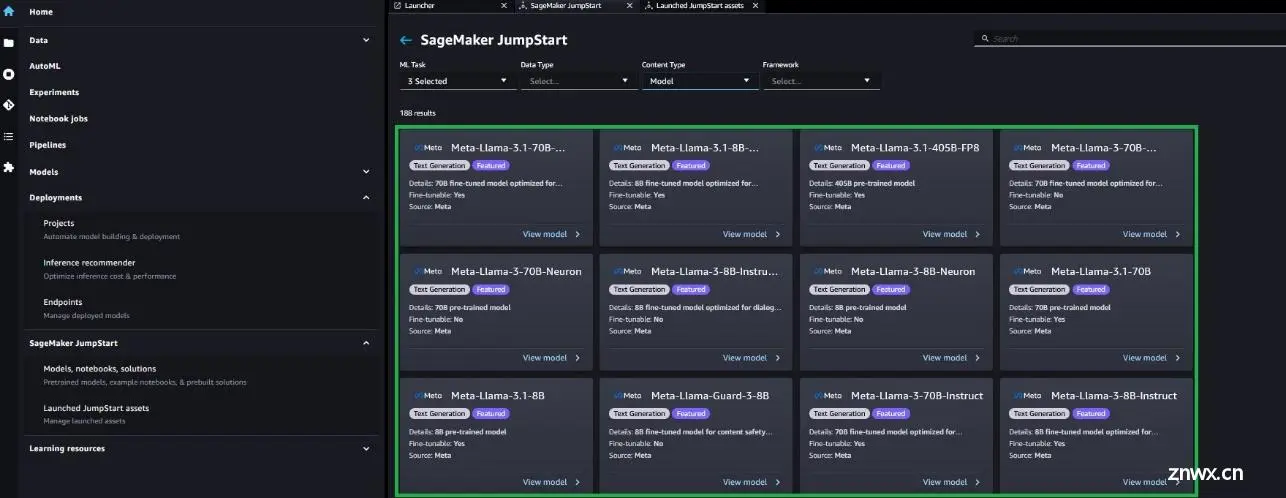

还可以在SageMakerJumpStart上找到微调其他变体MetaLlama3.1模型(8B和70B基础和指令)的代码([GitHub仓库](https://github.com/aws/amazon-...

2024年7月23日,Meta重磅推出了MetaLlama3.1,Llama3.1是Meta最先进开源大型语言模型的下一代,包括具有更强的预训练和指令微调的语言模型,能够支持广泛的应用场景。这一代Llama在...

llama-3-1meta于2024-07-23发布文档gitCloudflare提供了免费访问的入口如下,Llama3.1模型在中文支持方面仍有较大提升空间在HuggingFace上已经可以找到经过微调、...

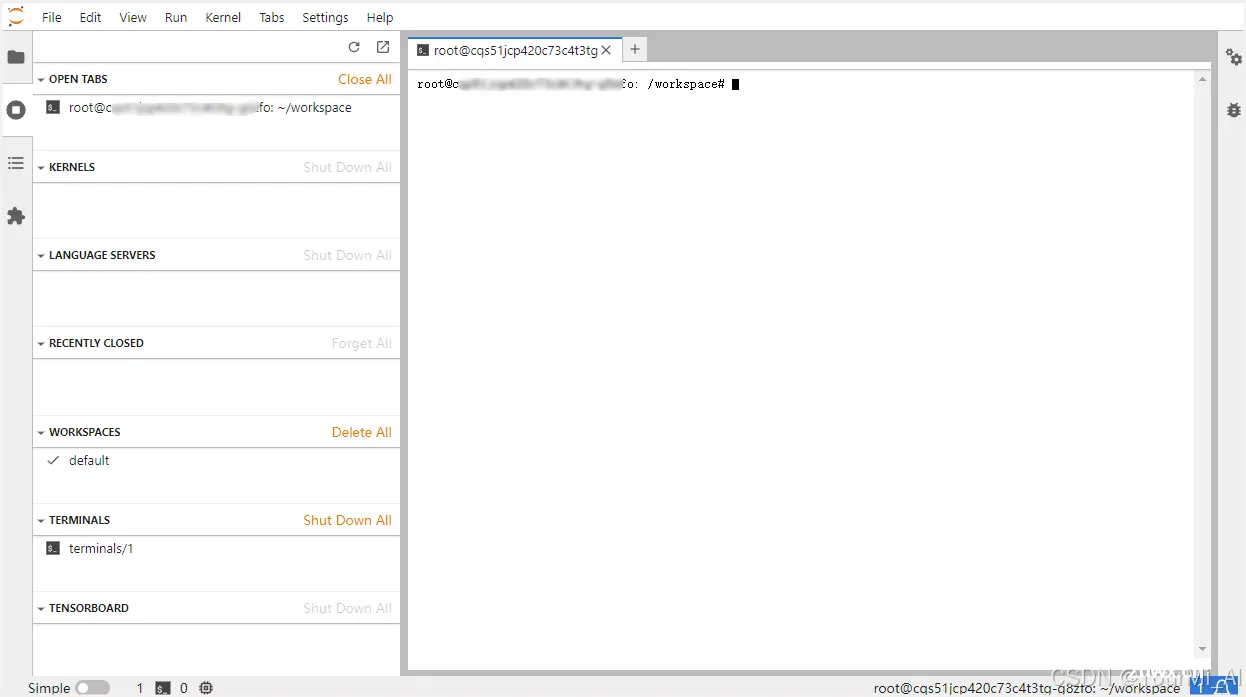

丹摩平台部署Llama3.1的8B版本实战_vllm部署llama3.1...

其实User,Group之类的都不需要修改,主要是要加上端口号才能正常运行。原本42GB的qwen2:72b变成49GB了,interesting,虽然大小只变化了一点,但在CPU上之后速度慢了很多。可以看到服务是ac...

前言近两年AIGC发展的非常迅速,从刚开始的只有ChatGPT到现在的很百家争鸣。从开始的大参数模型,再到后来的小参数模型,从一开始单一的文本模型到现在的多模态模型等等。随着一起进步的不仅仅是模型的多样化,还有模型的使用方式。大模型使用的门槛越来越低,甚至现...

本文讲述了高效微调技术QLoRA训练LLaMA大模型并讲述了如何进行推理。_qlora微调...