![【设置gpu设备】os.environ[‘CUDA_VISIBLE_DEVICES‘] 和 torch.cuda.set_device()](/uploads/2024/08/11/1723345263367011940.webp)

【设置gpu设备】os.environ[‘CUDA_VISIBLE_DEVICES‘]和torch.cuda.set_device()_os设置gpu使用设备...

目录1.AWS(亚马逊云服务)2.GoogleCloudPlatform(GCP)3.MicrosoftAzure4.阿里云5.腾讯云6.派欧算力云(PPIO)7.LambdaLabs8....

作者:运维有术星主随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀升。特别是对于需要处理大规模数据和复杂算法的AI大模型,GPU资源的使用变得至关重要。对于运维工程师而言,...

随着人工智能技术的飞速发展,GPU/AI算力的需求呈现出爆炸式增长。算力作为AI时代的基础设施,其重要性不言而喻。GPU/AI算力租用服务应运而生,为中小企业、科研机构及个人开发者提供了灵活、高效、低成本的计算资源...

转载:KubeSphere最佳实战:探索K8sGPU资源的管理,在KubeSphere上部署AI大模型Ollama随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀...

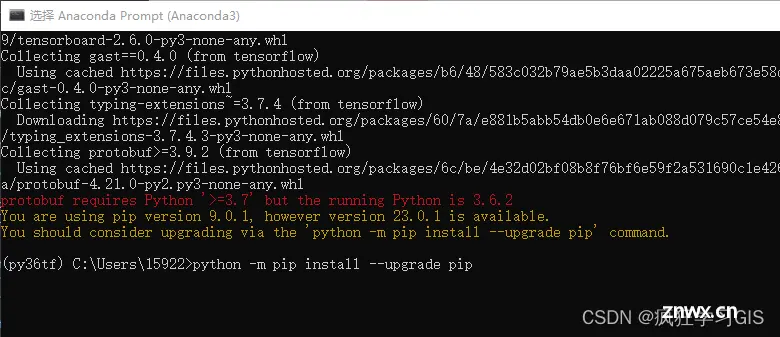

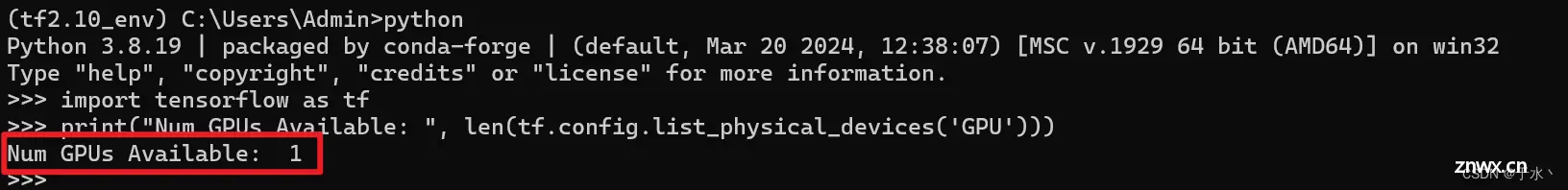

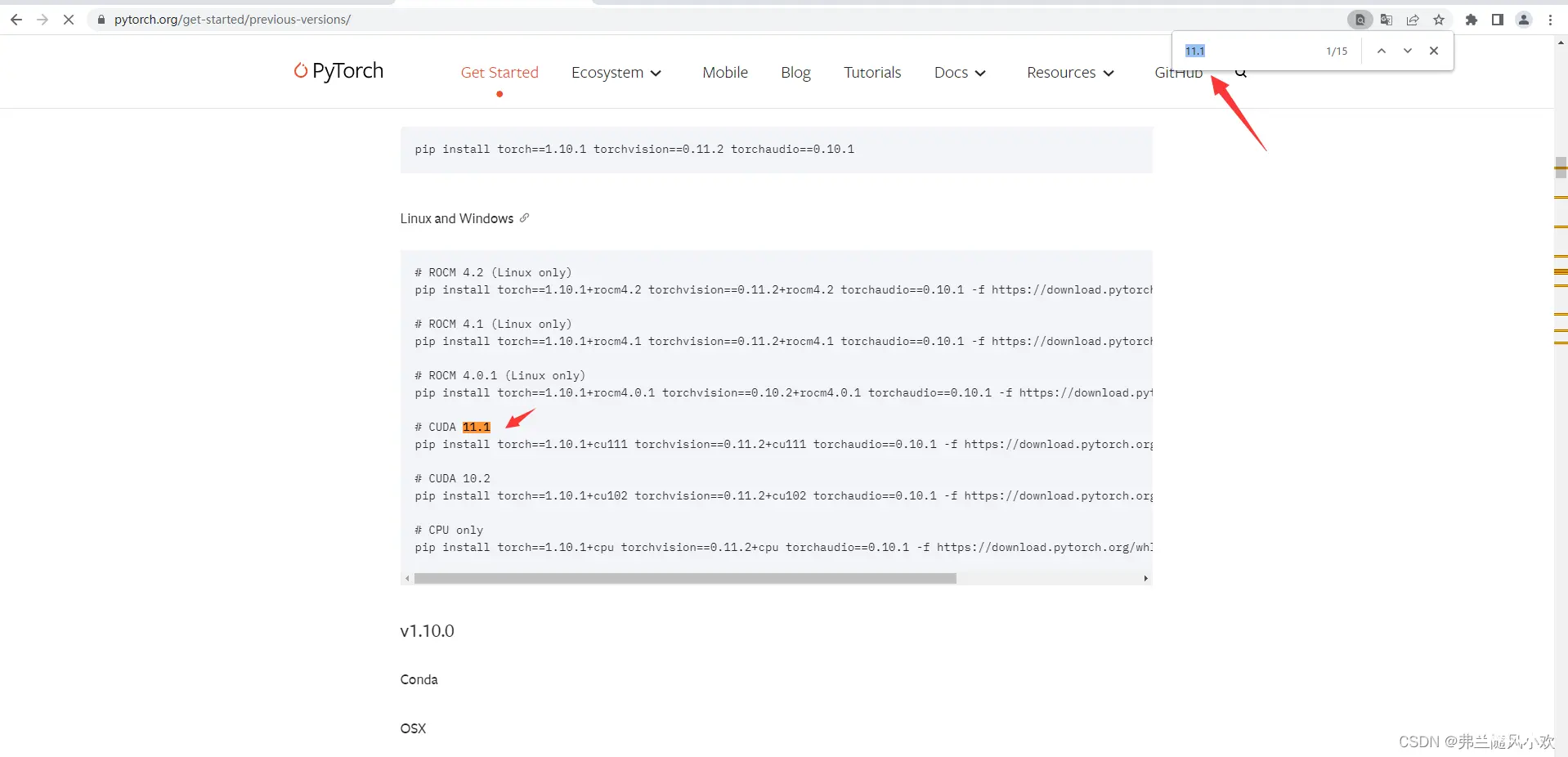

本文介绍在Anaconda环境中,下载并配置Python中机器学习、深度学习常用的新版tensorflow库的方法~...

从零安装tensorflow,cuda,cudnn_如何使用gpu进行ai训练...

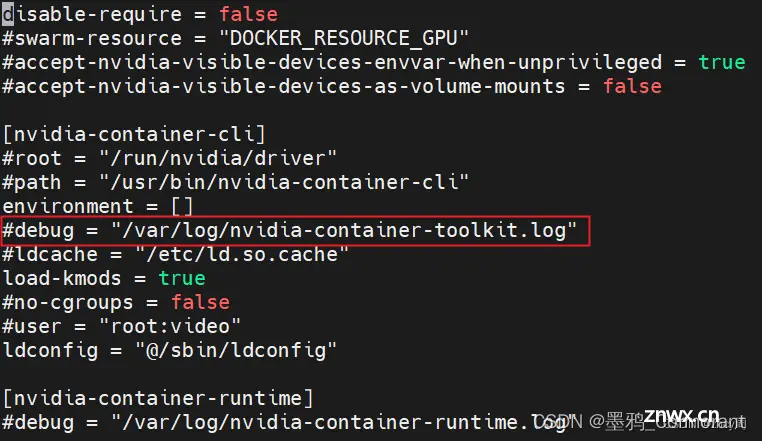

docker容器访问GPU资源使用指南_nvidia-docker...

【目标检测实验系列】AutoDL线上GPU服务器租用流程以及如何用Pycharm软件远程连接服务器进行模型训练(以Pycharm远程训练Yolov5项目为例子超详细)_autodl...

WebGL已经成为了web3D的标配,市面上有N多基于webGL的3D引擎,WebGPU作为挑战者,在渲染性能上确实改过webGL一头,由于起步较晚,想通过这个优势加持,赶上并超越webGL仍需时日。_webgl...