本文对使用transformers的AutoModel自动模型类进行介绍,主要用于加载transformers模型库中的大模型,文中详细介绍了应用于不同任务的ModelHead(模型头)、使用模型头、输出模型结...

本文简要介绍了device_map=\"auto\"等使用方法,多数情况下与CUDA_VISIBLE_DEVICES=1,2,3一起使用,可以简单高效的进行多卡分布式推理及训练计算,至于多机多卡场景,多用torc...

通过本文,我们深入探讨了ModuleNotFoundError:Nomodulenamed‘transformers’错误的原因、解决方案以及相关的Python包和模块知识。我们提供了安装transfor...

cannotimportname\'CommitOperationAdd\'from\'huggingface_hub\'(unknownlocation)_importerror:cannotimportname...

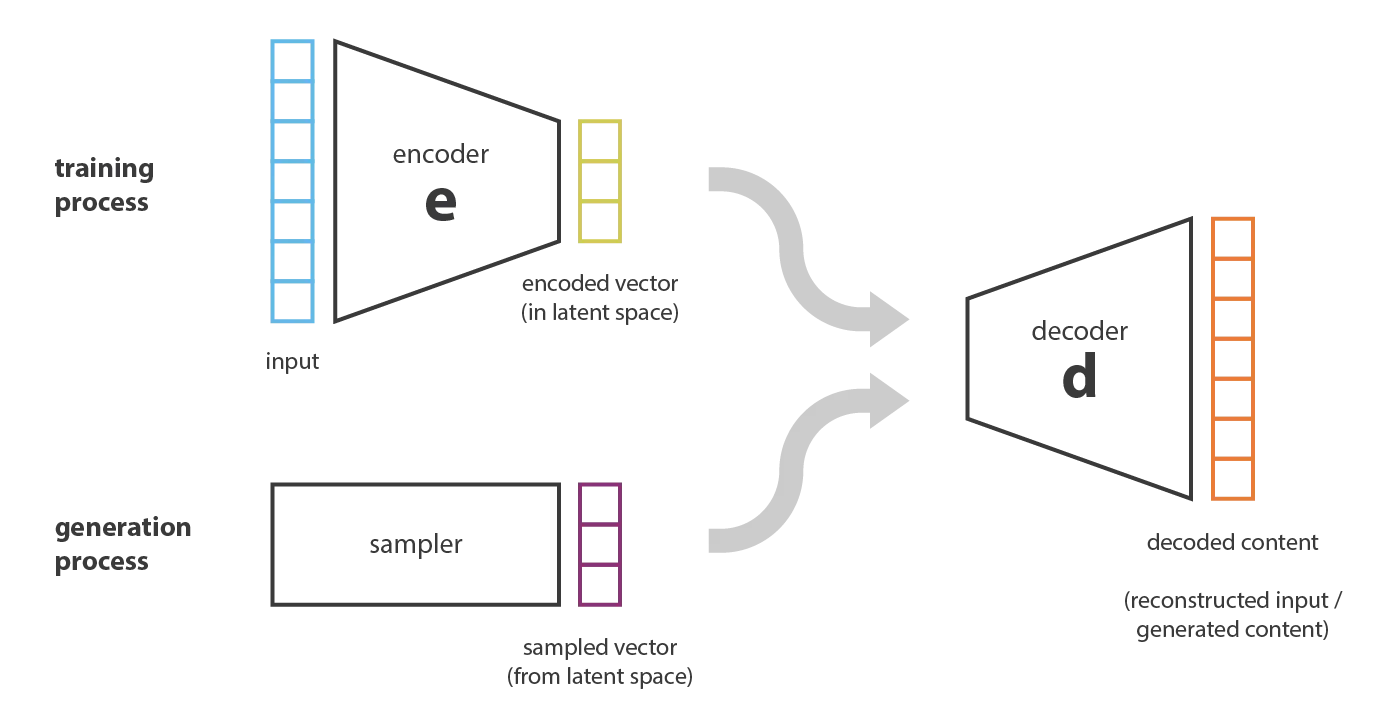

本文深入探讨生成式AI的核心技术,包括GANs、VAEs、自回归模型和Transformers,详细描述其原理、实现方法及实际应用,结合代码示例和现实案例,展示最新技术进展和应用场景。_gantransform...

基于LoRA进行模型微调时,需要先冻结全部参数,再指定相应的Linear层进行微调,那么如何计算全部参数,如何计算微调参数以及如何计算微调参数占全部参数的比例呢?本文先对Qwen2模型结构进行一览,做到心中有数,之...

![[AI]如何让语言模型LLMs流式输出:HuggingFace Transformers实现](/uploads/2024/06/12/1718161271748053676.webp)

HugginFaceTransforms是一个非常方便的库,集成了非常多SOTA的模型,包含:LLAMA,GPT,ChatGLMMoss,等。目前基本上主流的方案都是基于HugginFaceTransf...

SentenceTransformers是一个Python库,用于使用和训练各种应用的嵌入模型,例如检索增强生成(RAG)、语义搜索、语义文本相似度、释义挖掘(paraphrasemining)等等。其3.0版本的更新是该工程自创建以来最大...