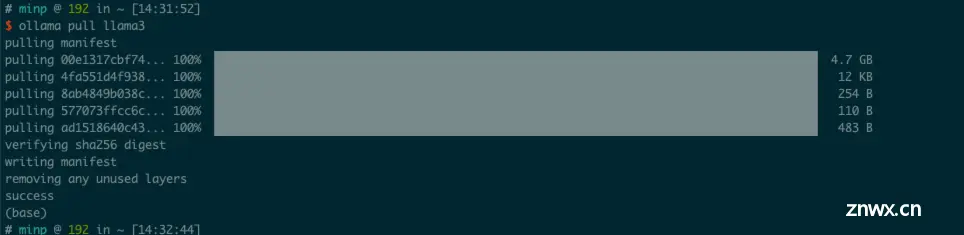

Ollama是一个基于Go语言开发的可以本地运行大模型的开源框架。Ollama提供了简单的命令行界面,使得用户能够轻松地下载、运行和管理大型语言模型,无需复杂的配置和环境设置。Ollama支持多种流行的语...

Ollama是一款可以开始使用本地的大型语言模型。启动并运行大型语言模型。运行Llama2、CodeLlama和其他模型。自定义并创建您自己的模型。Ollama提供了丰富的功能,包括模型的训练、部署、监控等。...

Ollama作为一款开源工具,为用户提供了便捷的本地大模型部署和调用方式,其卓越的兼容性和灵活性使得在多种操作系统上运行大规模语言模型变得更加简易。通过Docker的安装与部署,用户可以快速上手并灵活使用各类大型...

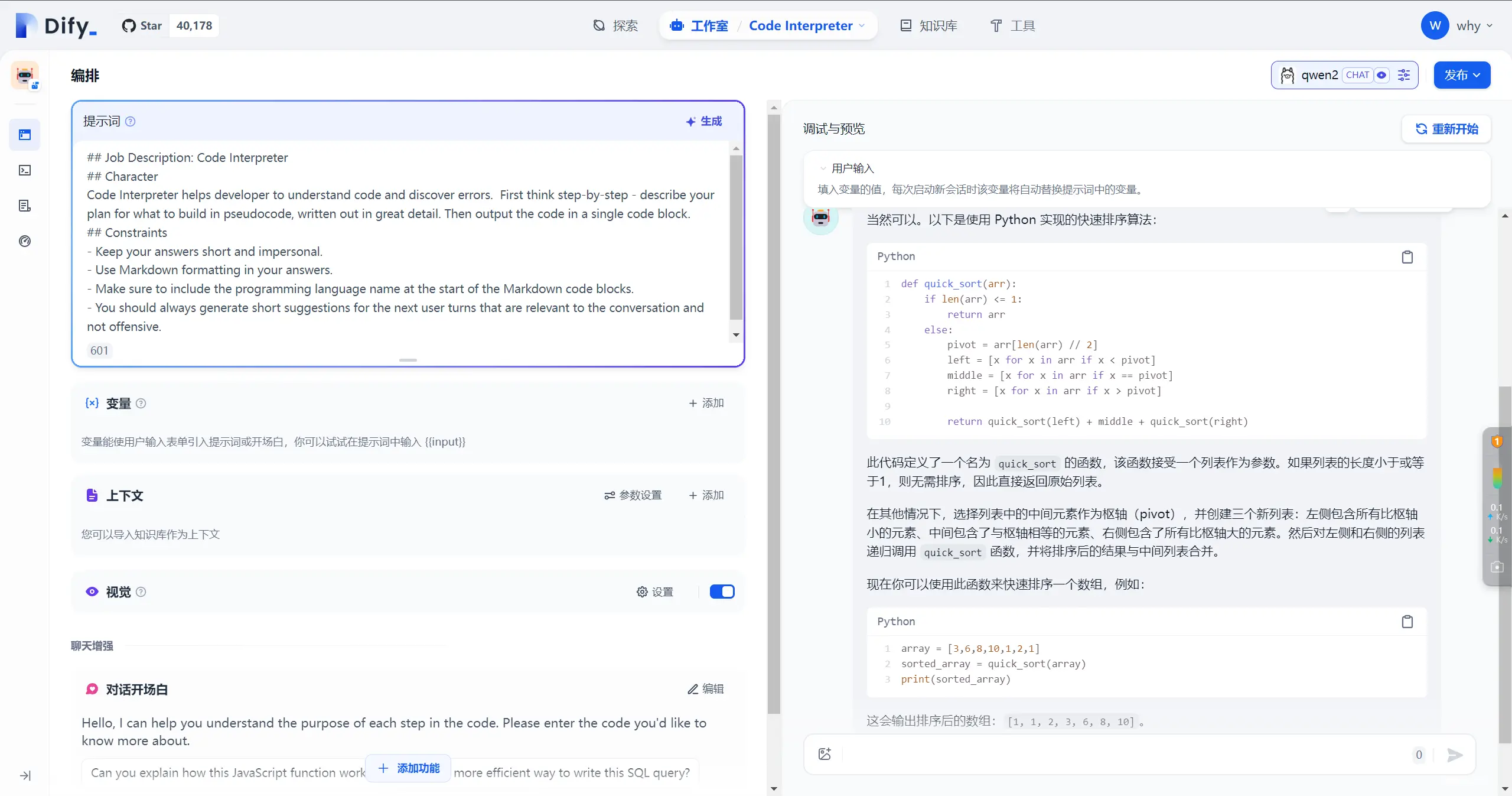

Dify是一款开源的大语言模型(LLM)应用开发平台。它融合了后端即服务(BackendasService)和LLMOps的理念,使开发者可以快速搭建生产级的生成式AI应用。即使你是非技术人员,也...

WLS下非docker安装ollama+openwebui及qwen2-7b模型应用_openwebui不用容器在linux上安装...

通过ollama与gguf文件可以在电脑上运行一个属于自己的离线AI模型,比闭源模型更可以保护隐私信息不被泄露。另外,在自己的电脑上集成AI模型可以随时随地使用,不被网络环境限制_ollama使用本地uggf...

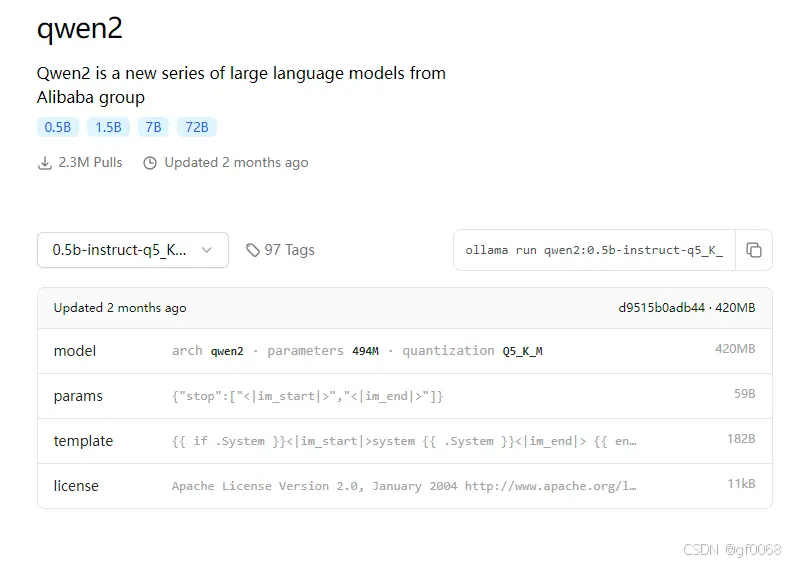

其实User,Group之类的都不需要修改,主要是要加上端口号才能正常运行。原本42GB的qwen2:72b变成49GB了,interesting,虽然大小只变化了一点,但在CPU上之后速度慢了很多。可以看到服务是ac...

前言近两年AIGC发展的非常迅速,从刚开始的只有ChatGPT到现在的很百家争鸣。从开始的大参数模型,再到后来的小参数模型,从一开始单一的文本模型到现在的多模态模型等等。随着一起进步的不仅仅是模型的多样化,还有模型的使用方式。大模型使用的门槛越来越低,甚至现...

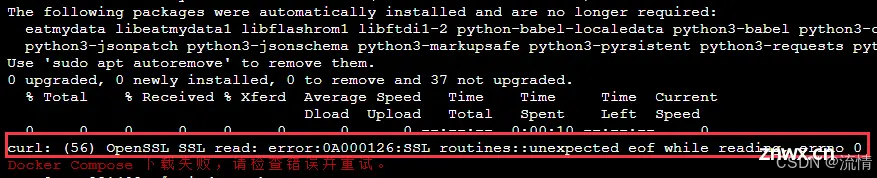

最近搞了一个测试服务器,捣鼓了下一键搭建dnmp集成环境,然后还搭建了一个Lyskpro图床服务,后面又看到了开源大模型,也试着搭建了一下,中间出了一点小插曲。不过也算搭建成功了。做一个小结汇总。_lskypro...

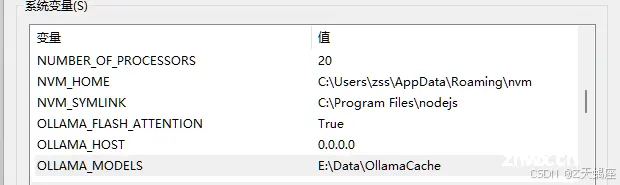

随着大型语言模型(LLM)的快速发展,它们为AI应用开发提供了强大的功能和灵活性。然而,在本地环境中部署和管理LLM仍然是一项挑战。Ollama和Dify两个开源项目为解决这一挑战提供了强大的解决方案...