本文对transformers之pipeline的文本分类(text-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline...

本文对transformers之pipeline的表格问答(table-question-answering)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipe...

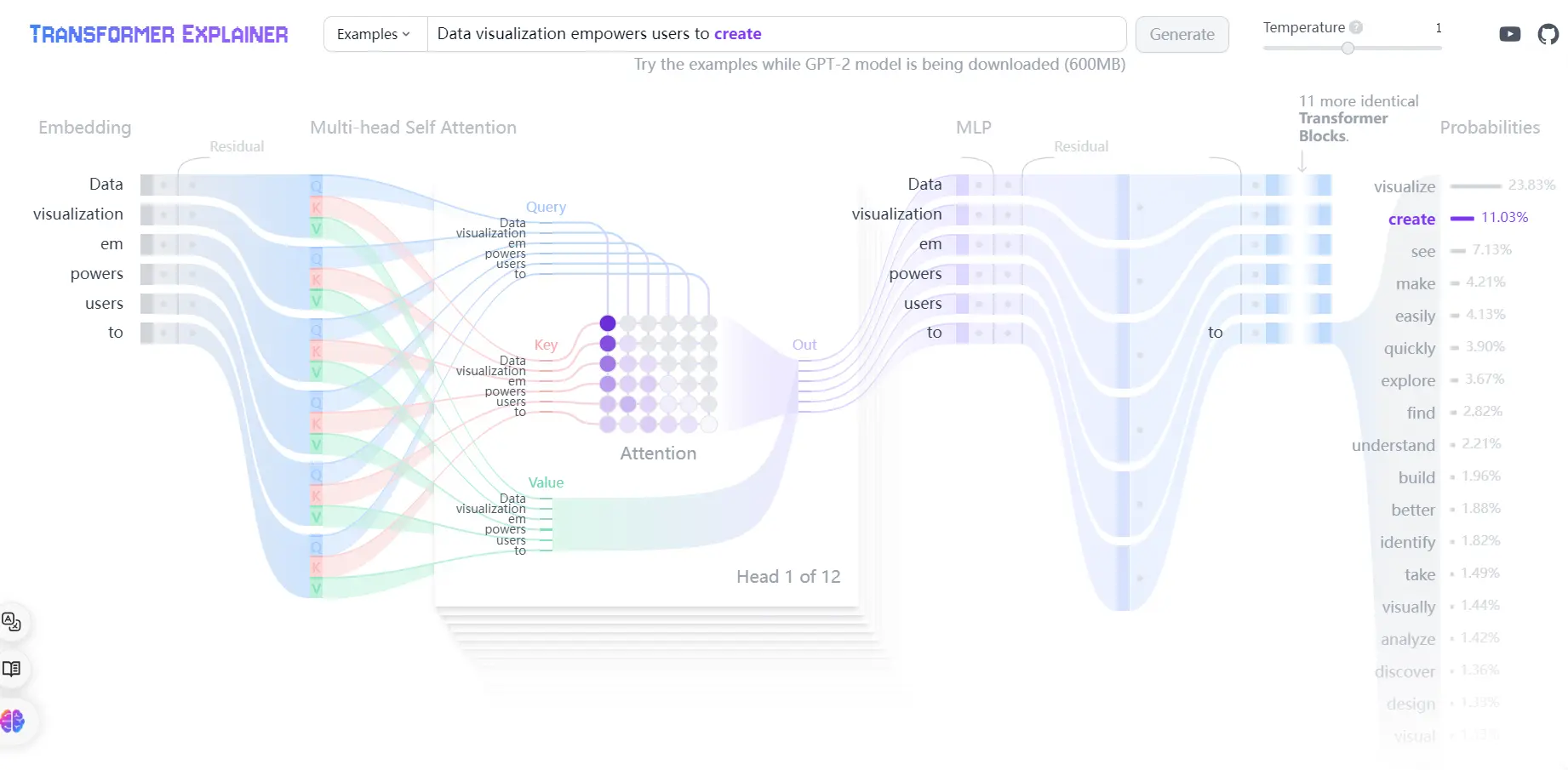

自注意力机制是Transformer模型的核心,它允许模型在编码每个单词时同时关注序列中的其他单词,从而捕捉到单词之间的依赖关系。位置编码的生成使用了正弦和余弦函数的不同频率,以确保编码在不同维度上具有不同的模式...

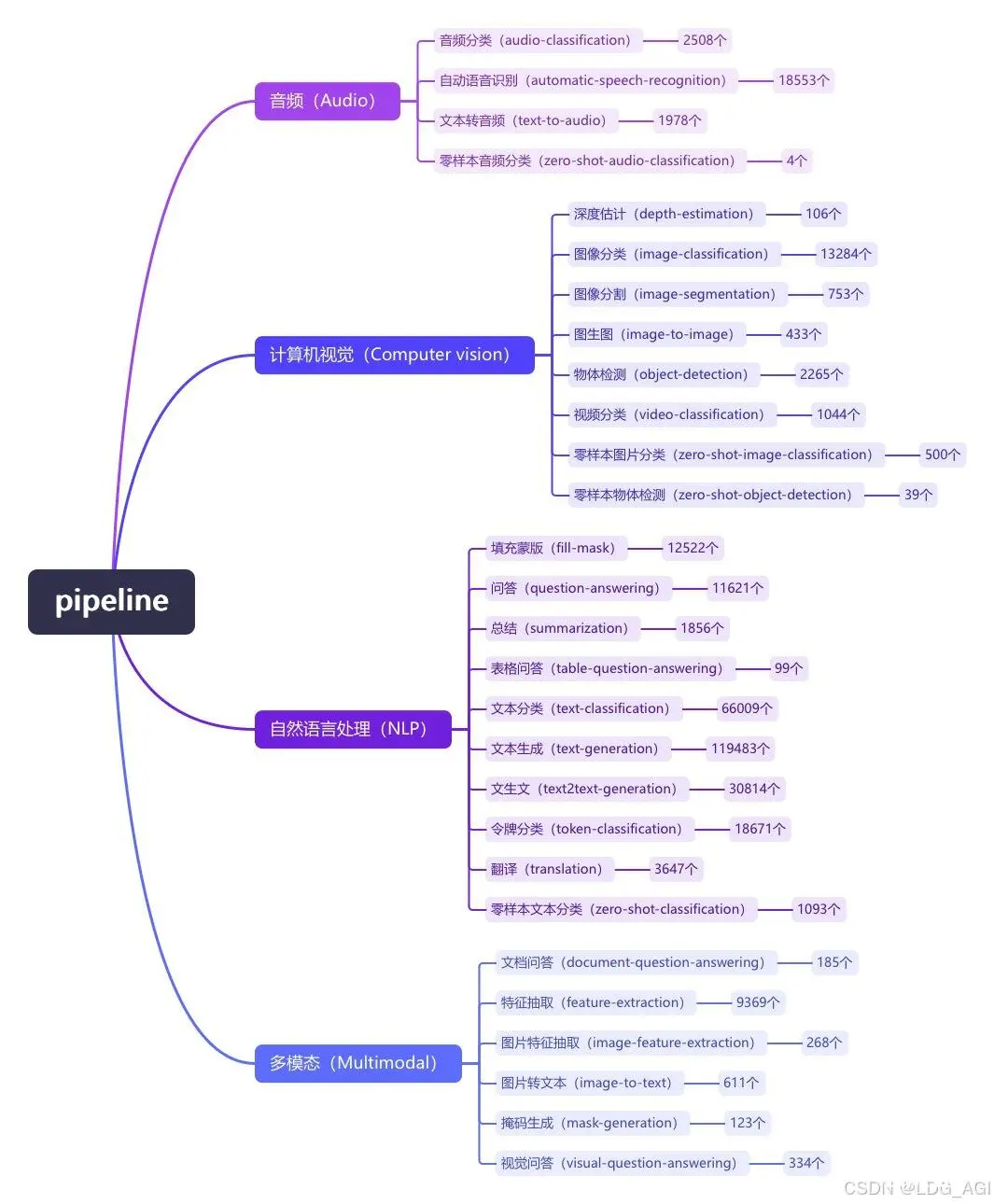

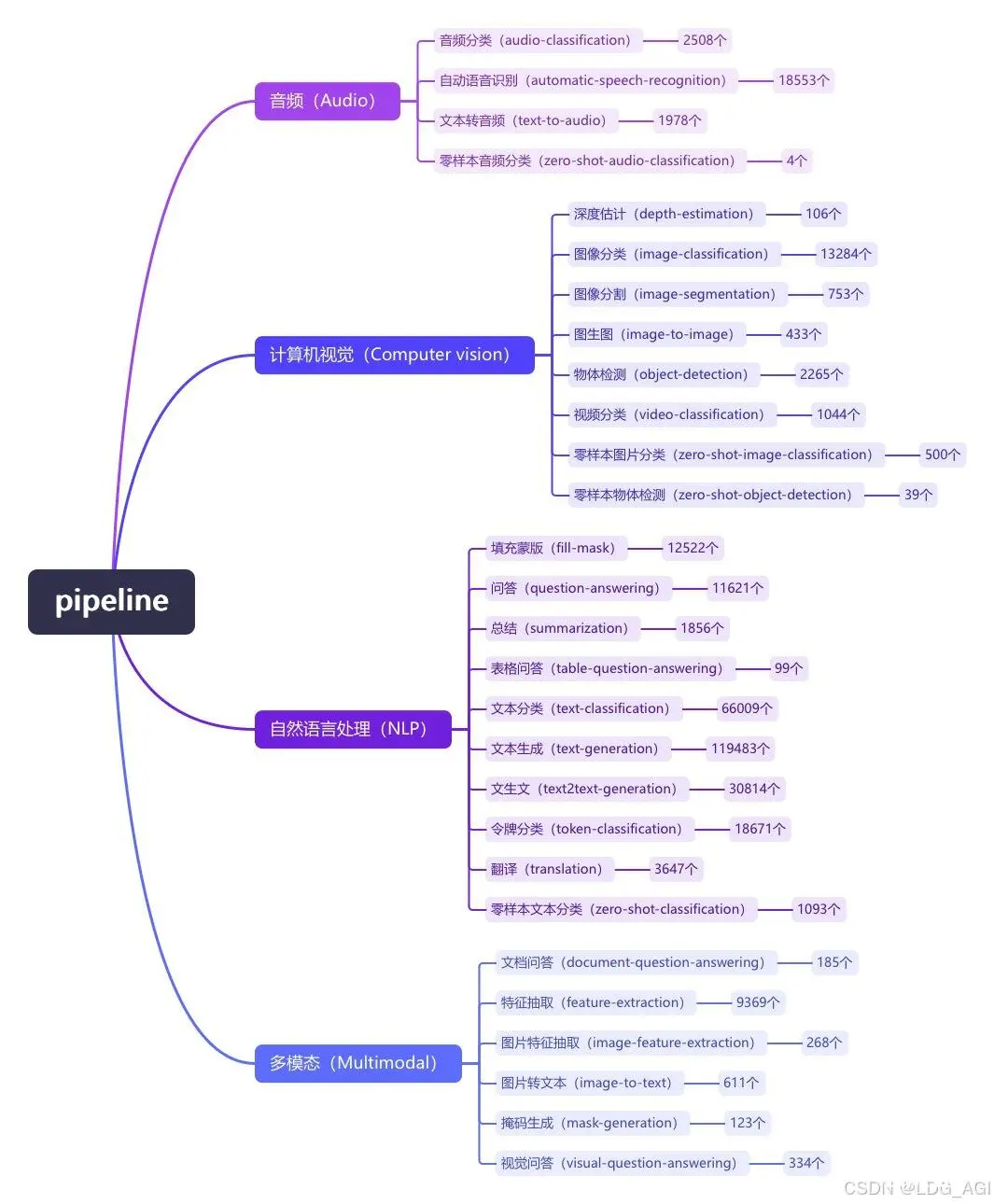

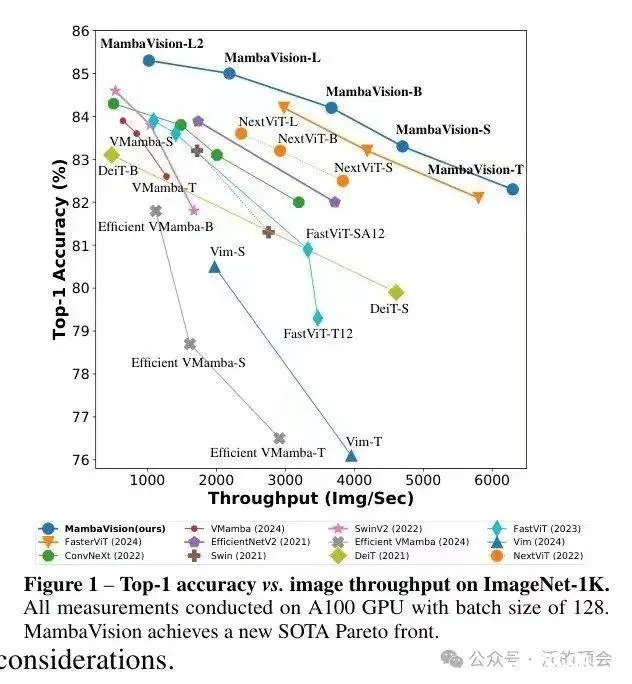

因模型规模的扩展和需要处理的序列不断变长,transformer逐渐出现计算量激增、计算效率下降等问题,研究者们提出了——,它结合了递归神经网络(RNN)和卷积神经网络(CNN)的特点,以提高处理长序列数据时的计算...

本文对transformers之pipeline的总结(summarization)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文中的2行...

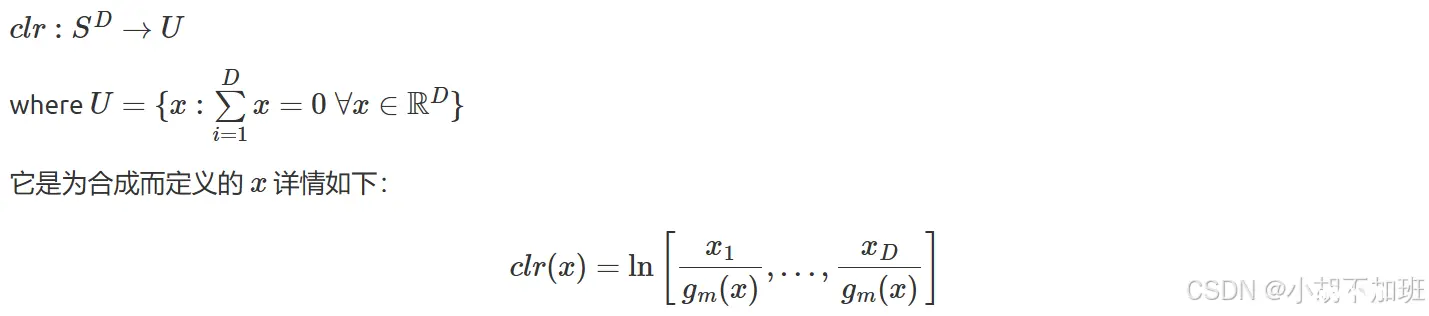

中心对数比变换(CenteredLogRatioTransformation,CLR)是一种数据预处理方法,常用于成分数据分析领域。在成分数据中,各成分之间通常存在一定的约束关系,比如它们的和为固定值等,中...

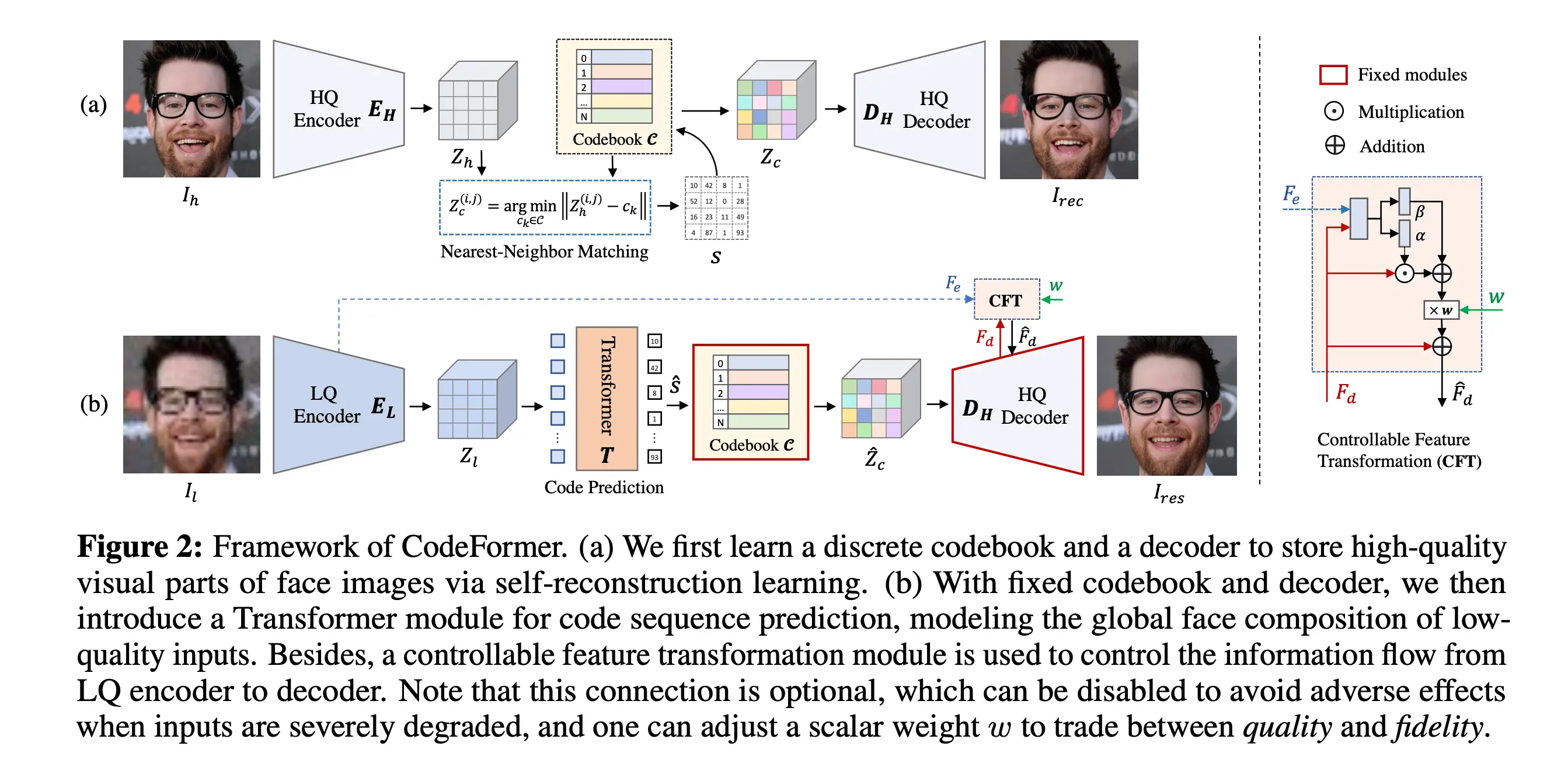

TowardsRobustBlindFaceRestorationwithCodebookLookupTransformer(NeurIPS2022)这篇论文试图解决的是盲目面部恢复(blindfacerestoration)问题,这是...

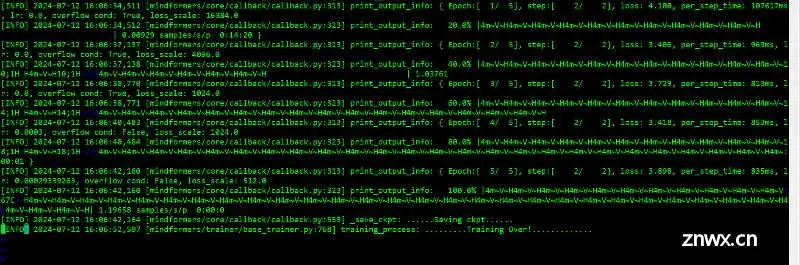

基于Mindformers+mindspore框架在昇腾910上进行qwen-7b-chat的8卡lora微调主要参考文档:https://gitee.com/mindspore/mindformers/tree/r1.0/research/qwe...

NLP之transformer:transformer-explainer的简介、安装和使用方法、案例应用之详细攻略目录相关论文transformer-explainer的简介transformer-expla...

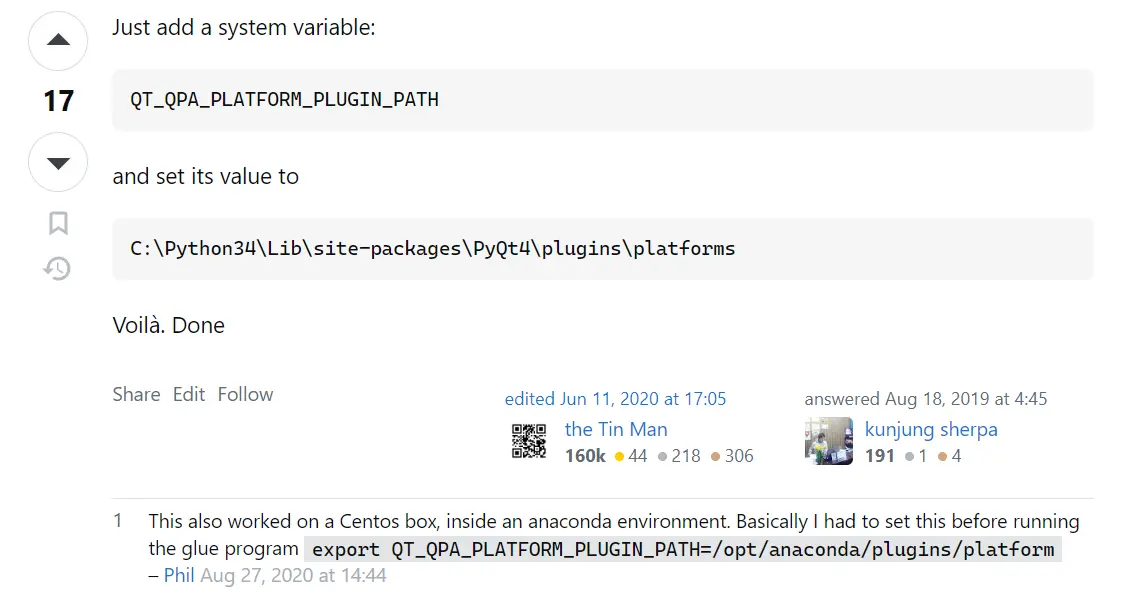

bug提示如上所示:ThisapplicationfailedtostartbecausenoQtplatformplugincouldbeinitialized.Reinstallingtheapplicationmayfi...