大规模语言模型(LargeLanguageModels,LLM),也称大语言模型或大型语言模型,是一种由包含数百亿以上参数的深度神经网络构建的语言模型,通常使用自监督学习方法通过大量无标注文本进行训练。_统...

智能体借助工具排查问题得出结论的整个过程与人类行为已经基本没有大的差别。智能体基本没用exec_command这种通用工具,而是选择合适的垂直工具(get_namenodes、namenode_log等),这点与...

tiktoken是OpenAI开发的一种BPE分词器。给定一段文本字符串(例如,)和一种编码方式(例如,),分词器可以将文本字符串切分成一系列的token(例如,将文本字符串切分成token非常有用,因为GPT模型看到...

AI大模型的战场正在分化,通用与垂直的较量才刚刚开始。无论是通用大模型的广泛适用性,还是垂直大模型的专业优势,它们都在推动着人工智能技术的发展和应用。作为观察者和参与者,我们更应关注这场竞争背后的技术创新和市场动态,...

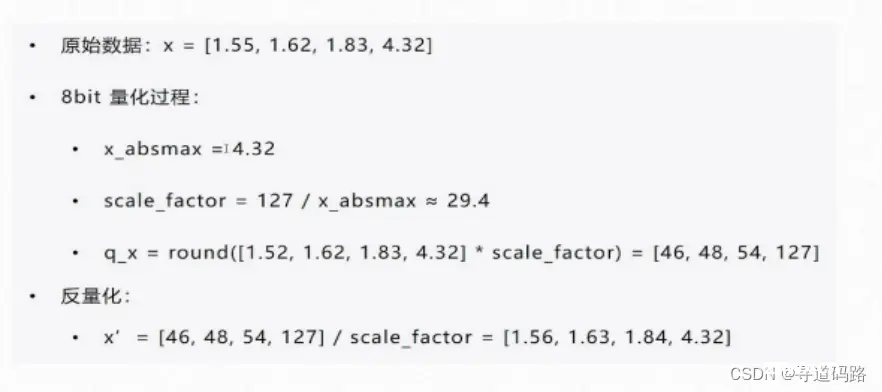

在深度学习的不断进步中,大型语言模型(LLMs)的预训练和微调技术成为了研究的热点。其中,量化技术以其在模型压缩和加速方面的潜力备受关注。本文将深入探讨QLoRA(QuantizedLow-RankAdap...

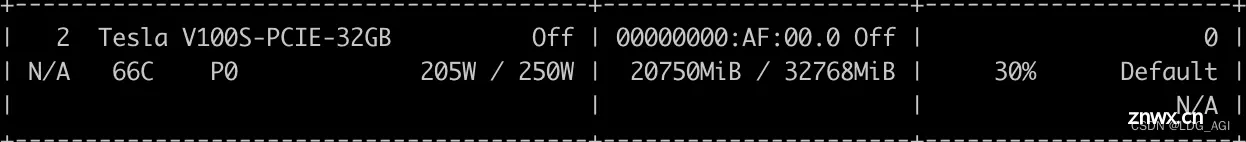

本文首先对量化和微调的原理进行剖析,接着以Qwen2-7B为例,基于QLoRA、PEFT一步一步带着大家微调自己的大模型,本文参考全网peft+qlora微调教程,一步一排坑,让大家在网络环境不允许的情况下,也...

基于LoRA进行模型微调时,需要先冻结全部参数,再指定相应的Linear层进行微调,那么如何计算全部参数,如何计算微调参数以及如何计算微调参数占全部参数的比例呢?本文先对Qwen2模型结构进行一览,做到心中有数,之...

随着人工智能技术的迅猛发展,各种大模型产品不断涌现。无论是设计师、程序员、美术摄影师,还是金融领域,教育培训,生活服务和医疗保障的从业者,都面临着如何选择适合自己需求的AI工具的挑战。本文将从多个领域的角度出发,...

Ollama支持在Modelfile中导入GGUF模型:创建一个名为Modelfile的文件,使用带有要导入的模型的本地文件路径的“FROM”指令。在Ollama里创建模型运行模型从Ollama库下载的大模型...

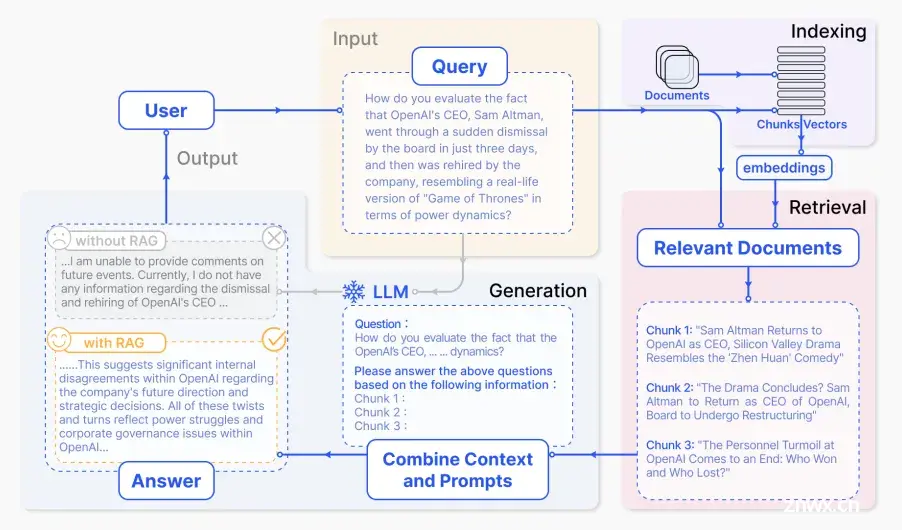

1.背景介绍知识图谱(KnowledgeGraph,KG)是一种以实体(Entity)和关系(Relation)为核心的数据结构,用于表示实际世界的知识。知识图谱的应用范围广泛,包括信息检索、问答系统、推荐系...